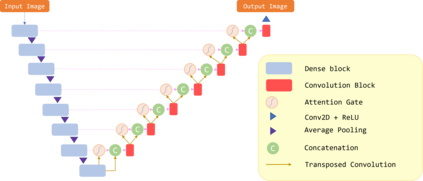

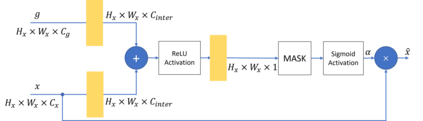

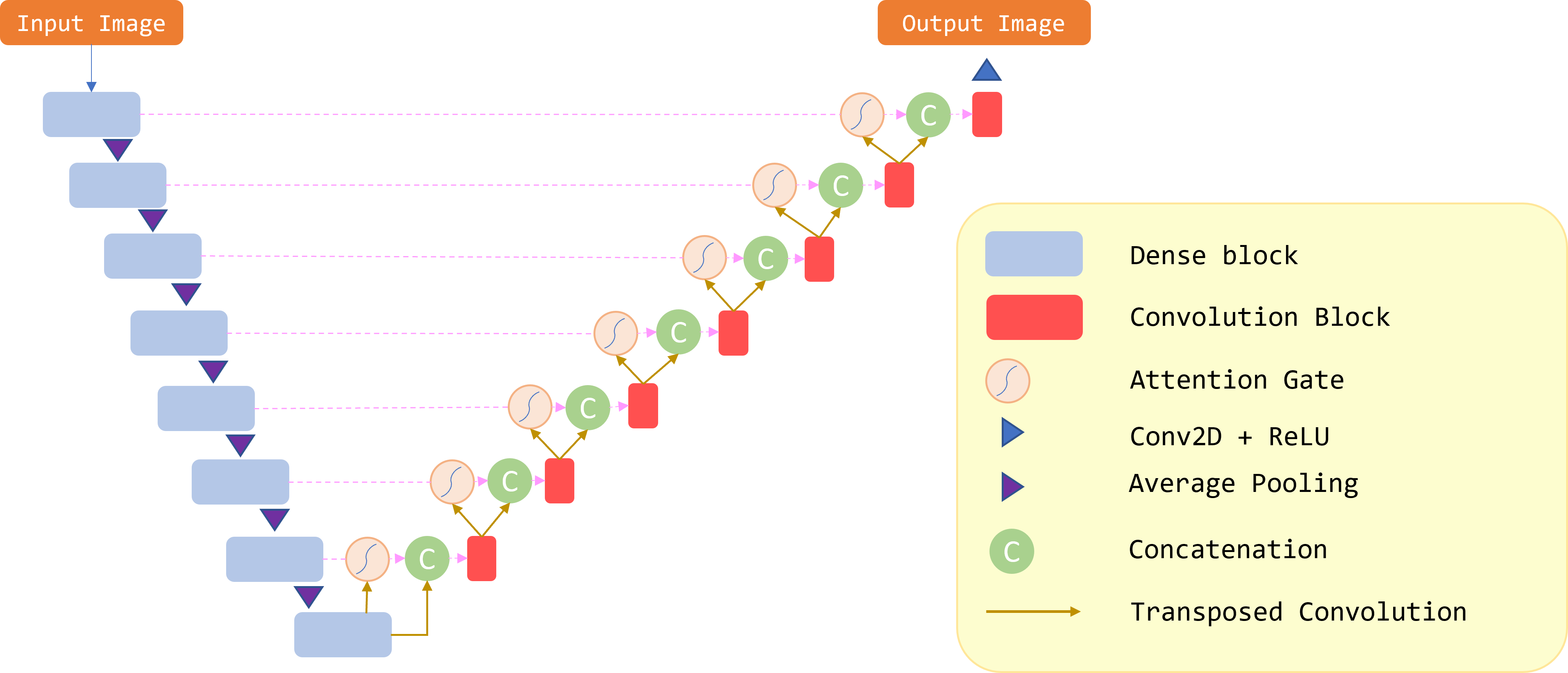

Because of increased urban complexity and growing populations, more and more challenges about predicting city-wide mobility behavior are being organized. Traffic Map Movie Forecasting Challenge 2020 is secondly held in the competition track of the Thirty-fourth Conference on Neural Information Processing Systems (NeurIPS). Similar to Traffic4Cast 2019, the task is to predict traffic flow volume, average speed in major directions on the geographical area of three big cities: Berlin, Istanbul, and Moscow. In this paper, we apply the attention mechanism on U-Net based model, especially we add an attention gate on the skip-connection between contraction path and expansion path. An attention gates filter features from the contraction path before combining with features on the expansion path, it enables our model to reduce the effect of non-traffic region features and focus more on crucial region features. In addition to the competition data, we also propose two extra features which often affect traffic flow, that are time and weekdays. We experiment with our model on the competition dataset and reproduce the winner solution in the same environment. Overall, our model archives better performance than recent methods.

翻译:由于城市复杂程度的提高和人口的增长,在预测全城市流动性行为方面正在组织越来越多的挑战。2020年交通地图预测挑战第二场是在第三十四届神经信息处理系统会议的竞争轨道上举行的。与2019年交通4Cast相似,任务是预测交通流量和三个大城市(柏林、伊斯坦布尔和莫斯科)地理区域主要方向的平均速度。在本文中,我们应用基于U-Net的注意机制,特别是我们在收缩路径和扩张路径之间跳过连接上增加一个关注门。在与扩张路径的特征相结合之前,收缩路径上的注意门过滤功能使得我们的模型能够减少非贸易区域特征的影响,并更加注重关键区域特征。除了竞争数据外,我们还提出了两个经常影响交通流量的额外特征,即时间和周日。我们在竞争数据集上试验我们的模型,并在同一个环境中复制赢家解决方案。总体而言,我们的模型保存工作比最近的方法要好。