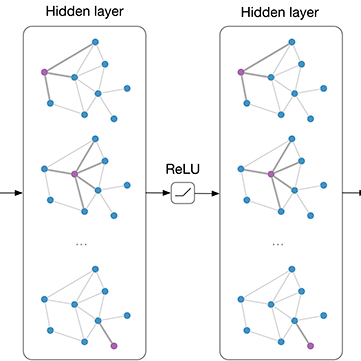

Existing few-shot learning (FSL) methods assume that there exist sufficient training samples from source classes for knowledge transfer to target classes with few training samples. However, this assumption is often invalid, especially when it comes to fine-grained recognition. In this work, we define a new FSL setting termed few-shot fewshot learning (FSFSL), under which both the source and target classes have limited training samples. To overcome the source class data scarcity problem, a natural option is to crawl images from the web with class names as search keywords. However, the crawled images are inevitably corrupted by large amount of noise (irrelevant images) and thus may harm the performance. To address this problem, we propose a graph convolutional network (GCN)-based label denoising (LDN) method to remove the irrelevant images. Further, with the cleaned web images as well as the original clean training images, we propose a GCN-based FSL method. For both the LDN and FSL tasks, a novel adaptive aggregation GCN (AdarGCN) model is proposed, which differs from existing GCN models in that adaptive aggregation is performed based on a multi-head multi-level aggregation module. With AdarGCN, how much and how far information carried by each graph node is propagated in the graph structure can be determined automatically, therefore alleviating the effects of both noisy and outlying training samples. Extensive experiments show the superior performance of our AdarGCN under both the new FSFSL and the conventional FSL settings.

翻译:现有的微小学习方法(FSL)假定,从源类中有足够的培训样本,可以将知识转让到培训样本很少的目标群体班,然而,这一假设往往无效,特别是在细微的识别方面。在这项工作中,我们定义了一个新的FSL设置,称为微小的微小学习(FSL),在这种设置下,源类和目标类中都有有限的培训样本。为了克服源类数据稀缺问题,一个自然的选择是从网络上爬出图像,以类名作为搜索关键字。然而,爬升的图像不可避免地被大量噪音(不相关的图像)腐蚀,从而可能损害性能。为了解决这一问题,我们提议了一个基于图形共转网络的标签分解(LDN)方法来去除无关的图像。此外,随着清洁的网络图像以及原始的清洁培训图像,我们提出了以GCN为基础的FSL方法。对于L和FSL任务来说,提出了一个新的适应性聚合GCN(AdarGCN)模型,这与现有的GCN模型不同,在适应性的GCN总体中,一个高层次的高级的GLA-GL模型是自动的,在高层次的模型下进行。