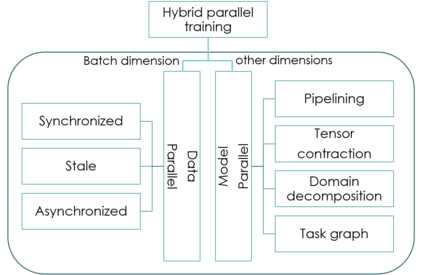

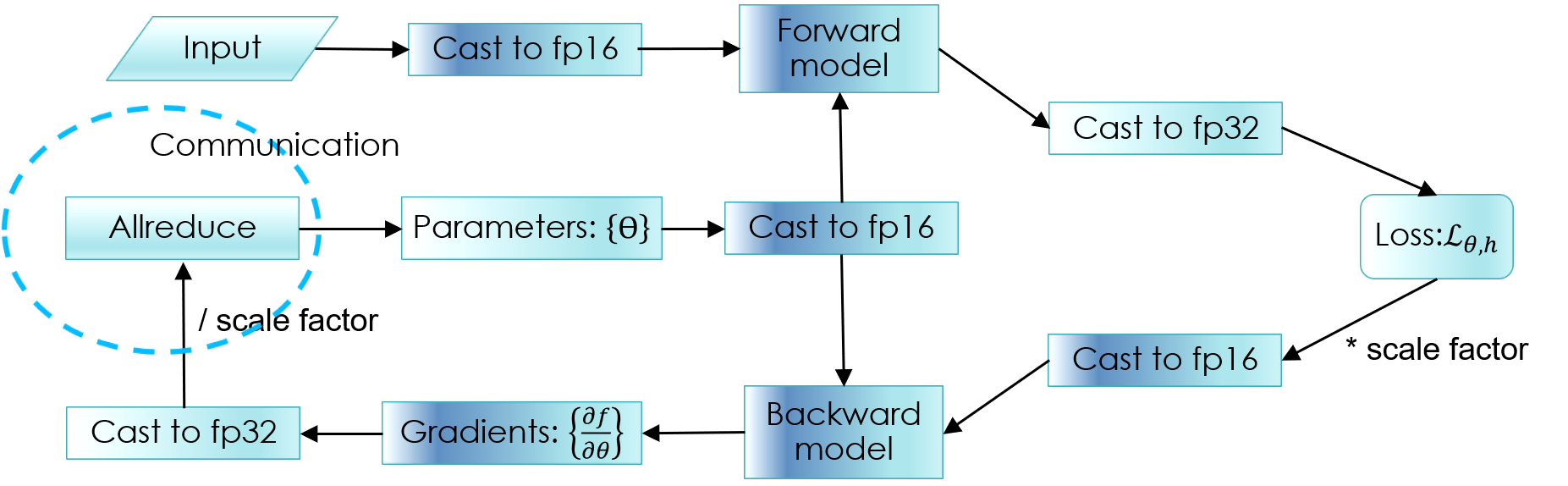

Deep learning models are yielding increasingly better performances thanks to multiple factors. To be successful, model may have large number of parameters or complex architectures and be trained on large dataset. This leads to large requirements on computing resource and turn around time, even more so when hyper-parameter optimization is done (e.g search over model architectures). While this is a challenge that goes beyond particle physics, we review the various ways to do the necessary computations in parallel, and put it in the context of high energy physics.

翻译:深层学习模型由于多种因素而越来越产生更好的性能。 要取得成功,模型可能拥有大量参数或复杂结构,并接受大型数据集培训。这导致对计算资源的大量要求,并改变时间,在进行超参数优化(例如对模型结构的搜索)时更是如此。 尽管这是一个超越粒子物理的挑战,但我们审查平行进行必要计算的各种途径,并将其置于高能量物理的背景下。

相关内容

专知会员服务

23+阅读 · 2019年11月21日

专知会员服务

36+阅读 · 2019年10月17日

Arxiv

7+阅读 · 2020年3月12日