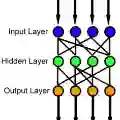

Feedforward neural networks are widely used as universal predictive models to fit data distribution. Common gradient-based learning, however, suffers from many drawbacks making the training process ineffective and time-consuming. Alternative randomized learning does not use gradients but selects hidden node parameters randomly. This makes the training process extremely fast. However, the problem in randomized learning is how to determine the random parameters. A recently proposed method uses autoencoders for unsupervised parameter learning. This method showed superior performance on classification tasks. In this work, we apply this method to regression problems, and, finding that it has some drawbacks, we show how to improve it. We propose a learning method of autoencoders that controls the produced random weights. We also propose how to determine the biases of hidden nodes. We empirically compare autoencoder based learning with other randomized learning methods proposed recently for regression and find that despite the proposed improvement of the autoencoder based learning, it does not outperform its competitors in fitting accuracy. Moreover, the method is much more complex than its competitors.

翻译:进取神经网络被广泛用作通用预测模型,以适应数据分布。但是,基于梯度的常见学习有许多缺点,使得培训过程无效和耗时。替代随机学习不使用梯度,而是随机选择隐藏节点参数。这使得培训过程非常快。但是,随机学习的问题是如何确定随机参数。最近提出的方法使用自动解码器进行不受监督的参数学习。这种方法显示分类任务方面的优异性能。在这项工作中,我们将这种方法应用于回归问题,发现它有一些缺点,我们展示如何改进它。我们提出了一种控制随机重量的自动解算器的学习方法。我们还提议了如何确定隐藏节点的偏向。我们用实验方法将基于自动解码的学习与最近提出的其他随机学习方法进行比较,发现尽管提议改进基于自动解码的学习,但该方法并不比其竞争者更精确。此外,该方法比其竞争者复杂得多。