神经网络显著提升了从海量高维数据集中学习的能力,广泛应用于众多领域。然而其决策不易解释、计算成本高昂且训练过程复杂。为构建系统化框架,推导新数学成果以高效测量全连接与卷积神经网络处理数据时的熵变。通过量化网络处理有效数据时的熵变,可可视化并识别高性能网络的关键模式。基于熵的损失函数被设计用于提升密集连接与卷积模型的精度效率,通过优化理想熵模式实现。在基准数据集上的图像压缩、分类及分割实验表明:该损失函数能引导神经网络以更低维度学习丰富隐式表征,减少训练轮次实现收敛,并获得更高准确率。

本研究由美国陆军工程兵团(USACE)资助,由美国陆军工程研究与发展中心环境实验室(ERDC-EL)执行。

过去15年间,神经网络已彻底革新计算机视觉(如LeCun等[28]与Krizhevsky等[27]的卷积神经网络/CNN,Dosovitskiy等[10]的视觉Transformer)、自然语言处理(如Radford等[38]、Ouyang等[35]的Transformer架构[45])、生成对抗网络/GANs[15]与扩散模型[23]驱动的合成数据生成等无数领域。凭借卓越预测力与通用性,神经网络已成为从医疗到国家安全领域的关键工具。然而模型的黑箱特性带来重大挑战——尤其在需要理解决策过程的高风险场景。开发可解释模型有望带来革命性变革,提供清晰可操作的决策洞察,提升模型效率,促进领域专家协作,深化关键特征影响认知。此外,网络复杂性阻碍部署解释:高维数据处理、数亿参数优化、复杂架构运行,不仅消耗巨量算力,更使决策过程难以阐明。增强可解释性将提升高风险应用可信度,尤其在关乎人类生命的决策领域。

信息理论具备为神经网络数据处理与决策提供概率解释的潜力,能实现模型决策解读,通过精简架构降低处理复杂度,提升泛化能力并优化效率。分析网络信息流模式还可识别训练/推理阶段的优化趋势,衍生出信息论度量指标与诱导理想行为的超参数集合。先前研究利用熵与互信息进行数据预处理、网络训练、正则化及决策解释,主要聚焦神经网络输出/隐式分布的熵值或隐式表征与其他表征/输出间的互信息估算,以追求性能效率或可解释性的下游收益。但直接估算隐式表征信息量面临高维度导致的不可靠估算与高计算成本问题,制约实用价值。本文通过仅推导神经网络隐层间熵变的显式公式规避此难题:首先建立测量全连接层与二维卷积层熵传播的新概率论成果,据此构建基于熵的损失函数,并引导网络训练以缩短收敛时间并提升性能。该方法形成实用熵引导框架,在多元计算机视觉任务与神经架构中展现显著效益。

主要贡献:

- 建立全连接层与卷积层熵传播的可计算公式,提出创新熵基损失项实现熵引导训练

- 分析成熟监督神经网络的熵传播模式,揭示理想信息流特征与最优熵引导策略

- 实验验证熵基损失项加速MNIST与CIFAR10图像压缩收敛,提升CIFAR10分类性能(附统计验证)

- 在大型模型(VGG-16/ResNet/U-Net)与更真实基准数据集验证性能提升与收敛加速

结构

第2节综述信息论学习相关研究;

第3节推导全连接与卷积层的熵传播概率论成果;

第4节将成果转化为新型熵基损失函数;

第5节展示熵基损失在标准图像数据集重建/分类/分割任务的应用结果;

第6节总结研究发现、贡献与未来工作意义。

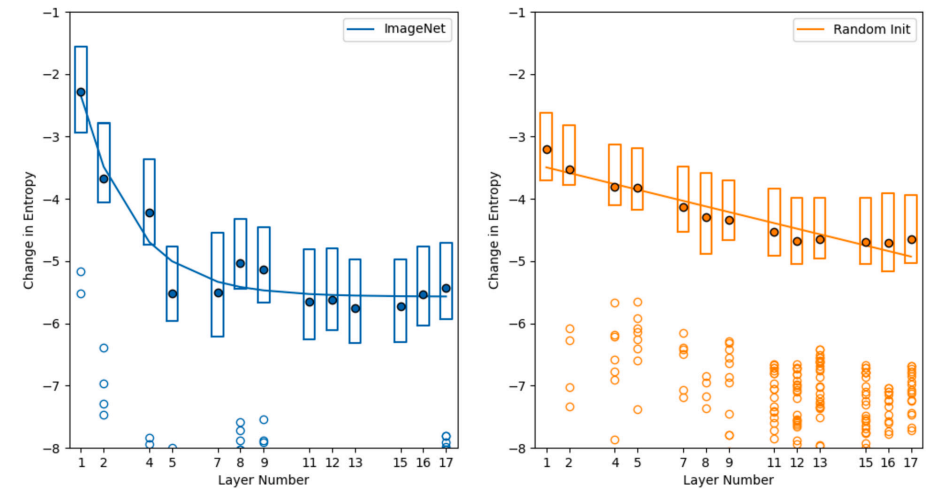

图1. 两个VGG16网络各层滤波器的平均熵变。其中一个网络经训练用于ImageNet分类,另一个为随机初始化。实心点表示均值,箱线图显示每层滤波器熵变的第一和第三四分位数,离群值以空心点标注。