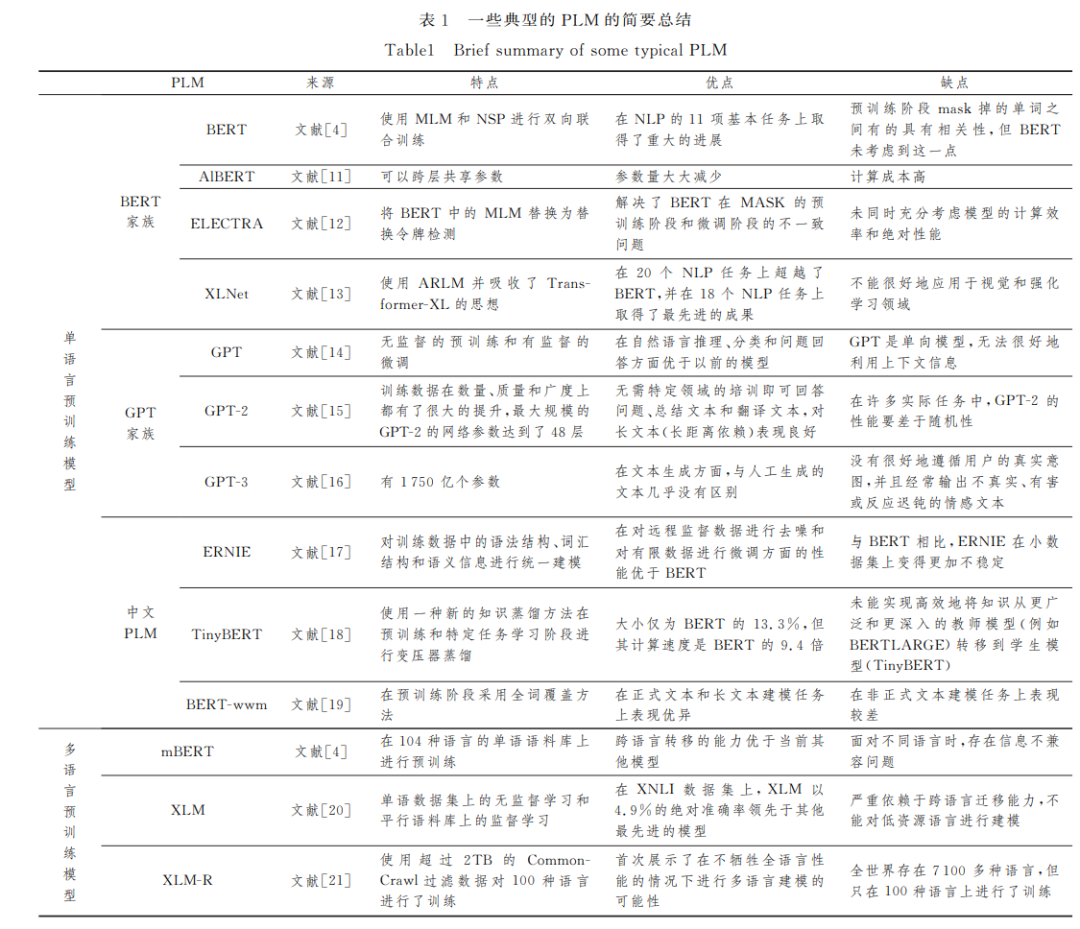

摘要: 近年来,预训练语言模型发展迅速,将自然语言处理推到了一个全新的发展阶段。文中的综述旨在帮助研究人员了解强大的预训练语言模型在何处以及如何应用于自然语言处理。具体来讲,首先简要回顾了典型的预训练模型,包括单语言预训练模型、多语言预训练模型以及中文预训练模型;然后讨论了这些预训练模型对5个不同的自然语言处理任务的贡献,即信息提取、情感分析、问答系统、文本摘要和机器翻译;最后讨论了预训练模型的应用所面临的一些挑战。

https://www.jsjkx.com/CN/10.11896/jsjkx.220800223

在早期的自然语言 处 理(NaturalLanguageProcessing, NLP)任务中,人们通常利用各种深度神经网络[1],使用低维 密集向量来表示语言的句法或语义特征.然而,由于深度神 经网络参数量大,并且是在有限的数据集上进行训练的,往往 会导致过度拟合.因此,Vaswanid等[2]提出了深度学习模型 Transformer,用于解决循环神经网络(RecurrentNeuralNetG work,RNN)训 练 缓 慢、效 率 低 下 和 过 度 拟 合 的 问 题[3].同 时,将 Transformer与自我注意力机制相结合,实现了快速并 行的 效 果. 从 此,预 训 练 语 言 模 型 (Pretrained Language Model,PLM)进入了蓬勃发展的阶段.各种大规模的单语言 PLM(如 BERT [4]和 GPT [5])在各种 NLP任务中获得了巨大 成功,并催生了许多不同的改进模型和多语言 PLM. 近两年来,PLM 在 NLP 领 域 应 用 得 非 常 广 泛,原 因 是 PLM 可以将各种困难复杂的 NLP任务简化为简单的微调问 题.PLM 通过自我监督学习在大规模文本语料库上进行预 训练,预训练过程包括从大型语料库中学习常识(与特定的下 游 NLP任务无关),以防止模型在小数据上过度拟合[6].在 预训练之后,PLM 需要针对具体的下游任务进行微调. 由于 PLM 对 NLP至关重要,为了帮助研究人员快速掌 握 PLM 的应用现状,本文综述了 PLM 在 NLP 领域5个最 热门的任务中的应用:信息提取(InformationExtraction,IE)、 情感分析(SentimentAnalysis,SA)、文本摘要(TextSummaGrization,TS)、问题回答(QuestionAnswering,QA)和机器翻 译(MachineTranslation,MT).此 外,我 们 还 讨 论 了 当 前 PLM 应用中的重要挑战. 其他研究人员也综述了 PLM,但本文的综述与他们的不 同.2020年,Qiu等[7]对 PLM 在 NLP领域的应用进行了调 查,但只进行了简单的概述.2020年,Zaib等[8]对 PLM 的对 话式人工智能做了一个简短的综述,但未涉及 PLM 在其他 领域的应用.2021年,Luo等[9]调查了 PLM 在跨语言SA 中 的应用.2021年,Kalyan等[10]回顾了基于转换的生物医学 PLM.然而,他们的 PLM 只涉及生物医学领域,这些综述都 没有包含最新的进展,且所做的综述单一或者不够详尽.本 文不仅讨论了 PLM 在 NLP领域的最新应用,而且详细地介 绍了这个主题,涵盖了信息提取、情感分析、自动问答、文本摘 要和机器翻译5个 NLP热门领域. 本文第2节简要介绍了一些典型的 PLM,包括国内外的 单语和多语 PLM;第3节总结了一些基于 PLM 的信息提取 方法;第4节回顾了一些基于 PLM 的情感分析技术;第5节 考察了用于问答系统的 PLM 模型;第6节讨论了基于 PLM 的文本摘要方法;第7节评论了一些关于PLM 的机器翻译的 研究;第8节讨论了未来工作的挑战;最后总结全文.