ChatGPT的引入导致了大型语言模型(LLMs)在解决下游任务中的使用显著增加。在这个背景下,越来越多的关注点放在了成本效率高的训练和部署上。低成本的训练和部署LLMs代表了未来的发展趋势。本文回顾了大型语言模型训练技术和与这一新兴趋势相一致的推理部署技术的演变。关于训练的讨论包括多个方面,包括数据预处理、训练架构、预训练任务、并行训练,以及与模型微调相关的内容。在推理方面,本文涵盖了模型压缩、并行计算、内存调度和结构优化等话题。它还探讨了LLMs的利用,并提供了对其未来发展的见解。

- 引言

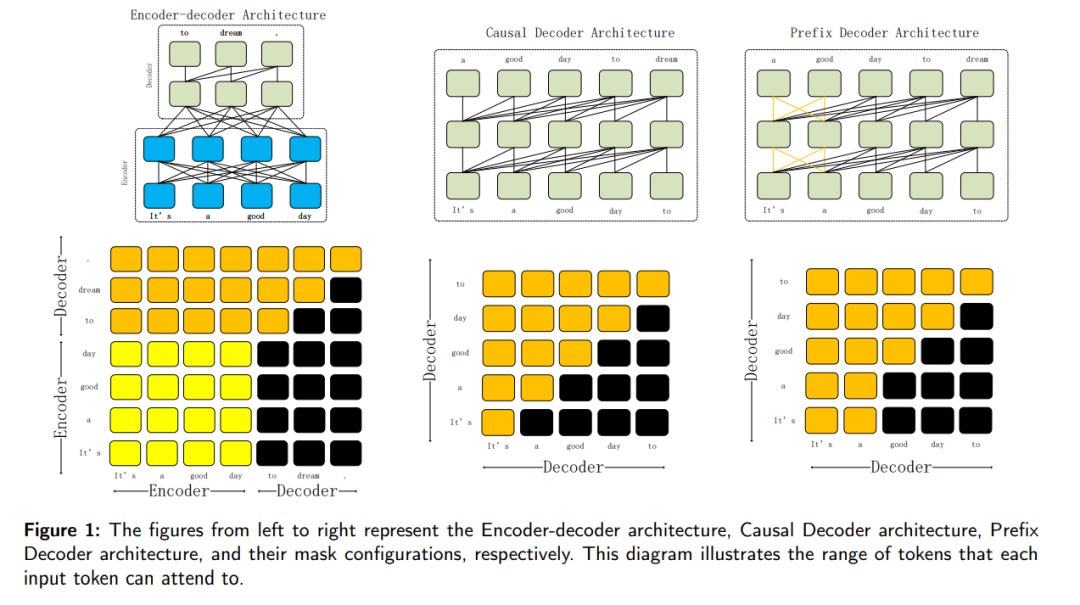

语言建模(LM)是在自然语言处理(NLP)领域实现认知智能的基本方法,近年来其进展显著[1; 2]。它在理解、生成和操作人类语言方面扮演着中心角色,成为各种NLP应用的基石,包括机器翻译、聊天机器人、情感分析和文本摘要。随着深度学习的发展,早期的统计语言模型(SLM)已逐渐转变为基于神经网络的神经语言模型(NLM)。这一转变的特点是采用词嵌入,将单词表示为分布式向量。值得注意的是,这些词嵌入在实际NLP任务中表现出色,深刻地塑造了该领域的进展。预训练语言模型(PLM)代表着在NLM之后语言模型演变的一个后续阶段。PLM的早期尝试包括ELMo[3],它基于双向长短期记忆(LSTM)架构。然而,随着Transformer架构[4]的出现,其特点是并行自注意力机制,预训练和微调学习范式已将PLM推至卓越地位,成为主导方法。这些模型通常通过自监着学习在大型数据集上进行训练,巩固了它们作为该领域主要方法论的地位。 Transformer架构特别适合于扩大模型规模,研究分析显示,增加模型的规模或训练数据大小可以显著提高其性能。许多研究通过不断扩大PLM的规模,推动了模型性能的边界[5; 6; 7; 8]。随着模型规模的增长,出现了一个名为“出现”的显著现象,其中它们表现出惊人的性能[6]。这些模型能够生成高质量的文本,并具有强大的学习和推理能力。它们甚至可以通过在上下文中学习(ICL)来处理少数样本学习任务[6]。这种显著能力使得它们能够无缝地应用于跨多个领域的各种下游任务[9; 10; 11; 12]。 具有显著更大的参数规模和广泛训练数据的预训练语言模型(PLMs)通常被称为大型语言模型(LLMs)[13; 14; 15]。模型大小通常超过100亿(10B)参数。LLMs发展中的一个重要里程碑是由GPT系列体现的[16; 5; 6; 17]。值得注意的是,OpenAI在2022年11月发布了ChatGPT,标志着LLMs时代的一个转折点,也是人工智能领域的一个改变游戏规则的时刻。ChatGPT使当前的AI算法实现了前所未有的强度和有效性,重塑了人类使用或开发AI算法的方式。它的出现引起了研究界的关注。然而,由于ChatGPT不是一个开源平台,目前使用ChatGPT的主要方式是通过访问OpenAI的网站 https://chat.openai.com 或通过他们的API接口。训练可以作为ChatGPT的替代品,或训练领域特定的LLMs变得非常必要[18; 19; 20; 21; 22; 1; 23; 24]。训练和部署LLMs需要在处理大规模数据方面的专业知识和在分布式并行训练方面的实际经验[25; 26; 27]。这一需求强调了开发LLMs的研究人员需要在解决LLM开发过程中遇到的挑战方面具有显著的工程能力。对LLMs感兴趣的研究人员必须具备工程技能,或学会与工程师有效合作。 基于上述原因,本文的主要目的是提供LLMs训练和推理技术的全面概述,以帮助研究人员掌握开发、部署和应用LLMs所需的知识。本综述的其余结构如下:第2节,我们将介绍LLMs的相关背景和基础知识。第3节,我们将深入探讨训练LLMs的技术方面,而在第4节我们将探索与LLMs的推理和部署相关的技术。第5节,我们将讨论LLMs的利用,第6节将探讨LLMs的未来方向及其对LLMs的影响。** 大型语言模型的训练**LLMs的训练可以大致分为三个步骤。第一步涉及数据收集和处理。第二步包括预训练过程,其中包括确定模型的架构和预训练任务,并使用合适的并行训练算法完成训练。第三步涉及微调和对齐。在本节中,我们将提供模型训练技术的概述。这将包括对相关训练数据集的介绍、数据准备和预处理、模型架构、具体的训练方法、模型评估,以及LLMs常用的训练框架。 目前,所有LLMs都基于Transformer架构,使这些模型能够扩展到几十亿甚至一万亿个参数。通常,PLM架构分为三类:仅编码器[88]、编码器-解码器[66]和仅解码器[16]。在最新的LLMs中,不再使用仅编码器架构,因此不会在此进一步讨论。相反,本节将重点介绍编码器-解码器和仅解码器架构。

** 大型语言模型的推理**

大型模型的规模以每年近10倍的速度增长,这带来了巨大的计算消耗和碳排放[172]。因此,如何在保持其推理能力的同时减少训练大型模型的计算负担已成为大家共同关注的问题。在本章中,我们主要介绍如何从计算和存储两个方面降低成本,即如何从模型压缩、内存调度、并行性和结构优化四个方面有效地执行大规模模型推理。

结论

ChatGPT的引入开启了大型LLMs领域的变革性时代,显著影响了它们在多样化下游任务中的应用。成本效率高的训练和部署已成为LLMs演化中的一个关键方面。本文提供了一个全面的综述,介绍了大型语言模型训练技术和推理部署技术的演进,以及与低成本开发的新兴趋势相一致。从传统的统计语言模型到神经语言模型,再到像ELMo和Transformer架构这样的PLMs的发展,为LLMs的主导地位奠定了基础。这些模型的规模和性能,特别是以GPT系列为例,已达到前所未有的水平,展示了“出现”现象,并在各个领域中实现了多功能应用。值得注意的是,OpenAI在2022年11月发布ChatGPT,标志着LLM领域的一个关键时刻,彻底改变了AI算法的强度和有效性。然而,目前对OpenAI基础设施的依赖凸显了替代LLMs的必要性,强调了领域特定模型和训练及部署过程的进步的需求。

训练和部署LLMs提出了需要在处理大规模数据和分布式并行训练方面具有专业知识的挑战。LLM开发所需的工程能力凸显了研究人员和工程师之间的协作努力的必要性。当我们在这篇综述中探讨LLM训练和推理的技术方面时,很明显,对这些过程的深刻理解对于涉足该领域的研究人员至关重要。展望未来,LLMs的未来方向包括模型架构的进一步发展、训练效率的提高和在各行业的更广泛应用。这篇综述提供的见解旨在为研究人员提供了解和掌握LLM开发复杂性所需的知识,促进这一动态领域的创新和进步。随着LLMs的不断发展,它们对自然语言处理和整个AI的影响有望塑造智能系统未来的发展格局。