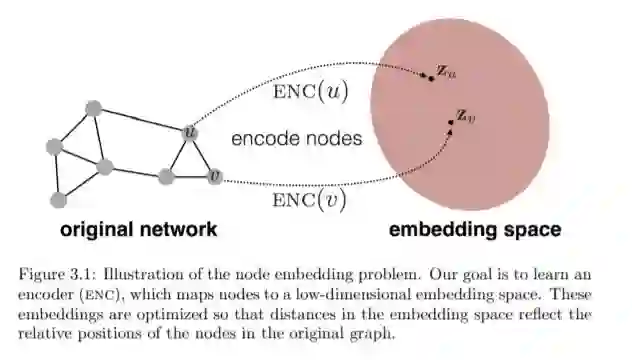

这部分是关于学习节点嵌入的方法。这些方法的目标是将节点编码为低维向量,这些低维向量总结了它们的图位置和它们的局部图邻域的结构。换句话说,我们希望项目节点为一个潜在的空间,在这个潜在的空间几何关系对应关系(例如,边缘)在原来的图或网络(Ho↵et al ., 2002)(图3.1)。在本章中,我们将提供简单和加权图的节点嵌入方法的概述。

成为VIP会员查看完整内容

相关内容

专知会员服务

78+阅读 · 2020年5月11日

专知会员服务

80+阅读 · 2019年11月5日

Arxiv

5+阅读 · 2019年8月24日

Arxiv

7+阅读 · 2019年7月10日

Arxiv

3+阅读 · 2019年3月13日