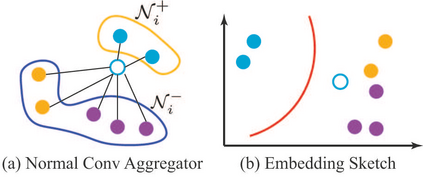

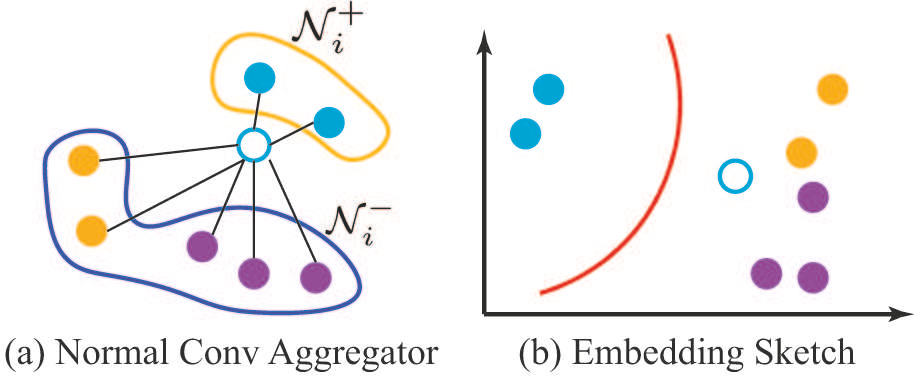

Graph classification is practically important in many domains. To solve this problem, one usually calculates a low-dimensional representation for each node in the graph with supervised or unsupervised approaches. Most existing approaches consider all the edges between nodes while overlooking whether the edge will brings positive or negative influence to the node representation learning. In many real-world applications, however, some connections among the nodes can be noisy for graph convolution, and not all the edges deserve your attention. In this work, we distinguish the positive and negative impacts of the neighbors to the node in graph node classification, and propose to enhance the graph convolutional network by considering the labels between the neighbor edges. We present a novel GCN framework, called Label-aware Graph Convolutional Network (LAGCN), which incorporates the supervised and unsupervised learning by introducing the edge label predictor. As a general model, LAGCN can be easily adapted in various previous GCN and enhance their performance with some theoretical guarantees. Experimental results on multiple real-world datasets show that LAGCN is competitive against various state-of-the-art methods in graph classification.

翻译:在许多领域, 图表分类实际上很重要 。 为了解决这个问题, 人们通常会用监督或不受监督的方法来计算图中每个节点的低维代表度。 大多数现有方法会考虑节点之间的所有边, 忽略节点的边际会给节点代表学习带来正面或负面的影响 。 但是, 在许多现实世界应用中, 节点之间的某些连接会为图形相投而吵闹, 而不是所有的边点都值得你注意 。 在这项工作中, 我们区分图节点分类中邻居对节点的正负影响, 并提议通过考虑相邻边缘之间的标签来增强图动网络 。 我们提出了一个新型的GCN 框架, 称为 Label-aware 图形相动网络( LAGCN ), 它将通过引入边缘标签预测器来整合受监督和不受监督的学习 。 作为一般模型, LAGCN 很容易在以前的多个GCN 中进行调整, 并用一些理论保证来提高它们的性能 。 在多个真实世界数据集上的实验结果显示, LAGCN 与图形分类中的各种状态方法具有竞争力 。