尽管深度强化学习(RL)在机器学习领域取得了多项引人注目的成功,但其在数据效率方面的不足以及所学策略泛化能力有限,仍然制约了其更广泛的应用。一个有前景的方法是将设计更优强化学习算法本身视为一个机器学习问题,这一过程被称为元强化学习(meta-RL)。元强化学习最常见的研究场景是在给定一组任务分布的前提下,学习一个策略,使其能够以尽可能少的数据适应该分布中的任意新任务。 在本综述中,我们将详细介绍元强化学习的问题设定及其主要变体。我们从高层次的角度出发,探讨了元强化学习研究如何根据任务分布的存在与否以及每个任务所分配的学习预算进行分类。在此基础上,我们对各类元强化学习算法及其应用进行了系统梳理。最后,我们总结了当前尚未解决的问题,并探讨了如何使元强化学习成为深度强化学习实践者的标准工具之一。

元强化学习(Meta-Reinforcement Learning,简称 meta-RL)是一类机器学习(ML)方法,其目标是“学会如何进行强化学习”。换言之,meta-RL 方法利用样本效率较低的机器学习过程,来学习样本效率更高的强化学习算法,或其组成部分。因此,meta-RL 是元学习(meta-learning)的一个特例,其特点在于学习得到的算法是一个强化学习算法。 将元强化学习视为机器学习问题已有相当长的历史(Schmidhuber, 1987;Schmidhuber et al., 1997;Thrun and Pratt, 1998;Schmidhuber, 2007)。有趣的是,研究还发现人脑中存在类似元强化学习的机制(Wang et al., 2018)。meta-RL 有潜力克服现有人工设计的强化学习算法的一些局限。尽管近年来深度强化学习取得了显著进展,成功案例包括掌握围棋(Silver et al., 2016)、平流层气球导航(Bellemare et al., 2020)和复杂地形中的机器人行走(Miki et al., 2022),但强化学习依然高度依赖大量样本,这限制了其在现实世界中的应用。meta-RL 可以生成比现有方法更高效的强化学习算法(或其组成部分),甚至能够解决原本难以处理的问题。 当然,提高测试阶段样本效率的代价是:第一,元学习相比标准学习需要更多的数据,因为它训练的是整个学习算法(通常跨多个任务);第二,元学习依赖于对“元训练数据”的拟合,这可能降低其在其他任务上的泛化能力。因此,meta-RL 所提供的是一种权衡:在训练阶段牺牲样本效率以及测试阶段的泛化能力,以换取测试阶段的高适应效率。 示例应用场景

以“自动做饭”的机器人厨师为例:该机器人部署在用户厨房时,必须学习一个特定于该厨房的策略,因为每个厨房的布局和电器都不同。问题更加复杂的是,并非所有烹饪用具都是可见的:锅可能放在橱柜里,调料藏在高架上,餐具在抽屉中。因此,机器人不仅需要理解厨房的一般布局,还要记住发现物品的位置。 若从零开始直接训练机器人在新厨房中做饭,既耗时又可能由于早期行为的随机性而带来安全隐患。一种替代方案是在一个训练厨房中预训练机器人,然后在新厨房中微调。但这种方法未考虑微调过程的优化。而 meta-RL 会在多个厨房的任务分布上进行训练,从而让机器人能适应任意厨房。这可能涉及学习某些参数以提升微调效果,或直接学习一个可部署的新强化学习算法。以这种方式训练的机器人既能更高效地利用采集到的数据,又能更有效地采集数据,例如关注新厨房中不寻常或具挑战性的特征。

虽然这种 meta-learning 方法所需的训练样本远多于简单微调,但只需训练一次,并能显著提升部署后的适应效率。这个例子表明,meta-RL 尤其适用于对高效适应有频繁需求的场景,例如安全关键型的强化学习任务——在这些任务中,数据采集成本高,探索新行为可能代价高昂或危险。在这类情况下,前期通过实验室或仿真环境进行样本效率较低的学习是值得的。

值得一提的是,目前 meta-RL 在实践中多用于较小规模的机器人任务,如机器人操控(Akkaya et al., 2019;Zhao et al., 2022b)和运动控制(Song et al., 2020b)。

综述范围

本文综述的是机器学习领域的元强化学习研究,不包括神经科学等其他领域的相关工作。与 meta-RL 密切相关的机器学习方向将在第 2.6 节中讨论。为了全面呈现 meta-RL 的研究广度与深度,我们调研了多个重要机器学习会议和专题研讨会的论文,时间跨度为 2017 至 2022 年。我们发现,大多数 meta-RL 的研究工作集中在 2016 年之后,主要分布于 NeurIPS、ICML 和 ICLR 三个会议。完整会议和研讨会列表见附录 A。

虽然综述主要聚焦于上述会议和时间范围,我们也纳入了一些重要但不在此范围内的研究论文。我们在会议和研讨会论文中搜索了显式提及 meta-RL 的文章,也包括一些虽未明确使用该术语但实质符合 meta-RL 范畴的研究。需要说明的是,本综述并不力求穷尽所有 meta-RL 研究,而是提供一个对核心思想和主要方向的整体性概览。

综述结构

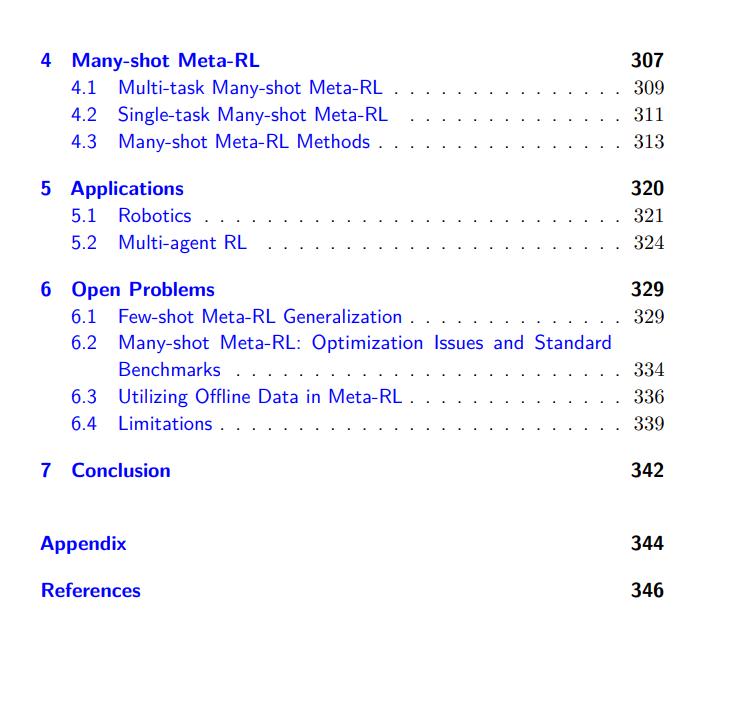

本综述旨在为 meta-RL 提供入门介绍,同时反映该领域的研究现状与开放问题。 * 第2节:定义 meta-RL 及其适用的问题设定,并介绍两个代表性算法; * 第3节:聚焦“少样本 meta-RL”这一最常见的问题设定,目标是训练能快速适应(在少量训练回合内完成学习)的强化学习算法。此类算法通常基于任务分布训练,并学习如何高效适应分布中的任意任务。图 1.1 所示的玩具示例展示了这种设定:一个智能体被 meta 训练以学习在二维平面中导航至不同(初始未知)目标点,在 meta 测试阶段能够高效适应新任务; * 第4节:探讨“多样本 meta-RL”设定,目标是学习通用强化学习算法,而非仅针对特定任务分布。此类算法可通过多任务训练,或在单一任务上与标准 RL 并行进行 meta 学习; * 第5节:介绍 meta-RL 的实际应用,如机器人控制; * 第6节:总结开放问题,包括:少样本 meta-RL 在更广泛任务分布上的泛化能力、多样本 meta-RL 的优化难题、以及如何降低 meta 训练成本。

为了提供 meta-RL 研究的高层次总结,我们在各节中收录并整理了代表性论文,并以表格形式呈现。