知识库上的问答(QA)提供了一种用户友好的方式来访问存储在知识库中的大量信息。由于最近在深度神经模型的表征学习方面取得的进展,我们在QA系统的性能上取得了巨大的进步。然而,这种深度模型作为黑盒的功能,具有不透明的推理过程,很脆弱,并且提供非常有限的控制(例如,用于调试错误的模型预测)。目前还不清楚如何可靠地添加或更新存储在其模型参数中的知识。

本论文提出了用于回题的非参数模型,该模型将逻辑与知识分离开来。对于一个给定的查询,所提出的模型能够从训练集中的其他上下文相似的查询中 "即时"得出可解释的推理模式。我们表明,我们的模型可以无缝地处理新的知识(新的实体和关系),因为它们被不断地添加到知识库中。我们的模型对需要子图推理模式的复杂和组合性自然语言查询是有效的,甚至在推理模式(逻辑形式)的注释不可用时也能工作,在多个基准上取得了新的最先进的结果。利用我们的非参数化方法,我们还证明有可能纠正深度QA模型的错误预测,而不需要重新训练,从而为建立更加可控和可调试的QA系统铺平道路。最后,与深度参数模型相比,本论文证明了非参数推理模型(i)可以更好地概括需要复杂推理的问题,特别是在训练期间看到的问题数量有限的情况下(ii)可以在新数据增加时更有效地推理,(iii)为其预测提供更多的可解释性,(iv)更可控和可调试。

第一章 引言

自动推理,即计算系统从观察到的证据中做出新推论的能力,一直是人工智能的一个长期目标。我们对具有丰富多样语义类型的大型知识库(KBs)的自动推理感兴趣(157;7;14)。无论是自动还是手动构建的知识库,往往都是不完整的。然而,许多有效的未观察到的事实可以通过推理从观察到的KB事实中推断出来。存储在知识库中的大部分信息都是形式为(e1,r, e2)的符号事实,其中e1, e2表示实体,r表示语义关系。因此,知识库可以被自然地描述为一个图,其中实体是节点,关系是标记的边。

访问存储在知识库中的信息的一个有效和用户友好的方法是向它发出查询。这种查询可以是结构化的(如预订航班的查询)或非结构化的(如自然语言查询)。在知识库上的问答(QA)系统面临的一个挑战是处理那些答案没有直接存储在知识库中(作为一个简单的事实)的查询,相反,QA模型需要推理,以便从其他观察到的事实中得出答案。这篇论文的重点是在结构化的KB上建立能够进行这种推理的QA系统。

由于最近深度神经模型在表征学习方面的进展,我们在QA和KB完成系统的性能方面取得了巨大的进步。然而,这样的深度模型也有很多实际的不足之处。比如说:

-

目前的质量保证和知识库完成模型通常是黑盒式的评分函数,学习实体和关系的固定词汇的向量表示(9;155;162;55)。模型的参数同时存储了逻辑和知识,使得模型所使用的底层推理过程不透明,也不清楚。

-

可以向质量保证系统提出的问题类型基本上是没有限制的,因此,模型必须学习并存储在其参数中的推理模式类型是巨大的。此外,在训练过程中,一个模型可能只遇到每种问题类型的几个训练实例。我们表明,KBQA的参数化模型在这样的环境中很困难(29)。

-

我们生活在一个不断发展的世界中,有很多异质性,同时新的实体和关系也在不断被创造。例如,描述新实体事实的科学论文和维基百科页面被不断添加。这些新的发现进一步引发了更多新的事实的推论,每一个事实都有其不同的推理。由于固定的预定义词汇,目前的知识库完成模型不能处理新增加的实体和关系,也不能对新数据进行推理。

-

随着我们观察到新证据(数据),人类的推理过程变得更加细微,即新的推理规则出现,现有的推理规则随着新数据的加入而演变。目前还不清楚如何稳健地更新深度神经模型的参数来编码更新的(和新的推理规则)。正如我们在论文后面所显示的,模型在对新到的数据进行训练时,往往会出现灾难性的遗忘,即模型已经忘记了它之前所学的东西(28;31)。

-

最后,当模型对一个给定的问题输出错误的预测时,它们为我们提供的见解和对错误预测的调试控制非常有限(31)。我们表明,非参数模型让我们有新的机会来修复错误的模型预测,让我们向KNN记忆 "注入 "案例,使模型更有可解释性和可控性。

1.1 期望

我们希望为大型知识库的问答设计准确的模型,并具有以下理想的特性:

-

适用于新加入的数据。我们需要能够与动态世界无缝推理的模型。这意味着模型应该能够处理新的实体和关系,以及随着新数据的加入而出现的新的(潜在的)推理规则。

-

准确地回答需要复杂推理模式的各种自然语言查询。知识库的自然语言界面为存储在其中的信息提供了一种用户友好的访问方式。自然语言查询还允许我们提出更复杂的问题,这些问题很难用单一的知识库关系来表达。此外,看似简单的问题可能需要涉及KB中多个事实的复杂推理(例如,居里家族的成员获得了多少诺贝尔奖?) 回答许多这样的问题所需要的推理模式是子图的形状,而且往往比简单的推理链更复杂。我们需要能够对复杂的(潜在的)子图图谱进行所需的推理的模型,以准确回答此类问题。

-

具有可控性和可调试性的可解释推理过程。目前的QA和KB完成模型作为黑盒的功能,对其推理过程提供了有限的见解。此外,当它们对一个查询输出错误的预测时,除了在失败的输入上重新训练模型外,我们没有什么可以做的。我们需要的模型不仅在如何得出查询的答案方面提供更多的透明度,而且是可控制和可调试的,对如何修复错误的模型预测提供更好的洞察力。

1.2 已完成的工作总结

本论文提出建立模型,将逻辑与存储在模型参数中的数据分离开来。所建议的模型不是记忆数据并将其存储在参数中,而是学习如何浏览知识图谱来回答一个给定的查询。我们提出的解决方案MINERVA(26),将知识图谱(KG)视为强化学习(RL)框架中的一个环境。从对应于查询实体的节点开始,MINERVA通过从所有边的集合(行动空间)中选择一条出站边来遍历知识图谱。这样重复进行,直到代理决定在它认为是答案的节点上停止。在训练过程中,如果终端节点是给定查询的答案,环境就会给予积极的奖励。应该强调的是,MINERVA不是记忆KG,而是学习如何为给定的查询进行导航。这使得MINERVA能够泛化到包含未见过的实体的图的新部分。此外,所穿越的关系边的序列也为模型所采用的推理过程提供了可解释性。然而,浏览KG的逻辑,即下一步选择哪条关系边缘,完全是由模型的参数来编码的。这意味着MINERVA将无法适应添加到KG中的新关系,因为没有经过训练的参数来适应它们。另外,随着新信息的加入,现有的规则会不断演变,新的推理规则也会出现。随着新数据的加入,MINERVA将无法使用新的(或进化的)规则进行推理(无需重新训练)。

为了能够对动态世界进行推理,我们提出了能够进行非参数和背景推理的模型(27)。给定一个关于新实体的查询,我们的模型在我们观察到查询关系的KG中找到其他上下文相似的实体。接下来,我们收集多个推理路径,将检索到的实体与使用查询关系的实体相连接。最后,这些推理路径会在查询实体周围的子图中被遍历,从而得出答案。这种非参数化的方法使我们能够与新到达的数据进行无缝推理。回答一个新增加的实体的查询所需的推理模式可以从知识库中的现有实体中导出。同样地,任何新增加的数据都可以被纳入,以完善对现有实体的查询的预测。(27)中提出的算法对从上下文实体中收集的所有路径进行了平等处理。然而,并不是所有的路径对推理都同样重要。事实上,经常存在一些 "虚假 "的路径,它们将问题实体与答案实体连接起来,但并不是有效的推理链。为了处理这种情况,我们提出了一种概率方法,用先验分和精确分来衡量每条推理路径(28)。我们证明了我们简单的基于CBR的方法不仅在各种知识库完成基准上取得了最先进的性能(168;187),而且在一个具有挑战性的开放世界知识库完成设置中,以很大的幅度超过了SOTA模型,在这个世界中,新的实体和事实正在不断地被添加。

本论文到目前为止所描述的工作,接受结构化查询(e1,r,?)作为输入。如前所述,知识库的自然语言界面为用户提供了对知识库中存储信息的友好访问。自然语言(NL)查询也允许我们提出难以用单一KB关系表达的问题。为了处理复杂的NL查询,我们引入了一种非参数化的语义解析方法,从训练集中检索其他类似的NL查询及其逻辑形式。然后,一个神经编码器-解码器模型以检索到的案例为条件,得出给定查询的逻辑形式(31)。我们表明,我们提出的方法对复杂的组合性问题非常有效,这些问题需要在训练过程中没有看到的新的KB关系组合,从而在多个KBQA数据集(192;164;77)中获得最先进的结果。

上述方法让人想起几十年前经典人工智能中提出的非参数框架--基于案例的推理(147;84)。一个CBR系统(1)的简图包括:(i)一个检索模块,其中检索与给定问题相似的 "案例",(ii)一个重用模块,其中重新使用检索到的案例的解决方案来合成一个新的解决方案。通常情况下,新的解决方案不起作用,需要更多的修改,这由(iii)修改模块来处理。最近,在质量保证方面有很多工作,从非参数存储器中检索相关证据(59;94;75)。另一项工作(96)是从文件中预先生成一个大的问题集。回答一个问题可以归结为在生成的列表中找到最相似的问题解析(使用KNN搜索)并返回相应的答案。

相比之下,我们的CBR方法是从训练数据(或KG)中检索与给定查询有关联的查询(或一个实体)。检索到的查询不需要是转述,但应该有关系上的相似性(例如,对于 "哪些国家与美国接壤?"的查询,一个最近的邻居问题可能是 "哪些国家与印度接壤?") 接下来,它找到解释解决所检索查询的推理模式(KG路径或子图)。最后,检索到的推理模式被用来推导出一个适用于给定查询的推理模式。与(96)提出的方法相比,我们认为我们的方法(31)是一种更稳健的非参数推理方式,因为不能保证所有问题都能从文档中预先生成。

然而,以前的工作(31)需要在训练过程中对逻辑形式进行注释,这对大规模的注释来说是非常昂贵的。此外,一个模式的注释并不能推广到不同的模式。我们假设在一个大的知识库中,回答一个查询类型所需的推理模式在它们各自的子图邻域中的各种实体中重复出现(29)。利用不同子图的局部邻域之间的这种结构相似性,我们引入了一个半参数模型,包括:(i)一个非参数组件,对于每个查询,动态地检索其他类似的k-近邻(KNN)训练查询以及查询特定的子图;(ii)一个参数组件,它被训练来识别来自KNN查询子图的(潜在)推理模式,然后将其应用于目标查询的子图。我们还提出了一种新的算法,从大规模知识图谱(KG)中选择一个特定于查询的紧凑子图,使我们能够扩展到包含数十亿条边的完整Freebase KG。

最后,本论文探讨了非参数模型的另一个有用属性。当QA模型对一个查询输出错误的预测时,非参数模型给我们提供了一个机会,通过向KNN索引注入相关案例来 "修复 "错误的预测。另一个选择是在失败的输入上训练模型,但我们发现,除非在失败的例子上进行仔细的微调,否则模型经常表现出灾难性的遗忘。相反,我们表明,在向KNN索引添加一些简单的案例(查询,逻辑形式对)时,我们的模型能够检索到新添加的案例,并使用它来推导出正确的逻辑形式,本质上修复了错误的预测。我们利用这一特性来证明,一个质量保证模型可以被用来回答那些需要关系的查询,而该模型从未被训练过,这为实现实用的生产准备模型铺平了道路。

1.3 本文背景下的推理

归纳推理是一种逻辑推理的形式,它使用观察结果来合成一般原则,而这些原则又被用来对未观察到的事物进行预测(72)。大多数机器学习(ML)方法都可以说是属于这一类推理,其中学习的参数编码了这些一般原则,对未观察到的数据的预测涉及模型参数与输入特征的加权组合。ML方法(尤其是深度神经网络)在泛化精度上有了很大的提高,然而,要理解模型参数中所捕捉到的基本泛化原则变得越来越困难。

相反,演绎推理从一组前提(如一组规则)开始,然后根据这些规则得出新的结论。任何通过演绎得出的新结论都可以通过遵循推导过程中使用的推理步骤来清晰地理解。然而,在大多数实际案例中,完整的规则/前提集是未知的。

本论文中提出的大多数工作都结合了归纳推理和演绎推理的优点。例如,MINERVA(第2章)从数据中诱导出通用角条款并将其存储在其参数中,但是在推理过程中,它不是直接输出一个答案实体,而是通过遵循学到的推理规则遍历KG。同样地,CBR(第3章)从KB中针对一个给定的查询实体,从其他类似的实体中飞快地诱导出象征性的加权角条款,最终的答案是通过这些规则的演绎而得到的。在CBR-KBQA(第四章)中,一个神经网络学习从类似查询的注释规则中复制相关关系。然后,神经网络输出查询的逻辑形式(归纳法),然后针对KB执行(演绎法)。因为有了归纳和演绎的成分,论文中的模型享有很高的准确性和可解释性。

我还想指出,本论文中提出的工作也不同于Peirce的归纳推理(63),其目的是找到最可能解释观察的规则。相反,本论文中的所有工作都推导出多种推理规则,并利用这些规则推导出结论。

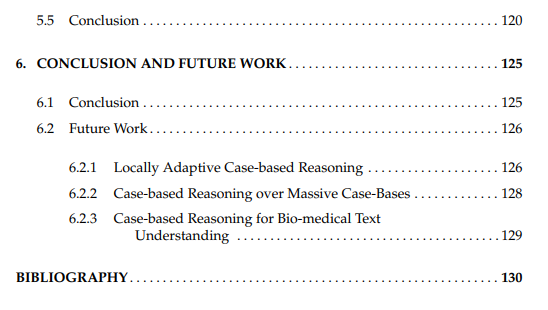

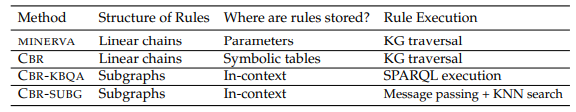

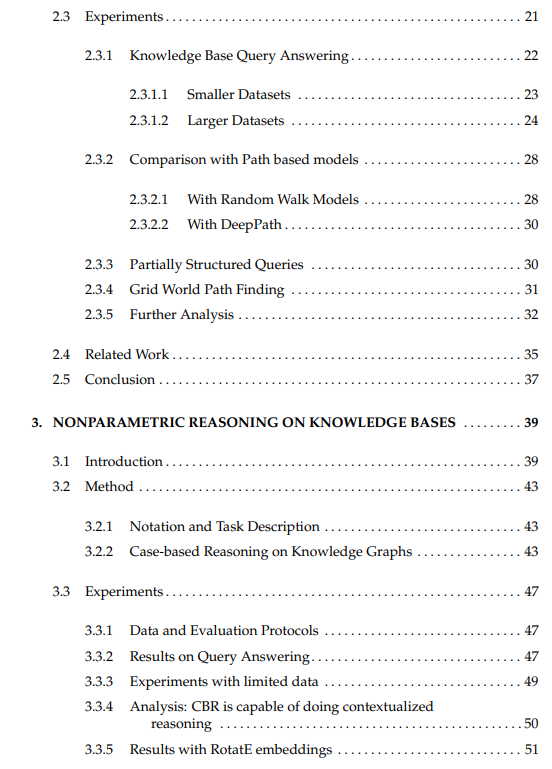

表1.1: 本论文中提出的方法在学习的规则结构方面的分类,它们被储存在哪里,以及这些规则如何被模型执行。

表1.1对本文介绍的方法进行了分类,包括所学规则的结构、存储位置以及规则的执行方式。在MINERVA和CBR中,学到的规则是一连串的KB关系或代表角句的关系链。在CBR-KBQA中,规则采取任意子图的形式(表示为SPARQL查询),而在CBR-SUBG中,规则是(潜在的)子图模式,在多个近邻查询的子图中重复。在MINERVA中,规则被编码在策略网络的参数中。在CBR中,对于一个给定的查询实体和关系,规则是从其他类似的实体中即时衍生出来的。这些规则是符号化的,存储在表格中。在PRCBR(28)中,每个规则都与所有可能的KB查询关系的标量分数有关。在CBR-KBQA和CBR-SUBG中,规则是根据上下文检索的。例如,对于CBR-KBQA,每个检索到的问题都与一个注释的SPARQL查询配对,对于CBR-SUBG,每个检索到的查询子图都包含潜在的推理子图。CBR-KBQA和CBR-SUBG的参数组件学习从上下文中存在的规则中识别所需的关系集,并输出一个逻辑形式(对于CBR-KBQA)或一个答案实体节点(对于CBR-SUBG)。最后,对于MINERVA和CBR来说,规则是通过遵循诱导规则遍历KG来执行的(推理)。在CBR-KBQA中,学到的规则可以用SPARQL解释器针对KB执行。最后,在CBR-SUBG中,节点表示是通过消息传递形成的,它(希望)在回答节点的表示中编码推理子图。然后,查询子图中的答案节点通过对检索到的KNN问题的已知答案节点进行相似性搜索来确定。

1.4 本文组织

本论文建议文件组织如下。

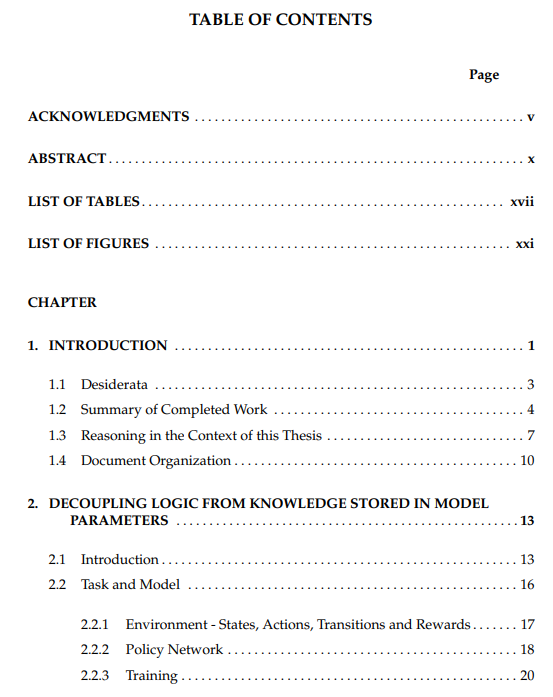

第二章,介绍了我们提出的模型(MINERVA),该模型参数中的逻辑与知识解耦。我们将演示MINERVA如何在KG上行走,以找到一个给定查询的答案。

第三章,我们描述了我们的非参数推理方法来完成知识库,并在一个具有挑战性的开放世界的知识图谱完成环境中证明了其功效。

第四章将我们的非参数方法扩展到自然语言中复杂的组合查询。利用我们模型的非参数属性,我们表明有可能 "修复 "深度QA模型的错误预测,而不需要重新训练它们。

第五章,描述了我们的解决方案,即对需要复杂子图推理模式的问题进行KBQA,而不需要在训练中注释逻辑形式。我们表明,我们提出的模型(CBR-SUBG)可以回答需要复杂推理模式的问题,即使它在训练期间只看到少数问题类型的例子;可以泛化到包含全新实体的图,并令人信服地超过基于路径的模型。我们还表明,模型的性能,以真正的非参数方式,随着更多证据(类似问题)的检索而增加。