本文分析了Hugging Face平台上近46万张AI模型卡,以考察开发者如何报告风险。从中提取出约3000条独立风险陈述,并构建了“AI模型风险目录”。我们将这些风险与MIT风险知识库中研究者识别的风险及AI事件数据库中的真实事件进行对比。开发者聚焦于偏见与安全等技术问题,而研究者则更强调广泛的社会影响。两组群体均较少关注欺诈与操纵——这些正是人类与AI交互过程中产生的常见危害。我们的研究结果表明,需要更清晰、结构化的风险报告机制,以帮助开发者在设计初期就考量人机交互与系统性风险。

风险与危害始终是AI安全与伦理研究的核心议题。研究者致力于识别并梳理这些概念以构建分类体系(Weidinger et al. 2022; Yampolskiy 2016)。部分研究聚焦大语言模型与生成式AI(Weidinger et al. 2021, 2022; Stahl and Eke 2024),另一些则关注更广泛的AI系统(Yampolskiy 2016; Wirtz, Weyerer, and Sturm 2020)或人工通用智能(McLean et al. 2023)。这些研究对风险与危害的定义往往存在差异。我们遵循OECD标准(Perset and Aranda 2024),将风险定义为危害发生的概率,危害则是已造成损害的风险。在某些语境中,这两个术语可互换使用。MIT风险知识库(Slattery et al. 2024)汇集了AI框架学术研究中的风险,是迄今最大规模的研究者识别AI风险集合。AI事件数据库(McGregor 2021)则收录真实世界危害事件,并由Velazquez等学者(2024)进一步分类。

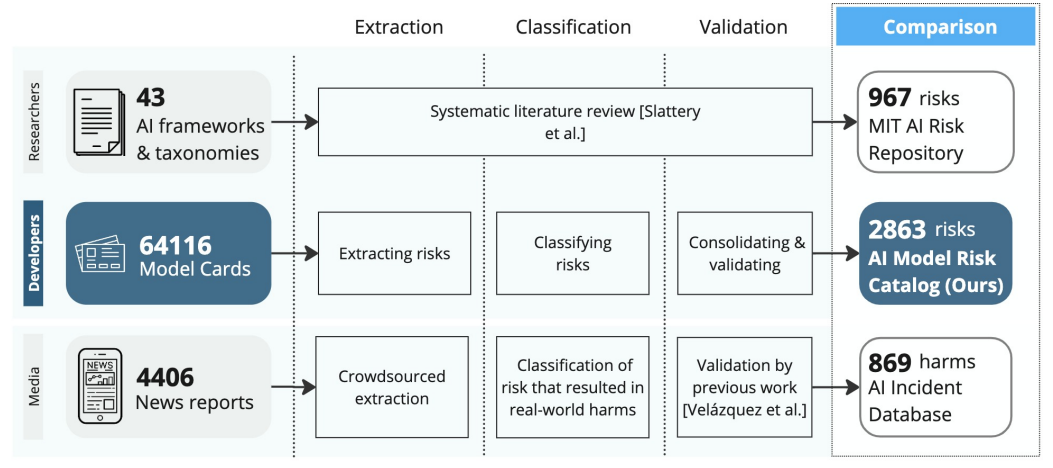

现有研究尚未深入探讨开发者如何描述特定模型的风险,或这些模型在典型用户场景中可能出现的故障。这一视角至关重要,因为开发者能为其构建系统的行为与局限提供 grounded 洞察。为弥补特定模型风险数据及其开发者描述的缺失,我们分析了截至2024年7月Hugging Face平台近50万张模型卡(Mitchell et al. 2019)。模型卡是记录AI模型的广泛采用标准,已被主流科技公司与独立开发者普遍使用。本研究作出两项主要贡献(图1):

-

分析开发者识别的风险以构建“AI模型风险目录”。我们收集Hugging Face所有可用模型卡,依据现有分类体系(Weidinger et al. 2022; Slattery et al. 2024)对每类风险中的相似项进行分组,并选取代表性案例。最终形成包含2,863条关联特定模型的分类风险目录。

-

对比开发者、研究者与真实世界危害。我们对比了三类风险强调重点:模型卡中开发者描述的风险、MIT风险知识库中研究者识别的风险,以及AI事件数据库中的真实危害。开发者倾向于报告技术风险(如模型局限、安全问题与偏见),这些占真实事件记录危害的半数以上。研究者关注治理、社会影响与人类能动性威胁,这些合计解释不足15%的事件。值得注意的是,最大比例的事件涉及恶意使用与错误信息。这两类风险在开发者与研究者中均未充分体现,可能因为它们依赖于不可预测的人类行为:研究者难以预见,开发者更难考量(Velazquez et al. 2024)。

最后探讨本目录如何补充现有AI风险测绘工作,及其对开发者、研究者、记者、政策制定者与公众的意义。

图1:研究方法概览。方法包含三个步骤:从模型卡提取风险、分类风险、整合风险以构建AI模型风险目录。随后将目录中开发者报告的风险与MIT风险知识库(Slattery et al. 2024)中研究者识别的风险及AI事件数据库(McGregor 2021)的真实危害进行对比。该目录基于64,116份含风险章节的模型卡,从中提取37,401条风险陈述(含重复项)。经整合后,从2,672份模型卡中识别出2,863条独立风险,使之成为三大来源中最大规模的AI风险集合。