【导读】推荐系统是现在习以为常的应用,如何融入元学习方法来解决推荐系统的冷启动或小数据场景是个有趣的问题。上海交大最新《推荐系统中的深度元学习》综述,有40页pdf涵盖135篇文献,全面地概述了当前基于深度元学习的推荐方法。针对推荐场景、元学习技术和元知识表示,提出了一种分类方法,为基于元学习的推荐方法提供了设计空间。值得关注!

作为信息过滤技术,基于深度神经网络的推荐系统近年来取得了很大的成功。然而,由于从头开始的模型训练需要足够的数据,基于深度学习的推荐方法仍然面临数据不足和计算效率低下的瓶颈。元学习作为一种新兴的学习模式,学习如何提高算法的学习效率和泛化能力,在解决数据稀疏问题方面显示出了其优势。最近,越来越多的基于深度元学习的推荐系统的研究出现了,以提高在可用数据有限的推荐场景下的性能,例如用户冷启动和项目冷启动。因此,本研究及时全面地概述了当前基于深度元学习的推荐方法。针对推荐场景、元学习技术和元知识表示,提出了一种分类方法,为基于元学习的推荐方法提供了设计空间。对于每个推荐场景,我们进一步讨论了现有方法如何应用元学习来提高推荐模型的泛化能力的技术细节。最后,我们指出了当前研究的局限性,并指出了未来研究的方向。

https://www.zhuanzhi.ai/paper/6cff1ae05b9c005089acf0838b5fa0a6

近年来,推荐系统作为缓解信息过载的过滤系统被广泛应用于电子商务、娱乐服务、新闻等各种网络应用。推荐系统通过在大量的候选物品中提出个性化的建议,在改善用户体验和增加在线平台吸引力方面取得了巨大的成功。随着数据驱动的机器学习算法[3,90],特别是基于深度学习的方法[9,32,121]的发展,该领域的学术和行业研究在准确性、多样性、可解释性等方面极大地提高了推荐系统的性能。

由于表达表示学习能力能够从足够的数据中发现隐藏的依赖关系,基于深度学习的方法在当代推荐模型中被大量引入[26,121]。通过利用大量具有不同数据结构的训练实例(例如,交互对[121]、序列[20]和图形[26]),具有深度神经结构的推荐模型通常被设计用于有效捕获非线性和非微不足道的用户/物品关系。然而,传统的基于深度学习的推荐模型通常是基于预定义的学习算法,用足够的数据从头开始训练。例如,常规监督学习范式通常使用从所有用户收集的交互来训练一个统一的推荐模型,并基于学习到的特征表示对未看到的交互进行推荐。这种基于深度学习的方法通常需要大量的数据和计算。换句话说,基于深度学习的推荐系统的性能很大程度上依赖于大量训练数据的可用性和足够的计算量。在实际的推荐应用中,数据的收集主要来源于用户在访问网络平台过程中观察到的用户互动。存在可用用户交互数据稀疏(如冷启动推荐)和模型训练计算受限(如在线推荐)的推荐场景。因此,数据不足和计算效率低下的问题成为基于深度学习的推荐模型的瓶颈。

最近,元学习提供了一种很有吸引力的学习范式,它针对数据和计算的不足,着重加强机器学习方法的泛化能力[36,98]。元学习的核心思想是从先前的多任务学习过程中获得关于高效任务学习的先验知识(即元知识)。元知识可以促进新任务的快速学习,在看不见的任务上具有良好的泛化性能。在这里,任务通常指属于同一类或具有相同属性的一组实例,涉及其上的单个学习过程。与提高深度学习模型的表征学习能力不同,元学习侧重于学习更好的学习策略来替代固定的学习算法,被称为学习到学习的概念。由于元学习技术在对看不见的任务进行快速适应方面具有巨大的潜力,它被广泛应用于图像识别[4,130]、图像分割[60]、自然语言处理[48]、强化学习[75,103]等研究领域。

元学习的好处与推荐模型在实例有限和计算效率低下的情况下的推广需求是一致的。早期基于元学习的推荐方法主要分为个性化推荐算法选择[13,78],提取元数据集的特征,针对不同的数据集(或任务)选择合适的推荐算法。通过运用提取元知识和生成任务特定模型的思想,这种元学习的定义更接近自动化机器学习的研究[39,115]。**随后,深度元学习[38]或神经网络元学习[36]出现,并逐渐成为推荐模型中典型讨论的元学习技术的主流[47,69]。如[36,38]所介绍的,深度元学习旨在提取元知识,以实现深度神经网络的快速学习,这对目前流行的深度学习范式带来了增强。2017年以来,深度元学习在推荐系统研究界受到关注。**在训练传统的深度推荐模型时,首先应用先进的元学习技术来缓解数据不足(即冷启动问题)。例如,最成功的基于优化的元学习框架MAML,以神经网络参数初始化的形式学习元知识,首先在冷启动推荐场景[47]中表现出极大的有效性。此外,在元学习模式下还研究了点击率预测[69]、在线推荐[123]、顺序推荐[125]等多种推荐场景,以提高在数据不足和计算效率低下的情况下的学习能力。

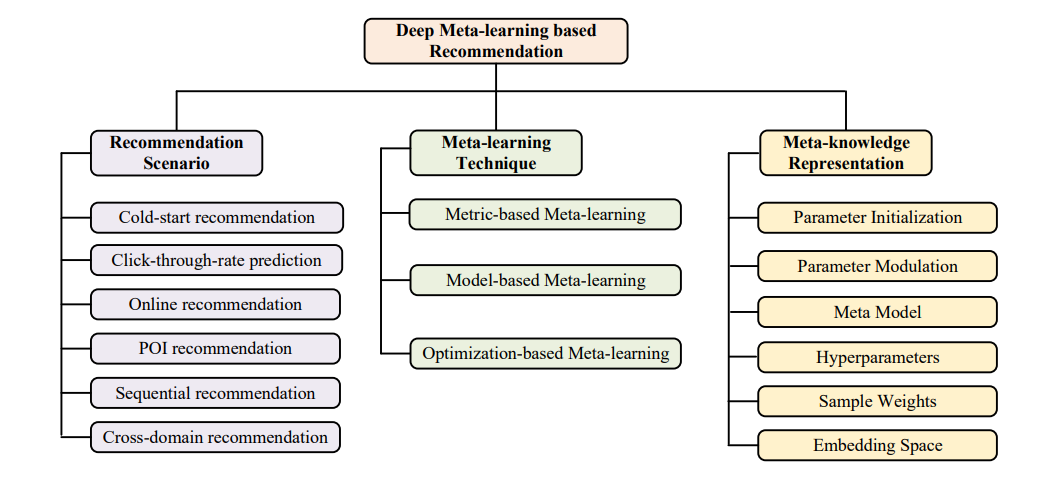

在本文中,我们对快速增长的基于深度元学习的推荐系统的研究进行了及时和全面的综述。在我们的研究中,虽然已经有一些关于元学习或深度元学习的研究综述了通用元学习方法及其应用的细节[36,38,98],但对推荐系统的最新进展仍然缺乏关注。此外,在其他应用领域也有一些关于元学习方法的综述,如自然语言处理[48,117],多模态[61]和图像分割[60]。然而,目前还没有关于深度元学习在推荐系统中的研究。与他们相比,我们的综述是填补这一空白的第一次尝试,系统地回顾了元学习和推荐系统相结合的最新论文。在我们的综述中,我们的目的是全面回顾基于深度元学习的推荐系统的文献,这将有助于读者和研究人员对这一主题的全面理解。为了仔细定位该领域的工作,我们提供了一个从三个角度的分类,包括推荐场景、元学习技术和元知识表示。此外,我们还根据推荐场景讨论了相关的方法,并介绍了不同的作品如何利用元学习技术提取特定的元知识,包括参数初始化、参数调制、超参数优化等多种形式。我们希望我们的分类可以为开发新的基于深度元学习的推荐方法提供设计空间。此外,我们还总结了构建元学习任务的常见方法,这是构建元学习范式的必要条件。 本次综述的结构安排如下。在第2节中,我们介绍了元学习技术的共同基础和典型的推荐场景,其中元学习方法已被研究,以缓解数据不足和计算效率低下。在第3节中,我们将介绍由三个独立轴组成的分类法。在第4节中,我们总结了文献中使用的元学习推荐任务构建的不同方法。然后,我们在第5节详细阐述了在不同推荐场景下使用元学习技术的现有方法的方法论细节。最后,我们在第6部分讨论了该领域未来的研究方向,并在第7部分总结了这一综述。

基于深度元学习的推荐系统分类

在本节中,我们建立了基于深度元学习的推荐系统的分类,并根据分类总结了现有方法的特点。通常,我们根据三个独立的轴来定义分类,包括推荐场景、元学习技术和元知识表示。图1显示了分类法。之前[38,98]对一般元学习方法的分类更多关注2.1节介绍的三种元学习框架,但对元学习技术的实际应用关注有限。此外,[36]提出了一个新的分类法,涉及元表示、元优化器和元目标三个方面。他们提供了一个更全面的分类,可以引导新的元学习方法的发展。但是,它侧重于整个元学习领域,不适合反映基于深度元学习的推荐系统的研究现状和应用场景。