题目: A Survey on Document-level Machine Translation: Methods and Evaluation

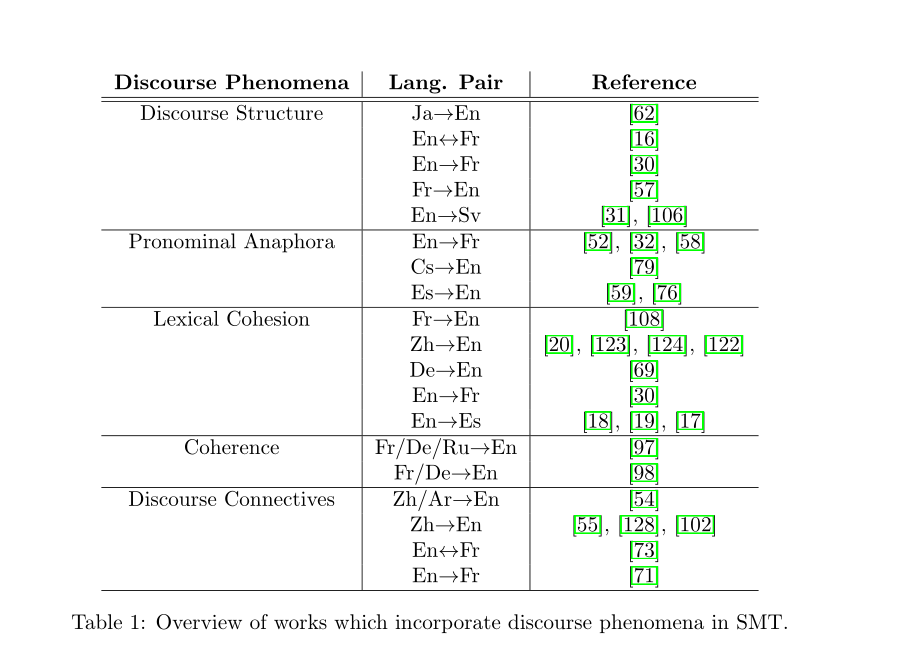

摘要: 机器翻译(Machine translation,MT)是自然语言处理(NLP)中的一项重要任务,它使翻译过程自动化,减少了对人工翻译的依赖。随着神经网络的出现,翻译质量超过了使用统计技术得到的翻译质量。直到三年前,所有的神经翻译模型都是独立翻译句子的,不包含任何额外的句子信息。本文的目的是突出神经革命前后在文档级机器翻译领域所做的主要工作,以便研究人员能够认识到我们从哪里开始,我们正朝着哪个方向前进。在谈到统计机器翻译(SMT)的文献时,我们关注的是那些试图改善特定话语现象翻译的作品,而在神经机器翻译(NMT)中,我们关注的是那些明确使用更广泛语境的作品。除此之外,我们还介绍了为说明该领域的改进而引入的评估策略。

成为VIP会员查看完整内容

相关内容

人工智能(Artificial Intelligence, AI )是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。 人工智能是计算机科学的一个分支。

专知会员服务

9+阅读 · 2020年6月10日

专知会员服务

19+阅读 · 2020年4月25日

专知会员服务

20+阅读 · 2020年1月7日

专知会员服务

41+阅读 · 2019年11月24日

专知会员服务

99+阅读 · 2019年11月11日

Arxiv

4+阅读 · 2019年12月12日

Arxiv

14+阅读 · 2019年1月17日

Arxiv

3+阅读 · 2018年8月27日

Arxiv

5+阅读 · 2018年4月16日