IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)是计算机视觉领域的顶级国际会议,CCF A类会议。CVPR2025将于2025年6月11日至15日在美国田纳西州纳什维尔举办。CVPR 2025 共有13,008 份投稿,录用2878篇,录取率为 22.1%。

![图片]()

- LaVin-DiT:大型视觉扩散 Transformer

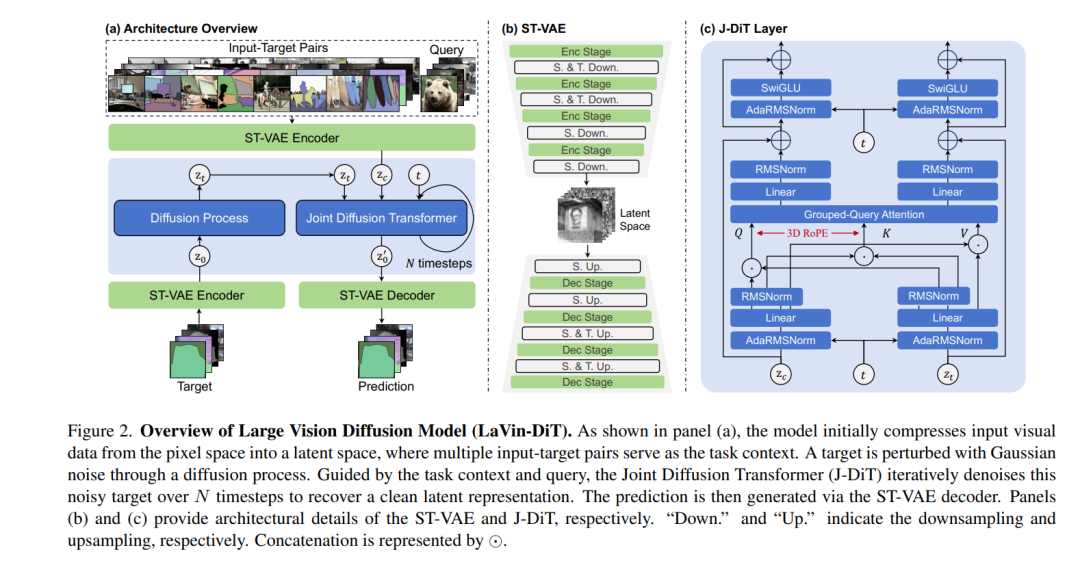

![]() 本文提出了大型视觉扩散 Transformer(LaVin-DiT),这是一个可扩展且统一的基础模型,旨在生成式框架下解决超过 20 种计算机视觉任务。与现有直接从自然语言处理架构改编的大型视觉模型不同,这些模型依赖于效率较低的自回归技术,并破坏了视觉数据中至关重要的空间关系,而 LaVin-DiT 引入了关键创新以优化视觉任务的生成性能。首先,为了解决视觉数据的高维性问题,我们引入了一种时空变分自编码器,将数据编码到连续的潜在空间中。其次,为了实现生成建模,我们开发了一种联合扩散 Transformer,逐步生成视觉输出。第三,为了实现统一的多任务训练,我们采用了上下文学习(in-context learning)方法。输入-目标对作为任务上下文,指导扩散 Transformer 在潜在空间中将输出与特定任务对齐。在推理过程中,任务特定的上下文集和测试数据作为查询,使 LaVin-DiT 能够在无需微调的情况下跨任务泛化。通过在大量视觉数据集上进行训练,该模型的参数规模从 0.1B 扩展到 3.4B,展示了其显著的可扩展性,并在多种视觉任务中实现了最先进的性能。这项工作为大型视觉基础模型开辟了一条新路径,凸显了扩散 Transformer 的广阔潜力。代码和模型均已公开。

本文提出了大型视觉扩散 Transformer(LaVin-DiT),这是一个可扩展且统一的基础模型,旨在生成式框架下解决超过 20 种计算机视觉任务。与现有直接从自然语言处理架构改编的大型视觉模型不同,这些模型依赖于效率较低的自回归技术,并破坏了视觉数据中至关重要的空间关系,而 LaVin-DiT 引入了关键创新以优化视觉任务的生成性能。首先,为了解决视觉数据的高维性问题,我们引入了一种时空变分自编码器,将数据编码到连续的潜在空间中。其次,为了实现生成建模,我们开发了一种联合扩散 Transformer,逐步生成视觉输出。第三,为了实现统一的多任务训练,我们采用了上下文学习(in-context learning)方法。输入-目标对作为任务上下文,指导扩散 Transformer 在潜在空间中将输出与特定任务对齐。在推理过程中,任务特定的上下文集和测试数据作为查询,使 LaVin-DiT 能够在无需微调的情况下跨任务泛化。通过在大量视觉数据集上进行训练,该模型的参数规模从 0.1B 扩展到 3.4B,展示了其显著的可扩展性,并在多种视觉任务中实现了最先进的性能。这项工作为大型视觉基础模型开辟了一条新路径,凸显了扩散 Transformer 的广阔潜力。代码和模型均已公开。

![]() 2. 无声品牌攻击:针对文本到图像扩散模型的无触发器数据投毒攻击

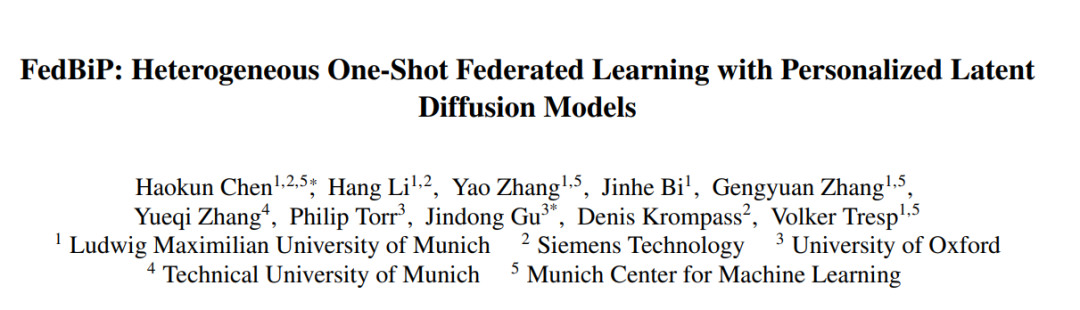

2. 无声品牌攻击:针对文本到图像扩散模型的无触发器数据投毒攻击![]() 文本到图像扩散模型在根据文本提示生成高质量内容方面取得了显著成功。然而,这些模型对公开数据的依赖以及微调中数据共享的日益普遍,使其特别容易受到数据投毒攻击的影响。在本研究中,我们提出了“无声品牌攻击”(Silent Branding Attack),这是一种新颖的数据投毒方法,能够操纵文本到图像扩散模型生成包含特定品牌标志或符号的图像,而无需任何文本触发。我们发现,当某些视觉模式在训练数据中重复出现时,模型会自然地在其输出中重现这些模式,即使提示中未提及。基于这一发现,我们开发了一种自动化的数据投毒算法,能够将标志无缝注入原始图像中,确保其自然融合且不易被察觉。在投毒数据集上训练的模型能够生成包含标志的图像,同时不会降低图像质量或文本对齐效果。我们通过实验验证了无声品牌攻击在两种实际场景中的有效性,包括大规模高质量图像数据集和风格个性化数据集,即使在没有特定文本触发的情况下也能实现高成功率。人类评估和包括标志检测在内的定量指标表明,我们的方法能够隐秘地嵌入标志。项目页面请访问:https://silent-branding.github.io/。

文本到图像扩散模型在根据文本提示生成高质量内容方面取得了显著成功。然而,这些模型对公开数据的依赖以及微调中数据共享的日益普遍,使其特别容易受到数据投毒攻击的影响。在本研究中,我们提出了“无声品牌攻击”(Silent Branding Attack),这是一种新颖的数据投毒方法,能够操纵文本到图像扩散模型生成包含特定品牌标志或符号的图像,而无需任何文本触发。我们发现,当某些视觉模式在训练数据中重复出现时,模型会自然地在其输出中重现这些模式,即使提示中未提及。基于这一发现,我们开发了一种自动化的数据投毒算法,能够将标志无缝注入原始图像中,确保其自然融合且不易被察觉。在投毒数据集上训练的模型能够生成包含标志的图像,同时不会降低图像质量或文本对齐效果。我们通过实验验证了无声品牌攻击在两种实际场景中的有效性,包括大规模高质量图像数据集和风格个性化数据集,即使在没有特定文本触发的情况下也能实现高成功率。人类评估和包括标志检测在内的定量指标表明,我们的方法能够隐秘地嵌入标志。项目页面请访问:https://silent-branding.github.io/。

![]()

- DAMM-Diffusion:学习发散感知的多模态扩散模型用于纳米颗粒分布预测

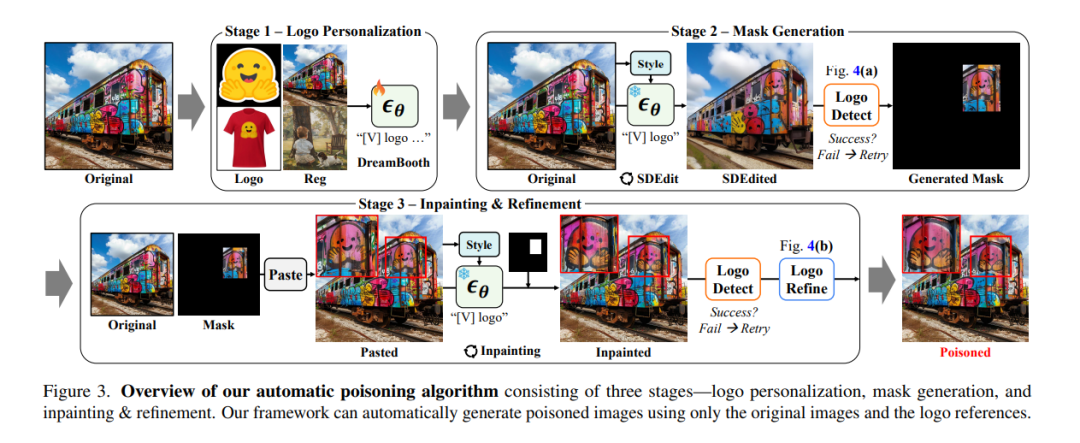

![]() 纳米颗粒(NPs)分布的预测对于肿瘤的诊断和治疗至关重要。最近的研究表明,肿瘤微环境(TME)的异质性高度影响了纳米颗粒在肿瘤中的分布。因此,借助多模态 TME 成分生成纳米颗粒分布已成为研究热点。然而,多模态 TME 成分之间的分布差异可能会导致副作用,即最佳的单模态模型可能优于联合生成模型。为了解决上述问题,我们提出了一种发散感知的多模态扩散模型(即 DAMM-Diffusion),以在统一网络中自适应地生成来自单模态和多模态分支的预测结果。具体而言,单模态分支由 U-Net 架构组成,而多模态分支通过引入两个新颖的融合模块(即多模态融合模块 MMFM 和不确定性感知融合模块 UAFM)对其进行了扩展。其中,MMFM 用于融合多模态特征,而 UAFM 模块则用于学习不确定性图以进行交叉注意力计算。在每个分支生成各自的预测结果后,我们提出了发散感知多模态预测器(DAMMP)模块,用于评估多模态数据与不确定性图的一致性,从而确定最终预测结果是来自多模态还是单模态预测。我们在给定肿瘤血管和细胞核的 TME 成分的情况下预测了纳米颗粒的分布,实验结果表明,DAMM-Diffusion 能够以比对比方法更高的准确性生成纳米颗粒的分布。在多模态脑图像合成任务上的额外结果进一步验证了所提方法的有效性。代码已开源。

纳米颗粒(NPs)分布的预测对于肿瘤的诊断和治疗至关重要。最近的研究表明,肿瘤微环境(TME)的异质性高度影响了纳米颗粒在肿瘤中的分布。因此,借助多模态 TME 成分生成纳米颗粒分布已成为研究热点。然而,多模态 TME 成分之间的分布差异可能会导致副作用,即最佳的单模态模型可能优于联合生成模型。为了解决上述问题,我们提出了一种发散感知的多模态扩散模型(即 DAMM-Diffusion),以在统一网络中自适应地生成来自单模态和多模态分支的预测结果。具体而言,单模态分支由 U-Net 架构组成,而多模态分支通过引入两个新颖的融合模块(即多模态融合模块 MMFM 和不确定性感知融合模块 UAFM)对其进行了扩展。其中,MMFM 用于融合多模态特征,而 UAFM 模块则用于学习不确定性图以进行交叉注意力计算。在每个分支生成各自的预测结果后,我们提出了发散感知多模态预测器(DAMMP)模块,用于评估多模态数据与不确定性图的一致性,从而确定最终预测结果是来自多模态还是单模态预测。我们在给定肿瘤血管和细胞核的 TME 成分的情况下预测了纳米颗粒的分布,实验结果表明,DAMM-Diffusion 能够以比对比方法更高的准确性生成纳米颗粒的分布。在多模态脑图像合成任务上的额外结果进一步验证了所提方法的有效性。代码已开源。![]()

- DifIISR:一种基于梯度引导扩散模型的红外图像超分辨率方法

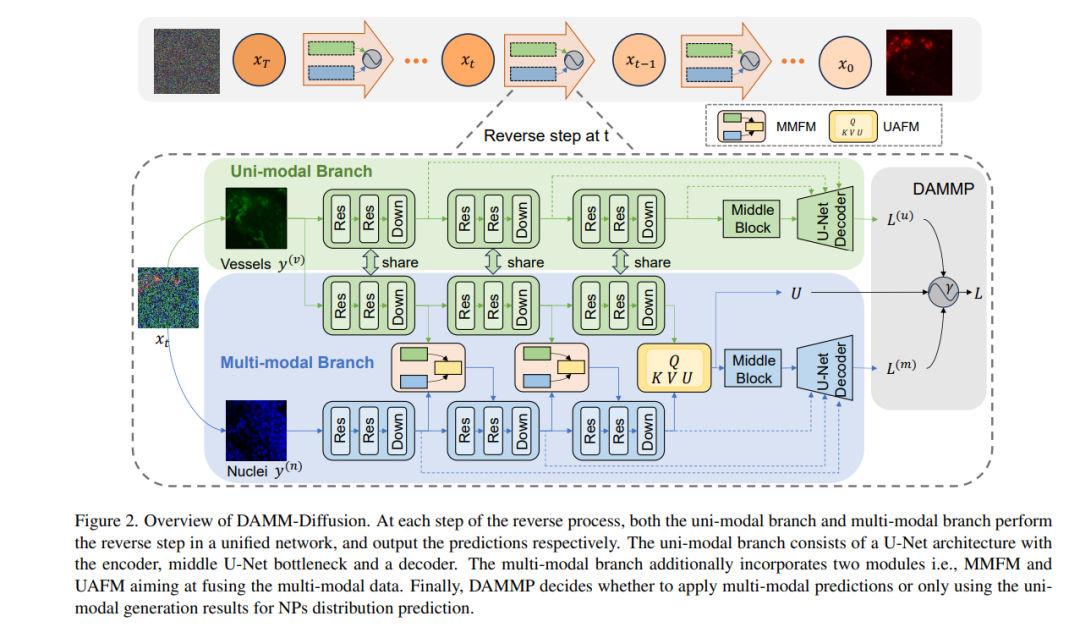

![]() 红外成像因其在复杂环境中的可靠性能,作为辅助模态在自动驾驶和机器人操作中至关重要。尽管红外成像技术广受欢迎,但红外相机的局限性(如低空间分辨率和复杂的退化问题)始终对成像质量和后续视觉任务构成挑战。因此,红外图像超分辨率(IISR)技术应运而生,以应对这一挑战。尽管扩散模型的最新发展极大地推动了这一领域的进步,但现有方法要么忽略了红外成像的独特模态特性,要么忽视了机器感知的需求。为了弥补这些不足,我们提出了 DifIISR,一种针对视觉质量和感知性能优化的红外图像超分辨率扩散模型。我们的方法通过在反向过程中将来自视觉和感知先验的梯度注入噪声,实现了基于任务的扩散引导。具体而言,我们引入了红外热光谱分布调节机制,以保持视觉保真度,通过匹配高频分量确保重建的红外图像与高分辨率图像高度一致。随后,我们整合了多种视觉基础模型作为下游视觉任务的感知引导,注入对检测和分割有益的通用感知特征。因此,我们的方法在获得卓越视觉结果的同时,实现了最先进的下游任务性能。代码已发布于:https://github.com/zirui0625/DifIISR。

红外成像因其在复杂环境中的可靠性能,作为辅助模态在自动驾驶和机器人操作中至关重要。尽管红外成像技术广受欢迎,但红外相机的局限性(如低空间分辨率和复杂的退化问题)始终对成像质量和后续视觉任务构成挑战。因此,红外图像超分辨率(IISR)技术应运而生,以应对这一挑战。尽管扩散模型的最新发展极大地推动了这一领域的进步,但现有方法要么忽略了红外成像的独特模态特性,要么忽视了机器感知的需求。为了弥补这些不足,我们提出了 DifIISR,一种针对视觉质量和感知性能优化的红外图像超分辨率扩散模型。我们的方法通过在反向过程中将来自视觉和感知先验的梯度注入噪声,实现了基于任务的扩散引导。具体而言,我们引入了红外热光谱分布调节机制,以保持视觉保真度,通过匹配高频分量确保重建的红外图像与高分辨率图像高度一致。随后,我们整合了多种视觉基础模型作为下游视觉任务的感知引导,注入对检测和分割有益的通用感知特征。因此,我们的方法在获得卓越视觉结果的同时,实现了最先进的下游任务性能。代码已发布于:https://github.com/zirui0625/DifIISR。

![]()

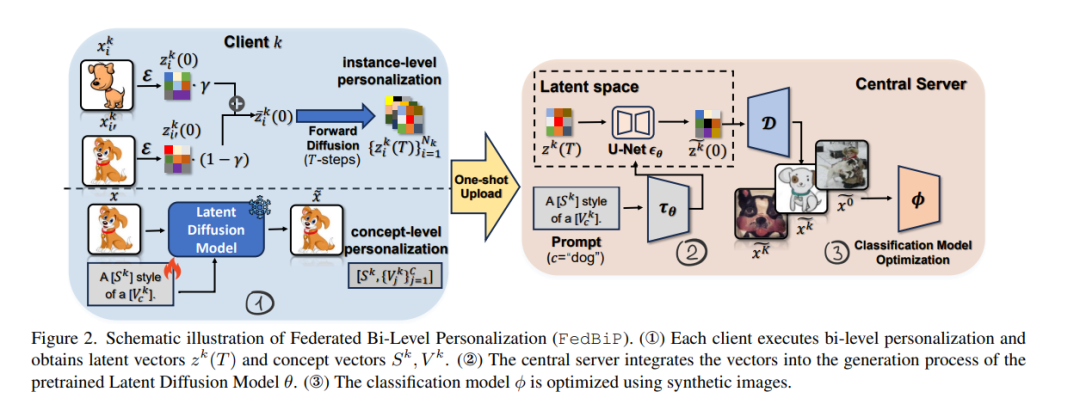

- FedBiP:基于个性化潜在扩散模型的异构单次联邦学习

![]() 单次联邦学习(One-Shot Federated Learning, OSFL)作为一种特殊的去中心化机器学习范式,近年来受到了广泛关注。与传统联邦学习相比,OSFL 仅需一轮客户端数据或模型上传,从而降低了通信成本并减轻了隐私威胁。尽管前景广阔,但现有方法在实际 OSFL 系统中面临客户端数据异构性和数据量有限的挑战。最近,潜在扩散模型(Latent Diffusion Models, LDM)通过在大规模数据集上的预训练,在合成高质量图像方面取得了显著进展,从而为解决这些问题提供了潜在方案。然而,直接将预训练的 LDM 应用于异构 OSFL 会导致合成数据的显著分布偏移,从而导致基于此类数据训练的分类模型性能下降。这一问题在稀有领域(如医学成像)尤为突出,因为这些领域在 LDM 的预训练数据中代表性不足。为了解决这一挑战,我们提出了联邦双层次个性化(Federated Bi-Level Personalization, FedBiP),该方法在实例层次和概念层次上对预训练的 LDM 进行个性化。通过这种方式,FedBiP 能够在不违反隐私规定的情况下,合成符合客户端本地数据分布的图像。FedBiP 也是首个同时解决 OSFL 中特征空间异构性和客户端数据稀缺性问题的方案。我们的方法通过在三个具有特征空间异构性的 OSFL 基准数据集以及具有标签异构性的医学和卫星图像数据集上的广泛实验得到了验证。实验结果表明,FedBiP 的有效性显著优于其他 OSFL 方法。代码已发布于:https://github.com/HaokunChen245/FedBiP。

单次联邦学习(One-Shot Federated Learning, OSFL)作为一种特殊的去中心化机器学习范式,近年来受到了广泛关注。与传统联邦学习相比,OSFL 仅需一轮客户端数据或模型上传,从而降低了通信成本并减轻了隐私威胁。尽管前景广阔,但现有方法在实际 OSFL 系统中面临客户端数据异构性和数据量有限的挑战。最近,潜在扩散模型(Latent Diffusion Models, LDM)通过在大规模数据集上的预训练,在合成高质量图像方面取得了显著进展,从而为解决这些问题提供了潜在方案。然而,直接将预训练的 LDM 应用于异构 OSFL 会导致合成数据的显著分布偏移,从而导致基于此类数据训练的分类模型性能下降。这一问题在稀有领域(如医学成像)尤为突出,因为这些领域在 LDM 的预训练数据中代表性不足。为了解决这一挑战,我们提出了联邦双层次个性化(Federated Bi-Level Personalization, FedBiP),该方法在实例层次和概念层次上对预训练的 LDM 进行个性化。通过这种方式,FedBiP 能够在不违反隐私规定的情况下,合成符合客户端本地数据分布的图像。FedBiP 也是首个同时解决 OSFL 中特征空间异构性和客户端数据稀缺性问题的方案。我们的方法通过在三个具有特征空间异构性的 OSFL 基准数据集以及具有标签异构性的医学和卫星图像数据集上的广泛实验得到了验证。实验结果表明,FedBiP 的有效性显著优于其他 OSFL 方法。代码已发布于:https://github.com/HaokunChen245/FedBiP。

![]()