题目: Debiased Contrastive Learning

摘要:

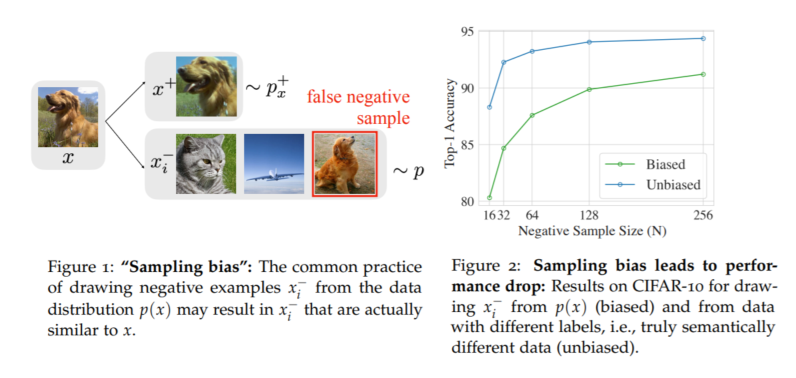

自监督表示学习的一项突出技术是对比语义相似和不相似的样本对。如果无法访问标签,通常会将不同的(负)点视为随机采样的数据点,隐式地接受这些点实际上可能具有相同的标签。不足为奇的是,我们观察到在具有标签的综合环境中,从真正不同的标签中抽取负面样本可以提高性能。受此观察结果的启发,开发了一种反偏差对比目标,即使不知道真实的标签,也可以校正相同标签的数据点的采样。从经验上讲,拟议的目标在视觉,语言和强化学习基准方面始终优于最新的代表性学习。从理论上讲,我们为下游分类任务建立概括边界。

成为VIP会员查看完整内容

相关内容

专知会员服务

41+阅读 · 2020年4月11日