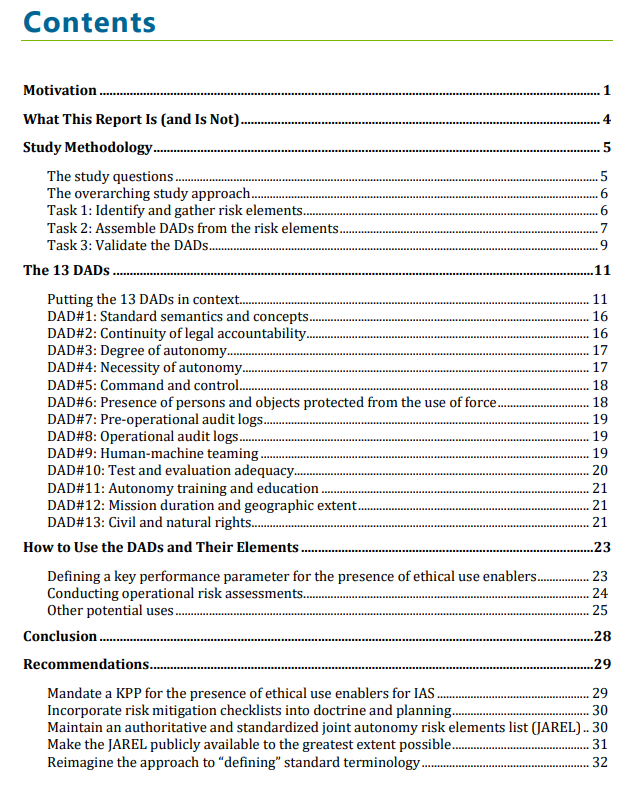

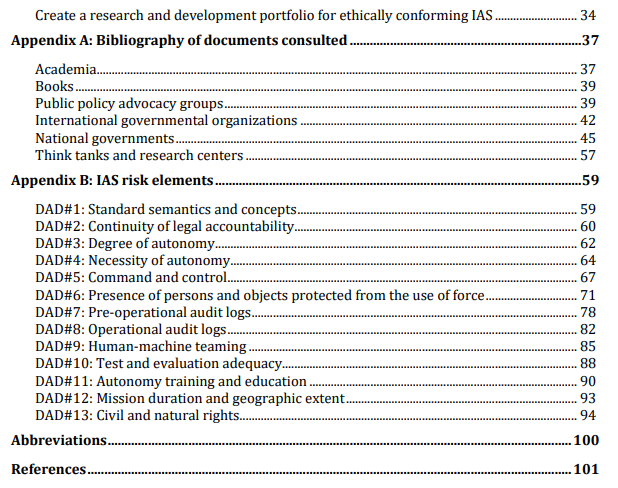

这项研究确定了自主决策的维度(DADs)--在将决策能力转移到智能自主系统(IAS)之前,人们应该考虑的潜在风险类别和原因。这项研究的目的是提供一些执行现有策略所需的工具,涉及法律、道德和军事上有效使用IAS的问题。这些工具有助于识别并减轻或接受与使用IAS有关的可能导致负面结果的风险。这13个确定的DADs是由565个 "风险要素 "组成的综合清单制定的,这些要素来自于支持和反对在武器系统中使用自主技术的各方所撰写的数百份文件。我们将这些要素以问题的形式记录下来,以便采购界在制定确保自主系统的道德使用的需求文件时使用,并由军事指挥官作为风险评估清单,确保自主系统不会以不道德的方式使用。这样,美国防部就可以在开发或部署自主系统之前做出完全知情的风险评估决定。

这项研究确定了自主决策的维度(DADs)--人们在将决策能力转移到智能自主系统(IAS)之前应该考虑的潜在风险类别。这项研究的目的是提供一些执行现有政策所需的工具,涉及法律、道德和军事上有效使用IAS的问题。这些工具有助于识别并减轻或接受与使用IAS有关的可能导致负面结果的风险。

本研究确定的13个DADs是由565个 "风险要素 "组成的综合清单制定的,这些风险要素来自于全球支持和反对在武器系统中使用自主技术的人士撰写的数百份文件。此外,这些风险项目超出了国防部目前的政策和程序,因为我们预计这些政策和程序会发生变化,而且自主技术会不断发展。我们以问题的形式捕捉每个风险要素。然后,每一项都可以很容易地被修改为 "必须声明",供采购界在制定功能要求时使用,以确保合法和道德地使用自主系统。这种方法可以将人工智能(AI)伦理从一套主观定义的、因而无法行动的政策和原则,提升为一套可衡量和可测试的合同义务。

军事指挥官也可以将这些风险要素作为(可衡量和可测试的)行动前风险评估 "清单",以确保自主系统不会以不道德的方式使用。这样,国防部(DOD)在开发或部署自主系统之前就可以做出充分知情的风险评估决定。由于我们的研究结果是专门为在国防采购系统和军事规划过程中使用而设计的,它们为将有关自主系统的政策和道德原则转变为实际的系统工程要求提供了第一步。

我们确定的13个DADs如下。

-

标准语义和概念:确保在自主系统的整个生命周期和不同的用户群体之间使用共同的术语和概念,以防止因沟通不畅而产生的风险。

-

法律责任的连续性:确保人在任何时候都对IAS负有法律责任,在快节奏和动态的军事行动中没有责任的空白。

-

自主程度:确保可以对系统自主程度进行调整,以适应动态的操作条件,并与不断变化的风险容忍度相匹配。

-

自主性的必要性:确保使用智能系统提供的军事优势(包括减少附带损害的概率)与使用该系统带来的任何额外风险相称。

-

指挥和控制:确保采取所有切实可行的措施,防止失去对IAS的指挥和控制,并确保IAS能够检测和防止意外的后果,停用可能从事意外行为的系统。

-

存在不使用武力的人员和物体:确保IAS能够识别并不以违反法律、政策或交战规则的方式故意伤害人员或物体。

-

操作前审计日志:通过记录数据、软件、硬件、人员互动的出处以及从采购前开始到交付给车队的过程,确保在采购期间对IAS的所有方面进行积极控制。

-

操作审计日志:确保记录输入、行动、互动和结果,以便进行操作后的分析,支持法律责任,分享经验教训,并对未来的战术、技术、程序和技术进行改进。

-

人机合作:确保行使人的判断力(特别是在涉及使用武力的时候)。

-

测试和评估的充分性:确保在测试和评估过程中最大限度地体现所考虑的作战环境的深度、广度和复杂性。

-

自主性培训和教育:确保每个与开发和使用IAS有关的人都充分了解其属性,以履行其责任,避免非法和不道德的使用。

-

任务时间和地理范围:确保任务的时间长度和空间范围不会使任务前的风险评估和规划因素失效。

-

公民权利和自然权利:确保人工智能系统在用于致命性自主武器以外的其他用途时,在设计上既能保障公民权利和自然权利,又能识别和减少自主系统中有时出现的偏见。

本研究就如何最好地利用13个DAD及其565个风险要素,积极推动国防部人工智能伦理原则从阐述阶段进入实施阶段,提出了六项建议。

-

将道德使用促进因素的存在作为IAS的强制性关键性能参数:将道德原则转化为可衡量和可测试的合同义务。

-

将国际会计准则风险缓解清单纳入理论和规划:提供必要的理论基础,使国际会计准则相关的风险评估成为长期战略和短期业务规划的强制性组成部分。

-

维护权威性和标准化的联合自主风险要素清单(JAREL):将565个风险要素清单转化为主要工具,以可重复和可调整的方式实施与国际会计准则有关的道德原则。

-

最大限度地公开JAREL:促进公众对国防部使用国际会计准则的信任,提高国防部利用和吸引国际会计准则开发队伍的能力,提高美国吸引盟友和合作伙伴的能力。

-

重新构想 "定义 "标准术语的方法:消除在道德相关政策中使用定义不清或未定义的主观术语所造成的实施障碍,这些术语容易被误解或产生不同的解释。

-

创建一个研发组合:提供能够符合道德规范的国际会计准则的技术。

最后,我们的研究结果支持国防部通过采取透明的方法来实施国防部人工智能伦理原则,对人工智能的道德使用做出承诺。为了证明这种透明度,本研究的发起人同意公开这份报告。这样做可以减少参与战争系统中人工智能开发和使用辩论的许多组织和社区所做的声明和意图的误导、误传和误读。