视频是训练计算机视觉模型的吸引人的数据来源。在线上几乎存在无限量的视频,但是进行详尽的手动标注是不可行的。本论文的目标是通过自监督学习高效地学习强大的视频表示:这是一种从数据中学习而非人类标注的方法。本论文围绕三个主题展开:(1)短期视频的自监督学习,(2)高效的视频表示学习,以及(3)长期视频的自监督学习。对于仅持续几秒钟的短期视频,我们展示了预测未来视频在大规模上是一种强大的学习信号。我们进一步展示,通过采用两种互补的模态,即 RGB 和光流,并使用它们相互教导,可以学习到强大的视频表示。对于高效的视频表示学习,我们展示了大规模预训练的视觉-语言模型可以通过提示调整技术有效地进行调整。我们还展示,丢弃图像块可以加速分类任务的微调和视频-语言模型的预训练。对于持续时间超过几分钟的长期视频,我们展示了时间对齐网络可以通过教学视频中的弱视觉-文本对应关系进行训练。由此产生的网络可以自动清理自然视频,以进行有效的视觉-语言训练。此外,我们还展示了可以通过利用预训练的视觉语言模型来训练电影描述模型。

视频是一种通过比特锁定空间和时间的媒介;它们包含了突出的人类感官信息,如视觉和音频;同时也携带了丰富的关于人类认知的信息,如推理、知识和决策制定,这些反映了人类的智慧。因此,理解视频是实现人工智能的一个重要里程碑。幸运的是,由于先进的网络和存储技术,视频现在被大量地创建和分享在互联网上,并且已经成为一个可以用来训练计算机视觉系统的无限数据源。然而,视频的巨大可用性排除了手动数据标注的可能性,并推动研究人员创建从原始数据本身学习的方法;这种方法被称为“自监督学习”。与从“样本 - 标签”对(例如 [Krizhevsky等,2012])中学习的监督学习不同,自监督学习(SSL)从一个不涉及任何手动定义标签的任务中学习。这个任务通常被称为“代理任务”,它只提供学习信号,而不是学习的最终目标。在从代理任务学习之后,模型生成输入样本的表示。这意味着输入样本被表示为具有有限维度的向量。表示学习的质量通常通过将学到的表示适应到感兴趣的下游任务来评估,如分类、分割和检索。

受到心理学动机的启发,以及受到硬件和实现等其他实际因素的影响,我们在本节介绍一些主导论文并指导方法设计的关键研究思想。

1.1 从海量视频数据中学习

视频是一种非常丰富的视觉数据,例如,每天有超过720,000小时的视频被上传到视频平台YouTube1,一个人需要82年的时间来观看它们。我们对开发能够从海量视频数据中受益的学习方法感兴趣,因为鉴于计算能力和数据处理的快速进步,这些方法在未来具有很高的潜力。因此,本论文的主要关注点是在自然视频上的大规模训练。尽管计算资源有限,但我们在大型视频数据集上探索大规模训练的极限,例如 Kinetics [Kay et al. 2017; João Carreira et al. 2018; João Carreira et al. 2019] 和 HowTo100M [Miech et al. 2019]。在方法设计上,我们从数据本身发现学习信号,这样一旦有额外的计算资源,我们的方法可以轻松扩展。

1.2 从多模态学习 视频自然地包含多种模态,如音频(来自物体和环境的声音,或人声)和文本(视频标题,字幕和观众的评论)。在视觉感官输入中,外观和运动(光流)也可以宽泛地被视为两种模态。根据心理学研究,多种模态通常是冗余的,但彼此互补,即不同的模态代表同一观察的不同方面。对于实际的自监督学习,模态之间的联系可以用作强大的学习信号。在我们的工作中,我们使用运动模态来教导外观模态,反之亦然。我们还依赖视觉和文本模态的共现来学习强大的表示。

1.3 高效学习 高效学习对于实现大规模的自监督学习非常重要,原因有两个。首先,它使具有有限资源访问的社区能够进行SSL研究和应用。其次,它减少了大规模计算造成的能耗和对环境的负面影响 [Strubell et al. 2019]。因此,高效学习是本论文的另一个关键思想。我们主要采用三种策略来追求高效学习:(1)从预训练模型学习以节省不必要的计算成本。(2)减少冗余或噪声学习信号,如连续视频帧中的图像块和无关的视频字幕。(3)通过少量参数来引导大模型,如提示调整。

2. 论文大纲和贡献

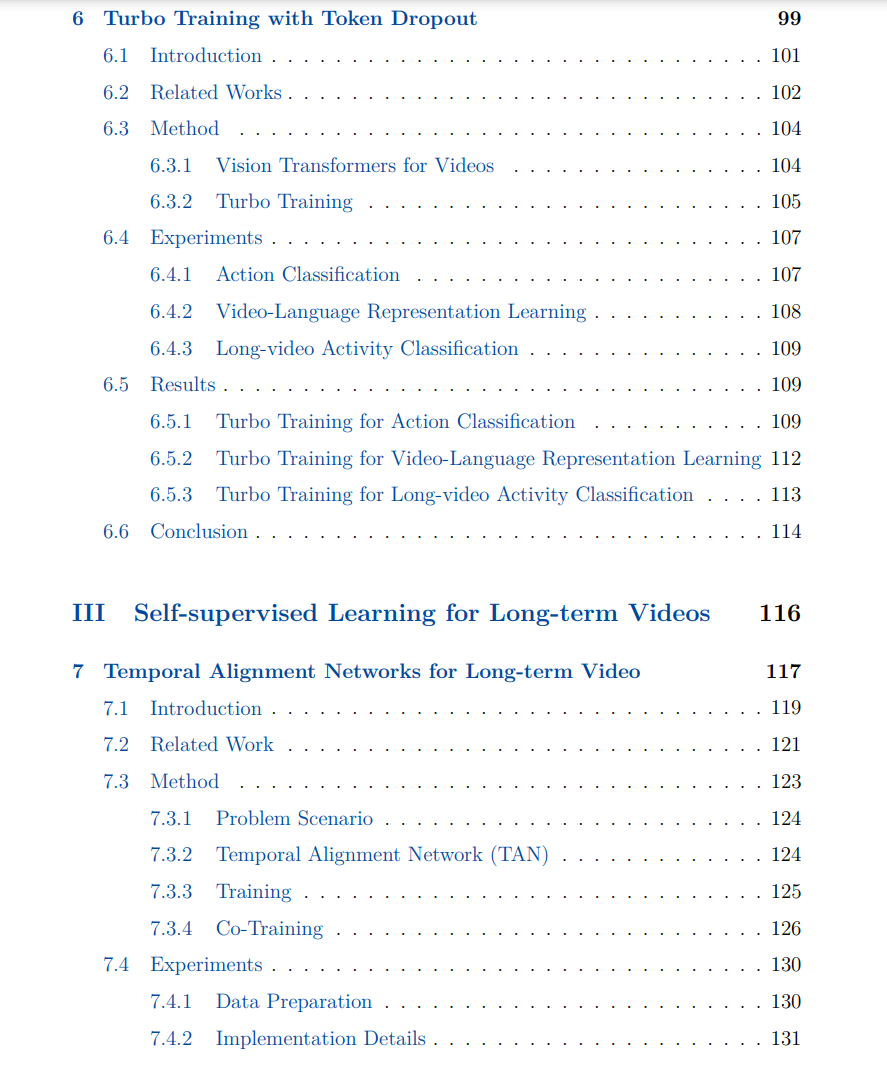

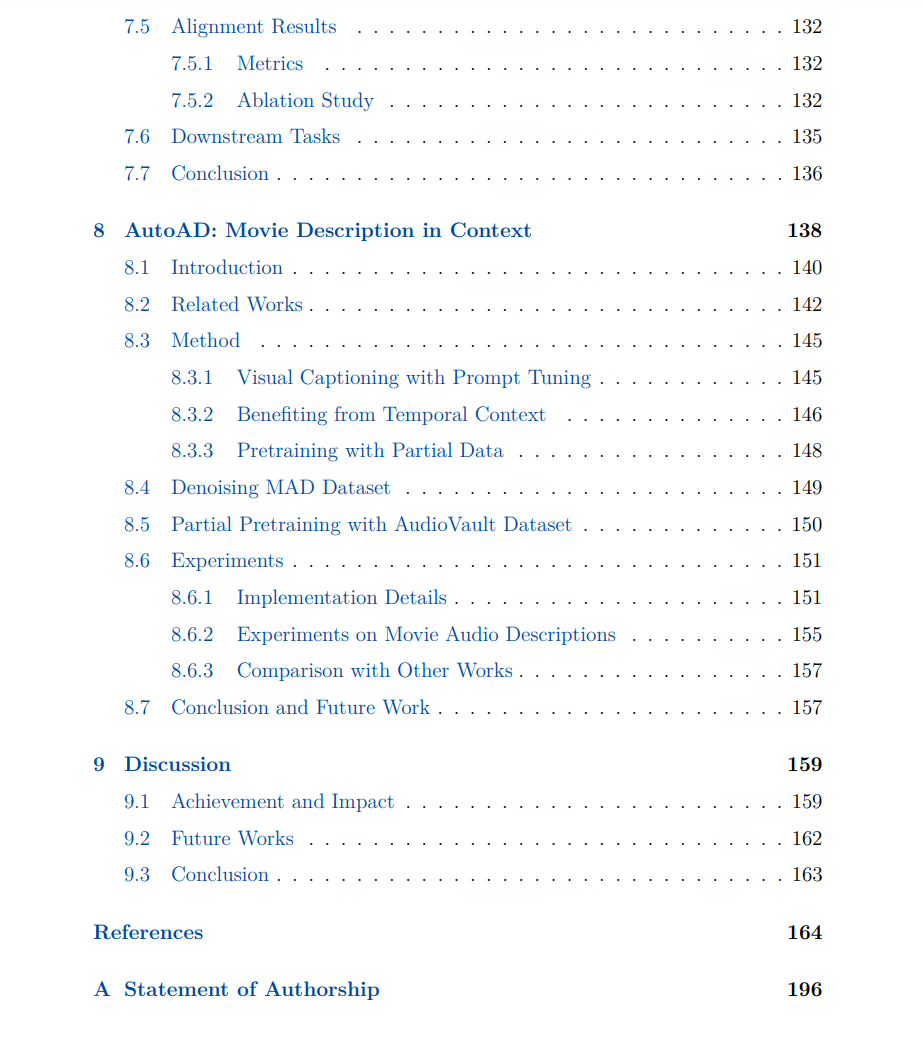

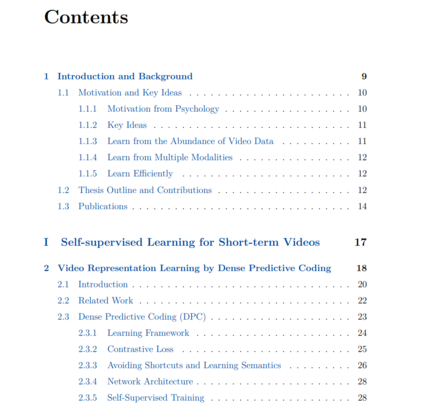

本节提供了后续论文章节的大纲,并总结了关键贡献。论文分为三个主题:短期视频的自监督学习,高效视频表示学习,以及长期视频的自监督学习。

第一部分:短期视频的自监督学习

通过“短期”这个词,我们指的是时长不超过10秒的视频。10秒是一个大致的界限,源于开创性的Kinetics数据集[Kay et al. 2017],其中的视频片段被剪辑到约10秒长。在这有限的时间内,短期视频包含较简单的语义信息,时间上的变化不大,通常只足以涵盖一个动作。在这个主题中,我们展示了通过预测未来和从互补模态中学习可以学到强大的视频表示。特别是在第2章中,我们的动机是预测像素空间是繁重且不必要的,对于学习更高级的语义而言,然后我们提出了一种在特征空间中预测未来视频的方法。通过在时空特征上使用对比损失进行训练,这样的预测模型学习到了一个强大的视频表示,用于动作分类任务。而且,预测未来的视频是一个通用任务,适用于任何视频数据,并且已经证明可以从大数据集训练中受益。然而,我们注意到视频预测中存在多个假设的属性,即鉴于目前的观察,可能发生多个合理的未来。因此,被训练成做出单一预测的模型会收敛到在特征空间中对多个可能的未来预测一个平均值,这限制了学习的进步。为了解决多假设问题,在第3章中,我们通过一个外部记忆库来增强未来预测模块,该记忆库包含可学习的特征向量,以便在结构上支持学习多个未来。在第4章中,利用视频的多模态属性,我们建议使用一种模态的最近邻作为伪标签来训练另一种模态,反之亦然。特别是,我们使用RGB视频流和光流流,我们展示了两种模态的最终表示质量都得到了很大的提高。

第二部分:高效视频表示学习

从第一部分的实践经验中,我们注意到,视频的自监督学习受益于大量数据和长时间的训练计划。然而,考虑到SSL训练的高资源需求和能耗,开发高效学习方法变得至关重要。在这个主题中,我们展示了两种可以降低视频表示学习的训练成本的方法。在第5章中,我们将轻量级的prompttuning方法应用于工业级的预训练视觉语言模型,以使用较小的计算成本实现各种下游视频理解任务,同时保持可比较的性能。在第6章中,我们建议在视觉变换器 [Dosovitskiy et al. 2020] 的视频-语言预训练、视频分类微调和长视频分类任务中丢弃冗余的输入视觉块。这种技术可以加速训练过程,达到最高4倍,并且使那些需要大量资源的训练任务在有限的资源下成为可能。

第三部分:长期视频的自监督学习

在线上的视频数据绝大多数是未剪辑的长视频,时长可能是几分钟或几小时。与第一部分中的短期视频不同,较长的时间轴包含丰富的信息,如复杂活动的程序或电影的故事情节。在这个主题中,展示了两种针对长期视频的方法,一种是从教学视频中学习,另一种是从特色电影中学习。在第7章中,我们利用YouTube上自然教学视频中的弱文本-视觉对应关系,并提出一种方法来自动将演示者的字幕与视频中的视觉内容对齐。因此,我们获得了一个时间对齐网络,它可以通过执行自动文本-视觉对齐来清理自然教学视频。在第8章中,我们关注可能持续几个小时的特色电影。受益于预训练的视觉-语言模型,我们开发了一种方法,沿着时间轴密集地为电影生成音频描述。

相关内容

牛津大学是一所英国研究型大学,也是罗素大学集团、英国“G5超级精英大学”,欧洲顶尖大学科英布拉集团、欧洲研究型大学联盟的核心成员。牛津大学培养了众多社会名人,包括了27位英国首相、60位诺贝尔奖得主以及数十位世界各国的皇室成员和政治领袖。2016年9月,泰晤士高等教育发布了2016-2017年度世界大学排名,其中牛津大学排名第一。