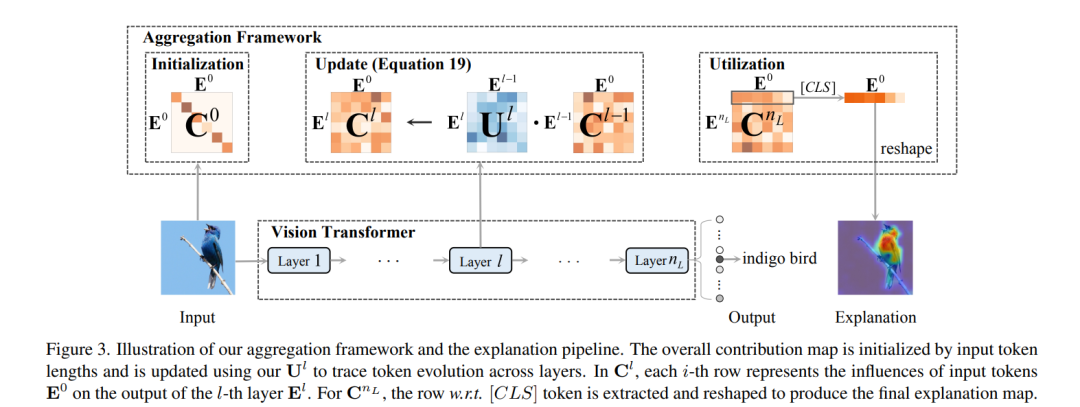

当 Transformers 在各种计算机视觉应用中迅速获得普及时,对它们内部机制的事后(post-hoc)解释大多仍是未探索的领域。视觉 Transformers 通过将图像区域表示为转换后的 tokens 并通过注意力权重(integrating them via attention weights)整合它们来提取视觉信息。然而,现有的事后解释方法仅考虑这些注意力权重,忽略了转换后 tokens 中的关键信息,这无法准确说明模型预测背后的理由。为了将 token 转换的影响纳入解释中,我们提出了一种新颖的事后解释方法 TokenTM,该方法利用我们引入的 token 转换效应的度量。具体来说,我们通过测量 token 长度的变化以及它们在转换前后方向上的相关性来量化 token 转换效应。此外,我们开发了初始化和聚合规则,以整合所有层次上的注意力权重和 token 转换效应,捕捉模型中全面的 token 贡献。在分割和扰动测试上的实验结果显示,我们提出的 TokenTM 方法与最先进的视觉 Transformer 解释方法相比具有优越性。 https://www.zhuanzhi.ai/paper/a67efdc07e9b3bbcefb222b30d45b1df

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日