超过Google,微信AI在NLP领域又获一项世界第一

乾明 发自 G151

量子位 报道 | 公众号 QbitAI

微信AI,NLP领域又获一项世界第一,这次是在机器阅读理解方面。

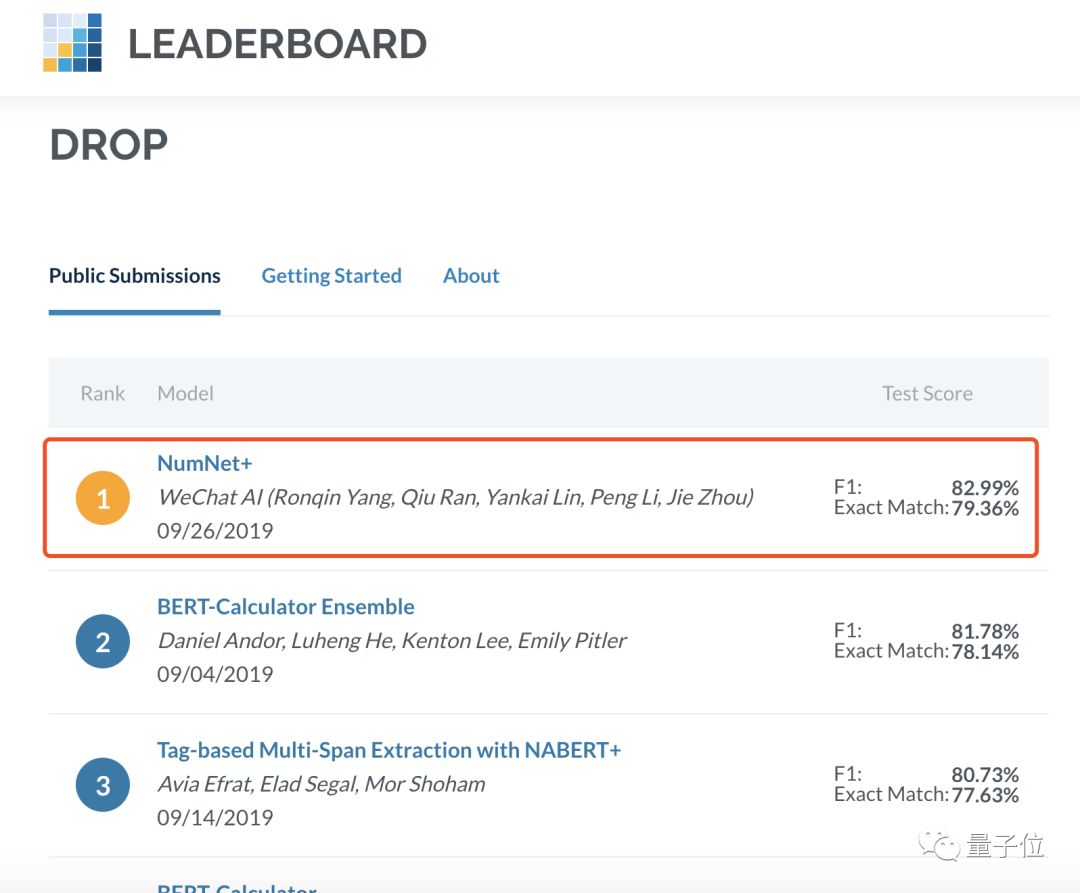

在专门考验计算机数学推理能力的DROP数据集上,微信AI最新方案超过了Google Research,排名第一,成为SOTA。

今年1月,在第七届对话系统技术挑战赛(DSTC7)上,首次亮相的微信智言团队一路过关斩将,最终拿下冠军。

不过这一次,微信AI团队说,这不仅是他们在机器阅读理解方面的进展,也是他们在数学推理方面的第一篇工作。

这一方案,并没有以当前业界主流的BERT为核心,而是以数字感知的图神经网络(NumGNN)方案为基础。

微信AI团队介绍,在NumGNN为核心的情况下,结合NAQANet的基础模块以及改进的前处理方法,在不使用BERT、RoBERTa等预训练模型的条件下,就能获得了高达67.97%的F1值。

在实际提交到榜单上的NumNet+上,他们又进一步融入RoBERTa的能力,并增加了对多span型问题的支持,从而使单模型 F1值能够高达82.99%。

从而,他们也得出了一个结论:

即使不使用BERT等预训练模型,模型的效果也可以比未经定制过的BERT好。

微信AI团队说,这一方案可以帮助人工智能提升阅读理解能力和逻辑推理能力,将来也会将其中的技术应用到腾讯小微智能对话助手中。

不过区别于谷歌和百度等智能语音助手的To C产品形式,目前腾讯小微智能对话助手,主要还是以云服务形式对外输出。

微信成绩意味着什么?AI考数学

先从数据集DROP说起。

DROP数据集,由AI2(Allen Institute for Artificial Intelligence)实验室提出,主要考察的是模型做类似数学运算相关的操作能力。

(小巧合,微信之父张小龙英文名也叫Allen,但allen.ai的域名属于AI2)

与SQuAD数据集中大多都是“刘德华老婆是谁?”的问题不同,其中的问题会涉及到数学运算的情况。

比如说,给我们5个人每个人买2个蛋挞,一共要买几个蛋挞?

这个问题对于人来说很简单,但对于机器来说却很困难。

微信AI团队解释了这背后的原因:机器不仅要能够比较数字相对的大小,还要能够知道和哪些数字做比较并进行推理,这就需要把数字相对的大小等等知识注入模型。

但在之前大多数机器阅读理解模型中,基本上都将数字与非数字单词同等对待,无法获知数字的大小关系,也不能完成诸如计数、加减法等数学运算。

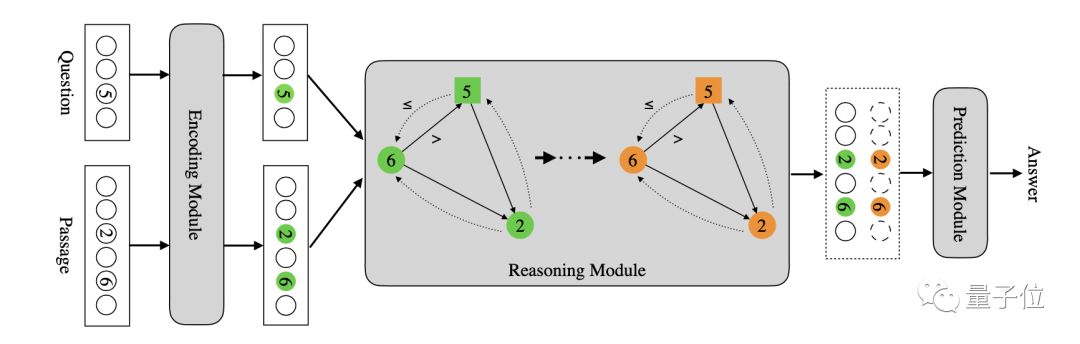

正是基于这一原因,微信AI团队提出了一种数字感知的图神经网络(numerically-aware graph neural network,NumGNN),并基于此提出了NumNet。

一方面利用图的拓扑结构编码数字间的大小关系,将文章和问题中的数字作为图结点,在具有“>”和“<=”关系的数字间建立有向边,从而将数字的大小关系作为先验知识注入模型。

具体来讲,给定一个问题和一段文本,先把问题里面的数字和文本里面的数字都抽出来。

每个数字就是图上一个节点,同时对于任意两个数字,假如A数字和B数字,如果A大于B的话,那么A和B中间加一条有向边,表示数字A和B之间是A大于B的关系。

如果A小于等于B,则会加另外一种有向边,把它们两个连接起来。通过这种操作,用图的拓谱结构把数字相对大小知识注入模型。

另一方面,是结合文本信息去做更复杂的数学推理,具体的实现方式是使用图卷积神经网络在前述图结构上执行推理,从而支持更复杂的数学推理功能。

超过Google方案,斩获全球第一

在DROP数据集的LEADERBOARD上,微信AI团队的方案为NumNet+。

微信AI团队介绍称,这一方案的基础与NumNet一样,都是NumGNN。

在新的方案中,用预训练模型替换了NumNet中的未经过预训练的Transformer作为encoder,进一步融入了RoBERTa的能力以及对多span型问题的支持。

从而实现了单模型 F1值 82.99%的效果,一举超过Google Research的BERT-Calculator Ensemble方案,成为榜单第一。

尽管取得的效果还不错,但在微信AI团队来看,但还有很多缺陷。

比如说,目前能够支持的数学表达式种类还是受到一定限制。尤其是DROP数据集的局限,其对文本理解的要求更高,但需要的数学推理难度比解数学应用题那类问题来得相对简单一点。

微信AI团队说,如何把两者更好的结合起来,使得整个模型的能力进一步的提升,是他们下一步考虑的问题。

而且,他们也说,并不会把注意力集中在用GNN来解决数字推理的问题上,后面也会重点去考虑其他的方式。

更具体来说,是能够将arithmetic word problems (AWPs)相关工作中处理复杂数学表达式相关的方法能够进行吸收融合,进一步提升模型的推理能力。

更多详情,可以前往DROP数据集LEADERBOARD:

https://leaderboard.allenai.org/drop/submissions/public

而微信AI这次的研究成果,已经被EMNLP2019收录,论文也已公开发表:

NumNet: Machine Reading Comprehension with Numerical Reasoning

https://arxiv.org/abs/1910.06701

项目地址:

https://github.com/llamazing/numnet_plus

— 完 —

活动推荐 | 科大讯飞1024开发者节

10月24日-26日,一场开发者的盛会。

120+国内外专家学者,20+场高峰论坛;10000平米AI黑科技互动展区,更有AI公益音乐节、AI公益健康跑助力!

扫码可获取量子位专属福利,进入原价1024元的【免费票】通道。

喜欢就点「好看」吧 !