AAAI 2020 | 通过解纠缠模型探测语义和语法的大脑表征机制

由于大脑语言处理过程十分复杂,传统认知神经科学使用人工设计的语料来收集神经影像数据进而研究这个问题。由于人工设计的语料脱离了人类通常的语言理解环境,结论无法泛化到实际语言场景中,另外受控刺激会引入语言理解之外的因素,因而无法得出人脑在自然语言理解情况下语义和语法表征的结论。

为了解决上述问题,我们提出了一种利用解纠缠的计算模型特征研究人脑对应表征的框架,可以适用于任何自然语言刺激实验中。针对大脑语义和语法表征的问题,我们利用计算模型将句子中的语义和语法特征区分开,使用分离的语义和语法特征来研究大脑对应的神经基础。

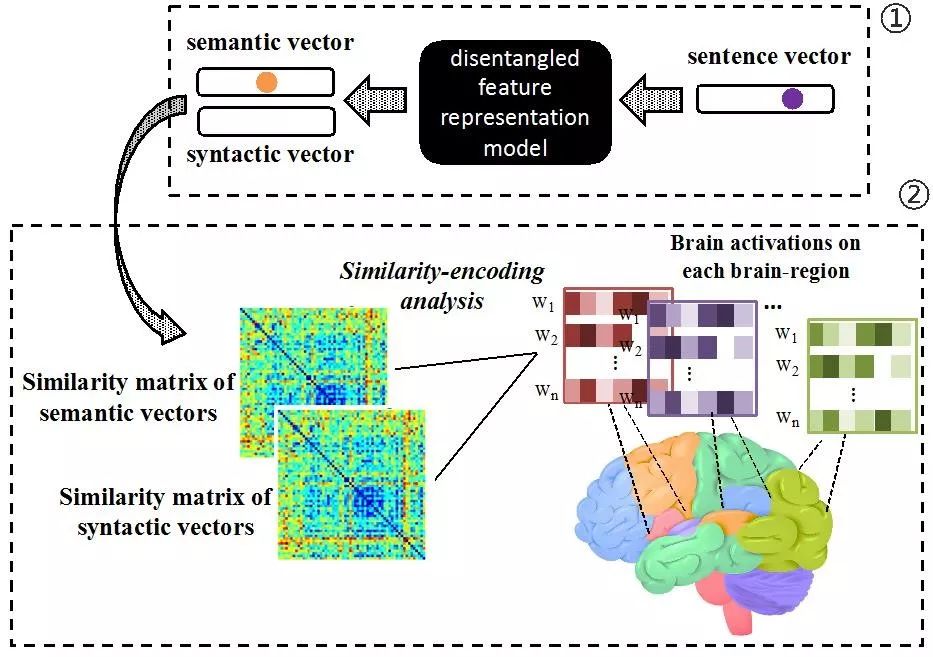

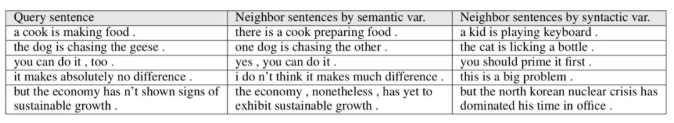

图1基于解纠缠特征的人脑表征研究的计算框架

论文方法

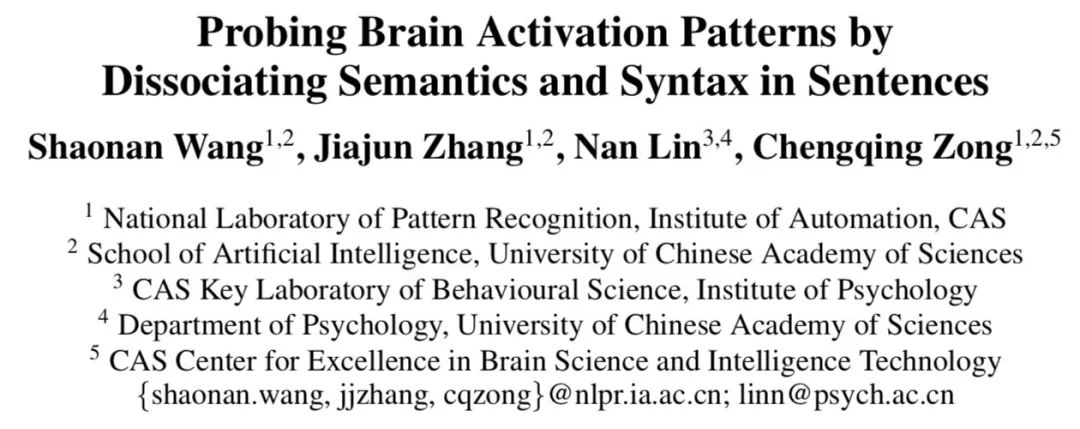

针对上述问题,中科院自动化所自然语言处理组王少楠助理研究员、张家俊研究员、宗成庆研究员和中科院心理所林楠副研究员合作提出了一种利用解纠缠的计算模型特征研究人脑对应表征的框架,用于研究人脑对应语义和语法的表征。

如图1所示,该框架分为两个部分,首先构造解纠缠的特征表示模型,接着用分离的特征表示向量在大脑激活数据中寻找对应特征最相关的脑区。具体来说,我们提出一种解纠缠的特征表示模型(DFRM)。如图2所示,该模型属于双通道的变分自编码器,利用两个隐含变量分别表示语义特征变量和语法特征变量。具体使用词向量平均编码器来抽取句子中的语义特征,利用长短时记忆网络(LSTM)来抽取句子中的语法特征,接着通过令语义变量学习区分两个句子是否含义相同,令语法变量学习区分两个句子是否语法相同的目标函数,使语义变量积累语义信息,语法变量积累语法信息。

该模型通过上述目标函数以及变分自编码器的重构误差学习语义和语法变量的分布形式,最终该模型可以用语义变量为每个句子生成语义向量,用语法变量为每个句子生成语法向量。

图 2 解纠缠特征表示模型

利用上述语义向量和语法向量,通过神经编码技术,我们可以研究大脑对应的语义和语法表征。具体来说,通过上述计算模型可以得到每个句子的语义向量和语法向量,利用所有句子中每两个句子求余弦相似性可以得到句子之间的语义相似度矩阵和语法相似度矩阵。同样的,对于大脑来说,每个脑区对每个句子都有一系列激活数值,对每两个句子间的激活向量求余弦相似性可以得到每个脑区的句子理解相似度矩阵。最后利用计算模型得到的语义相似性矩阵和语法相似性矩阵分别与每个脑区的相似性矩阵做相关性分析,即可以得到与语义最相关的脑区和与语法最相关的脑区。

实验结果

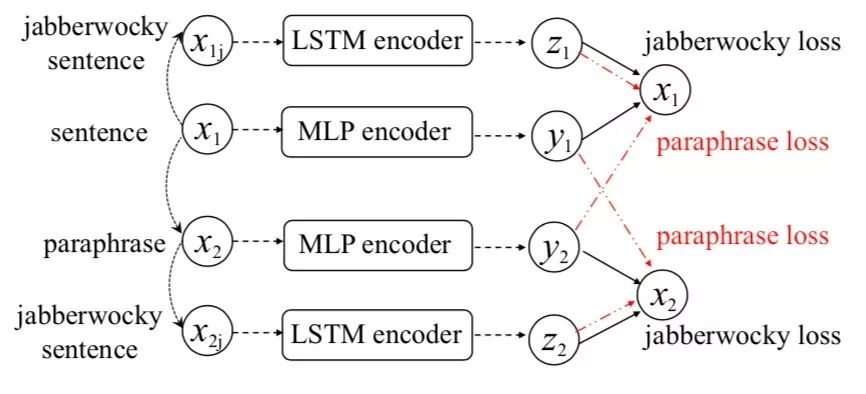

表1给出了不同模型在语义和语法任务上的不同表现。实验结果表明,我们提出的解纠缠特征表示模型(DFRM)可以最大限度的区分句子中语义和语法信息,在语义和语法相似性数据集上取得了最好的结果。

表1不同模型在多个语言对上的实验结果

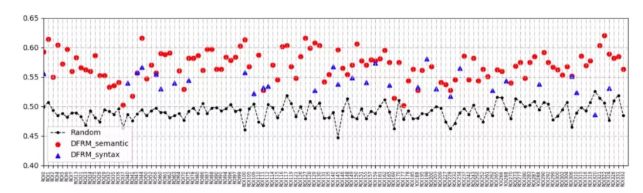

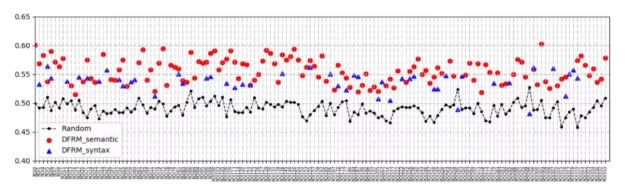

如图3和图4所示,将上述语义和语法向量应用于两个fMRI句子理解数据集上,我们发现语义表征比语法表征在大脑中各个区域的激活更加稳定,包括默认网络(default-model network),额顶叶(frontoparietal),视觉网络(visual networks)等。语义和语法的大脑表征在很大程度上重叠,也有少数脑区仅对一个脑区敏感。例如,部分额叶(frontal)和颞叶(temporal)区域是语义特征所特有的。部分右上额叶(right superior frontal)和右下顶叶(rightinferior parietal)区域是语法特有的。

图3 语义语法向量与大脑fMRI数据的相似性编码分析结果(数据集1)

图4 语义语法向量与大脑fMRI数据的相似性编码分析结果(数据集2)

这项工作的主要贡献在于:

提出了一种利用计算模型研究大脑中不同语言属性如何表征的框架。除了研究人脑语义语法的表征之外,也可以用来研究语言中的其他属性如视觉、语音和情绪等。

提出一种解纠缠的特征表示模型,可以在一定程度上分离句子中的语义和语法信息,为每个句子生成一个语义向量和一个语法向量。

实验结果从计算的角度为大脑语义和语法表征机制提供了新的证据,证实并扩展了已有认知神经科学的发现,表明了利用自然语言处理模型可以帮助我们研究脑大脑语言理解机理。

相关细节可参考发表于人工智能顶级学术会议AAAI 2020的论文:

Shaonan Wang, JiajunZhang, Nan Lin and Chengqing Zong. Probing Brain Activation Patterns byDissociating Semantics and Syntax in Sentences. The Thirdy-Fourth AAAIConference on Artificial Intelligence, Feb. 7-12, 2020, New York, USA.

AAAI 2020 | 这 10 篇论文值得你了解(附PPT下载)

AAAI 2020 论文解读系列:

AI 科技评论希望能够招聘 科技编辑/记者 一名

办公地点:北京

职务:以参与学术顶会报道、人物专访为主

工作内容:

1、参加各种人工智能学术会议,并做会议内容报道;

2、采访人工智能领域学者或研发人员;

3、关注学术领域热点事件,并及时跟踪报道。

要求:

1、热爱人工智能学术研究内容,擅长与学者或企业工程人员打交道;

2、有一定的理工科背景,对人工智能技术有所了解者更佳;

3、英语能力强(工作内容涉及大量英文资料);

4、学习能力强,对人工智能前沿技术有一定的了解,并能够逐渐形成自己的观点。

感兴趣者,可将简历发送到邮箱:jiawei@leiphone.com