漫画解读ERNIE:能和BERT一较高下的知识增强语义表示模型

————— 五分钟后 —————

ERNIE 是百度开源深度学习平台飞桨(PaddlePaddle)推出的知识增强语义表示模型,通过海量数据建模词、实体及实体关系。相较于 BERT 学习原始语言信号,ERNIE 直接对先验语义知识单元进行建模,增强了模型语义表示能力。简单来说,ERNIE 采用的 Masked Language Model 是一种带有先验知识 Mask 机制。

除此之外,ERNIE 采用多源训练数据,利用高性能分布式深度学习平台飞桨完成预训练。

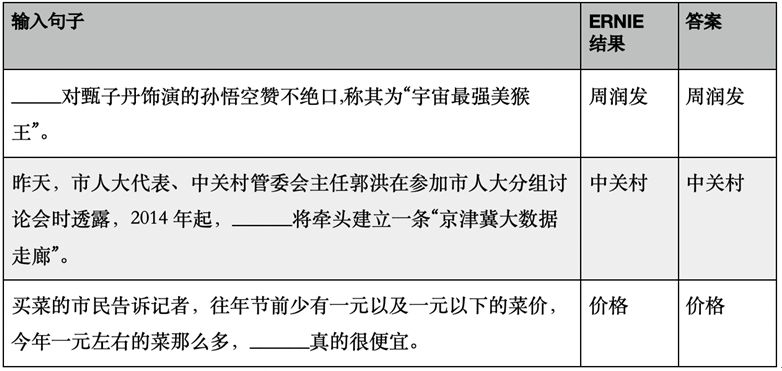

ERNIE 经过 1500 万篇文章,700 万对话的训练,尤其在语言推断、语义相似度、命名实体识别、情感分析、问答匹配等自然语言处理(NLP)各类中文任务上都有不俗的表现。下面我们一起来看看 ERNIE 的应用效果:

完型填空

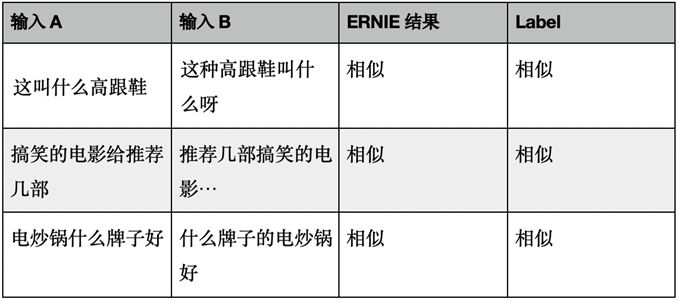

相似度

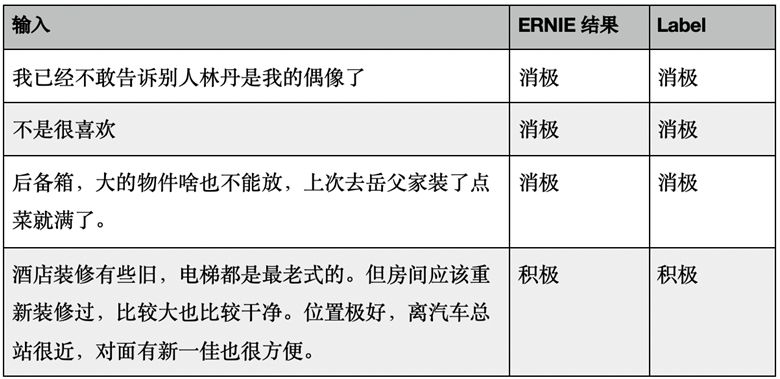

情感分类

了解ERNIE更多信息,点击阅读原文或查看以下链接:

http://github.com/PaddlePaddle/LARK/tree/develop/ERNIE

长按识别下方二维码

免费申请Tesla V100算力卡

配合PaddleHub让模型原地起飞

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 了解ERNIE

登录查看更多