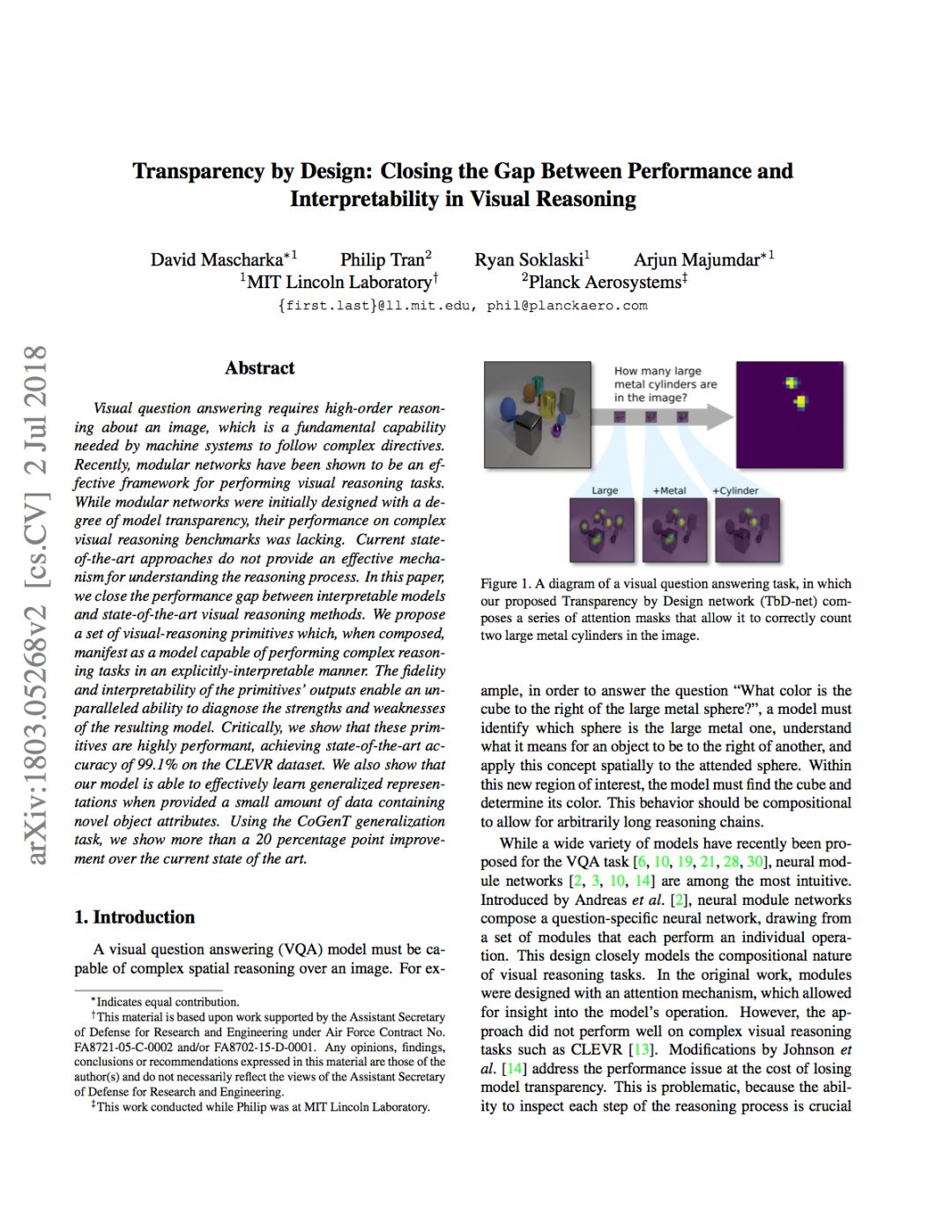

MIT:AI 如同人类的推理机制来解决问题(附论文)

麻省理工学院(MIT)林肯实验室智能和决策技术小组开发的模型为理解神经网络如何做出决策设立了新标准。

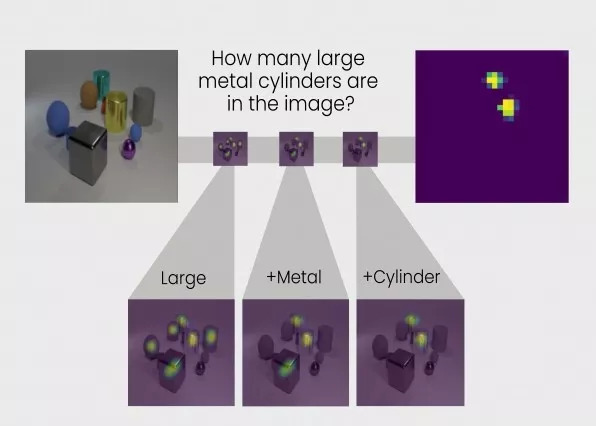

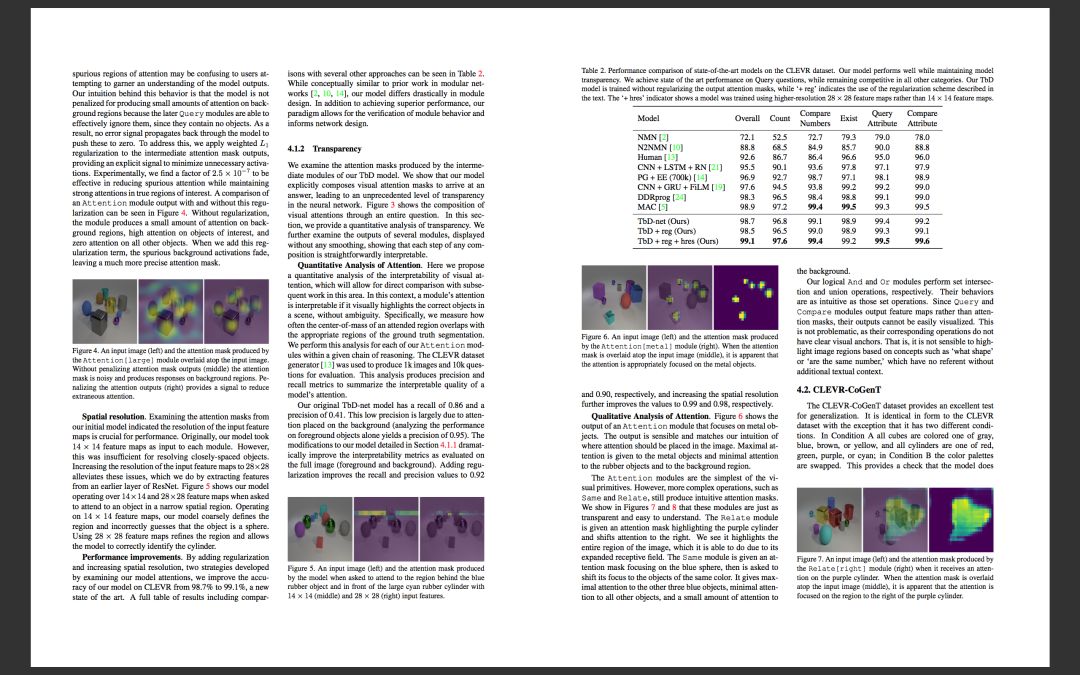

图1:TbD-net解决视觉推理问题的方法是,将问题分成一系列子任务。每个子任务的答案/结果在显示相关物体的热图中显示,这样分析员就能看到网络的推理过程。

有人给女孩看了一张图片,上面有各种形状,让她找到红色的大圆圈。为了找到答案,她经历了几个推理步骤:先找到所有大的物体,接着找到红色的物体;最后,挑出是圆形的红色大物体。

我们通过推理来学习如何解释这个世界,神经网络也是如此。现在,麻省理工学院林肯实验室智能和决策技术小组的一组研究人员开发出了一个神经网络,它可以执行如同人类的推理步骤,以回答关于图像内容的问题。该模型名为“透明设计网络”(TbD-net),它在解决问题时可视化呈现推理过程,让人类分析员得以解释其决策过程。该模型的表现胜过如今最好的视觉推理神经网络。

了解神经网络如何做出决策一直是AI研究人员长期以来面临的挑战。正如其名称中的“神经”这部分表明的那样,神经网络是受大脑启发的AI系统,旨在复制人类学习的方式。它们由输入层和输出层以及介于两者之间负责将输入转换成正确输出的层组成。一些深度神经网络已变得如此复杂,以至于几乎不可能解释这个转换过程。这就是为什么深度神经网络被称为“黑盒子”系统,即使对制造它们的工程师来说,具体的内部机理也是不透明的。

借助TbD-net,开发人员旨在使这样的内部机理透明化。透明之所以很重要,是由于这让人类得以解释AI的结果。

比如说,知道自动驾驶汽车中所使用的神经网络认为行人和停车标志到底有什么差异、它在推理过程的哪个环节上明白这种差异很重要。如果研究人员搞清楚了这些,就可以教神经网络纠正任何不正确的假设。不过TbD-net的开发人员表示,如今最好的神经网络缺乏一种有效的机制让人类能够理解神经网络的推理过程。

Ryan Soklaski和另外几名研究员Arjun Majumdar、David Mascharka和Philip Tran一同建成了TbD-net,他说:“提高视觉推理的性能这方面取得了进展,不过以牺牲可解释性为代价。”

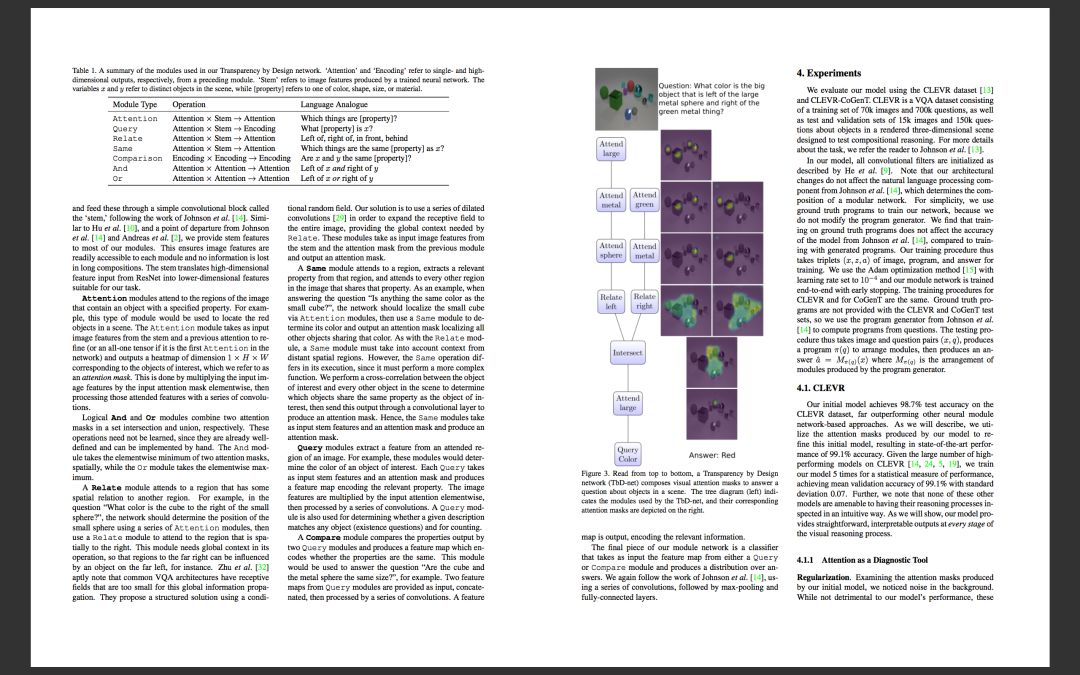

林肯实验室的研究小组借助TbD-net,缩小了性能与可解释性之间的差距。他们开发的系统的一个关键是“模块”集合,而模块是一种小型神经网络,专门用于执行特定的子任务。TbD-net被问到关于图像的视觉推理问题时,它将问题先分解成多个子任务,并分配适当的模块以完成各自的子任务。就像装配线上的工人一样,每个模块建立在前一个模块搞清楚结果的基础上,最后得出最终的正确答案。总体上来说,TbD-net使用了解释人类语言问题后将那些句子分解成子任务的AI技术,还使用了解释图像的多种计算机视觉AI技术。

Majumdar说:“将一系列复杂的推理分解成一系列较小的子问题,每个子问题都可以独立解决并组合,这是一种强大而直观的推理手段。”

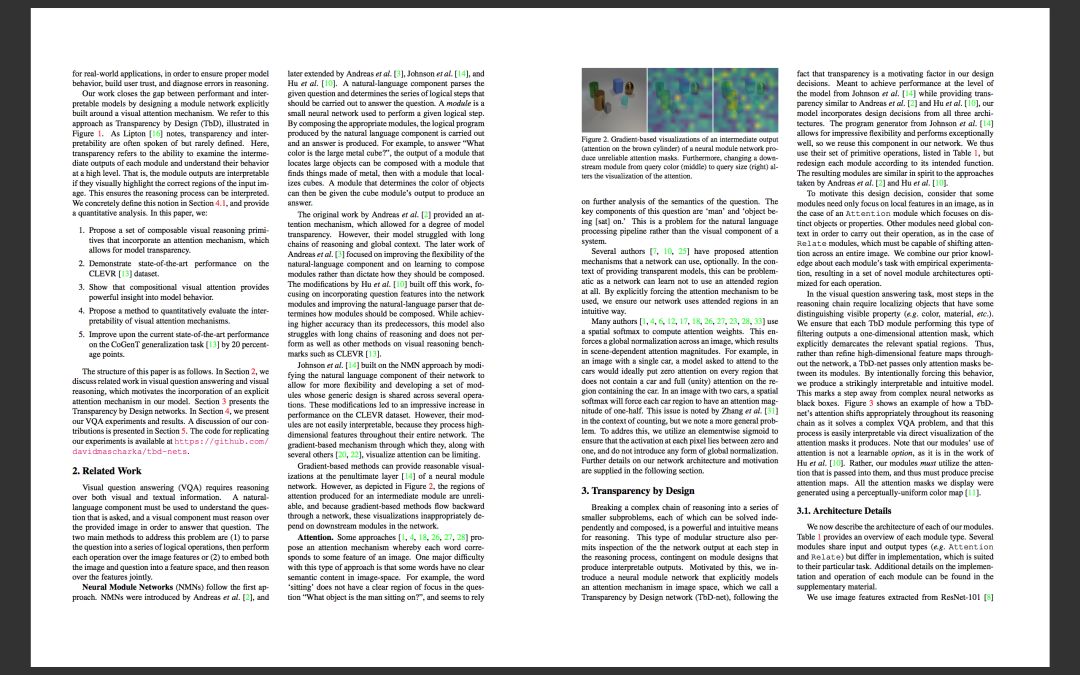

每个模块的输出用该研究小组所说的“注意力掩码”(attention mask)来可视化描述。注意力掩码显示图像中模块认为是正确答案的物体上方的热图blob。这种可视化使人类分析员能够看到模块如何解释图像。

举例来说,对TbD-net提出以下问题:“在这个图像中,那个大大的金属立方体是什么颜色?”为了回答这个问题,第一个模块只负责找到大物体,生成那些大物体高亮显示的注意力掩码。下一个模块获得该输出后,从被上一个模块认为个头大的那些物体中找出又是金属的。该模块的输出被发送到下一个模块,这个模块在那些很大的金属物体中找出哪些又是立方体。最后,这个输出被发送到可以确定物体颜色的模块。TbD-net的最终输出是“红色”,这是问题的正确答案。

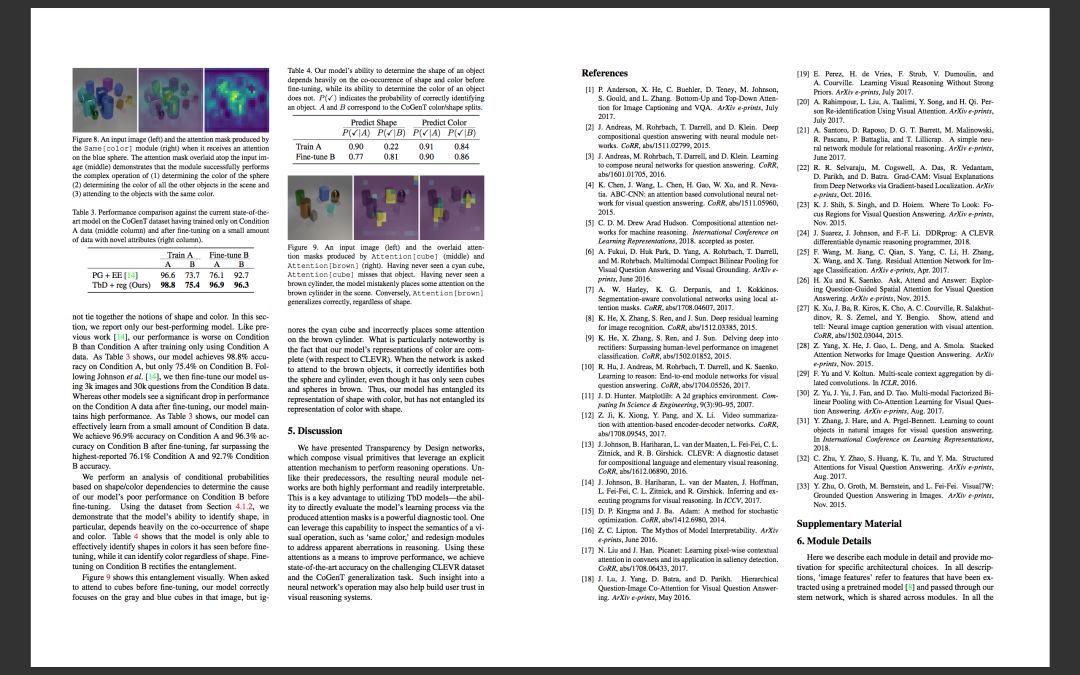

测试时发现,TbD-net取得的成绩超过了性能最佳的视觉推理模型。研究人员使用一个视觉问答数据集评估了该模型,该数据集包括70000个训练图像和700000个问题,还使用了包括15000个图像和150000个问题的测试集和验证集。初始模型用该数据集获得了98.7%的测试准确度,据研究人员声称,这远高于其他基于神经模块网络的方法。

重要的是,由于模块具有透明化这个重要优势,研究人员之后可以改进这些结果。只要查看模块生成的注意力掩码,他们可以看到哪个环节出了问题,并改进模型。最终结果是取得了准确度高达99.1%的超高性能。

Mascharka说:“我们的模型在视觉推理过程的每个阶段都提供了直观的、易于解释的输出。”

如果部署深度学习算法以帮助人类处理复杂的实际任务,可解释性来得尤为重要。为了确保这种系统具有可信性,用户需要能够检查推理过程,那样他们才能够理解模型为何做出错误的预测、如何做出错误的预测。

智能和决策技术小组的负责人Paul Metzger表示:“林肯实验室致力于成为应用机器学习研究和AI的世界领导者,以促进人机协作”,这项工作是其中的一部分。

这项研究成果的细节在今年夏天召开的计算机视觉和模式识别大会(CVPR)上发表的论文《透明设计:缩小视觉推理的性能与可解释性之间的差距》(https://arxiv.org/pdf/1803.05268.pdf)中进行了描述。

论文全文: