每日论文 | 无注意力翻译模型;可微分的模型预测控制;解决复杂图形中的最短距离问题

You May Not Need Attention

在神经机器翻译中,如果没有注意力并且将编码解码分离,我们能得到怎样的结果?为了回答这一问题,我们提出了一种循环神经翻译模型,不用注意力,也没有分离的编码器和解码器。这种模型延迟率低,在读取第一个源token时,就会立刻写出目标token,并且在解码时可以使用即时记忆。翻译性能与Bahdanau等人的注意力模型相当。

地址:https://arxiv.org/abs/1810.13409

Differentiable MPC for End-to-end Planning and Control

在这篇论文中,我们提出用模型预测控制(MPC)作为一种连续状态和动作空间中强化学习的可微分策略类别。这就提供了一种方法,可以使用和结合有模型和无模型两种方法。由此,我们可以通过端到端学习了解控制器的成本和动态。

地址:https://arxiv.org/abs/1810.13400

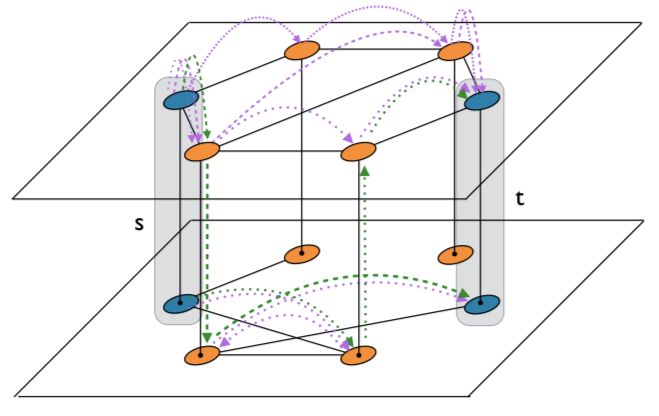

Effect of shortest path multiplicity on congestion of multiplex networks

最短距离是图形中具有代表性的距离测量问题,在很多网络中都有出现。在复杂网络中,这种距离计算对图层的计算是很重要的,在堵车情况发生时,解决了最短距离可以有效提高交通效率。在这篇文章中,我们提出了一种数学方法,用来计算距离的共同分布,以及复杂网络中最短距离的多样性,研究它们在堵车过程中的关系。

地址:https://arxiv.org/abs/1810.12961

星标论智,每天获取最新资讯

登录查看更多

相关内容

专知会员服务

97+阅读 · 2020年2月3日

专知会员服务

34+阅读 · 2020年1月15日

专知会员服务

37+阅读 · 2020年1月12日

Arxiv

8+阅读 · 2020年4月14日

Arxiv

3+阅读 · 2019年7月8日

Arxiv

3+阅读 · 2018年4月8日

Arxiv

3+阅读 · 2018年3月4日