【泡泡图灵智库】用于多相机匹配的时空二进制特征

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Multi-camera Matching of Spatio-Temporal Binary Features

作者:Alessio Xompero, Oswald Lanz, Andrea Cavallaro

来源:Proc. of Int. Conf. on Information Fusion (FUSION) 2018

播音员:

编译:李建华

审核:张国强

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——

用于多相机匹配的时空二进制特征,该文章发表于FUSION 2018。

图像的局部特征通常对于平面表面上或窄基线视图下的几何和光度变换鲁棒。但是在相机位姿未知、基线较宽的场景下,匹配性能会显著下降。为了解决这个问题,我们通过跟踪局部二进制特征来积累每个视图内的时域信息,这些特征编码了图像块中像素对的强度比较信息。然后,我们通过选择在时间上占优势的二进制值将时空特征编码为固定长度的二进制描述子。在上述描述子的基础上,我们补充了一个二进制向量,用于识别在时间上不稳定的强度比较。最后,当匹配不同相机得到的图像特征,我们使用此附加向量来忽略固定长度二进制描述子中的相应的二进制值。我们分析了本文方法的性能,并与基准算法进行了比较。

主要贡献

提出了一种针对多相机,大视角变化图像匹配任务的局部特征二进制描述方法。

算法流程

1、 特征提取与定位

1.1利用FAST角点提取算法提取序列图像的角点位置

1.2在每个角点位置附近区域利用高斯滤波平滑处理,根据ORB采样模式,提取特征描述子,每个描述子有256个值,由像素对的灰度大小情况决定。

1.3为了考虑旋转,提取了图像的角度信息。这样特征描述子包括位置、角度、ORB描述子。

2、特征跟踪与压缩

2.1跟踪图像序列,对每个序列提取特征描述子,对相邻图像的描述子进行距离计算,找出距离最近的特征,实现一一匹配。

2.2特征压缩:匹配后的特征描述子组合起来,维度较大:每个特征,有位置序列,共Li个序列;每个位置,有256个数据,这样每个位置有Li×256维数据。把这个数据压缩,根据每列(相同位置,不同序列)出现1的比例,比例大于50%,该列为1,否则为0,这样把数据压缩为1×256维(一个特征点的数据)。

2.3特征稳定性描述子。考虑到噪声,对每个特征,计算相邻图像序列的特征描述子的变化,这样可以得到(Li-1)×256维数据,同样,根据每列出现1的比例,当比例小于20%(变化较少),该列为1,否则为0,这样数据压缩为1×256维。这个值是描述特征稳定性的。

3、跨视角特征匹配

根据特征稳定性,以及特征描述子,采用加权汉明距离计算公式,进行不同相机图像特征的匹配。

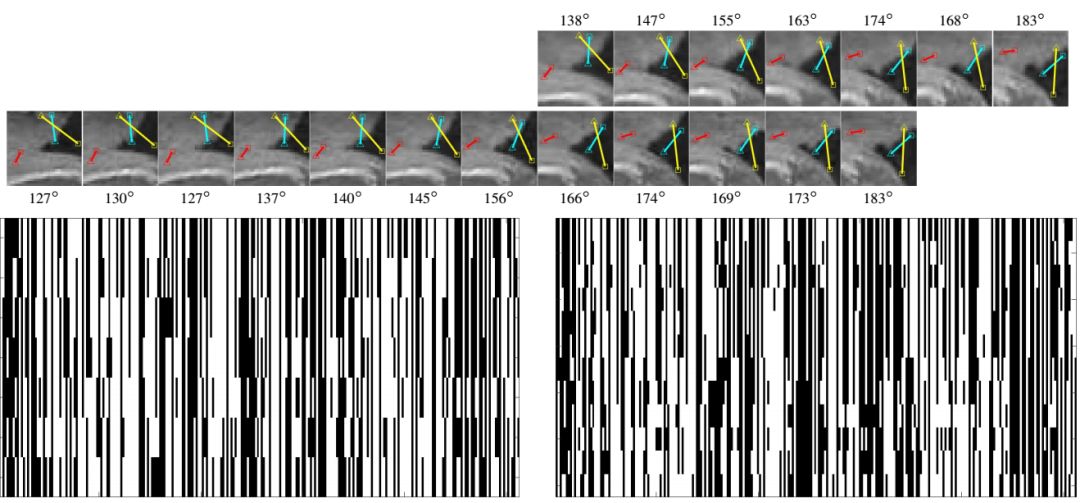

图1. ORB描述子示意图。第一行是第一个相机的图像块跟踪序列。第二行是另一个相机在不同视角下的图像块跟踪序列,图中有采样块的角度信息和ORG采样线(红色、黄色、青色)。不同相机、相同特征的跟踪序列起止帧数不同。第三行左侧是相机1提取的ORB描述子,纵向是时间(14帧),可以看到特征描述子很稳定(保持黑1颜色不变),右侧是相机2的描述子。黑代表0,白代表1。

主要结果

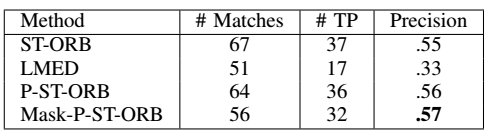

比较了ST-ORB、P-ST-ORB、Mask-P-ST-ORB、LMED四种描述子的性能。

ST-ORB:高维度的特征描述子,在时间维度把描述子组合起来。

P-ST-ORB:压缩后的描述子

Mask-P-ST-ORB:在P-ST-ORB的基础上增加了特征稳定性描述子。

LMED:ORB-SLAM中使用的描述子

1、仿真配置:

ORB描述子采用OpenCV3.3提取,默认参数,FAST阈值20%,每幅图的特征数500,采样块31×31。

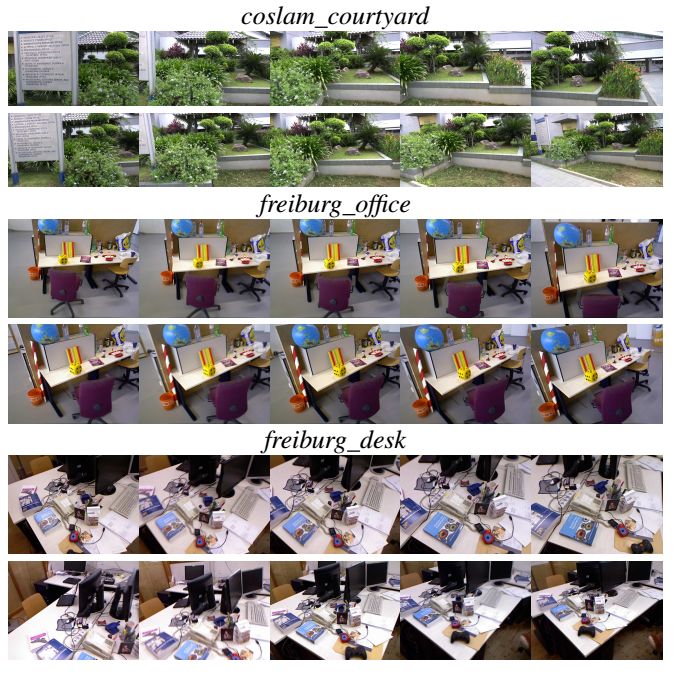

图2、数据库示意图,两行图像由两个相机从不同视角拍摄得到。

2、数据库:coslam courtyard,freiburg office and freiburg desk.

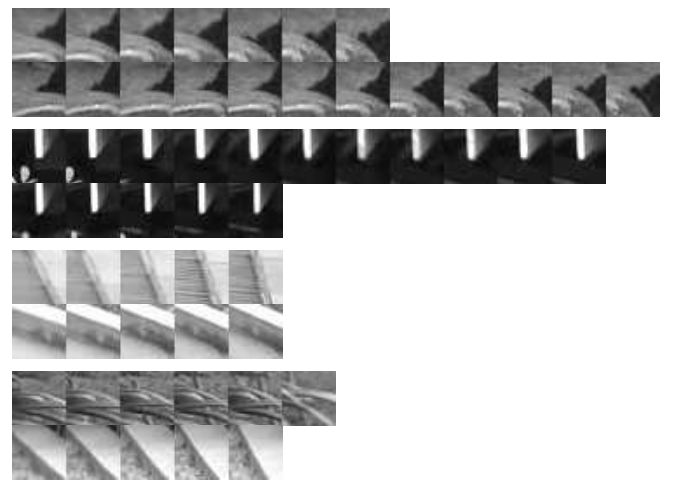

图3 正确匹配及错误匹配示例(汉明距离小于50)。其中前2组图像为正确匹配,后两组匹配错误,第三组的汉明距离为38,最后一组汉明距离为46。每行对应一个特征,但跟踪帧数不同

3、仿真结果如下图所示。

图4、在coslam courtyard数据集上的匹配精度比较,TP表示True Positive

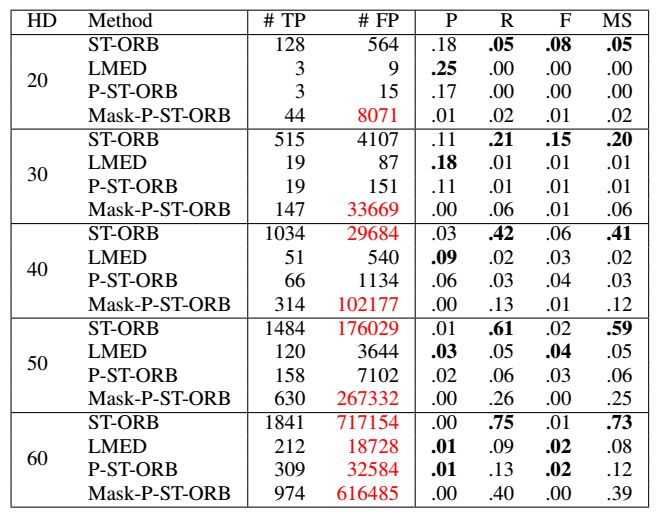

图5、在freiburg office数据集的结果,HD表示汉明距离阈值,FP表示False Positive(错误匹配)。相机1的特征点轨迹(tracklet)数为2516个,相机2的为3308个,两个相机特征匹配数真值为2447。红色数字表示错误匹配数太高了,区分度不够。P表示精度,即正确匹配数/总匹配数=TP/(TP+FP),R为召回率,F=2(P×R)/(P+R),为精度和召回率的调谐均值,MS表示匹配分数 = TP / min(tracklet1,tracklet2)

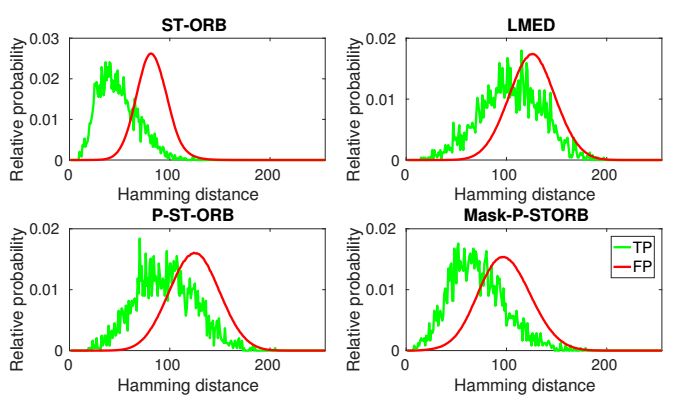

图6、不同描述子的汉明距离与匹配情况概率分布情况。上述曲线说明正确匹配和错误匹配不容易区分开,这是由于生成上述曲线的场景本身有重复图案,区分难度很大。

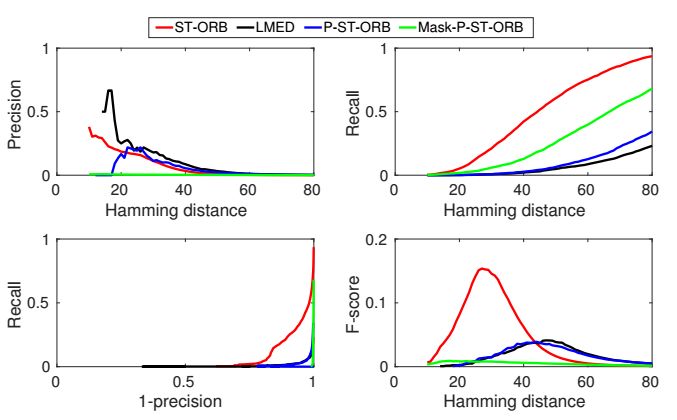

图7、 不同描述子性能与汉明距离阈值关系图,可以看到ST-ORB性能总体最优。

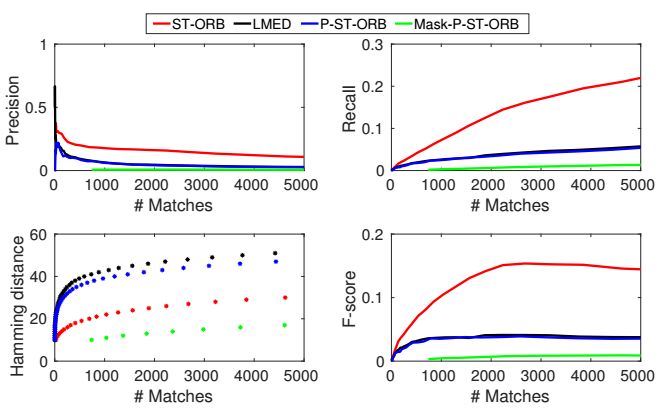

图8、不同描述子性能与特征匹配数关系图。

总结:仿真表明,本文提出的描述子总体性能优于ORB-SLAM中的LEMD,后续工作将重点考虑维度压缩方法,既能考虑视角变化,还可以保证匹配效率。

Abstract

Local image features are generally robust to different geometric and photometric transformations on planar surfaces or under narrow baseline views. However, the matching performance decreases considerably across cameras with unknown poses separated by a wide baseline. To address this problem, we accumulate temporal information within each view by tracking local binary features, which encode intensity comparisons of pixel pairs in an image patch. We then encode the spatio-temporal features into fixed-length binary descriptors by selecting temporally dominant binary values. We complement the descriptor with a binary vector that identifies intensity comparisons that are temporally unstable. Finally, we use this additional vector to ignore the corresponding binary values in the fixed-length binary descriptor when matching the features across cameras. We analyse the performance of the proposed approach and compare it with baselines.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com