【AAAI2021】自校正Q学习,Self-correcting Q-Learning

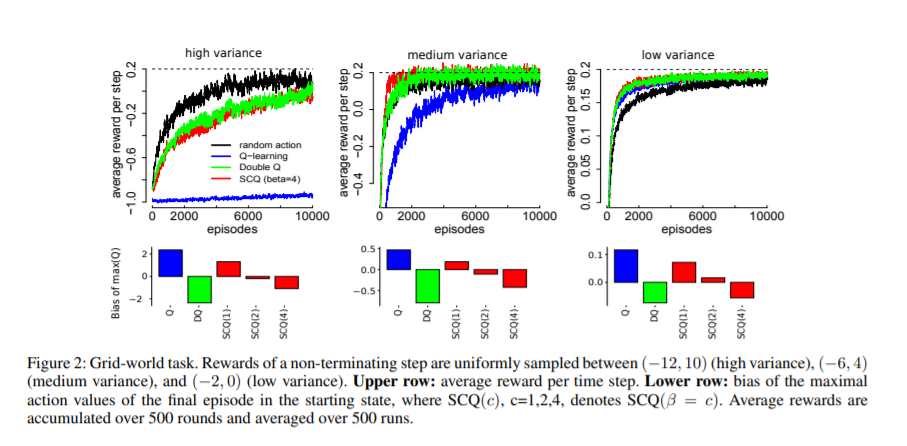

众所周知,Q-learning算法会受到最大化偏差的影响,即对动作值的系统性高估,这是最近重新受到关注的一个重要问题。双Q学习被提出作为一种有效的算法来缓解这种偏差。然而,这样做的代价是动作值被低估,以及内存需求增加和收敛速度减慢。在本文中,我们提出了一种新的方法来解决最大化偏差问题,即采用“自校正算法”来逼近期望值的最大值。我们的方法平衡了传统Q-learning中单估计量的高估和双估计量的低估。将此策略应用到Q-learning中,就会产生自校正Q-learning。我们从理论上证明了该算法具有与Q-learning相同的收敛性保证,并且更加精确。从经验上看,它在高方差奖励领域优于双Q-learning,甚至在零或低方差奖励领域的收敛速度也比Q-learning快。这些优势转移到深度Q网络实现,我们称之为自校正DQN,它在Atari2600域的几个任务上优于常规DQN和双DQN。

https://www.zhuanzhi.ai/paper/7ac6a8d6fb4d231cf273760d59f8dab2

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“SQL” 就可以获取《【AAAI2021】自校正Q学习,Self-correcting Q-Learning》专知下载链接

登录查看更多

相关内容

专知会员服务

17+阅读 · 2020年7月14日

专知会员服务

32+阅读 · 2020年2月1日

Arxiv

4+阅读 · 2018年8月17日