【CVPR2022】通过初始阶段的表征去相关性来提升类增量学习

模仿 oracle:通过初始阶段的表征去相关性来提升类增量学习 / Mimicing the Oracle: An Initial Phase Decorrelation Approach for Class Incremental Learning

这篇论文由字节跳动与新加坡国立大学、中科院自动化所、牛津大学合作完成。

本文主要研究了 class incremental learning,即类增量学习。最终的学习目标是希望通过阶段式的学习(phase-by-phase learning)能够得到一个与 joint training 性能匹配的模型。类增量学习最大的挑战即是:在学习完某一阶段的类别之后,模型在之前阶段类别的性能将大大下降。这一现象被称之为 forgetting。

对于一个分为多个阶段的类增量学习过程,我们可以将之分成两个部分,即 initial phase (第一个学习阶段)与 later phase (除第一个学习阶段后面所有的学习阶段)。以往的工作往往都是在 later phase 对模型进行正则化来减轻遗忘,而不对 initial phase 做特殊处理。但是在这篇论文中,作者们发现:initial phase 在类增量学习的过程中同样关键。

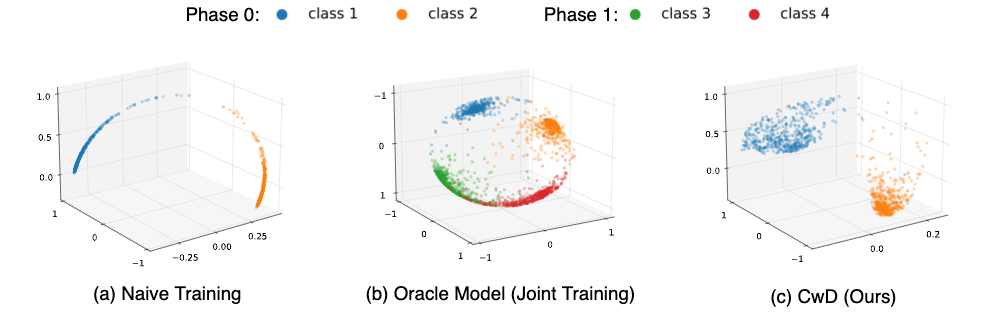

作者们通过可视化发现,一个仅在 initial phase 训练得到的模型与 joint training 的 oracle model 输出的表征的最大区别是:initial-phase-model 的 representation 的分布只会集中在 representation space 的一个狭长的区域(即一个维度较低的子空间),而 oracle model 的 representation 将较为均匀的分布于各个方向(即一个维度相对较高的子空间)。这一结果如图(a)(b)所示。

基于这一发现,作者们提出了一个新颖的正则项:Class-wise Decorrelation (CwD)。这一正则项只作用于 initial phase 的训练过程,目的是使得 initial phase 学习得到的模型的 representation 在空间中的分布能够在各个方向更加均匀,从而能够与 oracle model 更加相似。这一结果如图(c)所示。

作者们发现 CwD 正则项能够对以往的 state-of-the-arts 的类增量学习方法有显著的提升 (1%~ 3%)。希望通过这一工作,能够让科研社区同仁更了解 initial phase 在类增量学习中的意义,从而更加关注如何在 initial phase 提升类增量学习。

arxiv: https://www.zhuanzhi.ai/paper/dbd567beeb2d0e47f9676832e31d69df

code: https://github.com/Yujun-Shi/CwD

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CWD” 就可以获取《【CVPR2022】通过初始阶段的表征去相关性来提升类增量学习》专知下载链接