神经网络的可解释性是我们的错觉吗

加入极市专业CV交流群,与6000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!更有机会与李开复老师等大牛群内互动!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

作者:hahakity

https://zhuanlan.zhihu.com/p/74602449

来源:知乎,已获作者授权转载,禁止二次转载。

深度神经网络 DNN 被认为是黑盒子模型。为了理解 DNN 究竟学到了什么,人们发展了很多神经网络的解释器。这些解释器中有一类叫 Saliency Map, 关注图,研究神经网络究竟借助一张图片中的哪个区域做出决策。

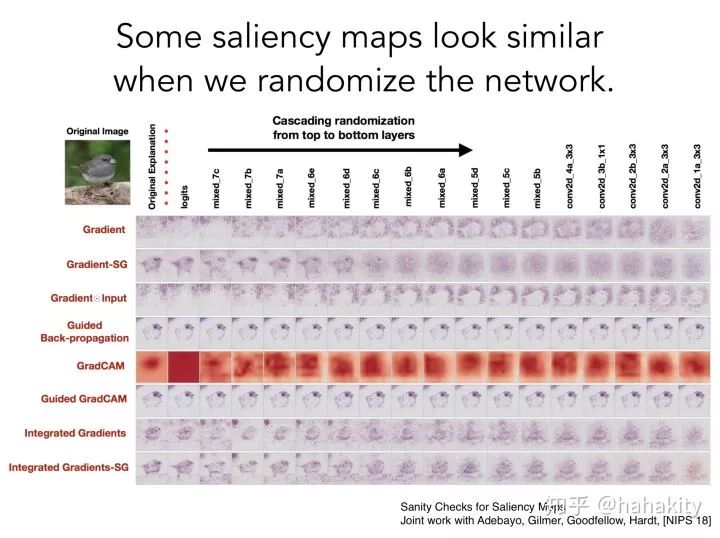

最近 MIT 的 Been Kim 给了一个关于深度学习可解释性的报告(报告链接:https://drive.google.com/file/d/1ACMlhSIC-tAnpRVYu-Epl0lWfOOtNvF1/view)。报告里有一张让人非常震惊的图。下面这张 Slides 讲就算将神经网络的参数随机处理,目前市面上的大部分神经网络解释器仍然给出看上去相似的关注图。也就是说虽然看上去解释器找到了输入图片中的重要区域,但这并不解释神经网络学到了什么,就算是随机网络,解释器也能找到这些区域。

左上角是一张鸟图,鸟图下方列着八种不同解释器的名字。每个解释器给出一行 Saliency Map, 每一行的第一列是使用未修改的解释器给出的关注图,第二列是只随机化输出层的权重参数,得到的关注图。除了 GradCAM,列表中的其他解释器给出的关注图几乎不受随机化的影响。接下来第三列,第四列 ... 一直到最右边一列,是逐层随机化权重,八种解释器得到的关注图。

一种可能的解释是卷积神经网络过于强大,即便是随机化的卷积核,也能从输入图片中学到各种特征。但这不能解释为何当神经网络给出随机预测时,解释器仍能正确识别对这一类重要的区域。

讲到这张透明片的时候,Been Kim 连说了好多 Shocking!因为我之前在专栏里介绍过各种可解释器,看到这张透明片,觉得格外震惊。这种严格的测试对理解神经网络的可解释性非常重要。可以预见可解释性研究要迎来一大波突破。

-End-

*延伸阅读

添加极市小助手微信(ID : cv-mart),备注:研究方向-姓名-学校/公司-城市(如:目标检测-小极-北大-深圳),即可申请加入目标检测、目标跟踪、人脸、工业检测、医学影像、三维&SLAM、图像分割等极市技术交流群,更有每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流,一起来让思想之光照的更远吧~

△长按添加极市小助手

△长按关注极市平台

觉得有用麻烦给个在看啦~