顶会论文轮番炸场,本周哪些论文最值得读?

在碎片化阅读充斥眼球的时代,越来越少的人会去关注每篇论文背后的探索和思考。

在这个栏目里,你会快速 get 每篇精选论文的亮点和痛点,时刻紧跟 AI 前沿成果。

点击本文底部的「阅读原文」即刻加入社区,查看更多最新论文推荐。

@lizhongyang2011 推荐

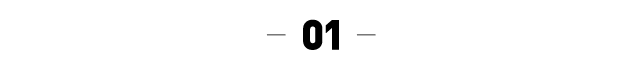

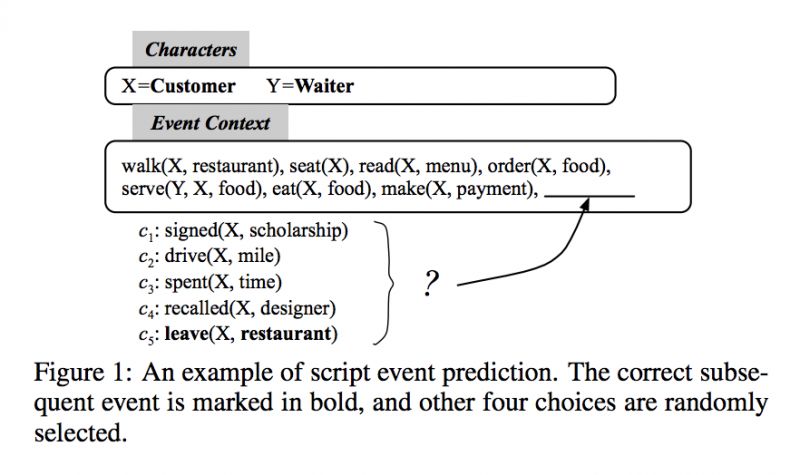

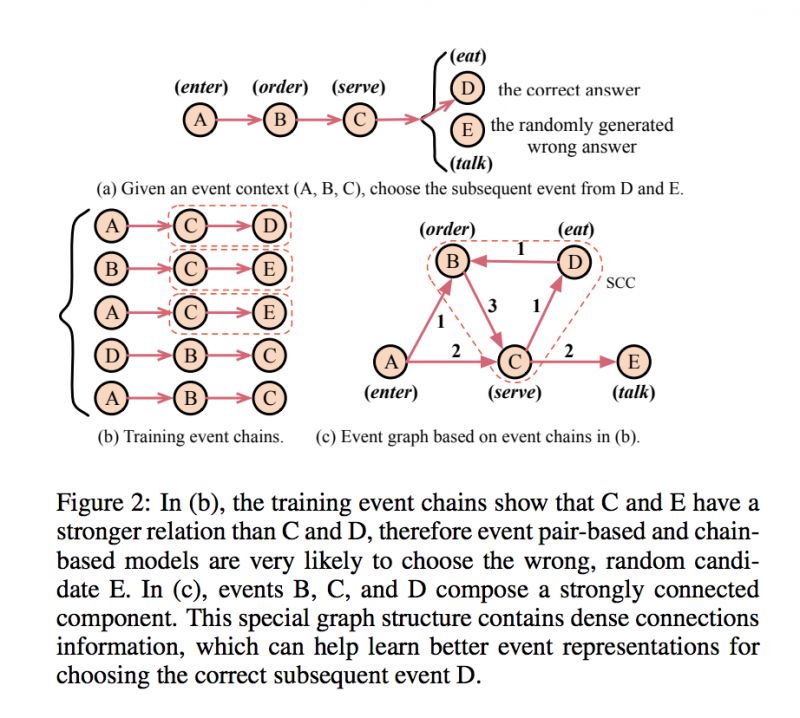

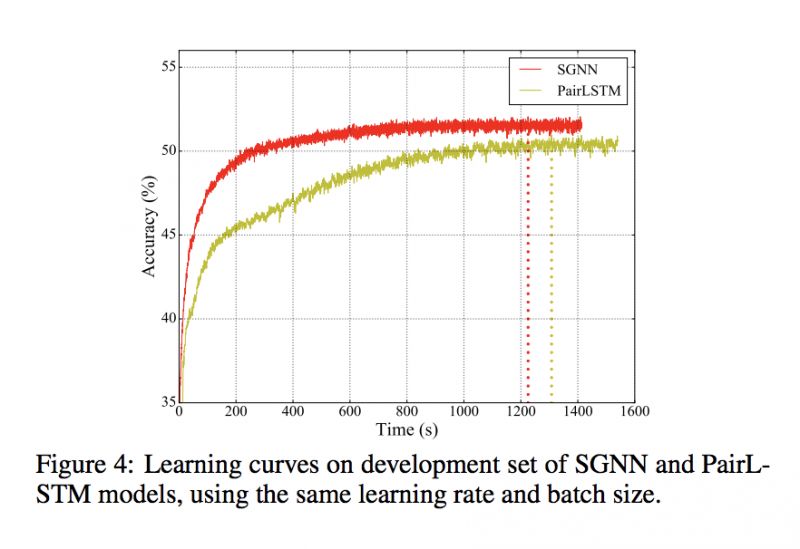

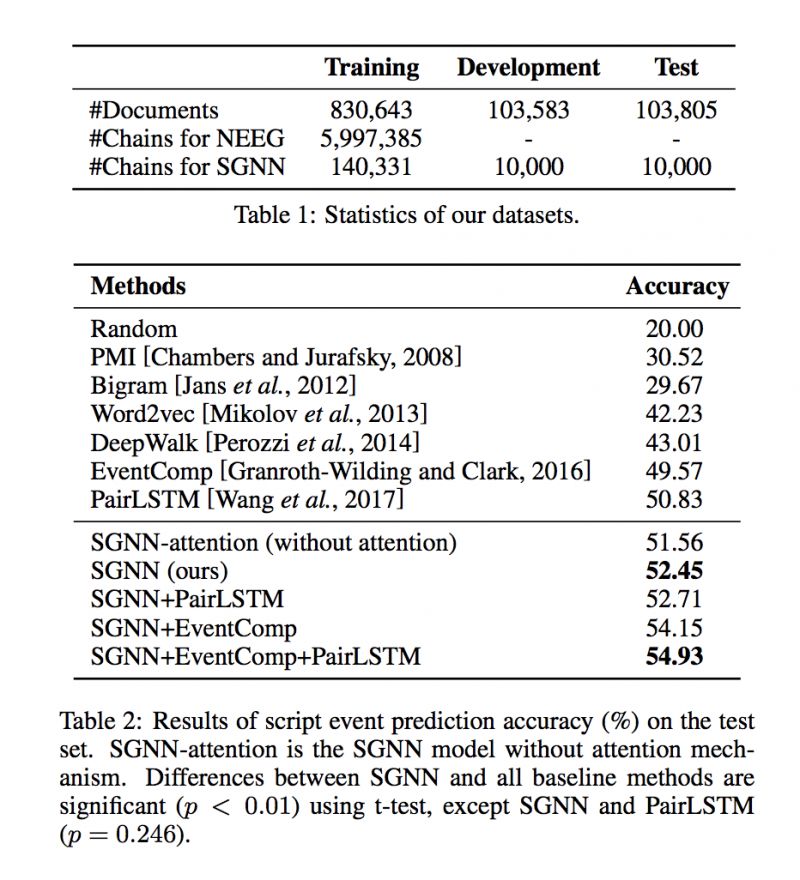

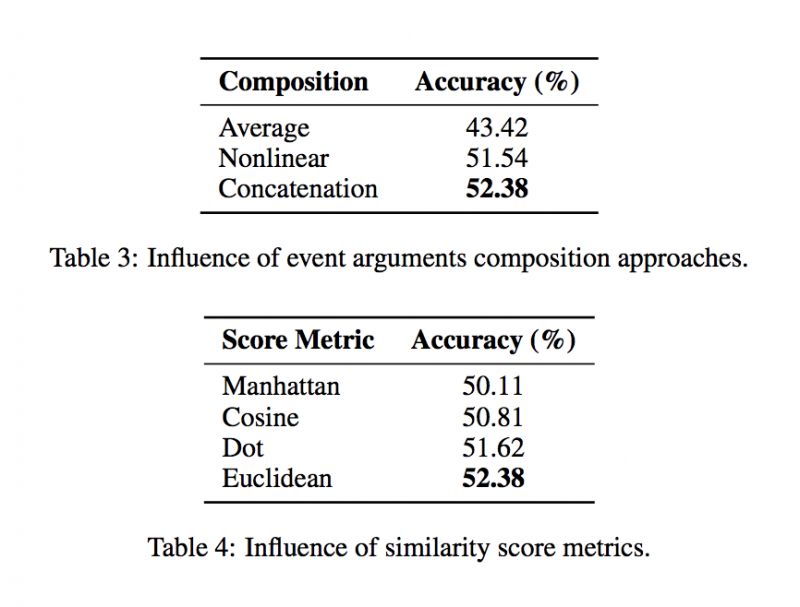

#Script Event Prediction

本文是哈工大发表于 IJCAI 2018 的工作,论文提出通过构建叙事事理图谱来更好地利用事件之间的稠密连接信息,以帮助脚本事件预测任务。为了解决大规模事理图谱图结构上的推断问题,本文提出了一个可扩展的图神经网络模型,来学习事件之间的交互作用并学习到更好的事件表示。在脚本事件预测任务上,本文的方法取得了 SOTA 的结果。

▲ 论文模型:点击查看大图

@paperweekly 推荐

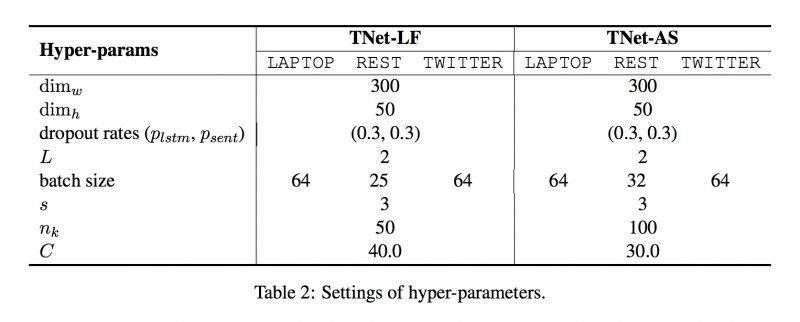

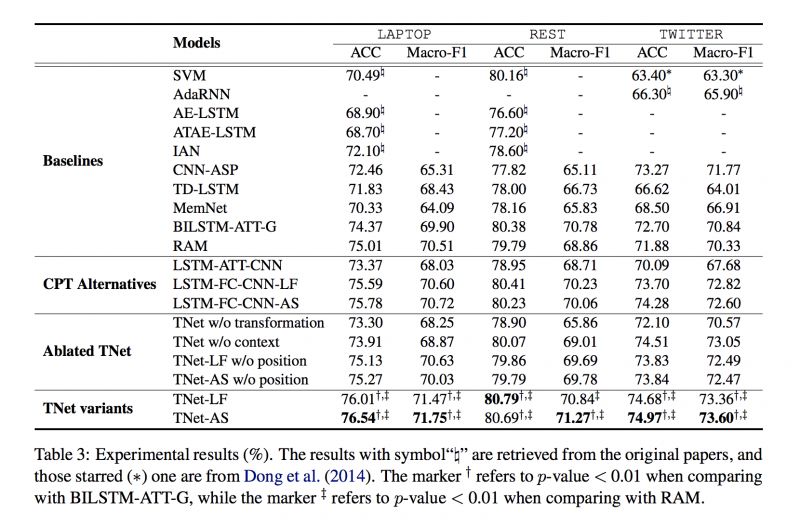

#Sentiment Classification

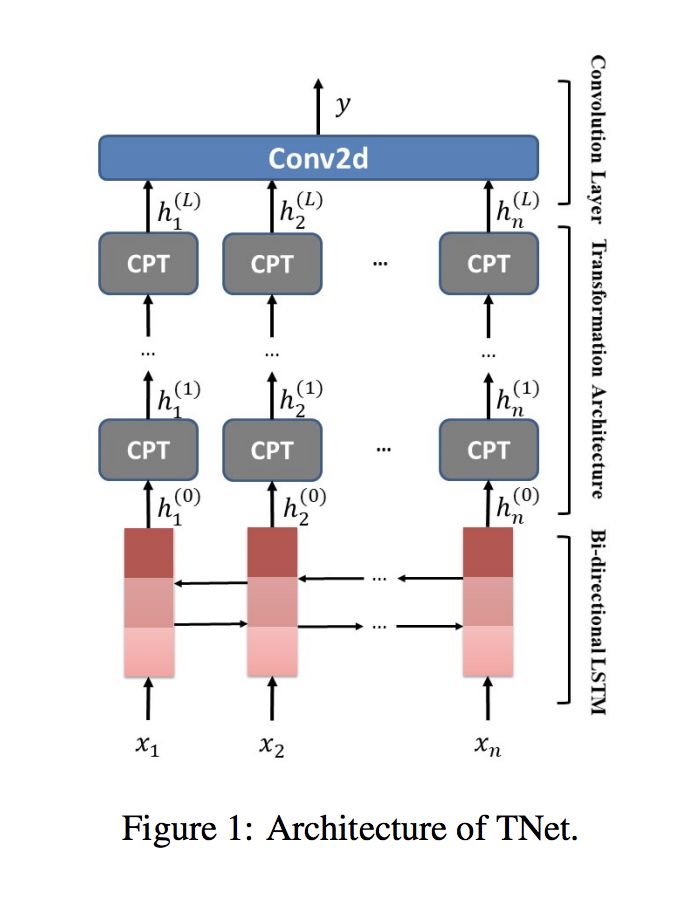

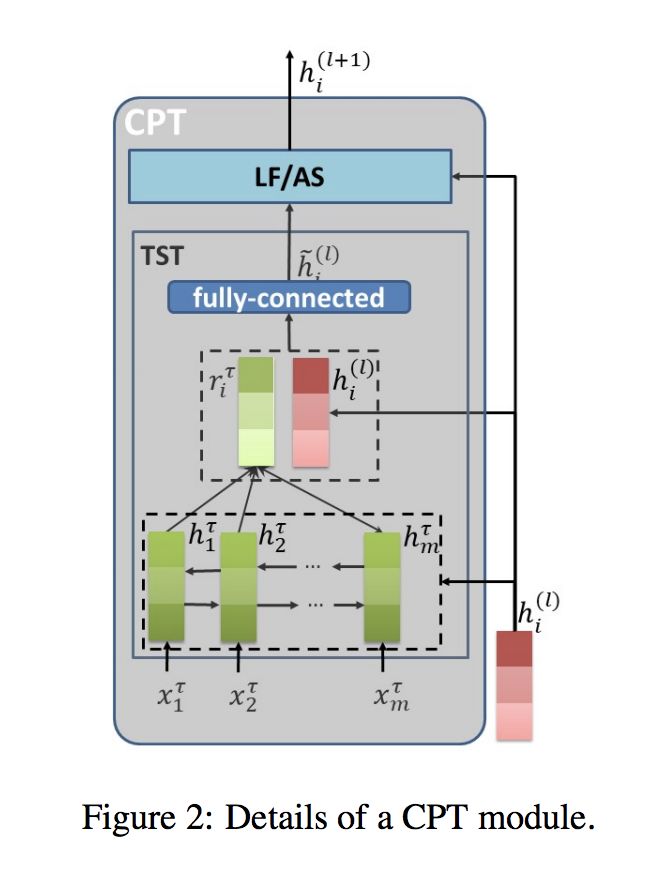

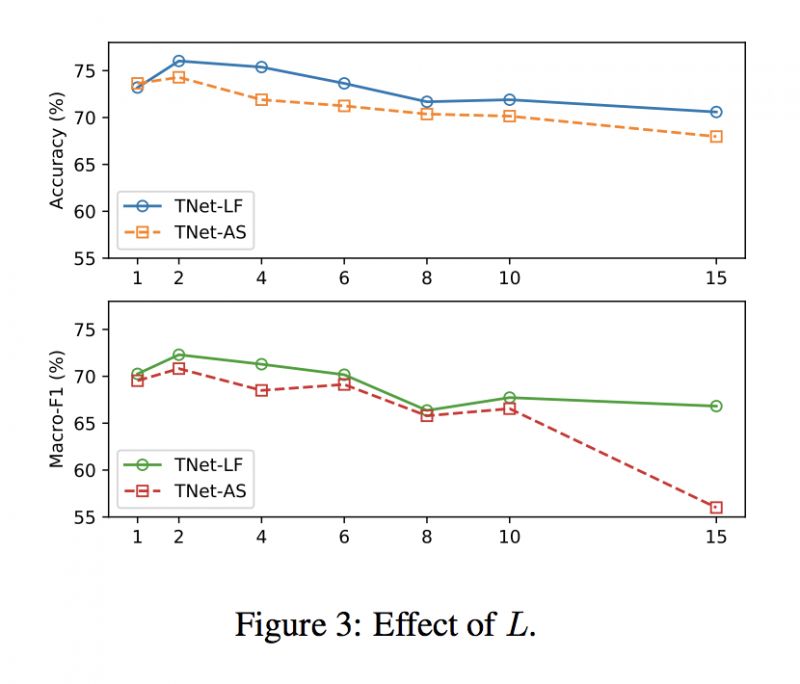

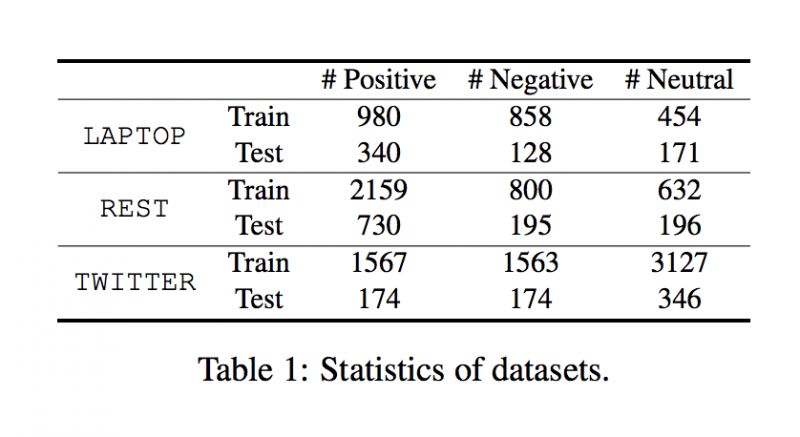

本文是 Tencent AI Lab 与香港中文大学联合发表于 ACL 2018的工作。该文尝试了一种新思路来解决面向评论目标(opinion target)的情感分类任务:用卷积神经网络(CNN)替代基于注意力机制的 RNN 去提取最重要的分类特征。

由于 CNN 很难利用目标实体信息,该文设计了一个特征变换组件来将实体信息引入到单词的语义表示当中。这个特征变换过程可能会使上下文信息丢失,所以文中提出了两种“上下文保留”机制,将上下文信息和变换之后的特征结合起来。该框架在三个标准数据集上,取得了全面优于已有方法的准确率和 F1 值。

▲ 论文模型:点击查看大图

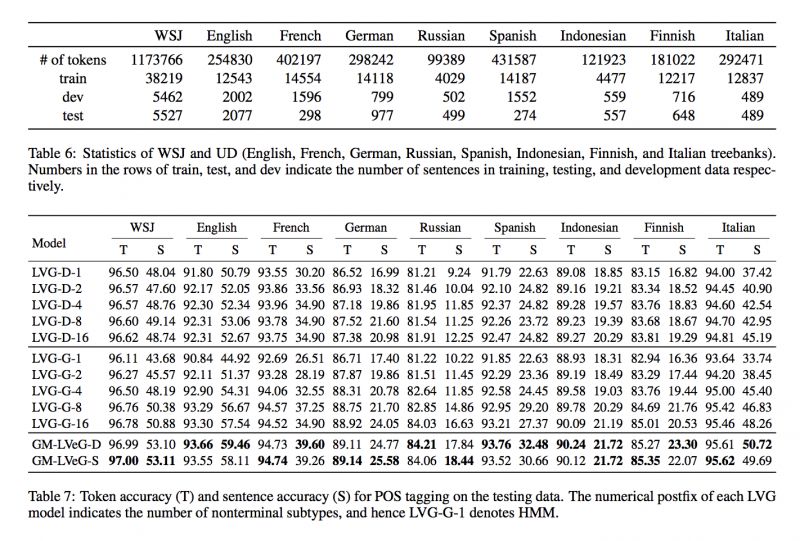

Gaussian Mixture Latent Vector Grammars

@lalalalal 推荐

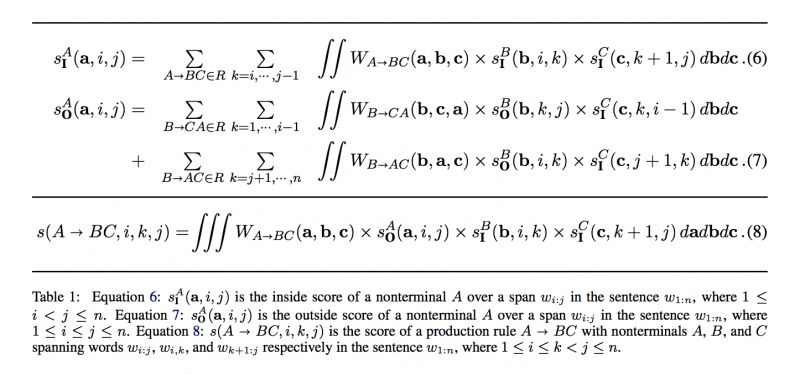

#Grammar Learning

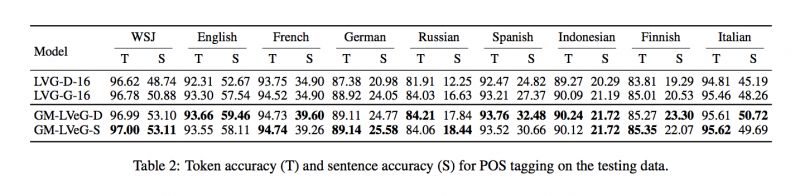

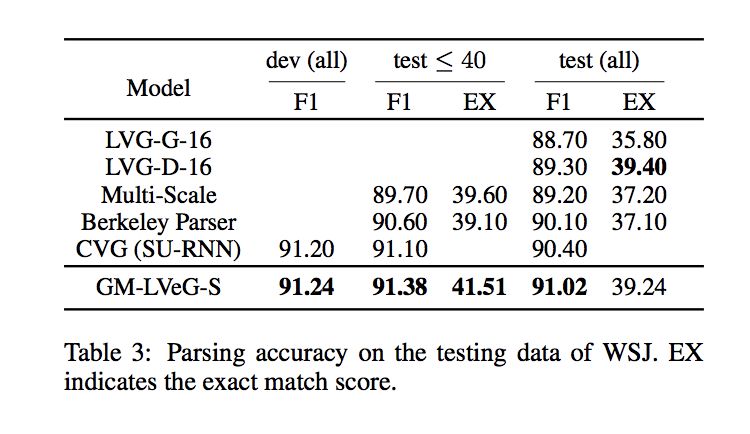

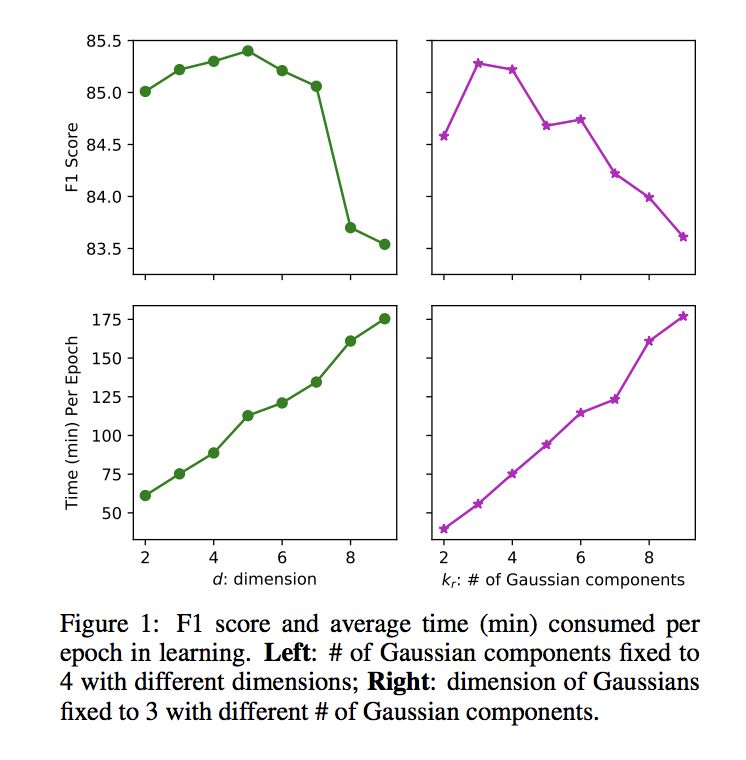

本文是上海科技大学发表于 ACL 2018 的工作,论文收到 6/5/5 的评分(满分 6 分)。论文提出了 Latent Vector Grammars (LVeGs),证明 Latent Variable Grammars 和 Compositional Vector Grammars 皆为 LVeGs 的特例。此外,论文还提出 LVeGs 的一种特例:Gaussian Mixture LVeGs,能够进行有效的推理和学习。在 Constituency Parsing 和 Part-of-Speech Tagging 两个任务上皆取得不错的效果。

问题价值:语法树可以表示语言的生成过程,编码语言中潜藏的结构信息,有助于语言理解和生成任务;之前的研究显示细化句法类别,如将每个句法类别切分为有限个子类别,能够提高语法分析的精度;本文更进一步,提出使用连续向量空间表示句法子类别空间,因此能够建模无穷多个句法子类别。

问题难度:如何表示句法子类别的连续空间;如何在句法子类别高纬连续表示的设定下进行有效的学习和推理。

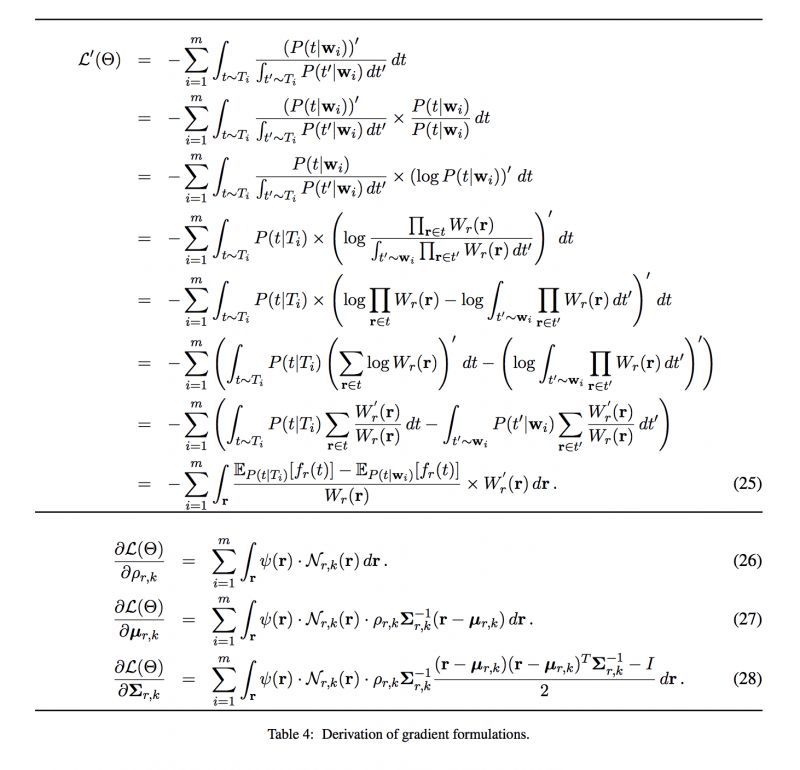

解决思路:本文将文法规则的权重函数定义为混合高斯分布;对于文法规则 A->B,其权重函数的变量为向量 a(句法类别 A 的子类型向量空间)和 b(句法类别 B 的子类型向量空间)的串联;在上述设定下,能够应用梯度下降的优化方法进行有效的学习,同时能够应用动态规划算法进行有效推理。

▲ 论文模型:点击查看大图

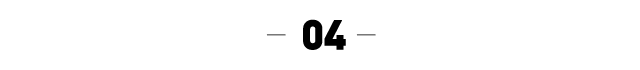

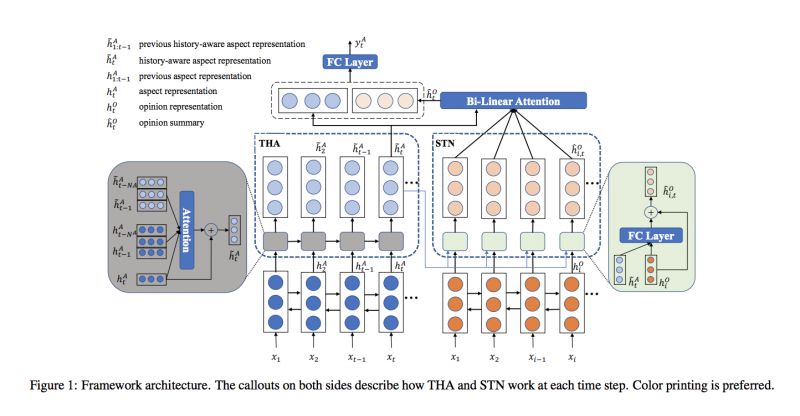

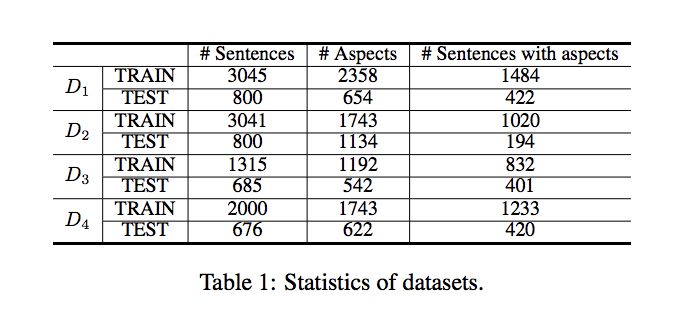

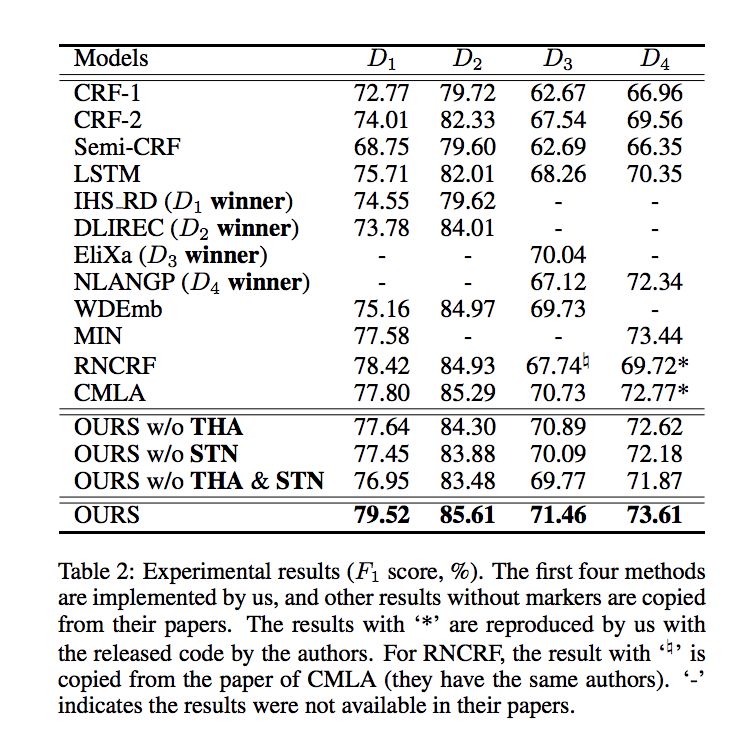

@paperweekly 推荐

#Hierarchical Attention Networks

本文是 Tencent AI Lab 与香港中文大学联合发表于 IJCAI 2018 的工作。该文提出的 aspect 抽取框架利用了两个有用的线索:opinion summary 和 aspect 检测历史。

opinion summary 是基于 aspect 预测的每个当前 token 从整个输入句子提炼出来的,因此这个量身定做的 summary 有助于当前 token 是否为 aspect 的预测。另一个线索是从之前 token 的 aspect 预测提取出来的预测历史,此线索利用了同位词关系和 BIO tagging 的约束来提高预测效果。该模型在四个基准数据集上进行了实验,均取得了最佳结果。

▲ 论文模型:点击查看大图

@paperweekly 推荐

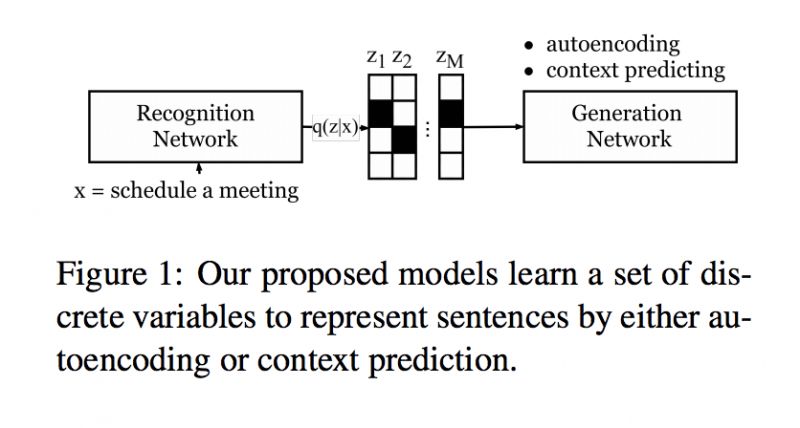

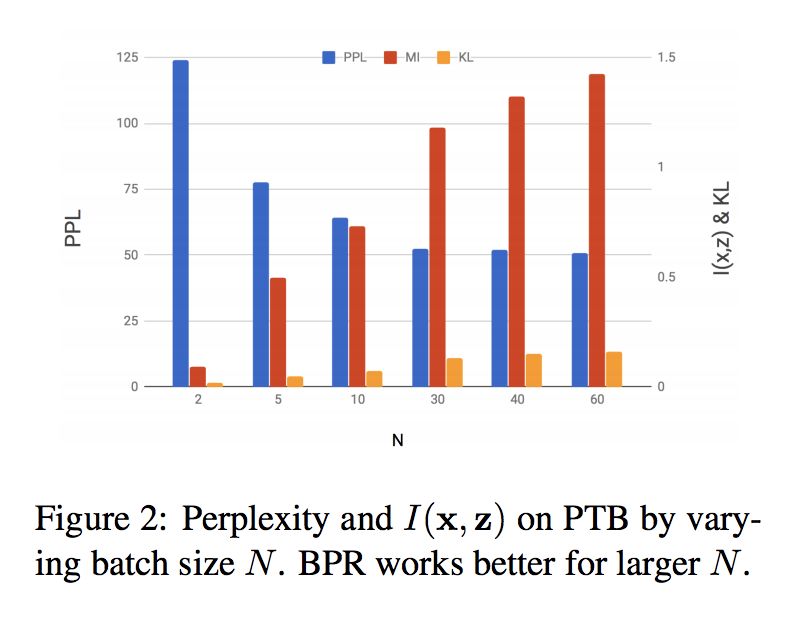

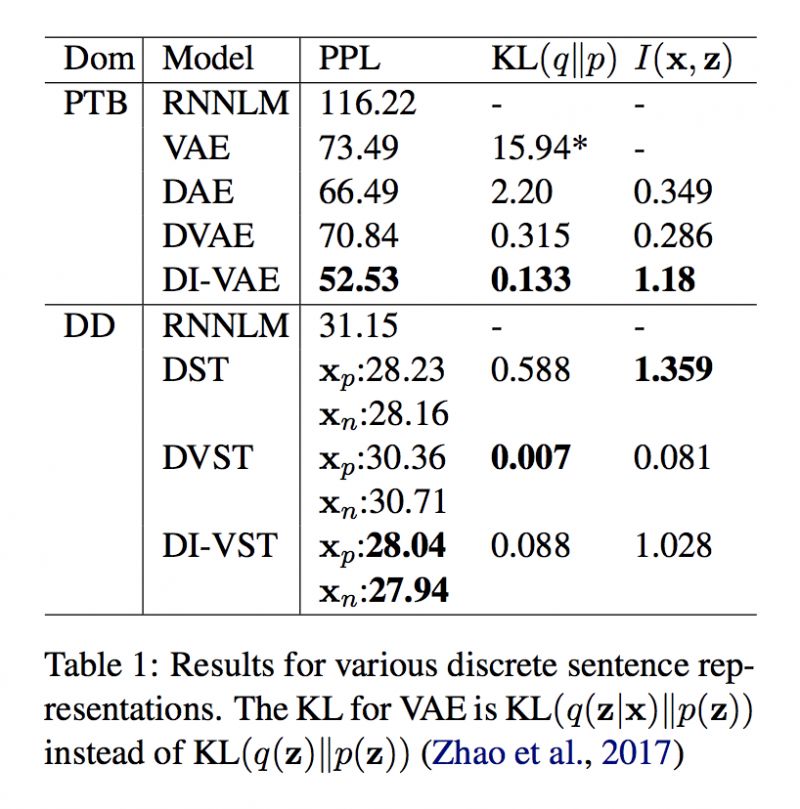

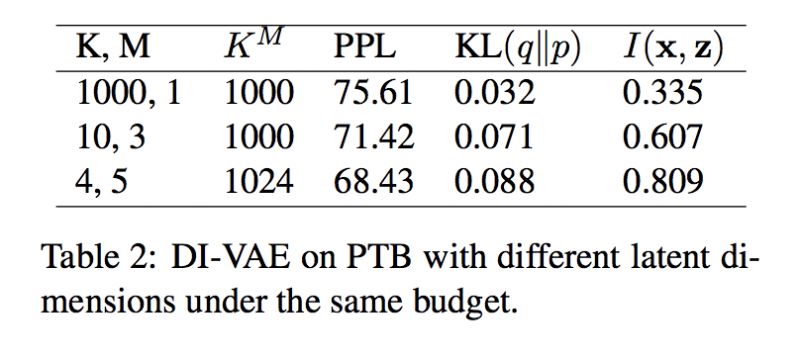

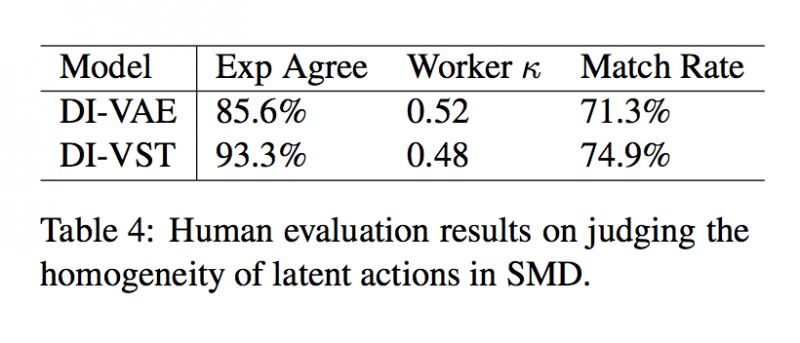

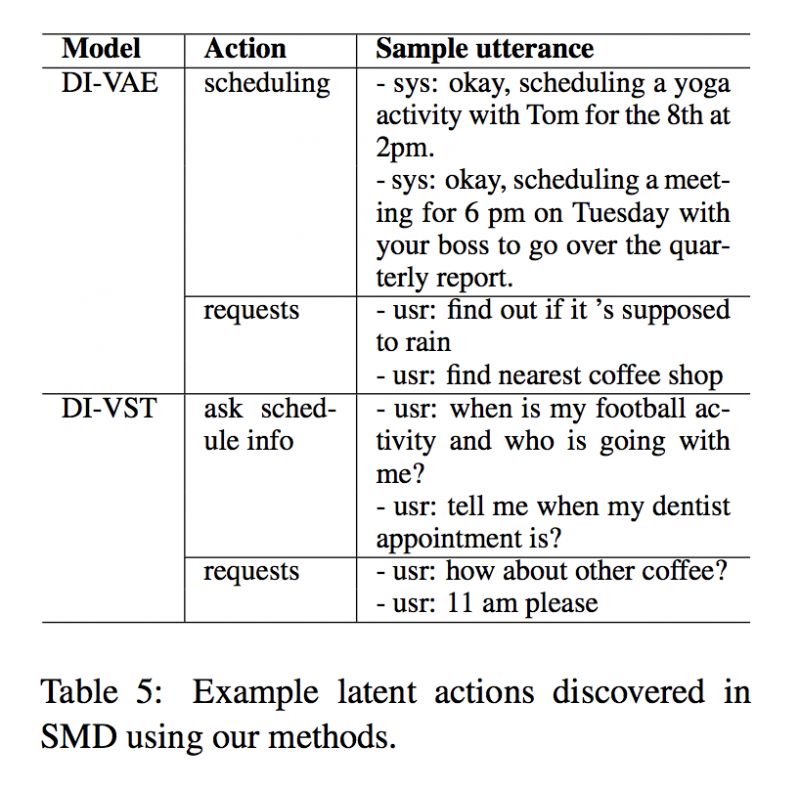

#Dialog Generation

本文是 CMU 发表于 ACL 2018 的工作,论文从生成式对话模型的可解释表示学习出发,作者提出了两种无监督的 VAE 模型:DI-VAE 和 DI-VST,可以和现有的 encoder-decoder 框架结合,去做可解释的对话生成。

▲ 论文模型:点击查看大图

@DeepTrial 推荐

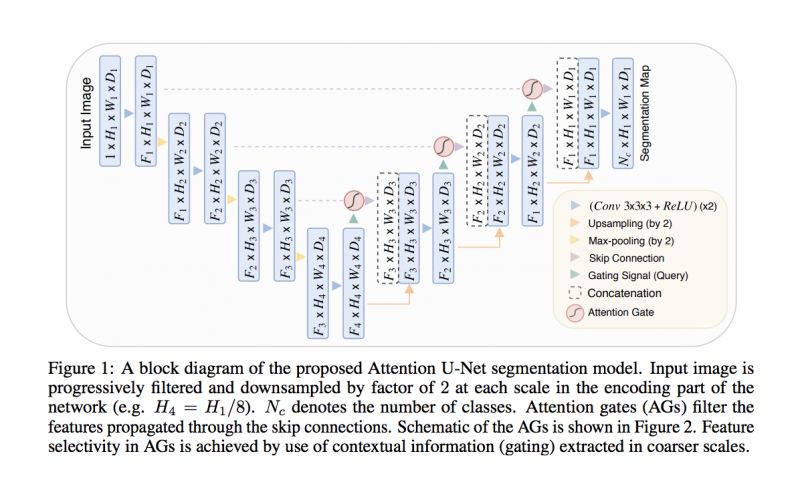

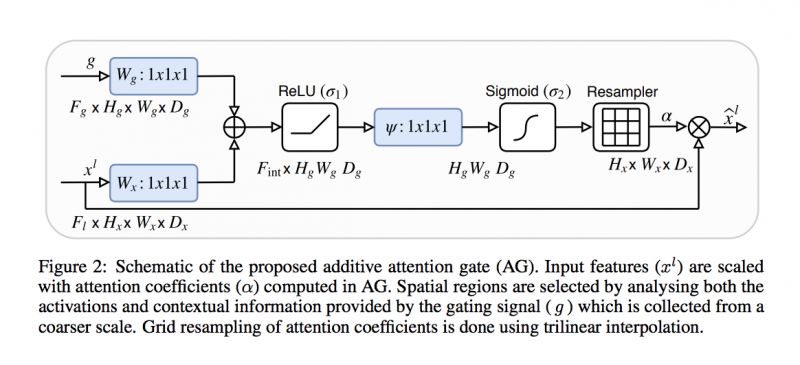

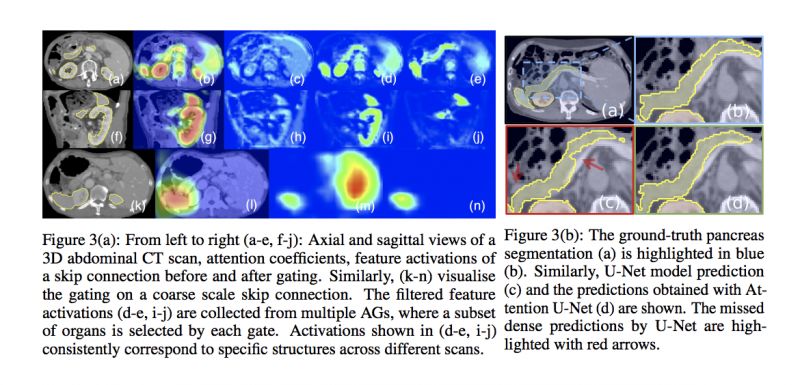

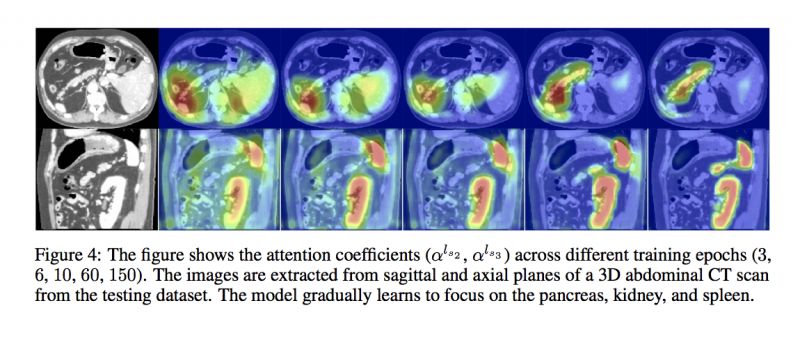

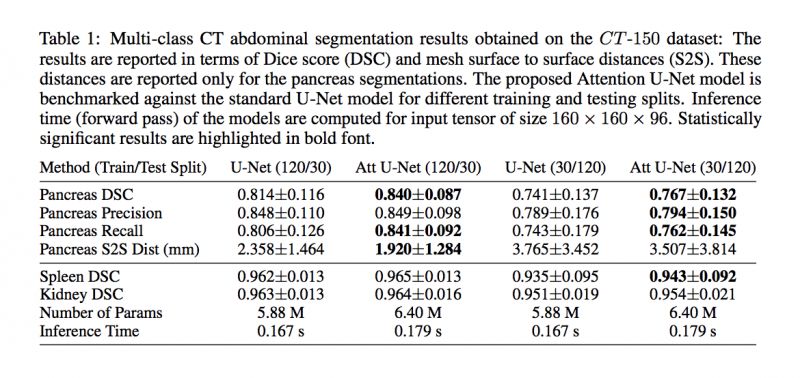

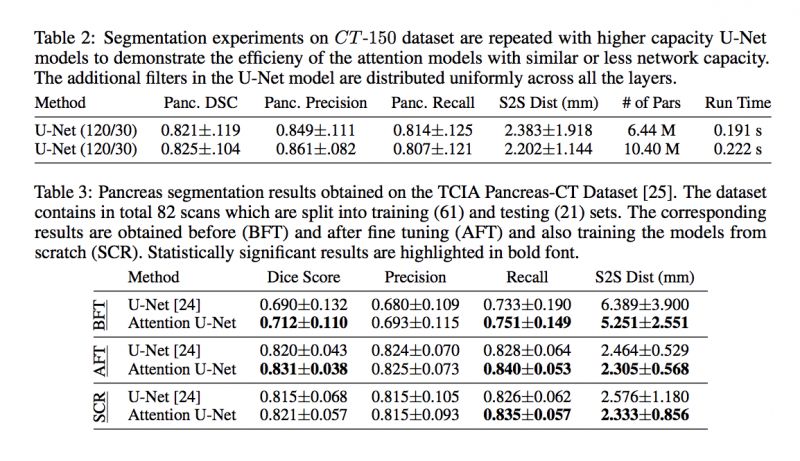

#Attention Mechanism

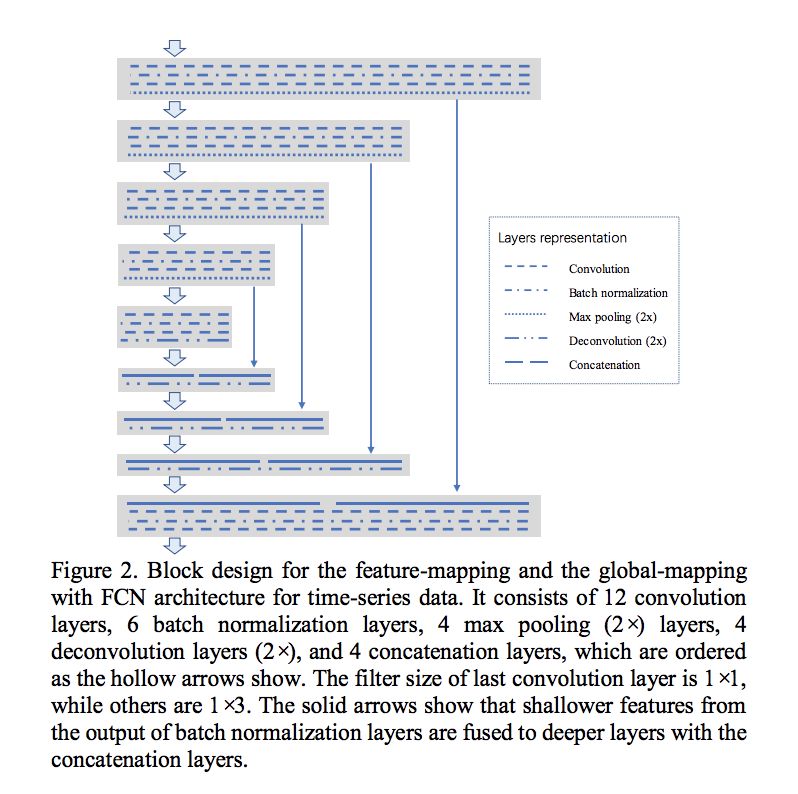

作者实现了 Attention 机制与 U-Net 网络的融合。以往在计算机视觉领域中所使用的 Attention 机制,需要使用增强学习等方法来调整参数,使得网络效率低下。作者这里使用 U-Net 模型下采样阶段提取出的特征作为门控信息,生成 Attention 的权值,而整个模型的参数调整都遵循梯度下降的原则,无需引入其他方法,极大简化了网络结构。

另一方面 Attention 机制可以帮助 U-Net 模型抑制和分割目标无关区域的响应,帮助加快收敛速度,提高模型精度。文中,作者给出了 Attention U-Net 在肺部 CT 图像,视网膜眼底图像上应用的结构,证明其在图像语义分割上的优异性能。

▲ 论文模型:点击查看大图

@TwistedW 推荐

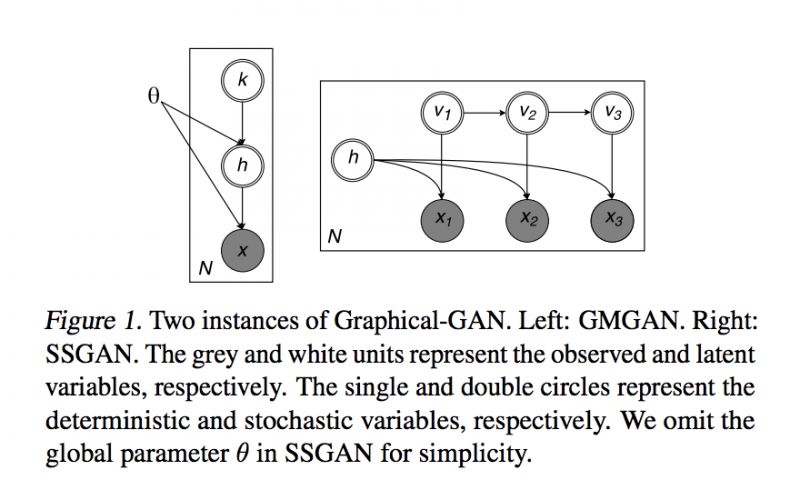

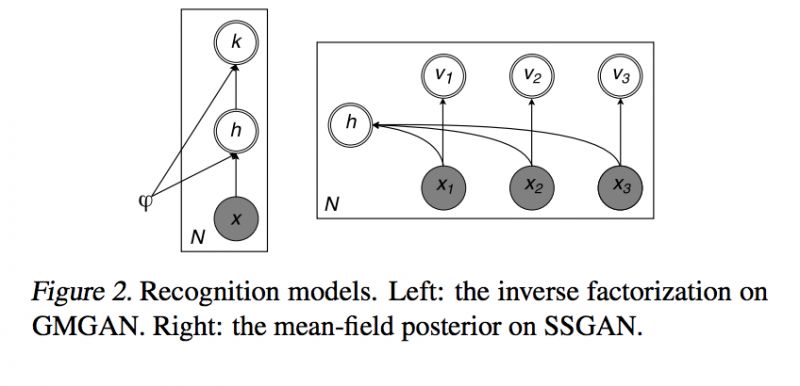

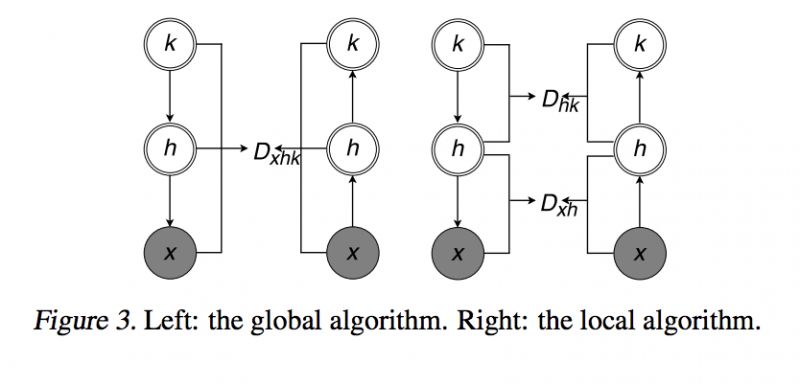

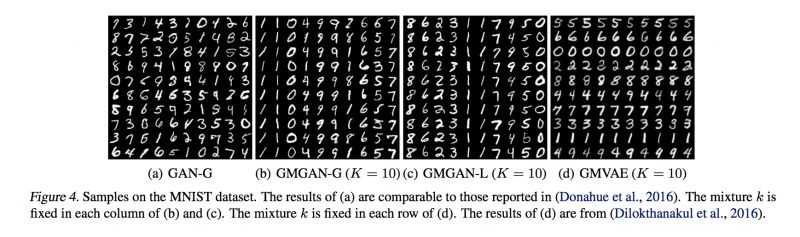

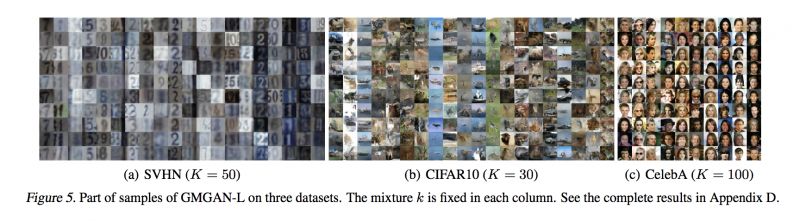

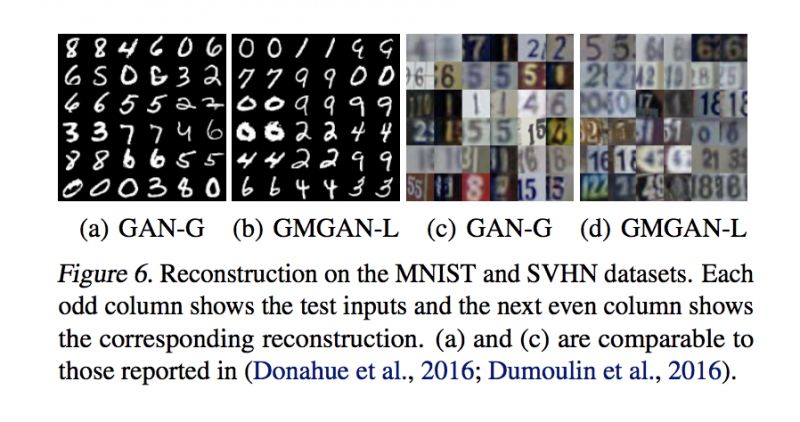

#Generative Adversarial Networks

文章提出了 Graphical GAN 将贝叶斯网络应用于 GAN 中,达到了紧凑表示随机变量之间的依赖关系结构,以及生成对抗网络对学习表达依赖函数的依赖关系结构。文章的数学和理论高度较高,实验上不仅仅可以生成静态的图像还可以生成带有时序信息的数据。

▲ 论文模型:点击查看大图

@paperweekly 推荐

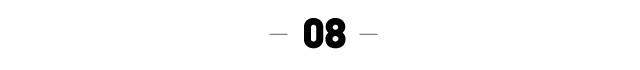

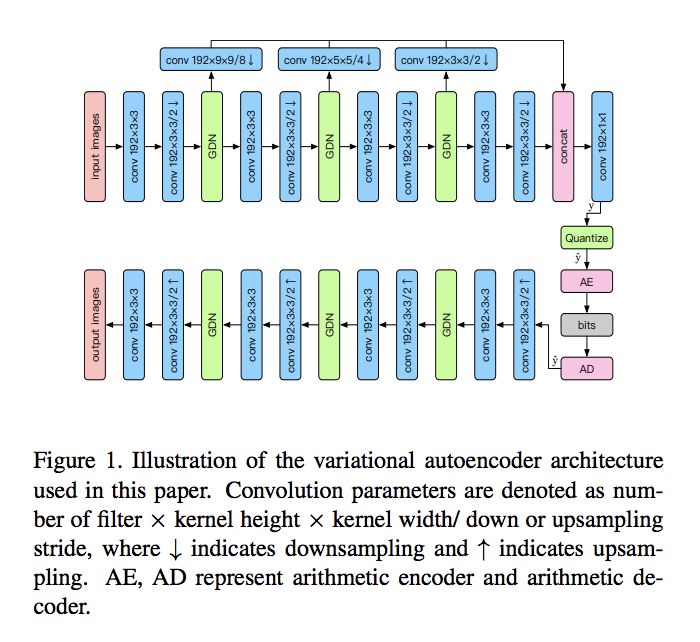

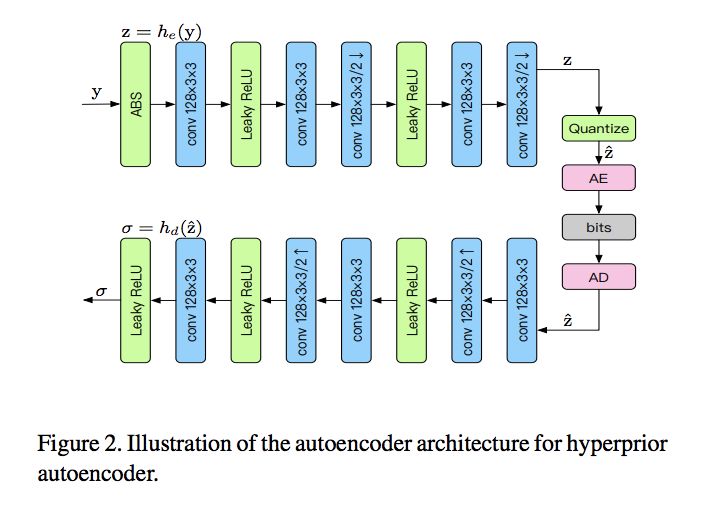

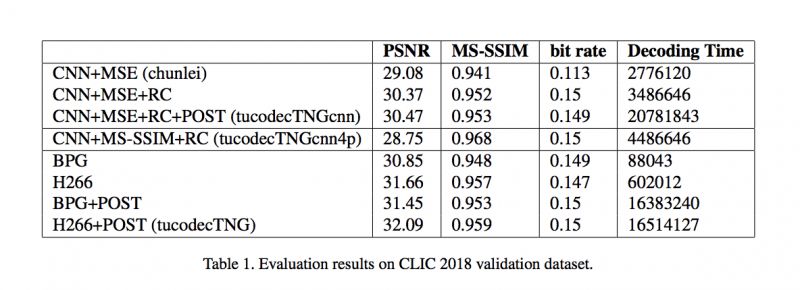

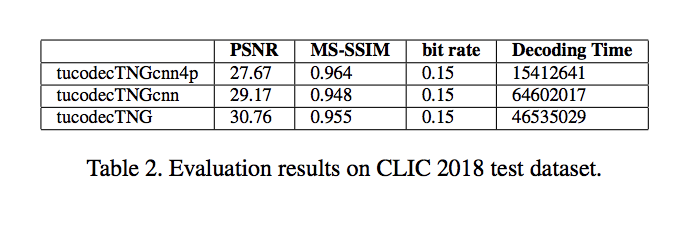

#Image Compression

本文是图鸭科技图片压缩团队于 CVPR 2018 图像压缩别挑战赛(CLIC)参赛论文。该文提出了一种在深度学习领域的图像压缩算法,在保证图像质量的同时,尽可能的降低图片大小。

论文主要有以下几个方面:优化的网络结构、高效的量化方法、量化与码字估计联合优化、优化的熵编码技术,并与网络结构融合,实现端到端的优化。大赛结果表明,该方法没有辜负我们的期望,Tucodec TNGcnn4p 在 CLIC 上斩获全部两项主观测评指标 MOS 与 MS-SSIM 的第一名。

▲ 论文模型:点击查看大图

@fashipiaoliu 推荐

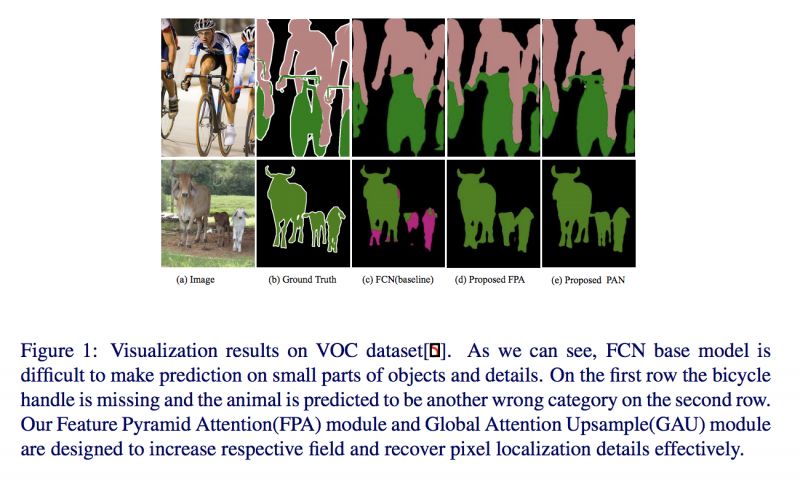

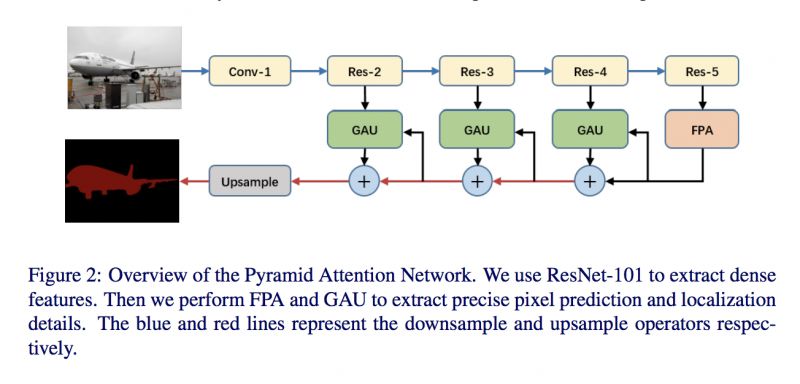

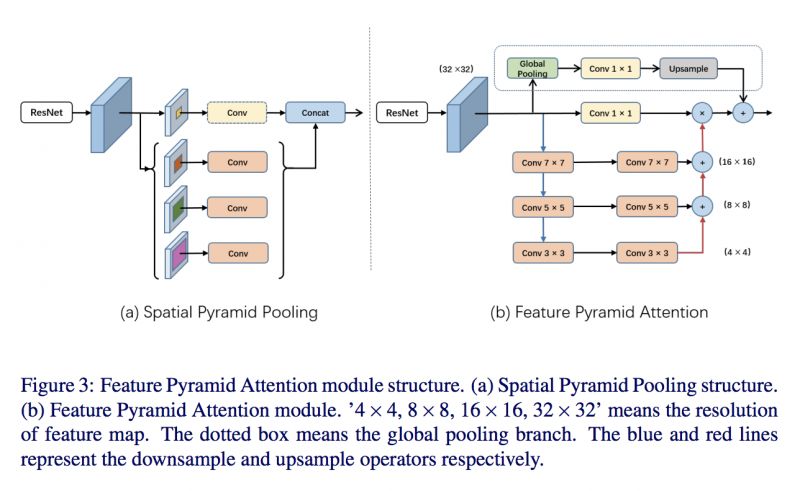

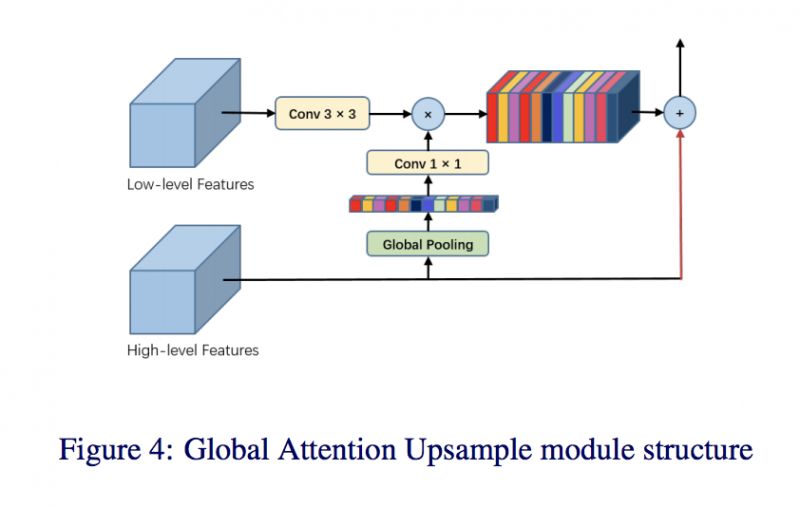

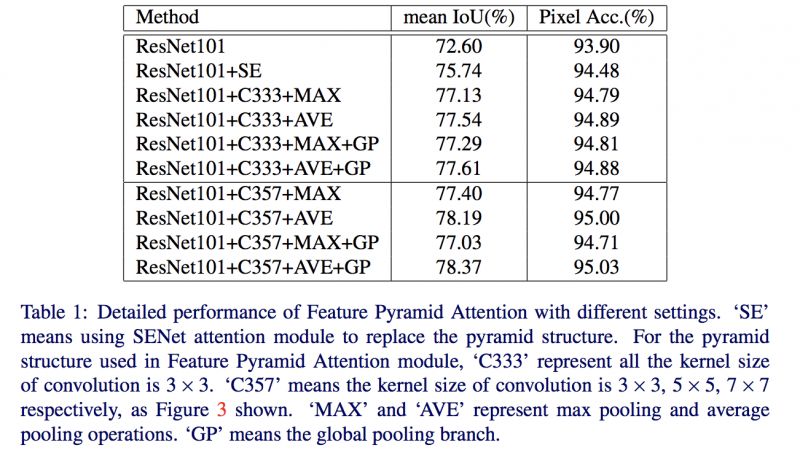

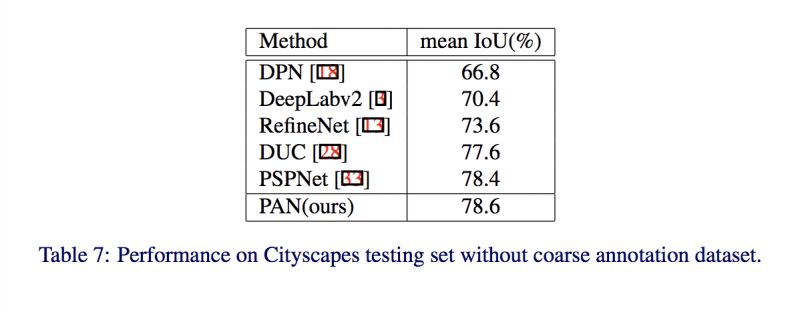

#Semantic Segmentation

本文来自北京理工大学和 Face++,论文提出了特征金字塔注意力模块可在 FCN 基础像素预测模型嵌入不同尺度的上下文特征。开发了一个高效解码模块 GAU 以帮助语义分割。结合特征金字塔注意力和全局注意力上采样,该金字塔注意力网络架构可在 VOC 2012 和 cityscapes 基准上达到当前最优水平。

▲ 论文模型:点击查看大图

@DeepTrial 推荐

#Medical Image Analysis

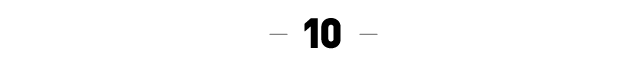

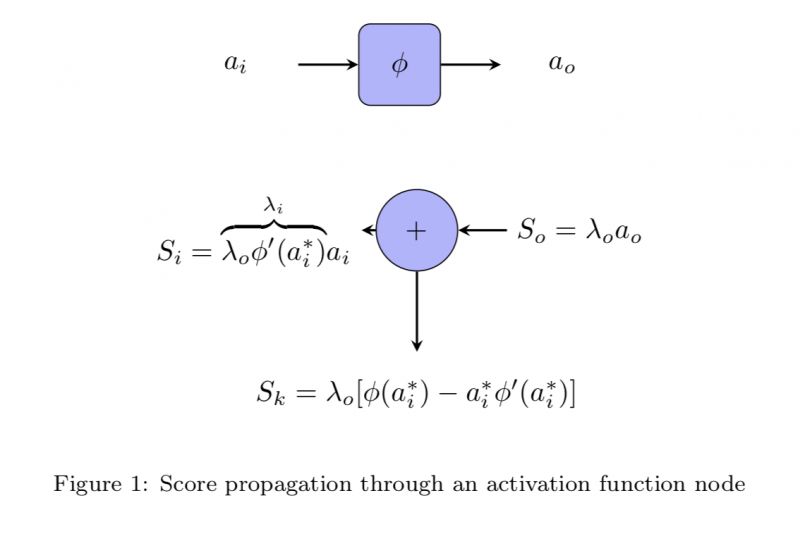

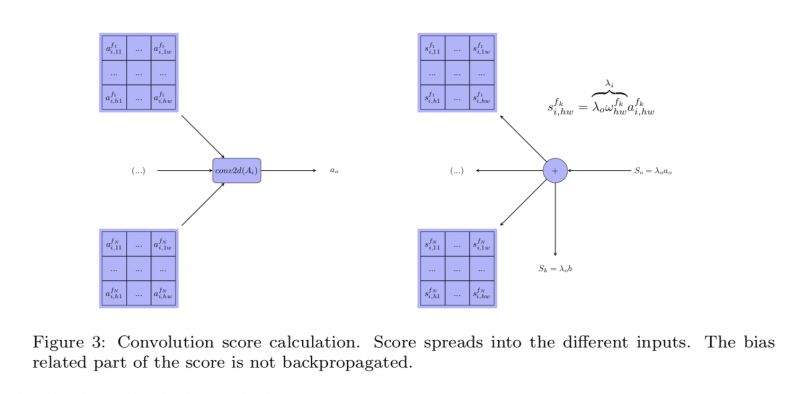

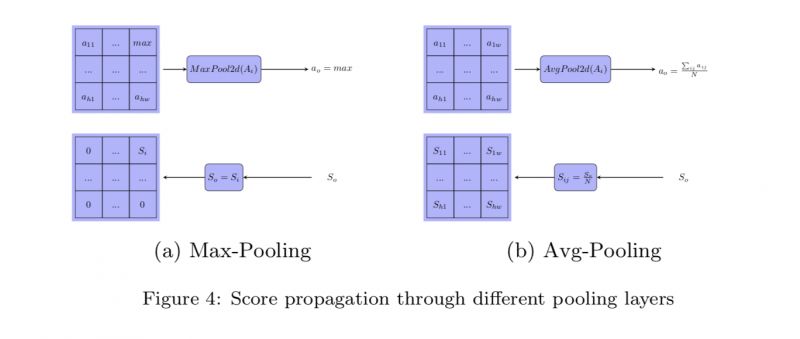

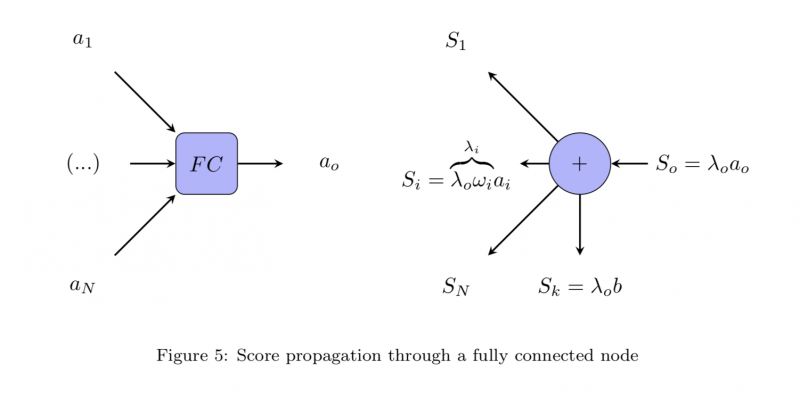

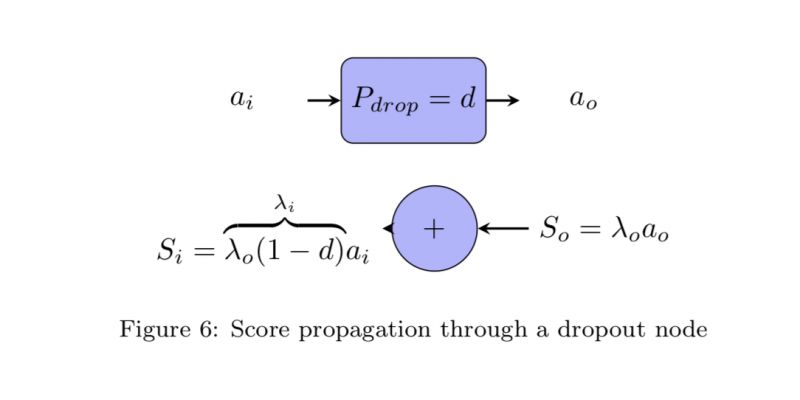

当使用深度学习处理医学图像问题时,往往会因为深度学习的不可解释性阻碍医生或大众信任计算机给出的判断。在糖尿病视网膜症评级问题上也是如此。现有的 CNN 模型在这个问题的数据集上已有很高的准确率,但模型本身是不可解释的。

本文作者提出了一种解释卷积神经网络的方法,使得模型给出的分类结论更有说服性。本文重点围绕卷积神经网络的数学解释方法而展开。对于关注神经网络可解释性的研究者而言值得一看。

▲ 论文模型:点击查看大图

@daven88 推荐

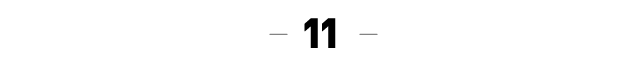

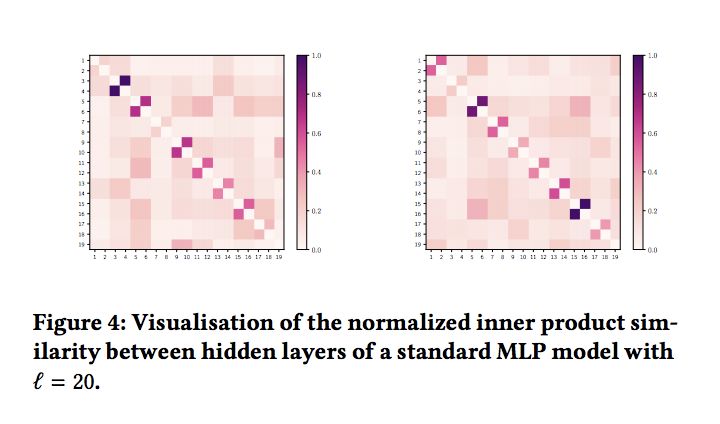

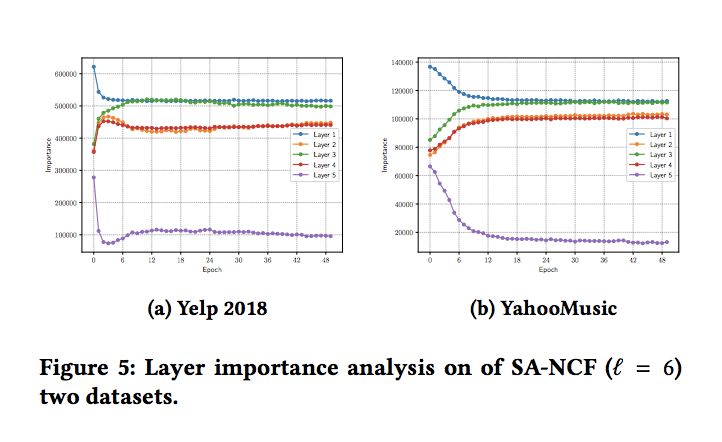

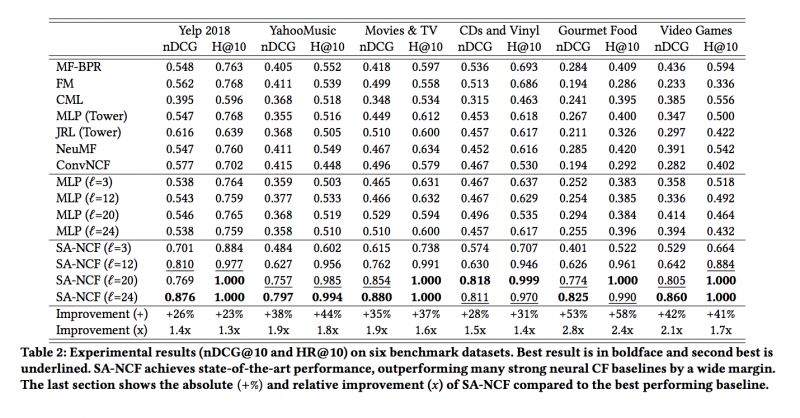

#Recommender Systems

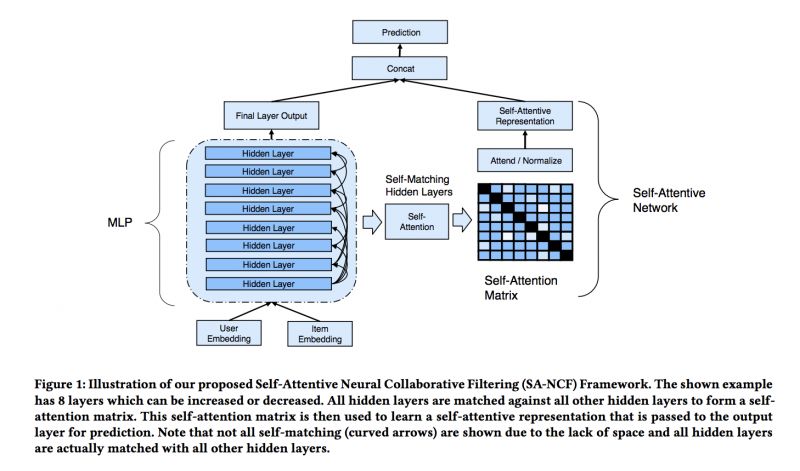

目前主流的基于深度学习的推荐系统大多都在研究如何模拟用户和商品之间的非线性的关系。 但是目前使用到的深度学习框架都是浅层的 (比如 3 到 4 层)。 如何训练更深的模型还不是很清楚。

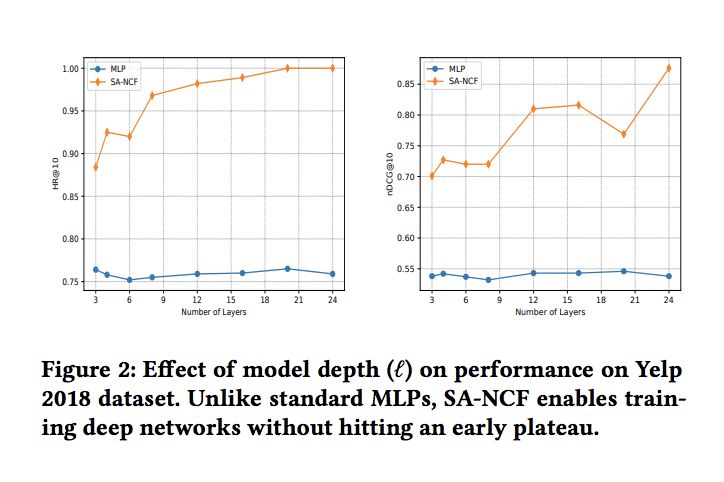

本文提出了一种新型的深度学习模型 SA-NCF,这个模型可以让层数达到 20 甚至更深的层数。这个模型利用层级的自注意力模型来学习 MLP 中各个隐含层之间的深层次的关系和相似度。SA-NCF是一个全连接的自匹配模型。

我们在 6 个大规模的真实的数据集上面做了测试,发现我们的模型能起到 23%-58% 的提升(基于最新的深度学习的推荐模型, 例如 NeuMF,MLP,CML),在有些数据集上 HR@10 甚至可以达到 100%。是一个非常有应用前景的模型。

▲ 论文模型:点击查看大图

@lykaust15 推荐

#Deep Learning

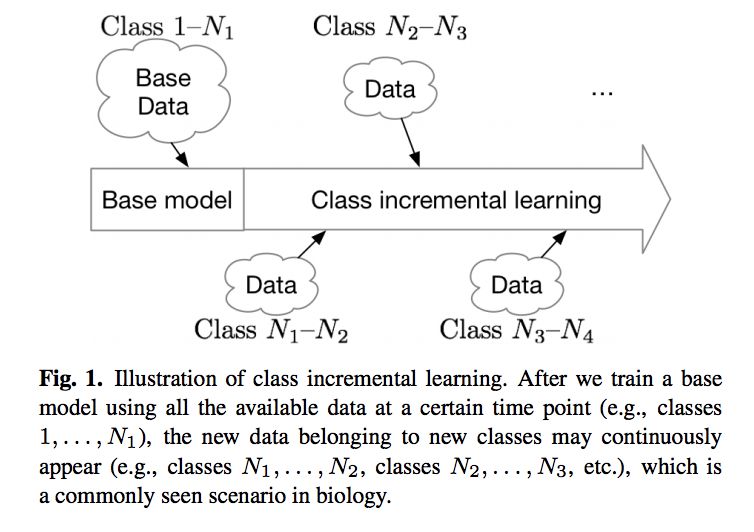

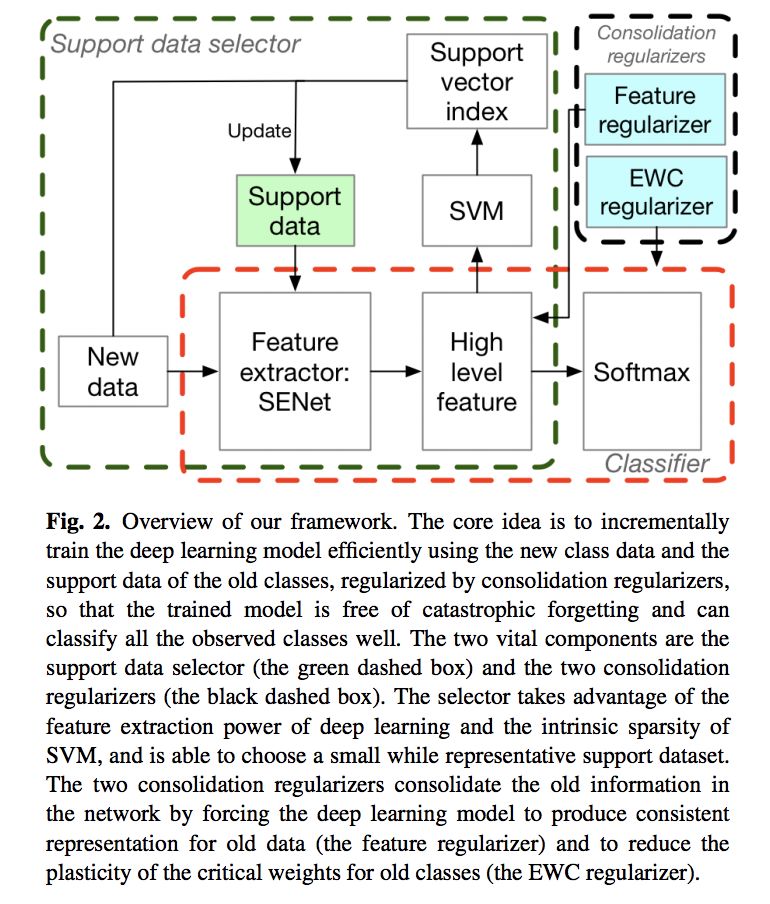

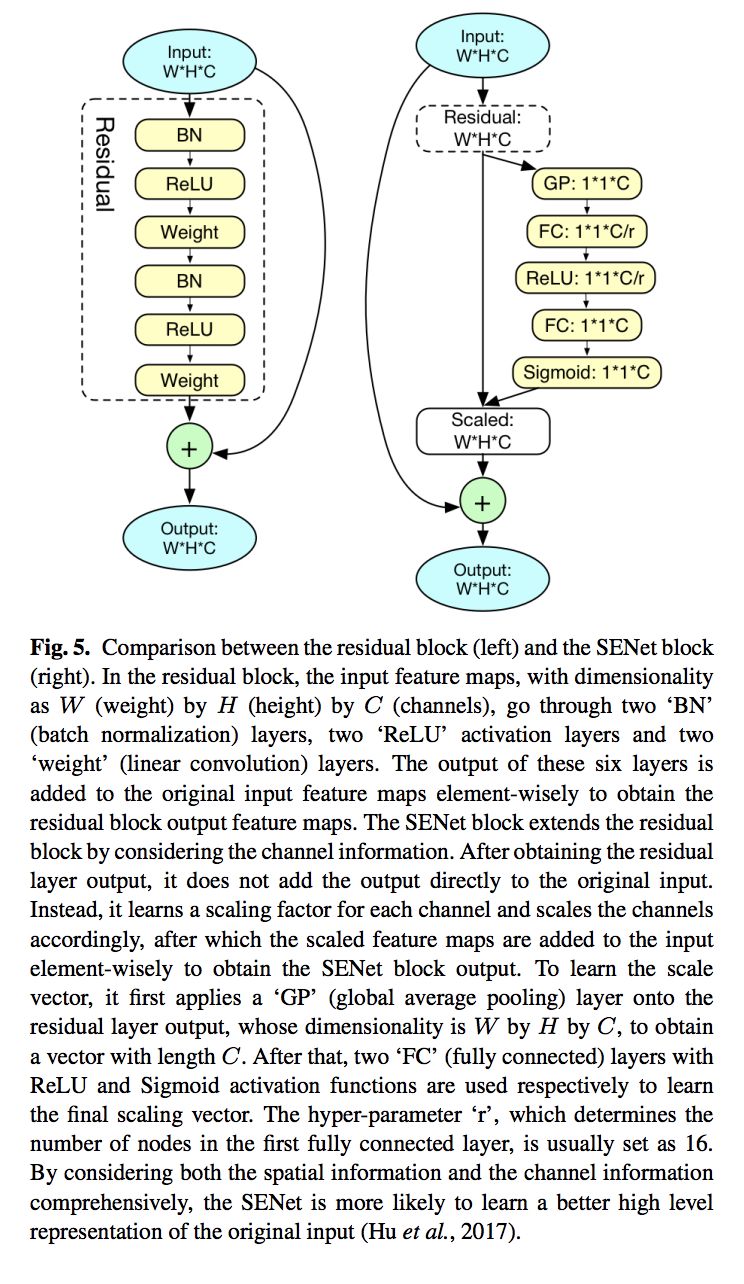

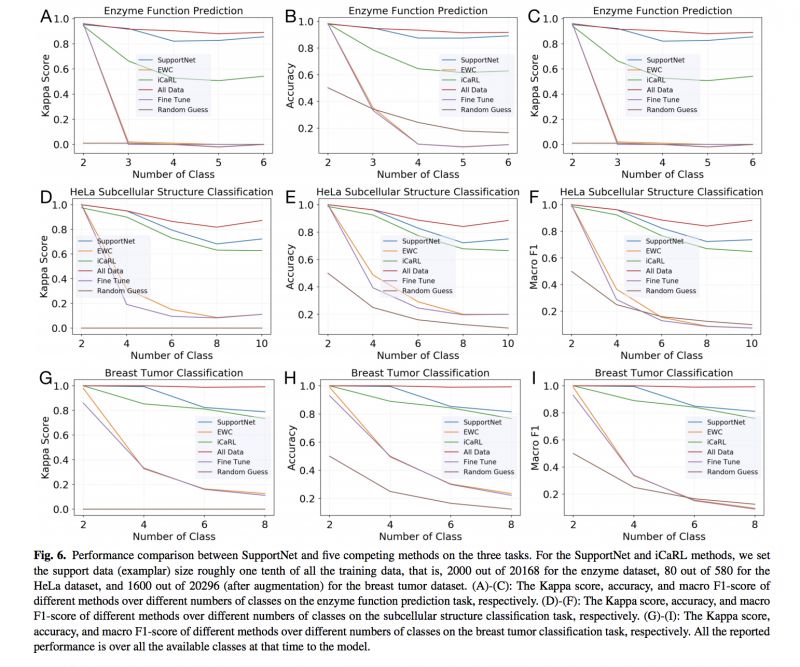

本文提出了一个非常简单实用有效的方法,将深度学习和 SVM 结合解决了使用深度学习进行 class incremental learning 时会遇到的 catastrophic forgetting 的问题。

在使用深度学习时,我们经常遇到这样一个场景(尤其是长时间,大数据量的 project):在使用已有的数据训练好一个深度学习模型之后,又来了一批新的数据,而这批新数据的 class 是原有数据没有的 class,我们需要使模型变得也有能力去预测新的 class,这就是 class incremental learning。

使用所有的数据从头训练一个全新的模型太过费时费力。但如果只用新数据去 fine-tune 以前的模型就会出现这个模型把所有的 test 数据(甚至包括以前的训练数据)都预测成新 class 的情况,就好像这个模型忘记了我们曾经使用过老数据对它进行训练一样,这个现象被形象地称为 catastrophic forgetting。这个问题非常有意思,除了和人工智能有关,它还有一些脑神经科学以及认知心理学的背景,详细介绍请参见原文。

这两年有很多关于这个方向的研究。其中最有名的是 EWC 和 iCaRL。虽然 EWC 在 sequential tasks 上 performance 很好,但是在 class incremental learning 上的 performance 有时甚至比 random guess 还要差。iCaRL 虽然有着 state-of-the-art 的 performance,但是比最优 performance(从头训练一个全新的 model 的 performance),有时能差 30 到 40 个百分点。

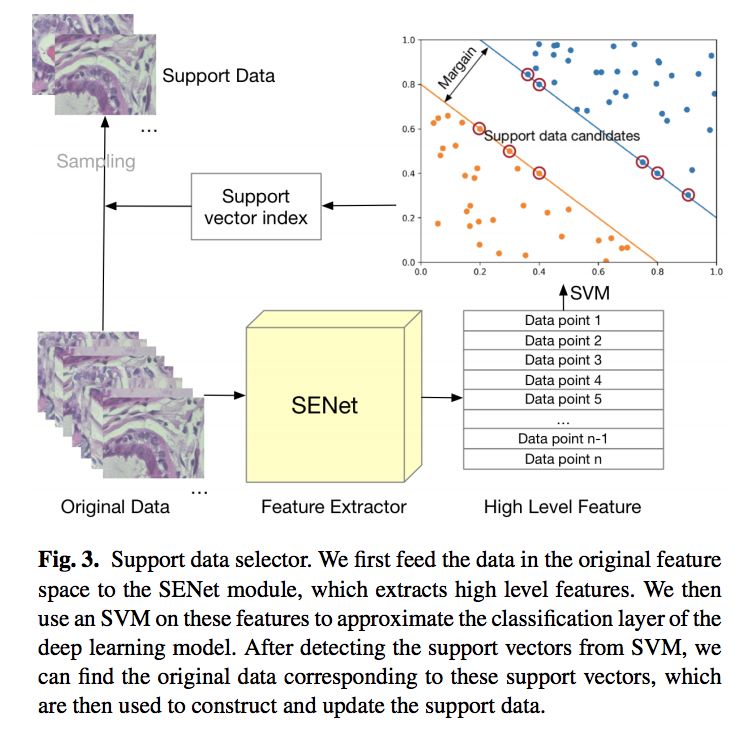

本文的方法将深度学习和 SVM 结合起来,取了两种算法的长处。在训练完一个深度学习 model 之后,SupportNet 会使用 SVM 去 approximate 深度学习模型的最后一层。根据 SVM 模型的 support vector 信息,SupportNet 能够得到所要保留的 support data。在新数据来的时候,这些 support data 以及新数据会被用来 fine-tune 之前的模型。

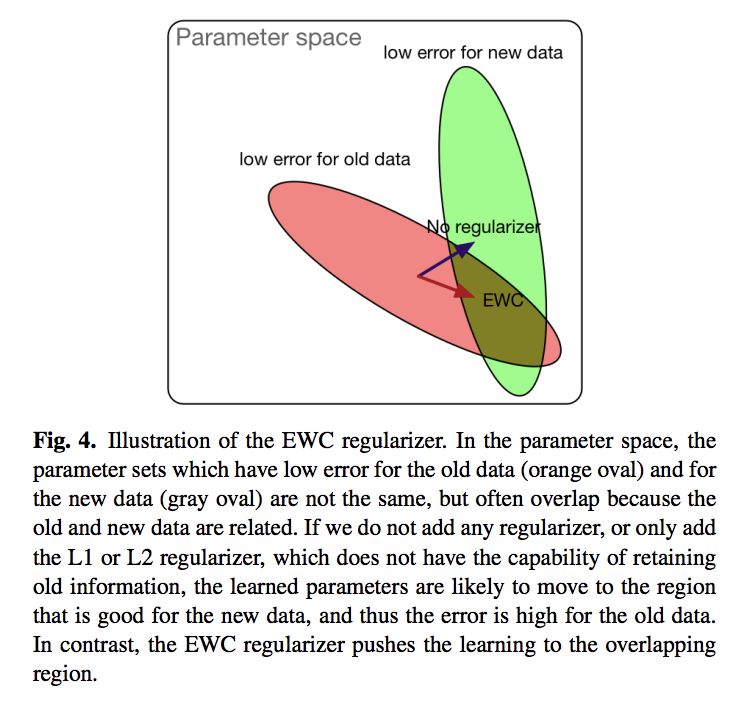

除了使用了这个方法,SupportNet 还使用了两个非常有效的 regularizer,EWC regularizer 和 feature regularizer,来稳定深度学习模型。文章用大量的实验证明了该方法的 performance。

值得注意的是,SupportNet 不仅比 iCaRL 的 performance 要好很多,它在一个数据集上的 performance 甚至接近最优 performance。文章还对各个参数以及方法为什么会 work 进行了详细分析。

▲ 论文模型:点击查看大图

@zuri 推荐

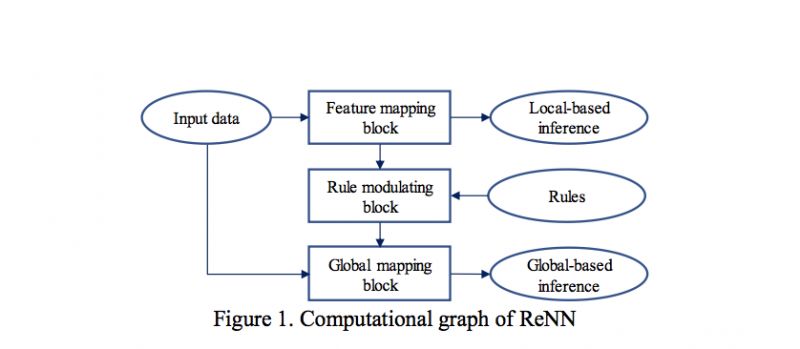

#Rule Embedding

本文基于先验知识与深度学习结合的思想提出了规则嵌入式神经网络,将专家知识以规则的形式嵌入到 ANN 中,借鉴“知识+经验”的人类智能的处理方式。知识的引入提高了 ANN 的性能,降低了 model 的复杂度,即使小样本数据量也能训练出很好的模型,可能也是深度学习走向 StrongAI 的关键。

▲ 论文模型:点击查看大图

@Rcypw 推荐

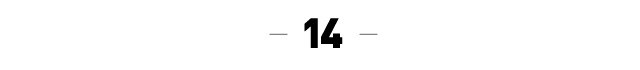

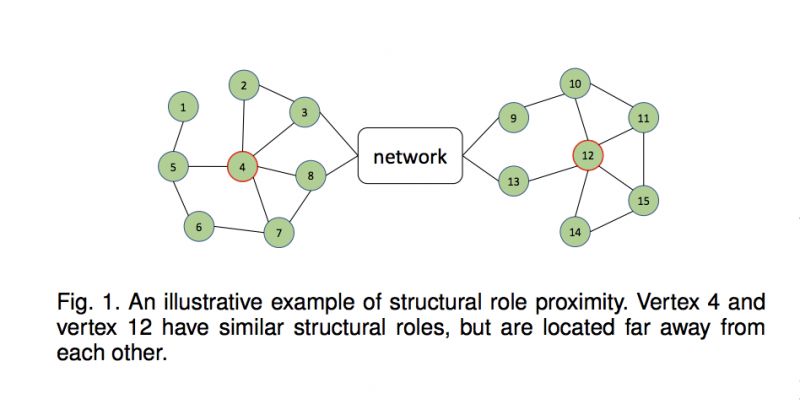

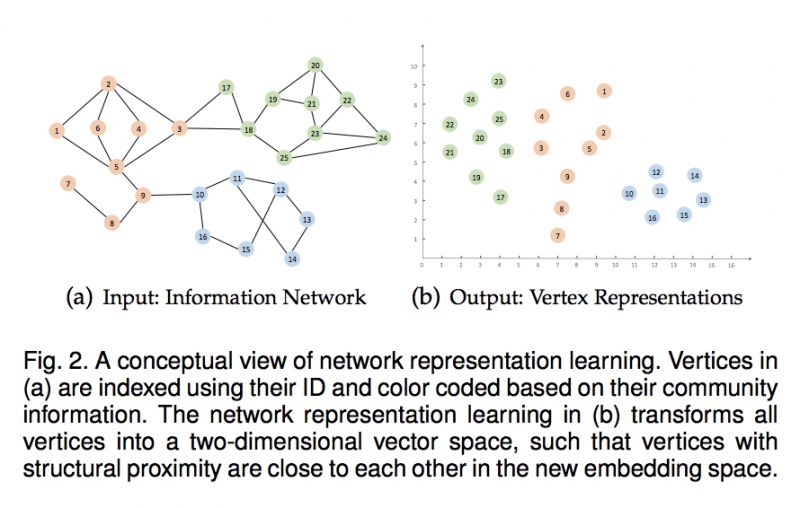

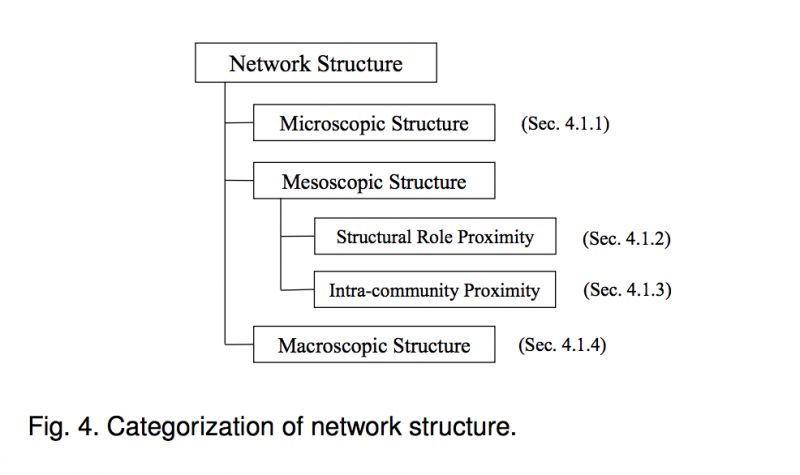

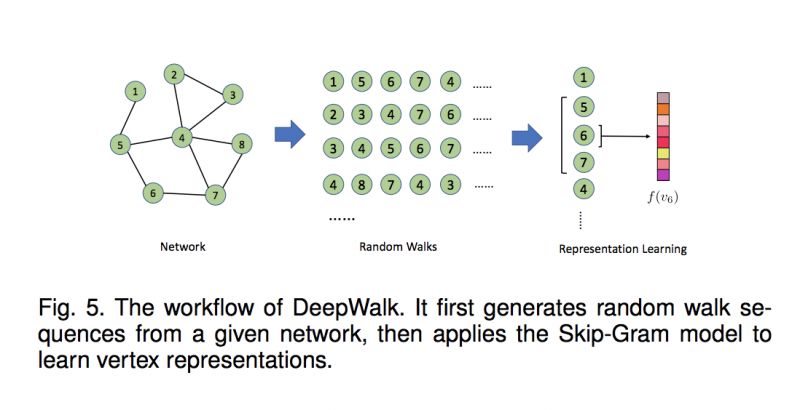

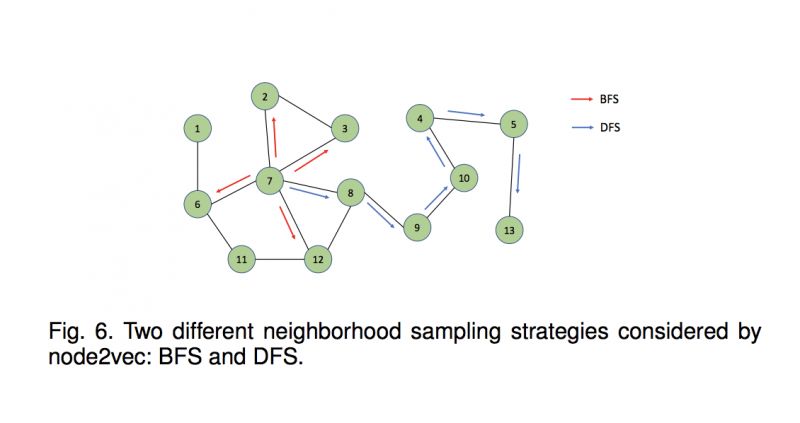

#Network Representation Learning

本文是一篇网络表示学习综述文章,论文总结了今年关于 NRL/GRL 的相关工作,研究充分,总结、归纳很详细,对 NRL/GRL 研究具有指导意义。

▲ 论文模型:点击查看大图

@loyalfei 推荐

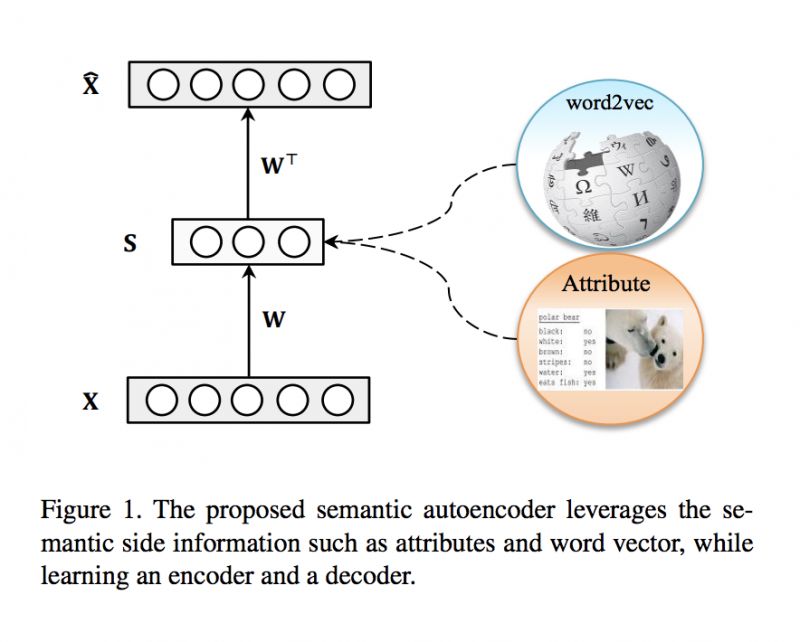

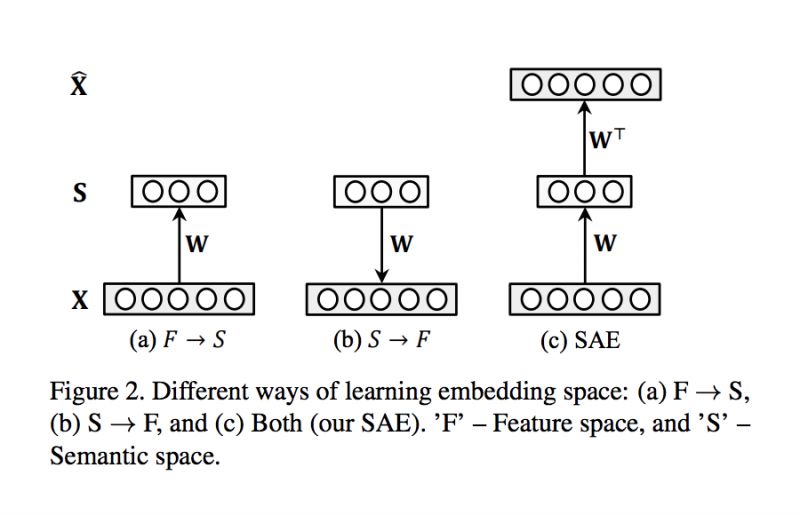

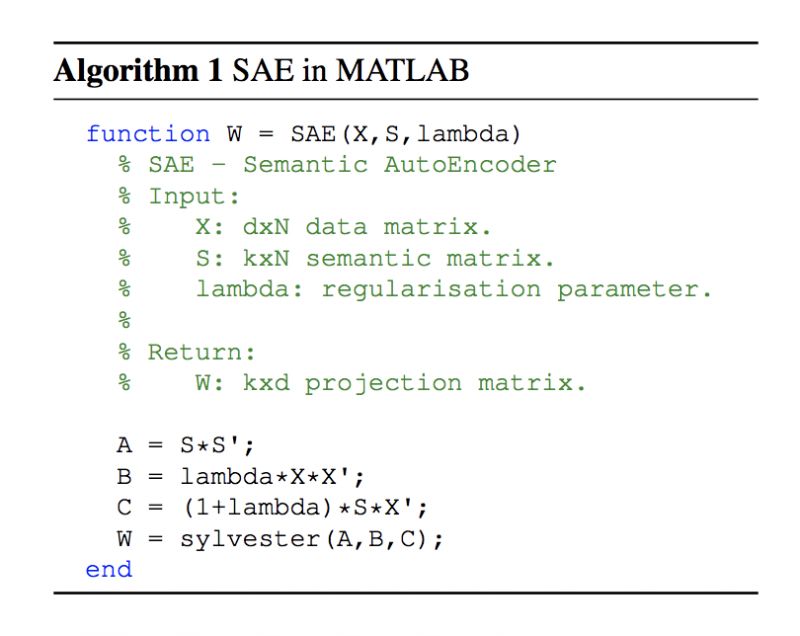

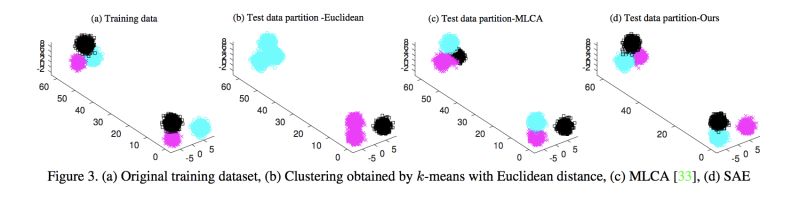

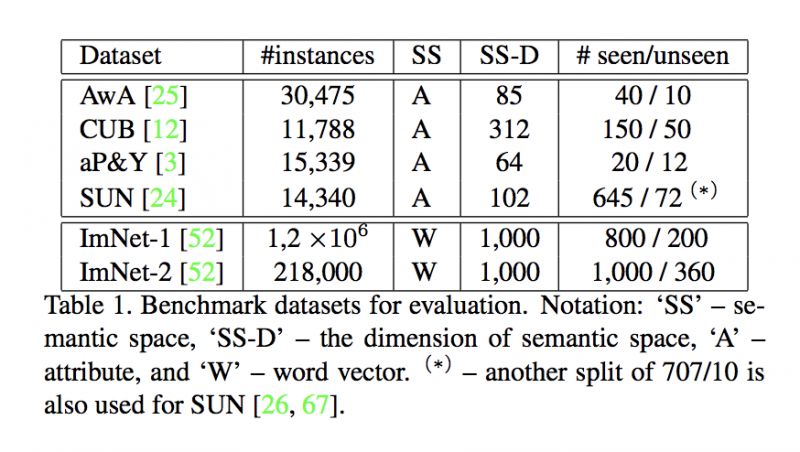

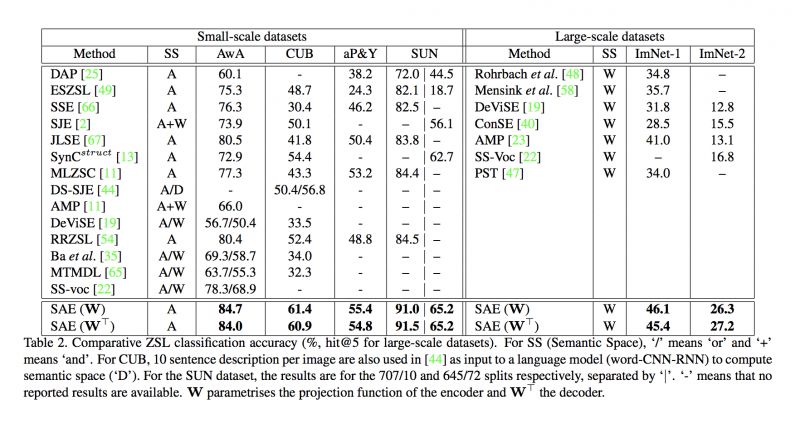

#Zero-Shot Learning

本文是伦敦大学玛丽皇后学院发表于 CVPR 2017 的工作,论文引入语义信息,提出一种新的语义自编码器结构,实现 zero-shot learning 的工作,解决了训练集和测试集的领域漂移(domain shift)问题。算法的自编码器在进行编码和解码时,使用了原始数据作为约束,即编码后的数据能够尽可能恢复为原来的数据。

▲ 论文模型:点击查看大图

本期所有入选论文的推荐人

均将获得PaperWeekly纪念周边一份

▲ 深度学习主题行李牌/卡套 + 防水贴纸

礼物领取方式

推荐人请根据论文详情页底部留言

添加小助手领取礼物

想要赢取以上周边好礼?

点击阅读原文即刻加入社区吧!

点击以下标题查看往期推荐:

AI活动推荐

中国人工智能大会 CCAI 2018

AI领域规格最高、规模最大

影响力最强的专业会议之一

热点话题√核心技术√科学问题√

活动时间

2018年7月28日-29日

中国·深圳

长按识别二维码,查看大会简介

▼

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 加入社区刷论文