还在为周会发愁?你需要这13篇最新论文 | 本周值得读

在碎片化阅读充斥眼球的时代,越来越少的人会去关注每篇论文背后的探索和思考。

在这个栏目里,你会快速 get 每篇精选论文的亮点和痛点,时刻紧跟 AI 前沿成果。

点击本文底部的「阅读原文」即刻加入社区,查看更多最新论文推荐。

@shaness 推荐

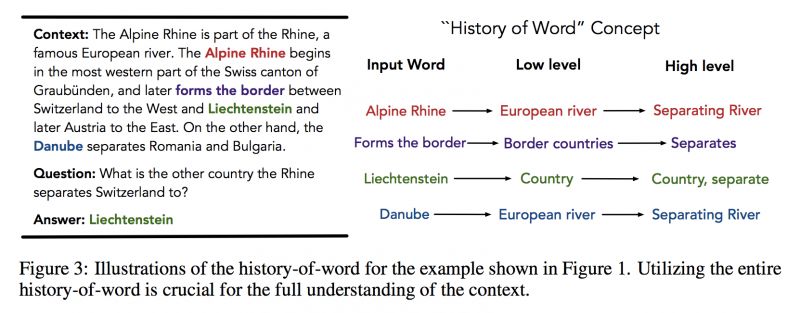

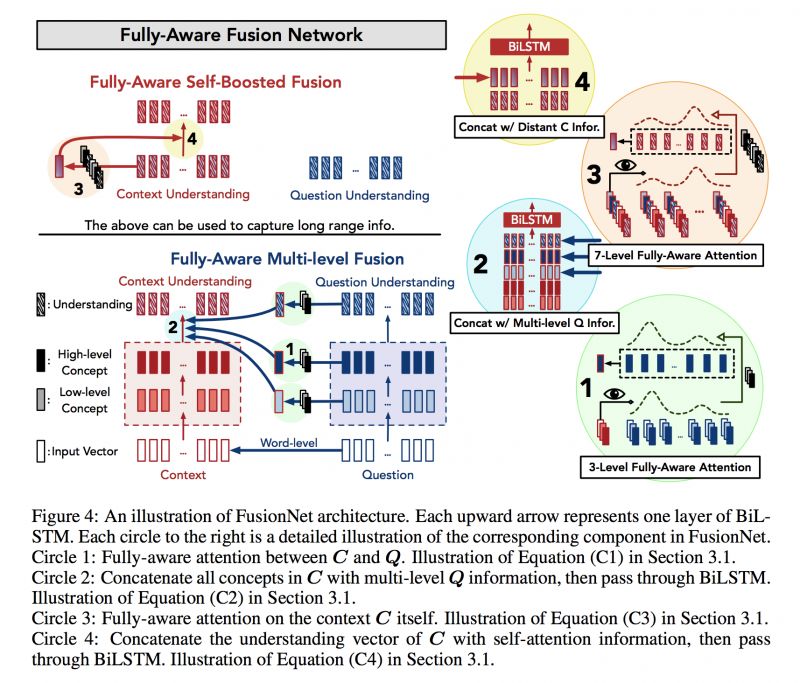

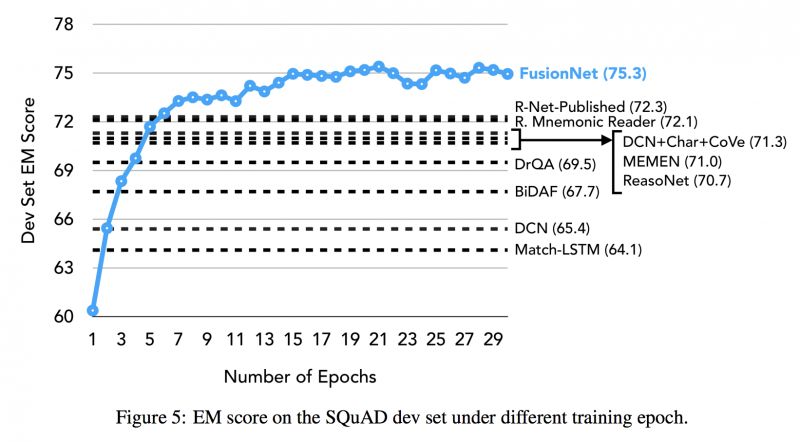

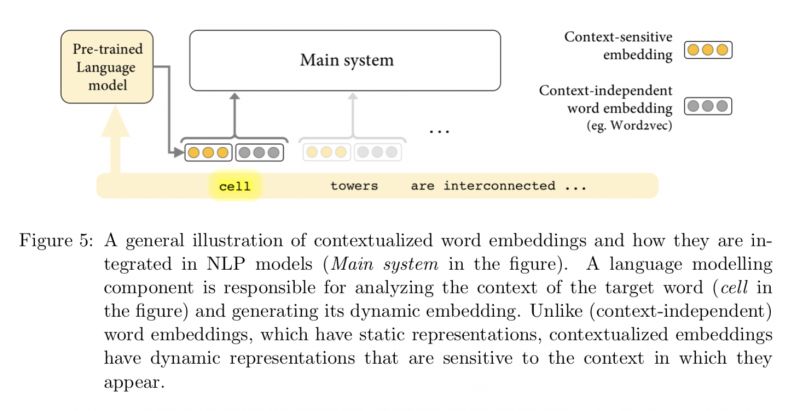

#Attention Mechanism

本文是微软和台湾大学发表于 ICLR 2018 的工作,论文最大的价值是融合了当前主流的 Attention 模型的各个层次表示,并且一一作了介绍,可以通过本文了解当前主流 Attention 模型所用到的信息都是怎么得到的。文章使用了 GloVe 表示单词,CoVe 表示上下文。

▲ 论文模型:点击查看大图

@qqfly1to19 推荐

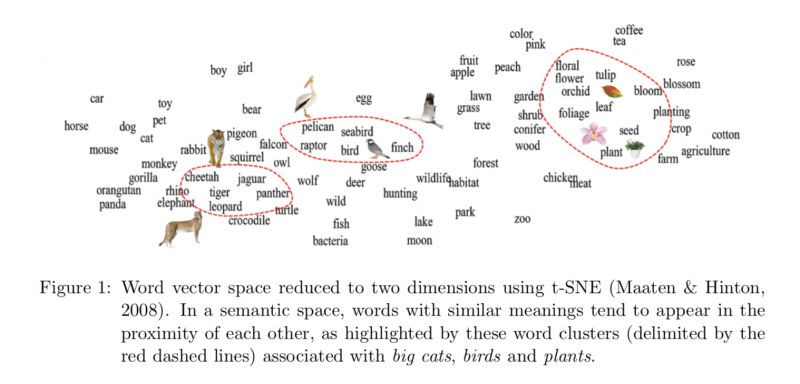

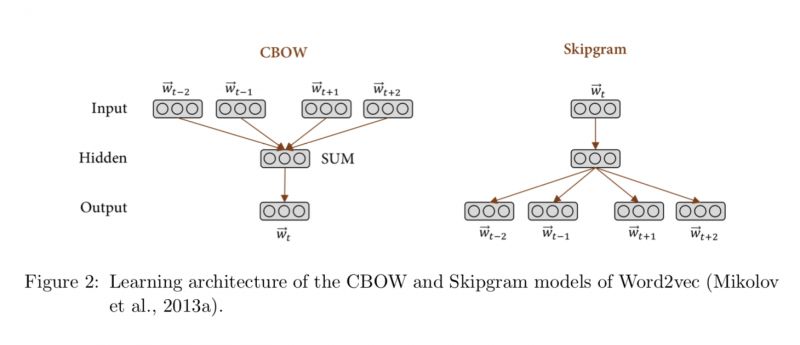

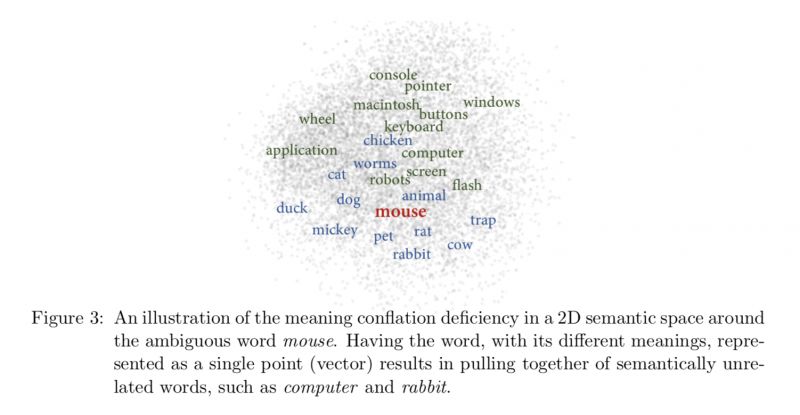

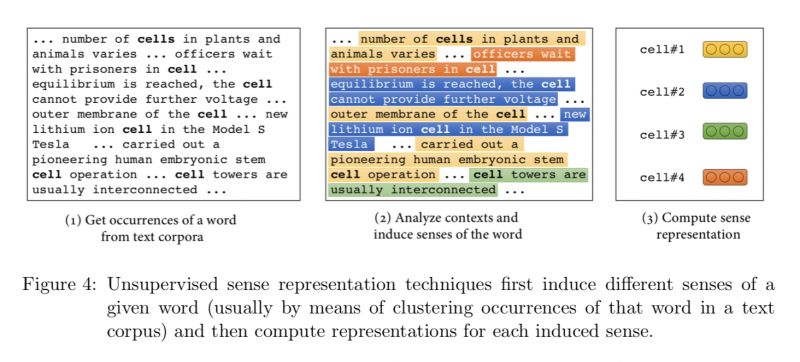

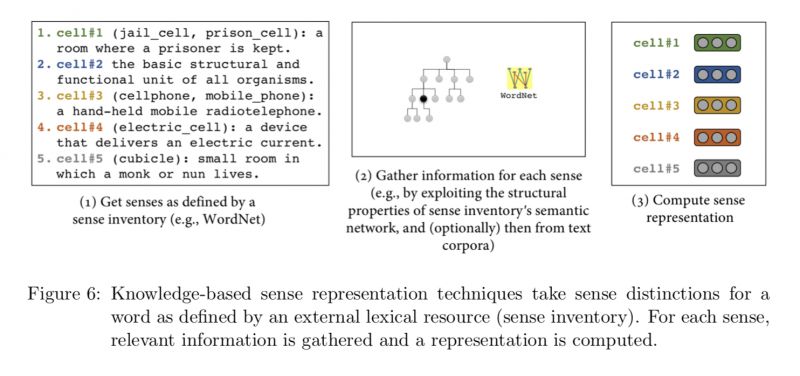

#Word Embedding

众所周知,Word Embedding 这种从语言结构中学习出来的低维表示存在着很多问题,诸如将原本的多义词 Embedding 进了一个向量里,具有相同语言结构的 Word(如反义词)具有相近的向量,这些问题在实际的工程领域往往是致命的。本篇长文总共 40 页,篇幅较长。主要是从 Word Embedding 的工作出发去讲Sense Embedding,内容很厚,建议好好阅读。

▲ 论文模型:点击查看大图

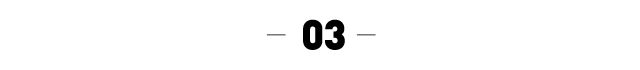

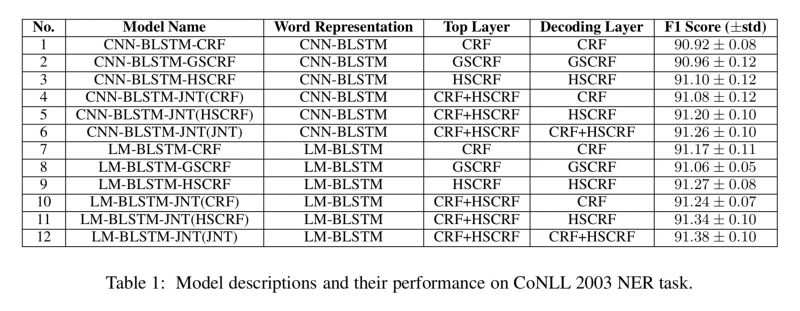

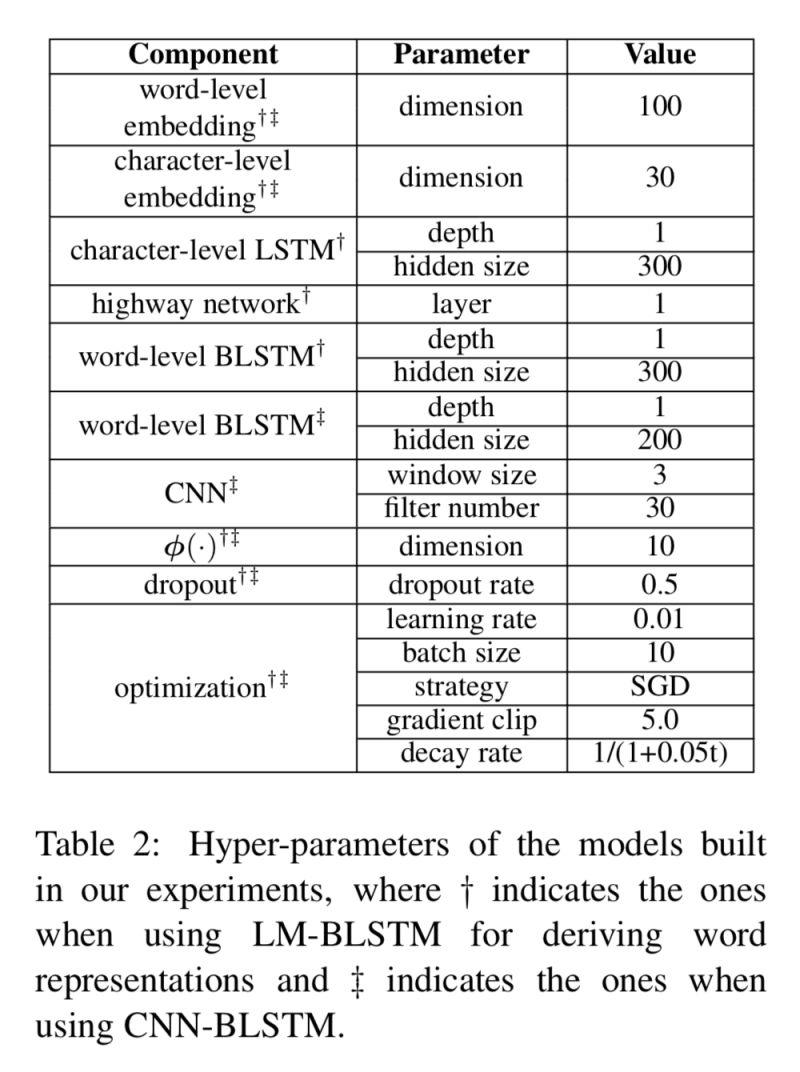

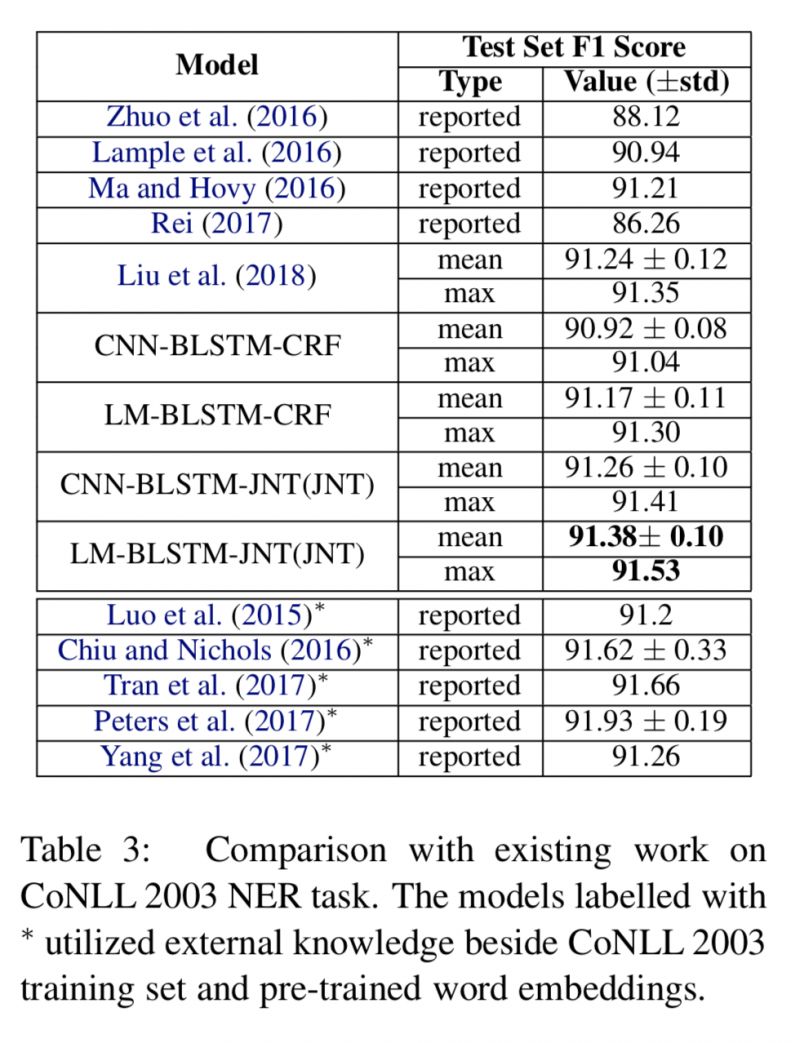

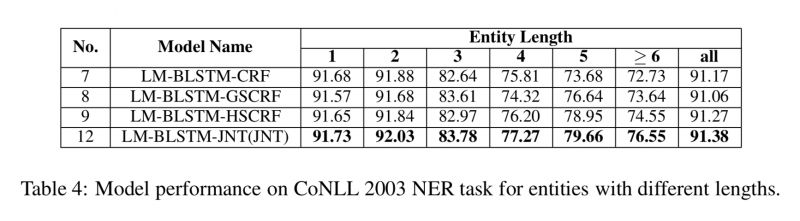

Hybrid semi-Markov CRF for Neural Sequence Labeling

@zxye 推荐

#CRF

本文是中科大发表于 ACL 2018 的工作,这篇文章联合使用 CRF 和改进的 Semi-CRF 在 CoNLL 2003 命名实体识别任务上达到了 state-of-the-art 的性能。

▲ 论文模型:点击查看大图

@guxd 推荐

#Dialog Systems

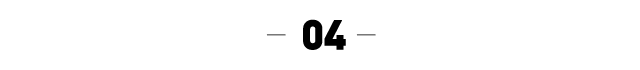

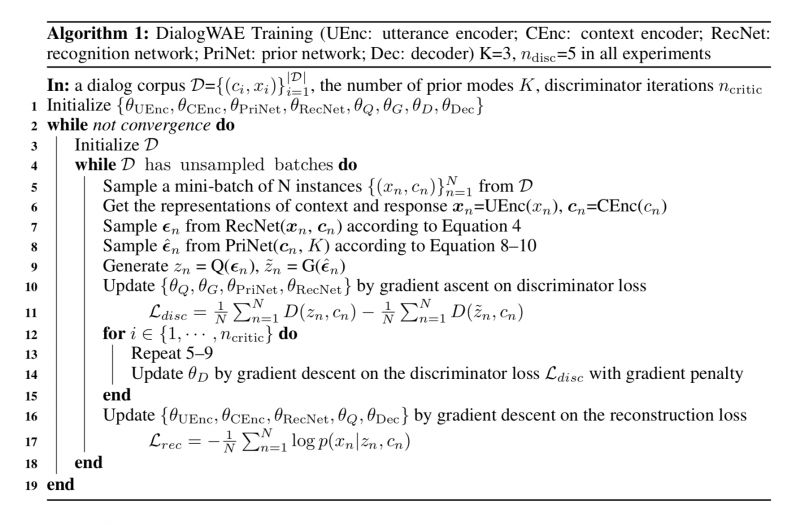

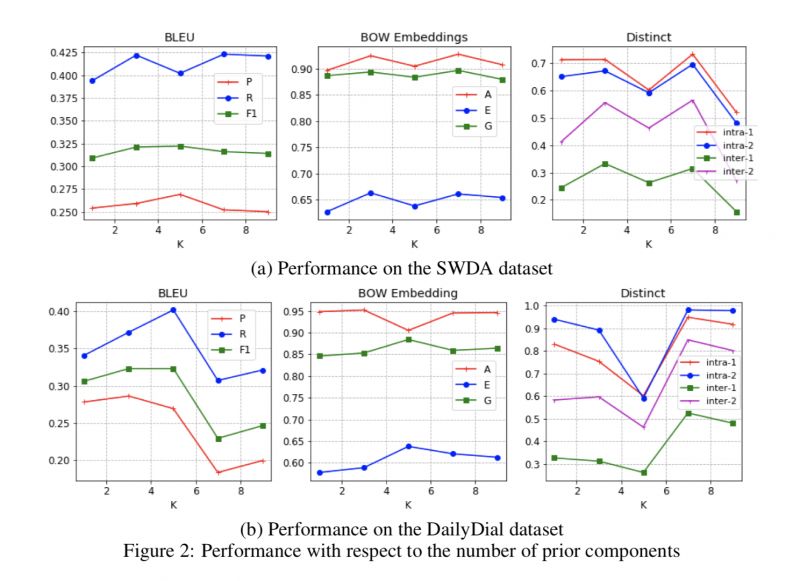

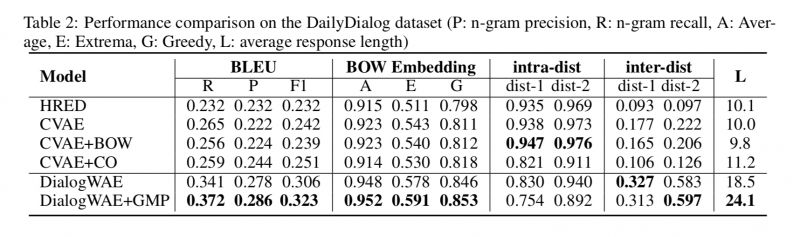

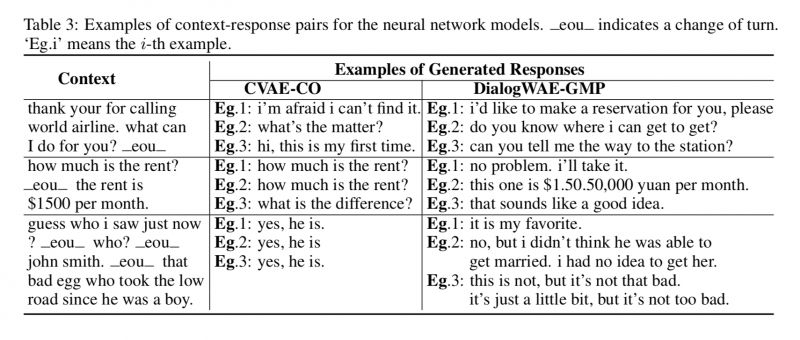

现有的对话模型通常采用变分自编码器(VAE)实现多样化的应答生成,然而VAE模型假定对话的隐变量服从简单的高斯分布,从而限制了应答的范围(比如单模态应答)。

本文提出一种基于 Wasserstein 自编码器的应答生成模型,不同于 VAE 模型的单一高斯先验假设,本文通过在隐变量上进行 GAN 训练,实现对真实数据分布的拟合。同时引入高斯混合先验网络实现多模态回答生成。实验结果表明采用高斯混合先验的 GAN 模型在产生更连贯,信息丰富和多样化的回应方面优于现有技术。

▲ 论文模型:点击查看大图

@paperweekly 推荐

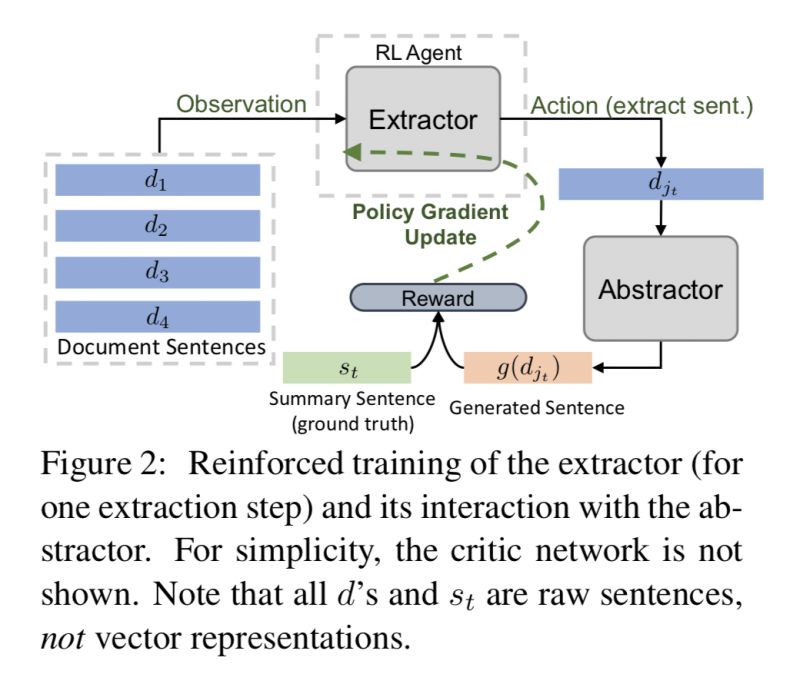

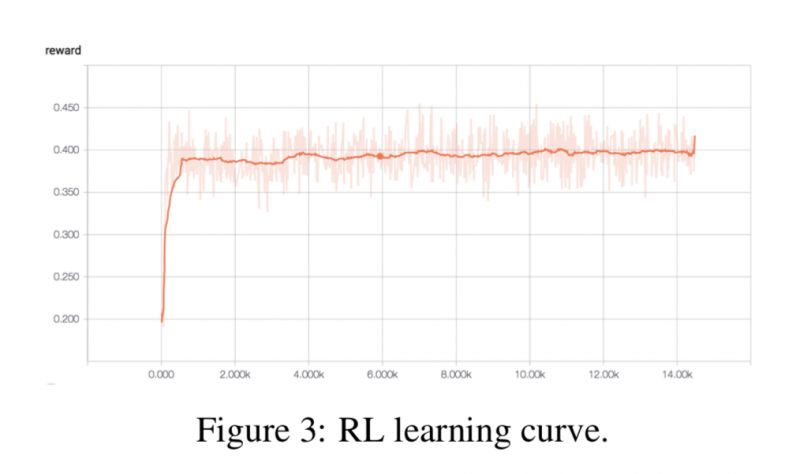

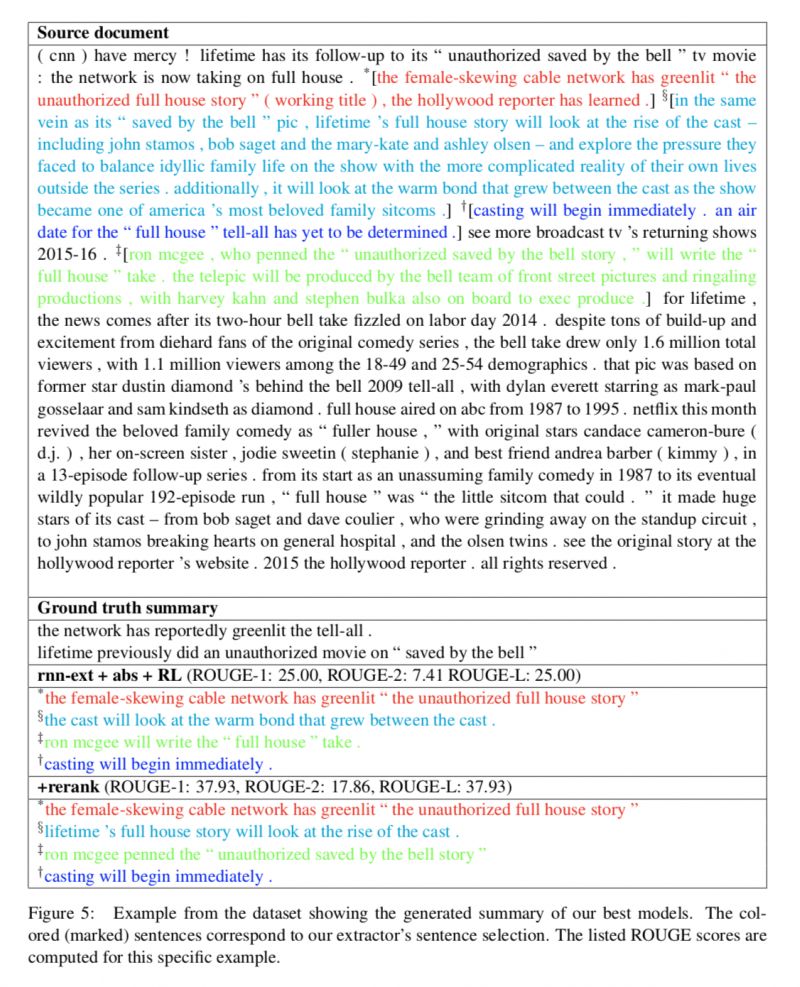

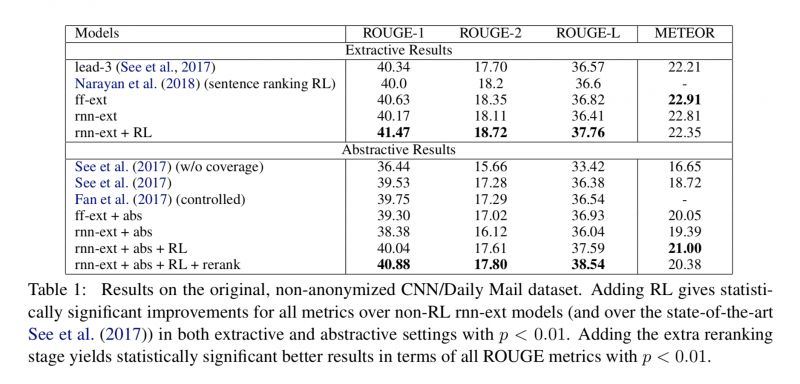

#Abstractive Summarization

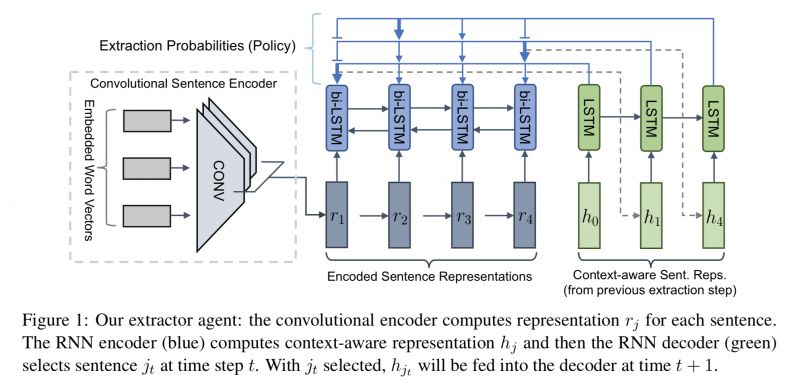

本文是 UNC Chapel Hill 发表于 ACL 2018 的工作,论文提出了新颖的基于强化学习的句子级的文本摘要生成模型,达到了 state-of-art 效果。

通过先抽取在生成的方式,加快了训练和测试解码速度,同时引入强化学习将抽取和生成巧妙联合起来,构成了一个整体的端到端模型而不是一个 pipeline 系统。

▲ 论文模型:点击查看大图

@paperweekly 推荐

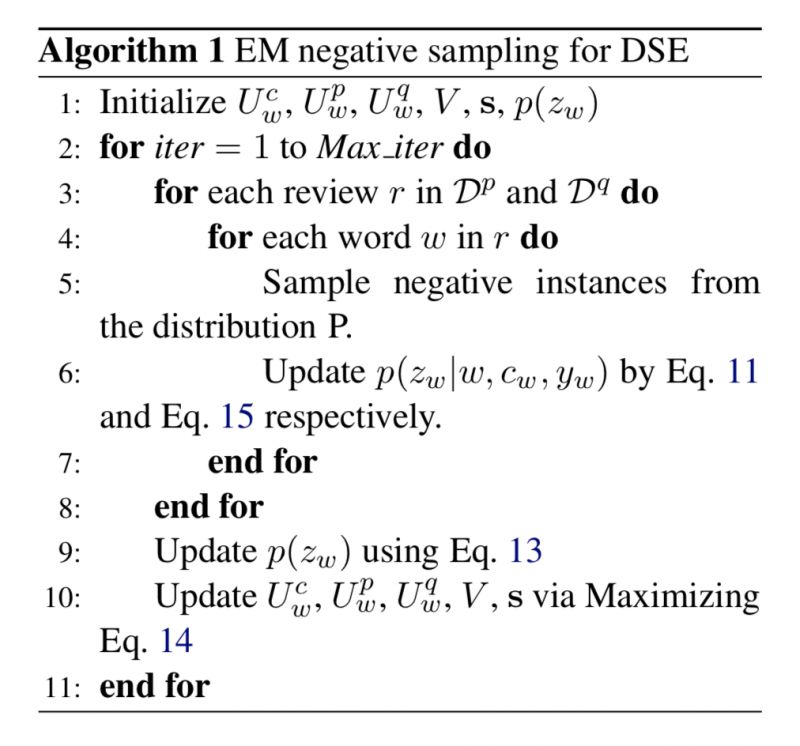

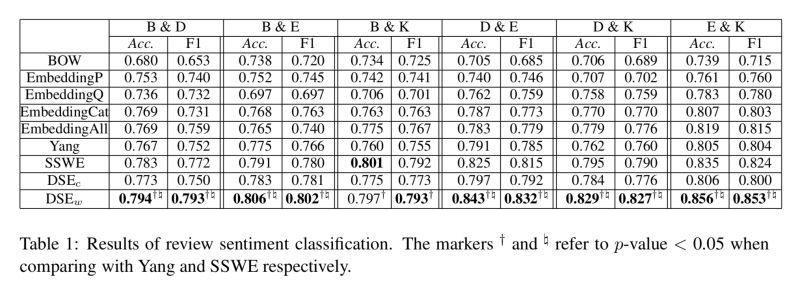

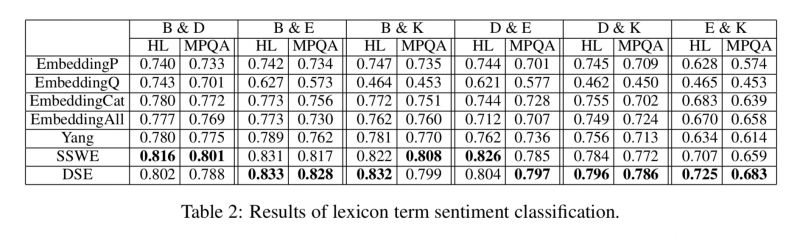

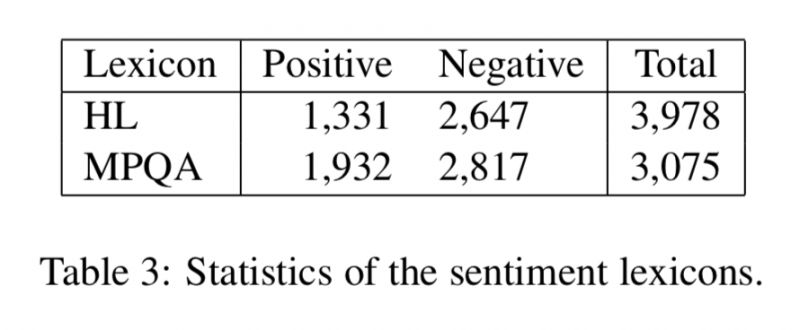

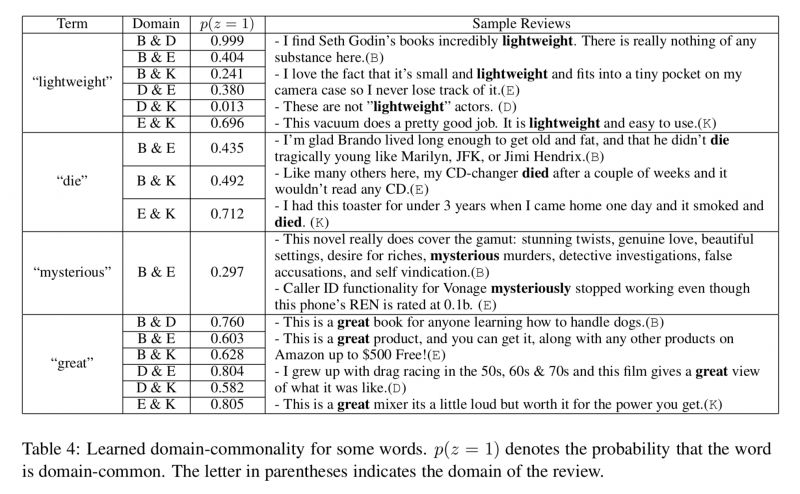

#Word Embeddings

本文是香港中文大学与 Tencent AI Lab 联合发表于 ACL 2018 的工作。论文提出了一种学习领域适应和情感感知的词嵌入的新方法,能够同时捕获词的情感语义和领域信息。

与已有方法不同的是,该方法利用评论中的情感信息和上下文信息来自动确定和生成领域无关的词向量和领域相关的词向量,从而利用来自于多个领域的共同情感词的信息,并且同时捕获来自不同领域的领域相关词的不同语义。

实验结果表明,该方法能够更好的学习多领域情况下的情感词表示,提高了句子层面和词汇层面的情感分类任务的性能。

▲ 论文模型:点击查看大图

@shaness 推荐

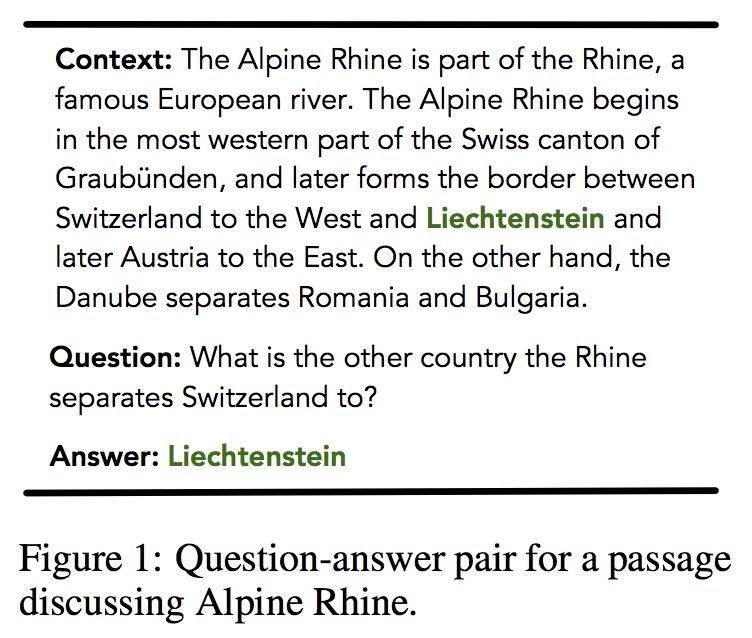

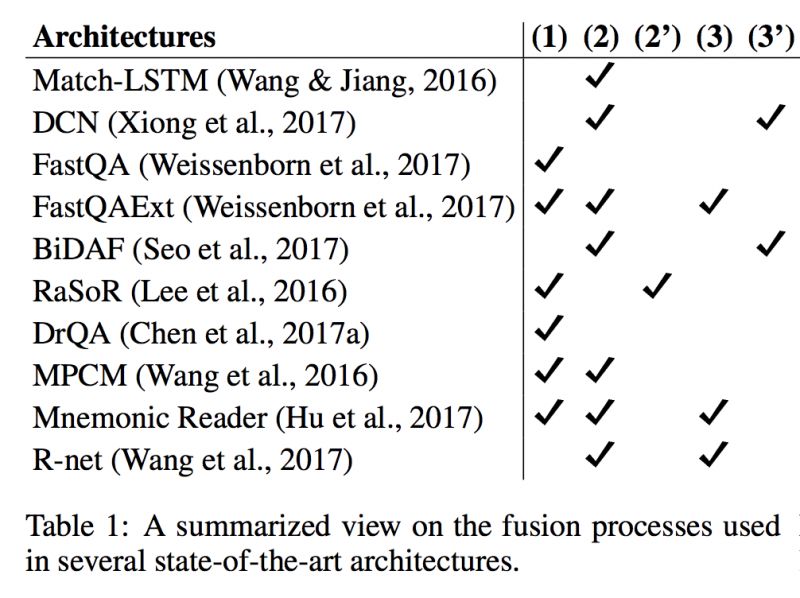

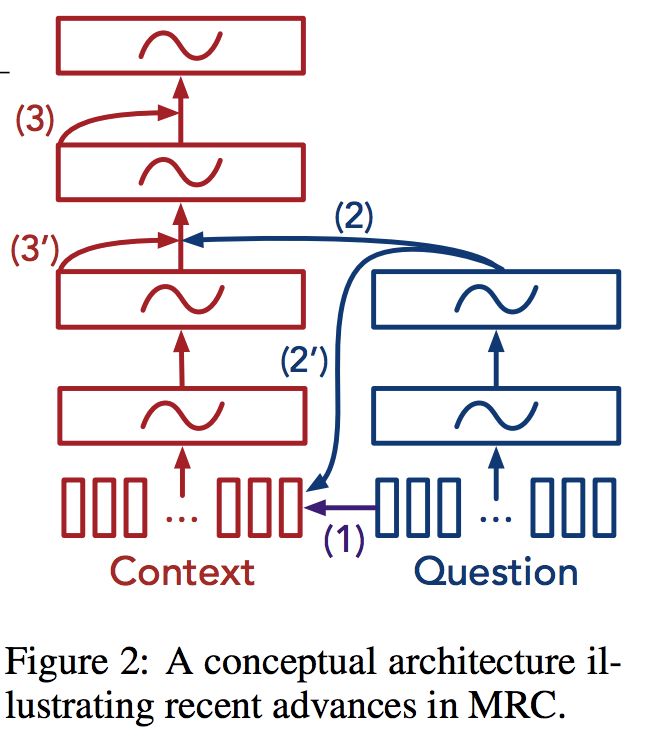

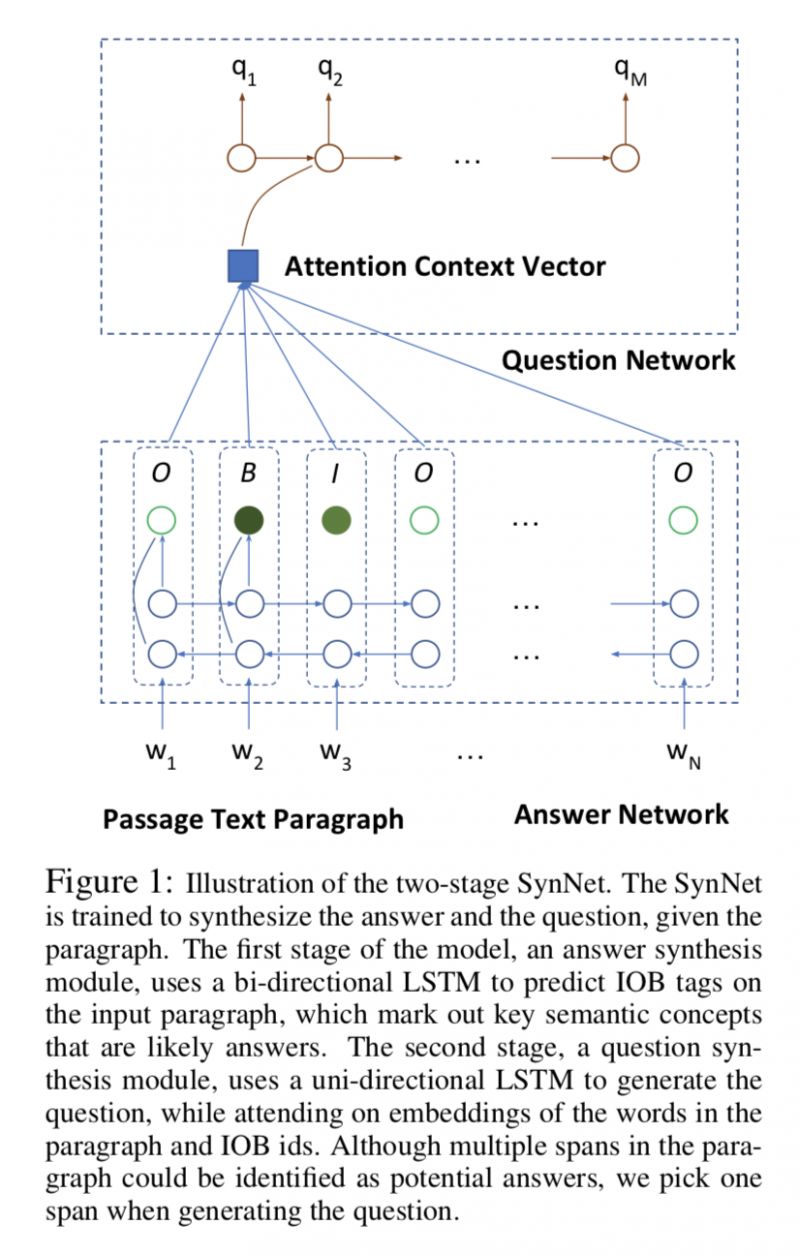

#Machine Comprehension

机器阅读理解在最近的文章中,主要是针对特定数据集上的表现做模型改进。而微软的这篇文章更加贴近现实问题:如何让机器自己从一个数据集上通过监督学习生成答案和生成问题的能力,然后无监督地应用在其他的 domain 里面,对缺少标注数据的 MRC 问题提出了迁移学习的解决思路。

本文思路分两步合成,先根据 paragraph(后简称 p)生成答案(后简称 a),然后根据 p 和 a 生成 quenstion。

▲ 论文模型:点击查看大图

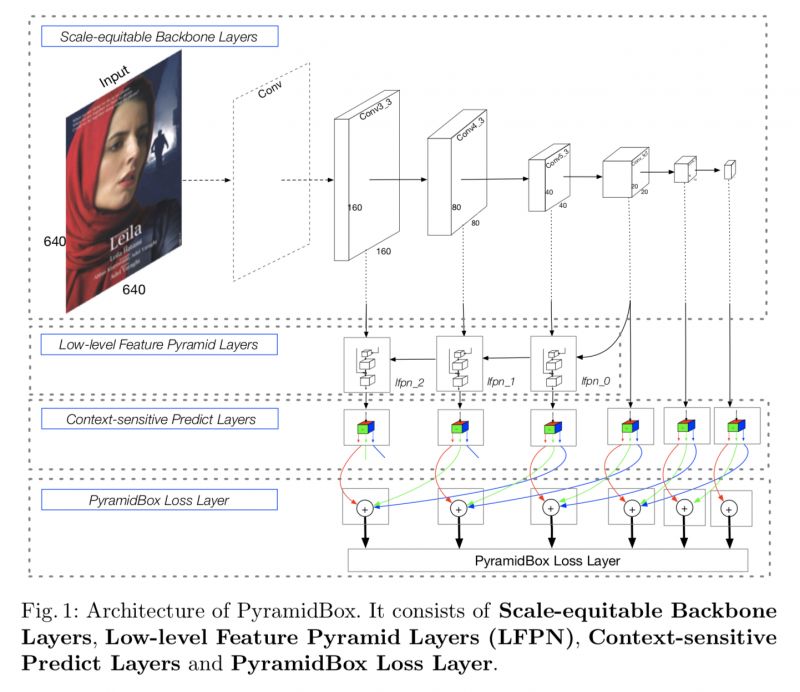

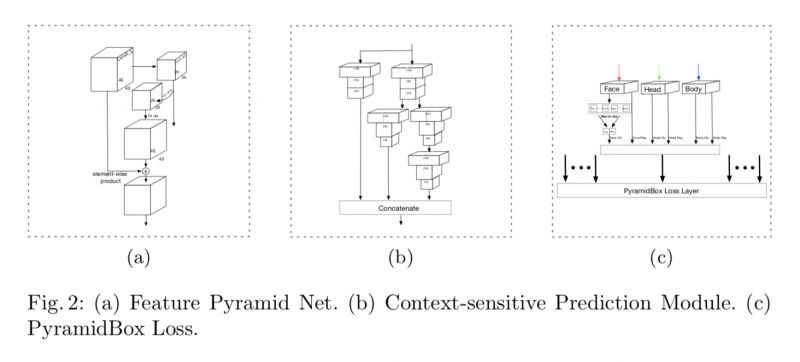

@yinnxinn 推荐

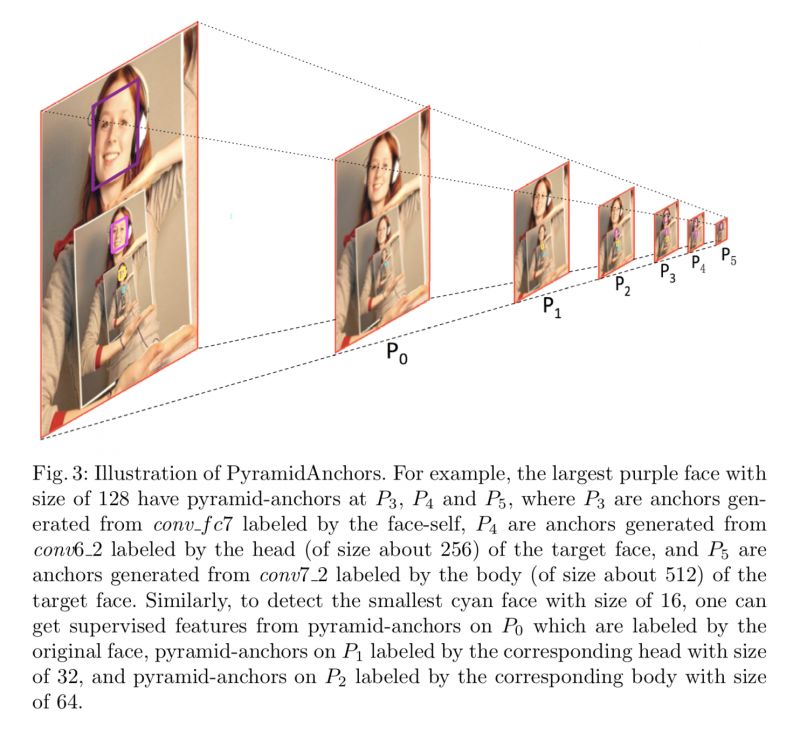

#Face Detection

本文来自百度,论文达到了超级好的人脸检测效果。从工程角度将 FPN,RCNN,anchor 等多种结构的优势结合起来。论文将 FPN 和 S^3^FD 的优势结合起来,主干框架采取 VGG16 进行特征提取,在 conv3_3,conv4_3,conv5_3 层使用 FPN 构建 branch 对底层 feature 的背景信息进行保留,最后将高低层的信息进行组合得到 predict_layer。

▲ 论文模型:点击查看大图

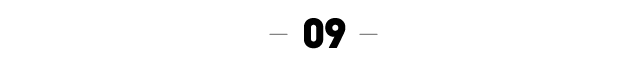

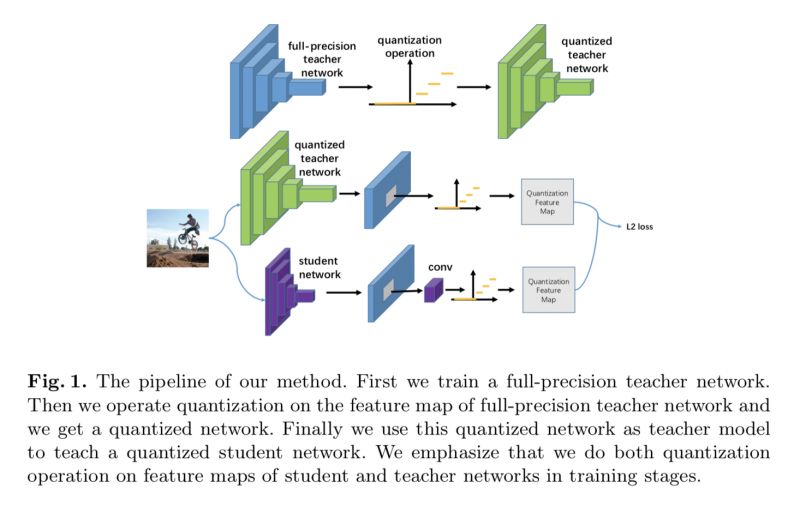

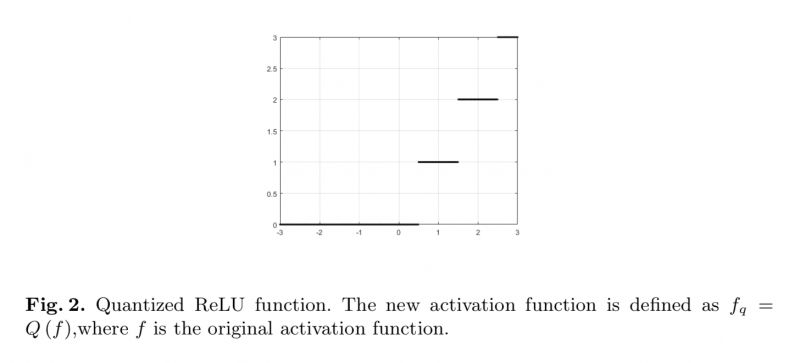

@darksoul 推荐

#Object Detection

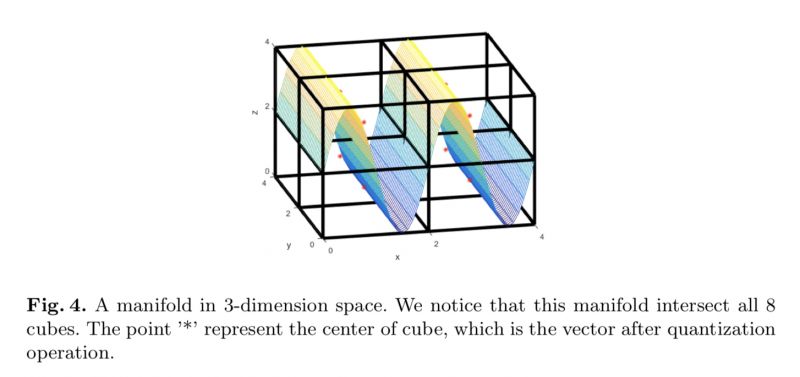

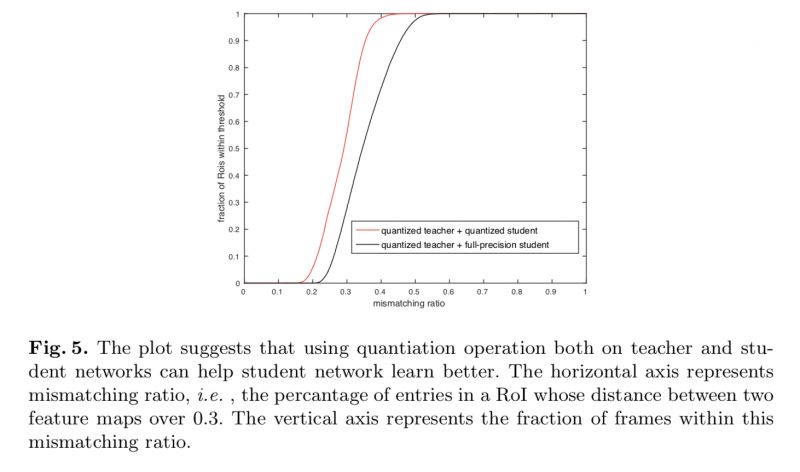

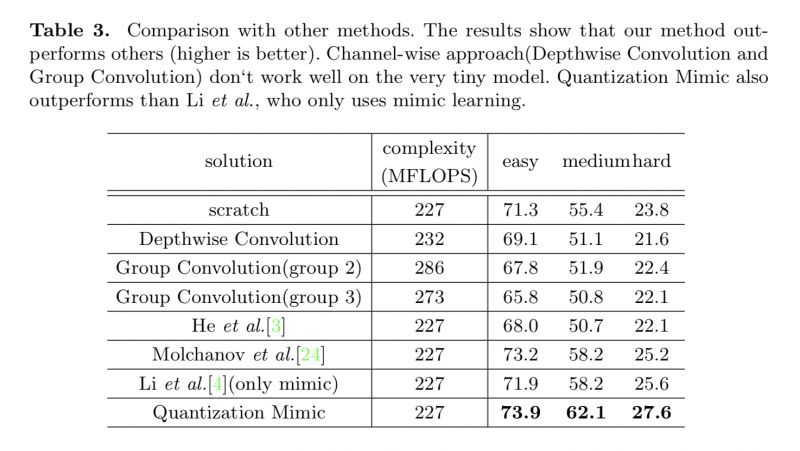

本文来自清华大学和商汤科技,文章使用量化的方法加强 Mimic 的性能,对 Mimic 的方法扩展有新的指导意义。

▲ 论文模型:点击查看大图

@born2 推荐

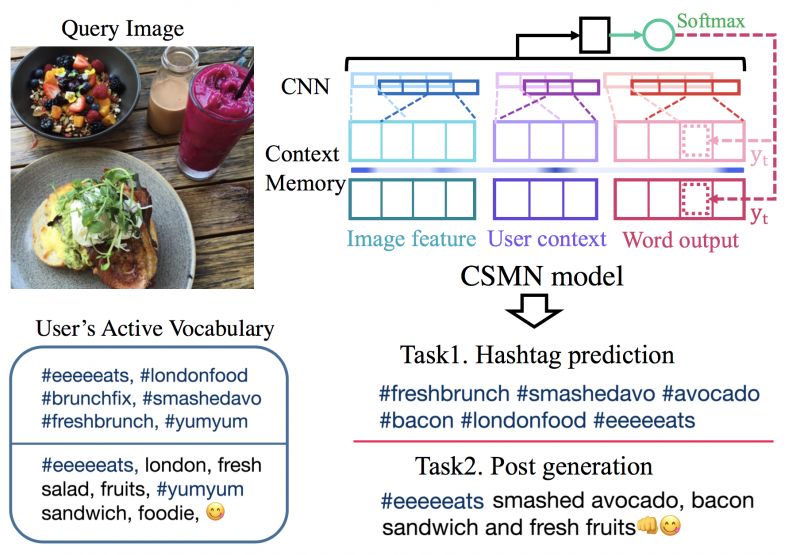

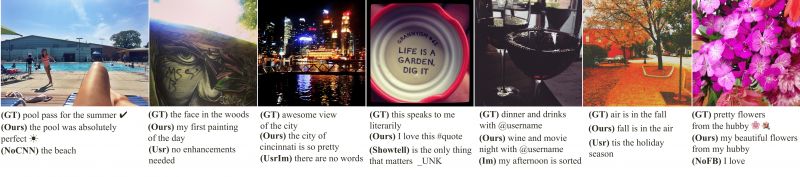

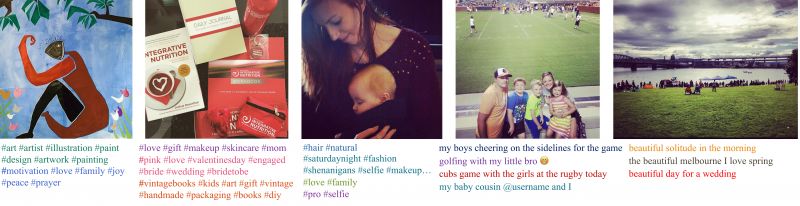

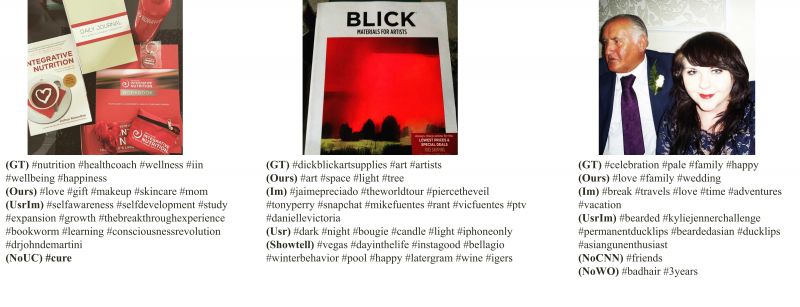

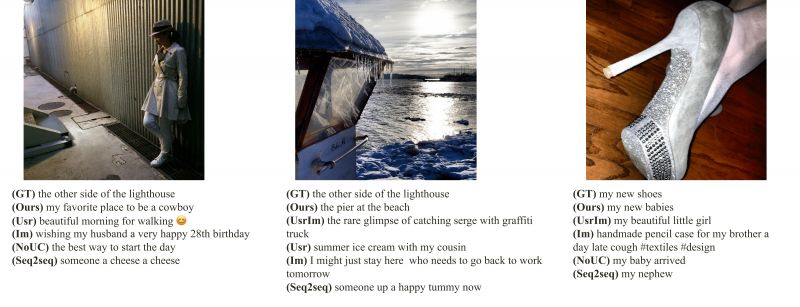

#Image Caption

对于 Image Caption 任务,给出一张图,生成一句话,已经取得了长足的进步。本文提出了 Caption 方向的一个新问题:如何产生个性化的 Caption。因为不同的人对同样的图片会做出不同的描述,其中包含了描述者本身的用词表达习惯等特征,如何针对性的学习某个人的表达式本文提出的新问题。

这个问题很有强的实用价值,我们日常生活中的微信朋友圈,微博等等,图片所配的问题之中,都隐藏着个人平日的用词习惯,如果能够学习到一个相应的模型,那么将会为我们节省大量的时间,我们只需要在机器生成的句子上做简单的修改,甚至不需要修改,就可以直接发布朋友圈。

存在两个问题,首先是数据库的问题,其次就是如何构建一个能够学习这种个性化的模型。

本文构建了一个个性化的 Caption 数据库,并提出了使用记忆网络进行个人习惯用词的提取,利用卷积的方式来获取单词和图像之间的关系,最终取得了很好的效果。

▲ 论文模型:点击查看大图

@DeepTrial 推荐

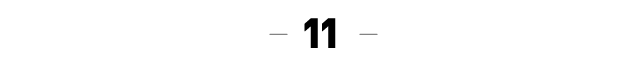

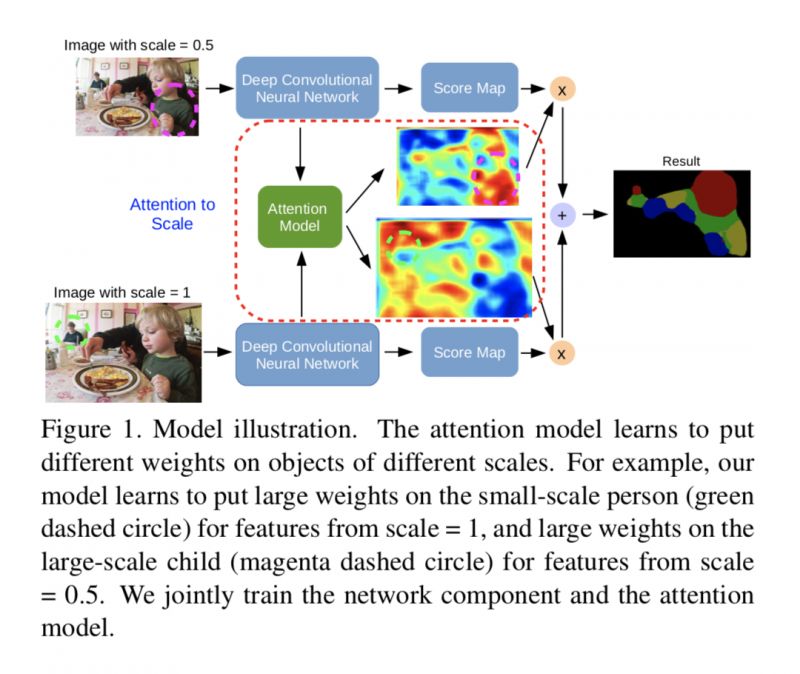

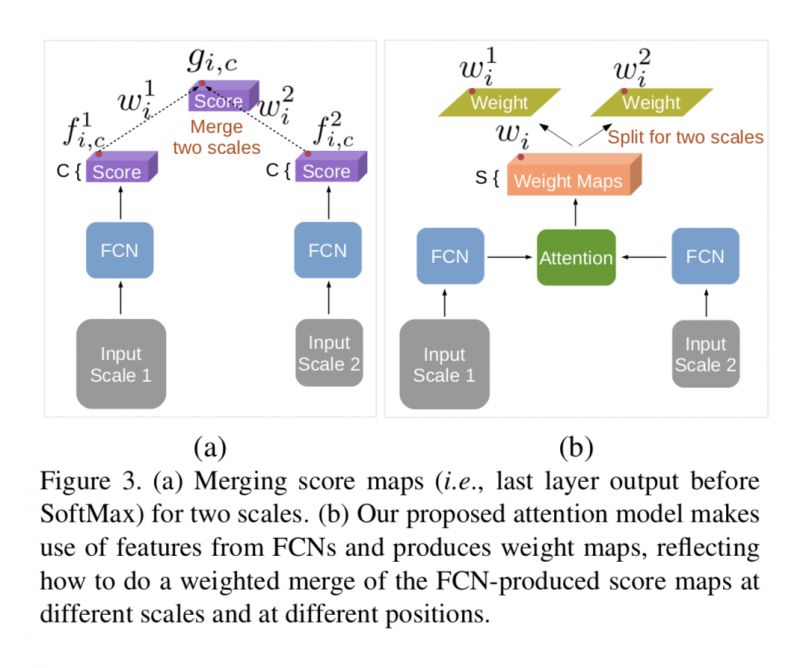

#Image Segmentation

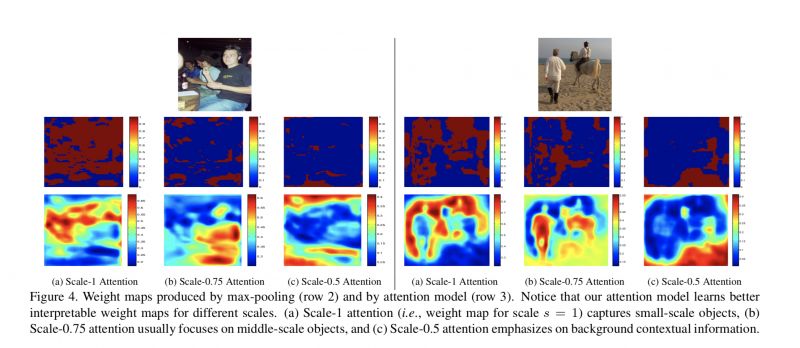

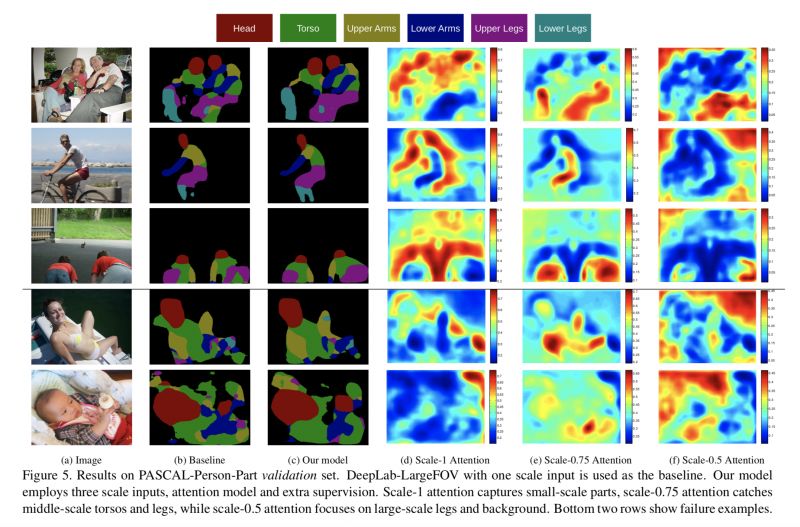

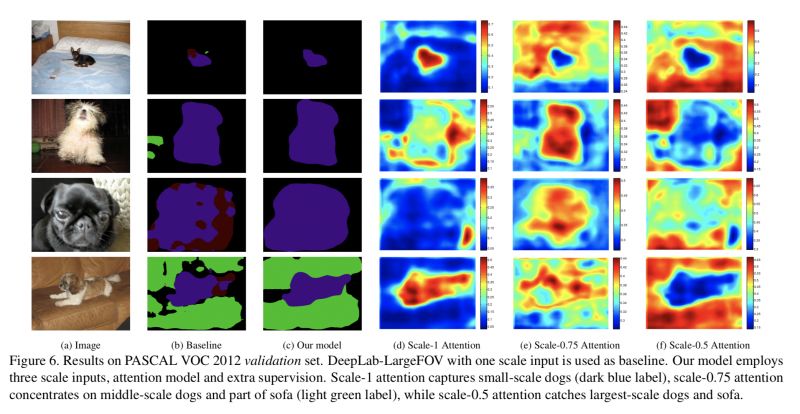

通过对输入图片的尺度进行放缩,构造多尺度。传统的方法是使用 average-pooling 或 max-pooling 对不同尺度的特征进行融合,而本文通过构造 Attention model(由两个卷积层构成)从而自动地去学不同尺度的权重,进行融合(效果提升 1 到 2 个点吧,不同的数据集不一样)。

从论文中的权重可视化的结果,能发现小尺寸输入上,对应网络关注于 small-scale objects,而在大一点的尺寸上,网络就关注于 middle-scale,large-scale 甚至 background contextual information。可视化效果感觉非常有意思。

▲ 论文模型:点击查看大图

@daven88 推荐

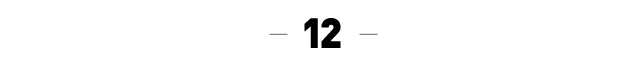

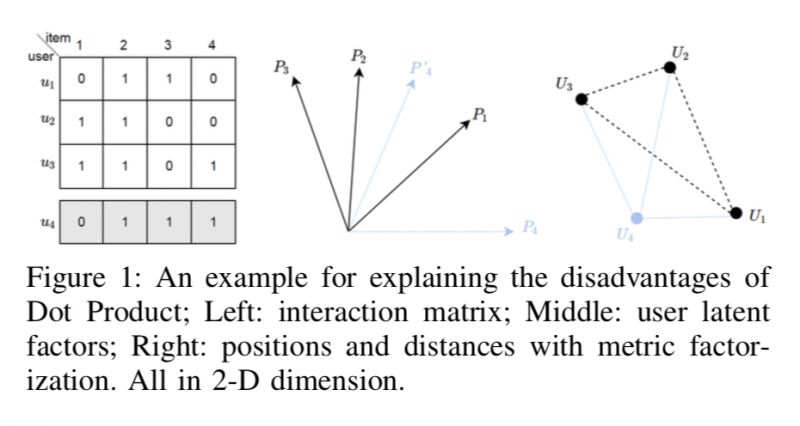

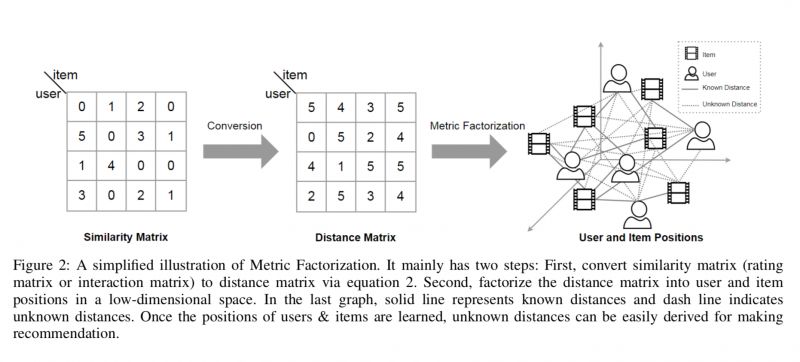

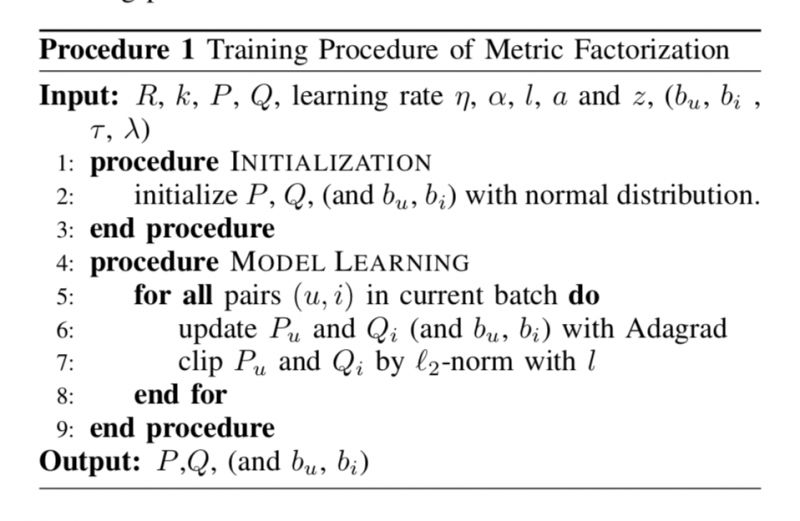

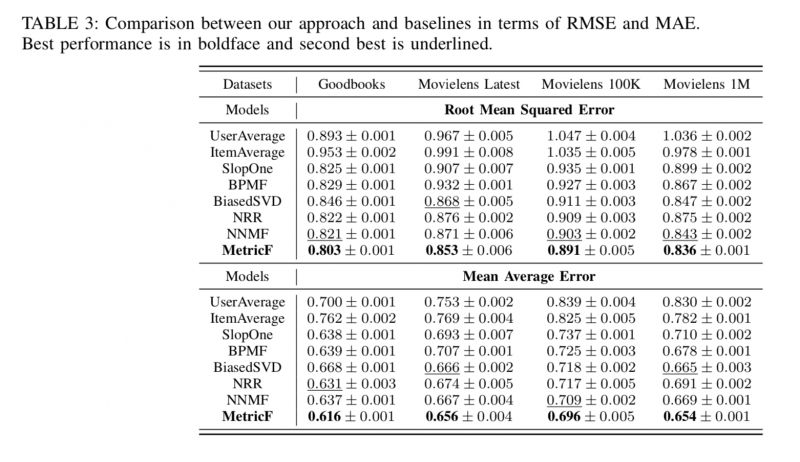

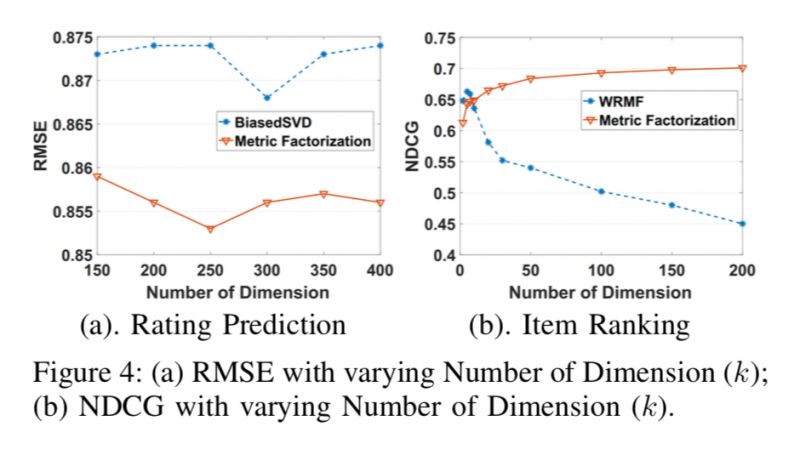

#Recommender System

本文提出了一种新型的推荐系统算法——Metric Factorization(距离分解), 该方法旨在改进传统的基于矩阵分解的推荐系统算法。矩阵分解一个很大的问题就是不符合 inequality property, 这很大程度上阻碍了其表现。

本文提出新型的解决方案,通过把用户和商品看作是一个低纬空间里面的点,然后用他们之间的距离来表示他们的距离。通过类似于矩阵分解的 squared loss 就能很好的从已有的历史数据中学出用户和商品在这个低维空间的位置。

Metric Factorization 可以用在评分预测和排序两个经典的推荐场景,并且都取得了 state-of-the-art 的结果,超过基于 deep learning 以及已有的 Metric learning 的推荐算法。

▲ 论文模型:点击查看大图

@Davidzhang 推荐

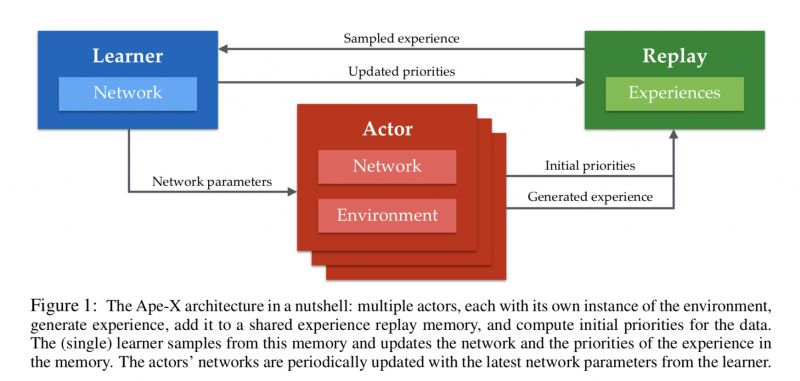

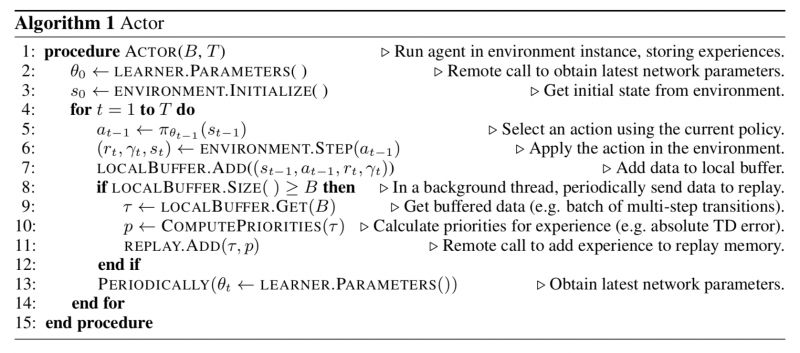

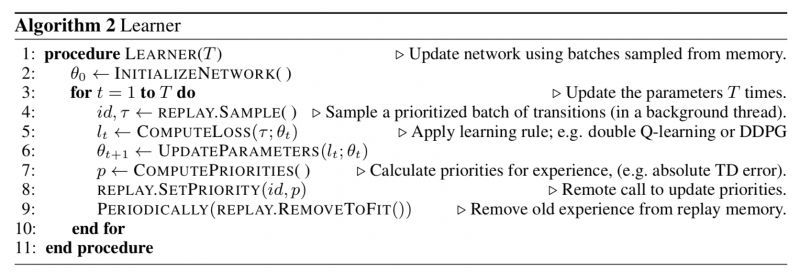

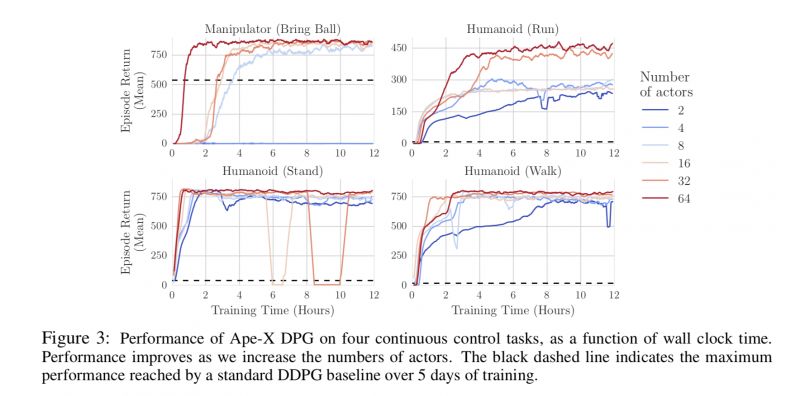

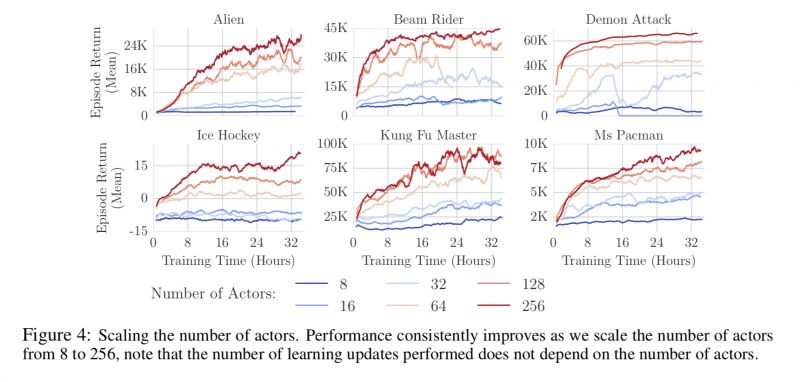

#Reinforcement Learning

本文是 DeepMind 发表于 ICLR 2018 的工作。Exploration 是强化学习里面比较难的问题,这篇 paper 通过分布式,可以说用一个最简单的做法却实现了非常好的 exploration。同时,这篇 paper 也让我们要意识到 RL 的分布式计算是非常重要的一个环节,不仅仅是加快训练速度,还可以更好的提升效果。

▲ 论文模型:点击查看大图

本期所有入选论文的推荐人

均将获得PaperWeekly纪念周边一份

▲ 深度学习主题行李牌/卡套 + 防水贴纸

礼物领取方式

推荐人请根据论文详情页底部留言

添加小助手领取礼物

想要赢取以上周边好礼?

点击阅读原文即刻加入社区吧!

点击以下标题查看往期推荐:

▲ 戳我查看招募详情

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 加入社区刷论文