视频预测领域有哪些最新研究进展?不妨看看这几篇顶会论文

作者丨文永亮

学校丨哈尔滨工业大学(深圳)硕士生

研究方向丨视频预测、时空序列预测

ICCV 2019

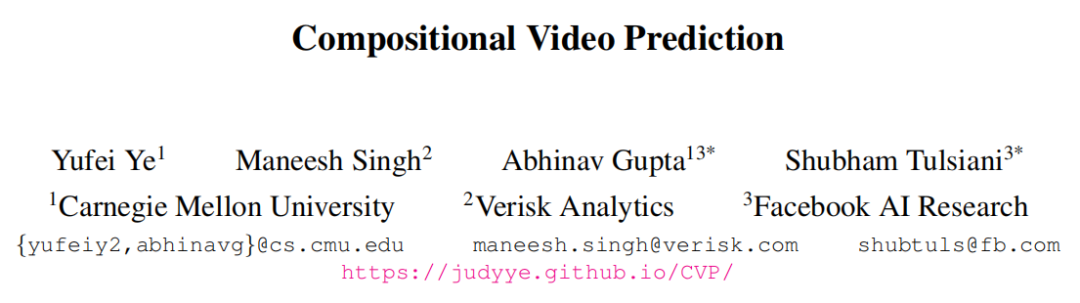

这是卡耐基梅隆和 Facebook 的一篇 paper,这篇论文的关键在于分解实体预测再组成,我们观察到一个场景是由不同实体经历不同运动组成的,所以这里提出的方法是通过隐式预测独立实体的未来状态,同时推理它们之间的相互作用,并使用预测状态来构成未来的视频帧,从而实现了对实体分解组成的视频预测。

该论文使用了两个数据集,一个是包含可能掉落的堆叠物体 ShapeStacks,另一个包含人类在体育馆中进行活动的视频 Penn Action,并表明论文的方法可以在这些不同的环境中进行逼真的随机视频预测。

主要架构有下面三个部分组成:

1. Entity Predictor(实体预测模块):预测每一个实体表示的未来状态;

2. Frame Decoder(帧解码器):从实体表示中解码成 frame;

3. Encoder(编码器):把 frame 编码成 u 作为 LSTM 的 cell-state 得到输出记录时序信息(最后其实就是 concat 进去,见如下)。

https://github.com/JudyYe/CVP/blob/c176a508e6cbddd60b932b76af8931f774e2efa0/cvp/graph.py#L349

obj_vecs = torch.cat([pose, bbox, diff_z], dim=-1)

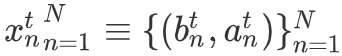

,

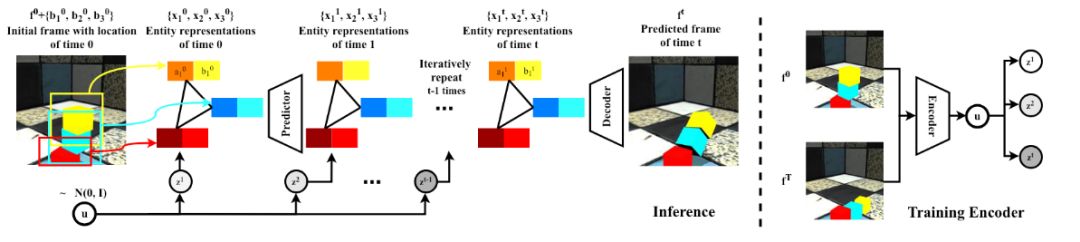

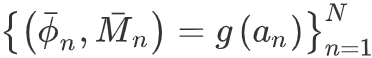

, 表示在

g

的网络结构下解码每一个实体的特征和空间掩码,让 W

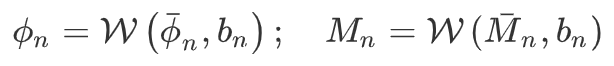

表示类似 Spatial Transformer Networks 的空间变化网络,可以得到下面的实体的特征和掩码

表示在

g

的网络结构下解码每一个实体的特征和空间掩码,让 W

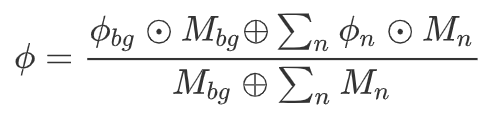

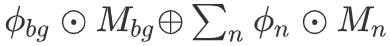

表示类似 Spatial Transformer Networks 的空间变化网络,可以得到下面的实体的特征和掩码通过权重掩码和各个特征的结合最后取平均,这样我们就得到图像级别的特征,即每一帧的特征,是常数的空间掩码(论文取值为 0.1),其组成的特征表示如下:

这个是加权后的背景特征与加权后的每个实体的特征的总和,最后除以权重和。

这样就得到了解码的结果。

这个是加权后的背景特征与加权后的每个实体的特征的总和,最后除以权重和。

这样就得到了解码的结果。

。

。

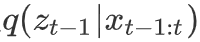

ICLR 2019

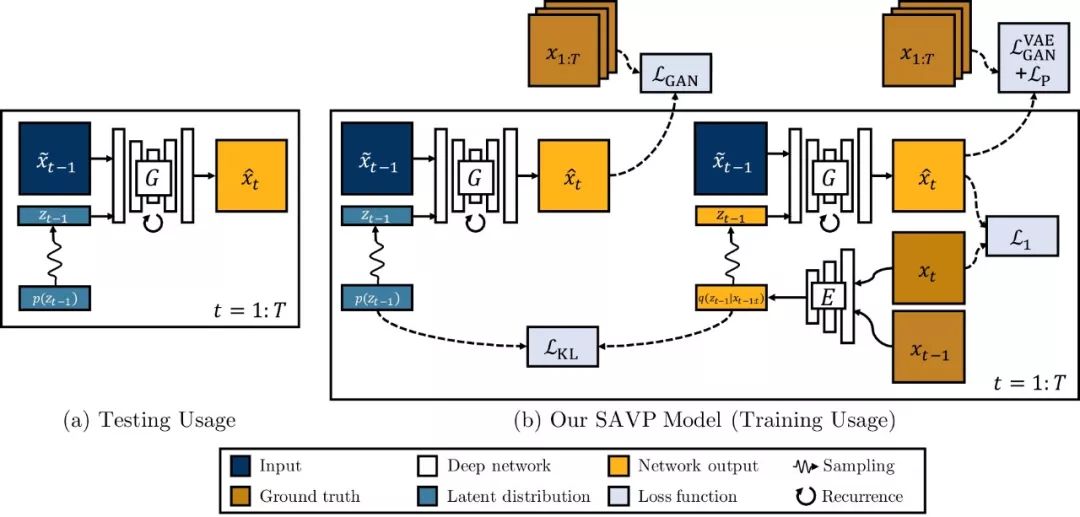

▲ SV2P网络结构

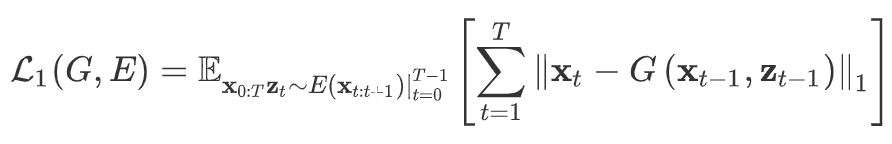

在训练期间,隐变量

的重构,

与

被 Encoder 编码为隐变量,前一帧

与隐变量

经过 G 模型之后得到预测帧

要计算与当前帧

的 L1 损失,使其生成要尽量相似。

在测试阶段我们的隐变量从先验分布直接采样,

与

经过 G 生成下一帧的预测图

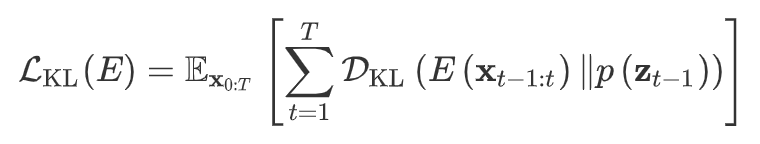

,所以需要同时拉近

的分布,其 KL 散度如下:

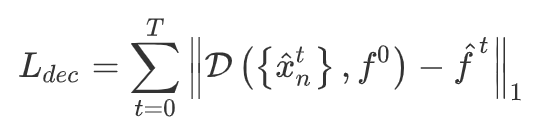

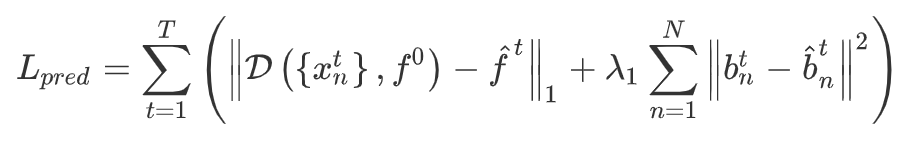

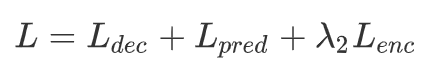

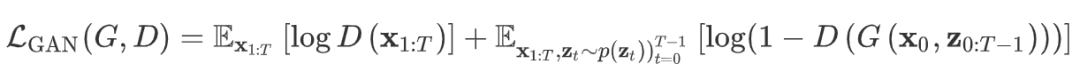

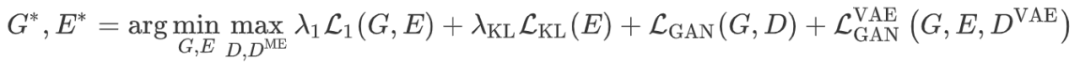

所以 G 和 E 的目标函数如下:

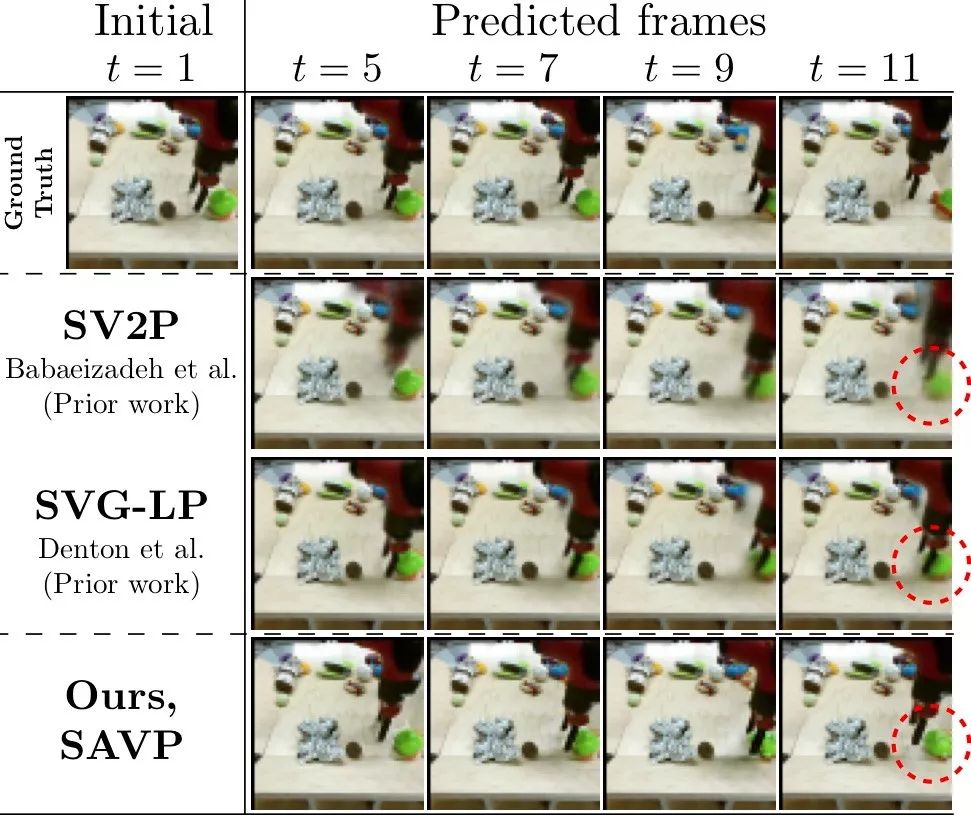

L1 损失并不是很能反映图像的相似度,既然文章是 VAE 和 GAN 的结合,所以在下面提出了判别器去评判图片质量。论文指出单纯的 VAE 更容易产生模糊图,这里加入的判别器是能够分辨出生成视频序列与真实视频序列

,这里是比较意想不到的地方,因为这里没有使用直接的图像判别器,而是判别生成序列与真实序列,其 D 判别器的网络结构是使用了 3D 卷积基于 SNGAN 的,G 生成器是使用了 convLSTM 捕捉时空序列信息。

最后总的损失函数如下:

下面是论文中的实验结果:

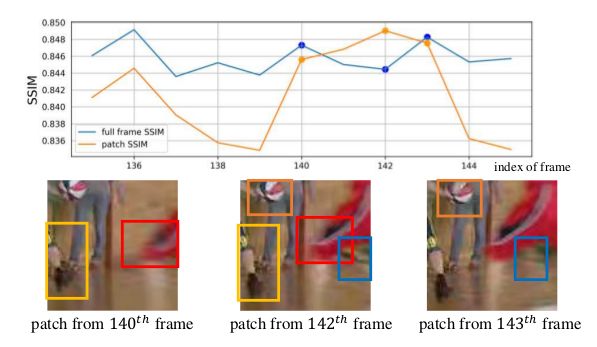

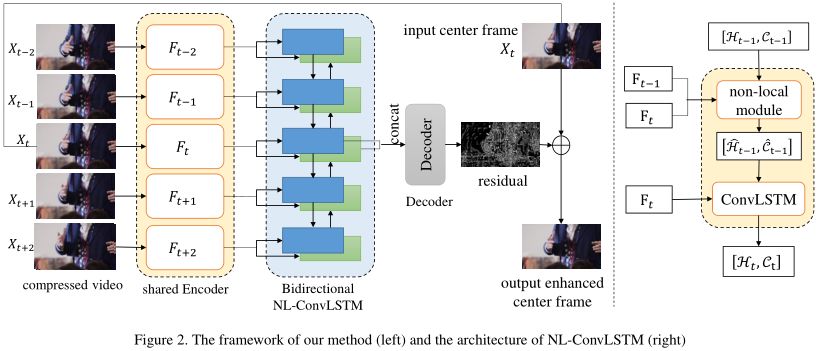

ICCV 2019

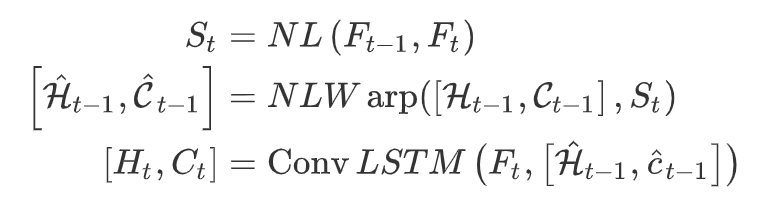

ConvLSTM 可以表示成下面的公式:

即 hidden state 是从上一次的 hidden state

经过 ConvLSTM-cell 得到的。

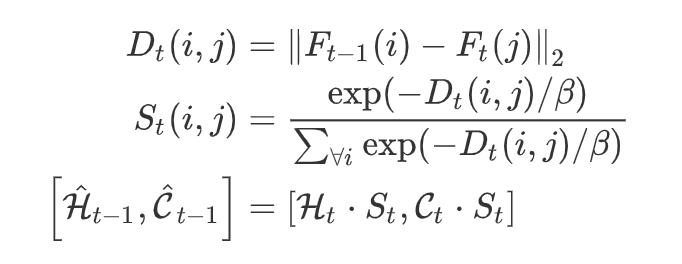

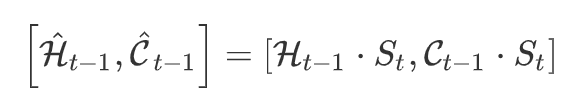

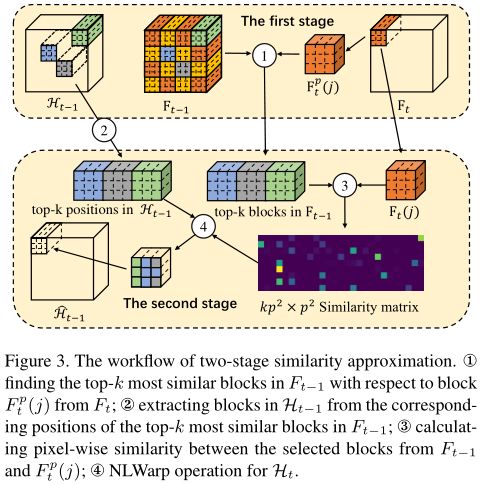

而 NL-ConvLSTM 是在 ConvLSTM 的基础上加了 Non-local 的方法,可以表示如下:

其中是当前帧

与前一帧的

的相似矩阵,这里的 Non-Local 的操作是一种特殊的 attention,这不是 self-attention,是比较前一帧获得相似矩阵再计算 attention,NLWrap 操作可以用数学表达如下:

这里的公式估计论文写错了,我认为是:

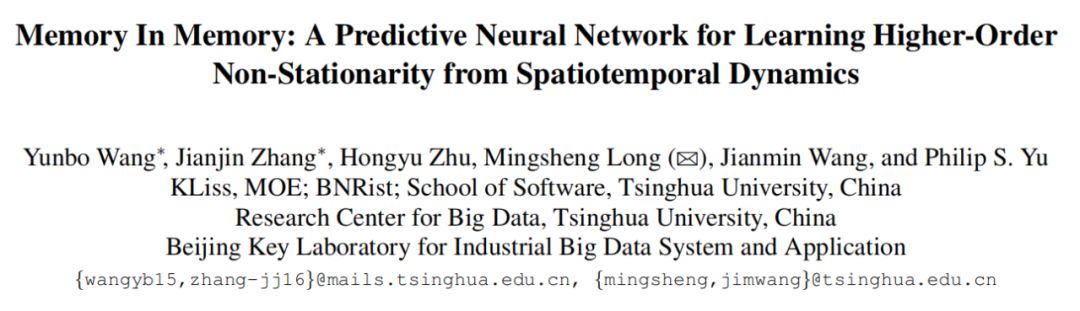

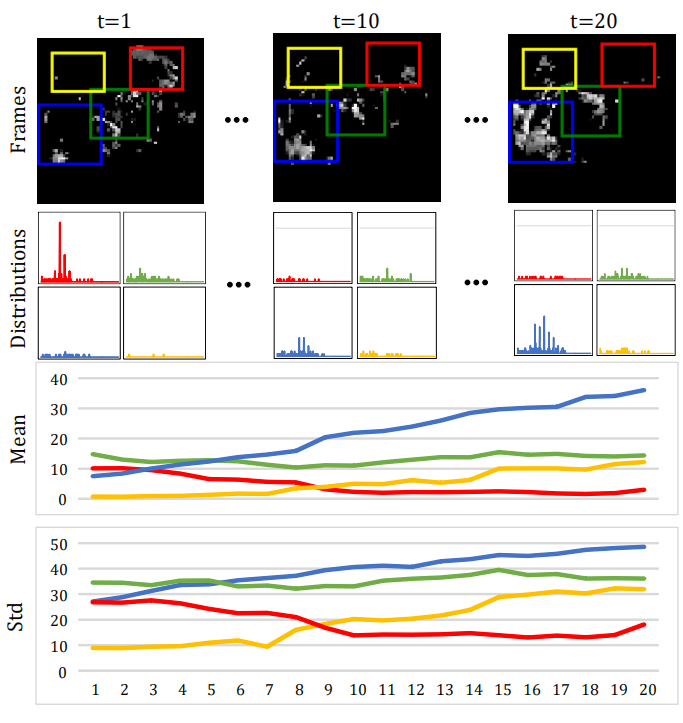

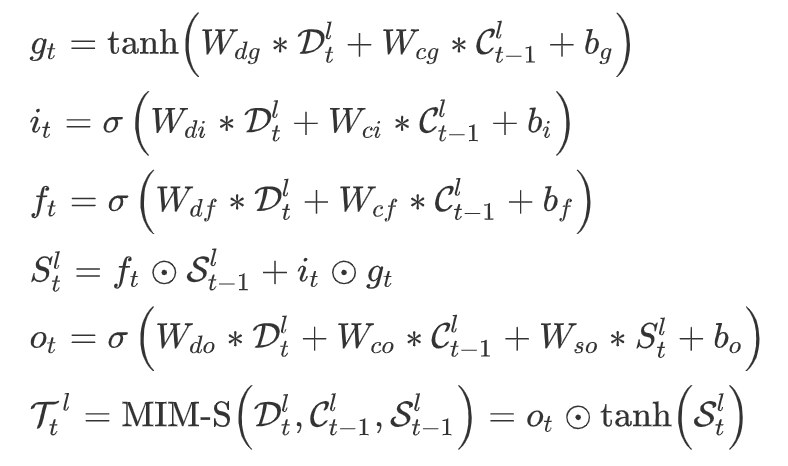

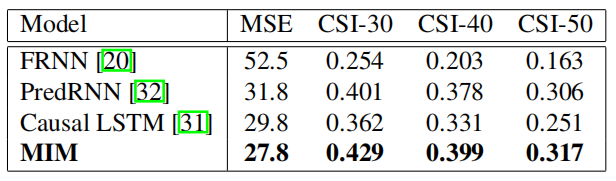

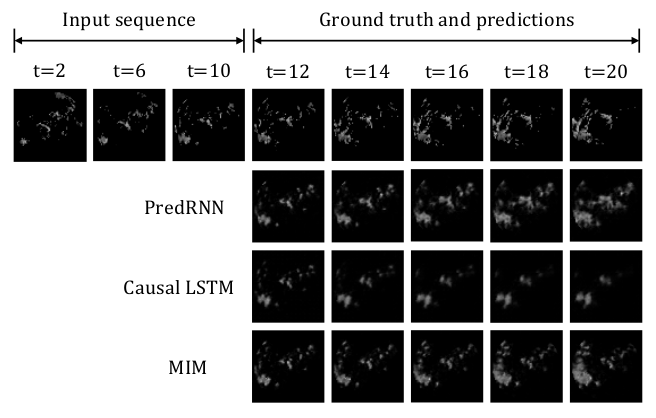

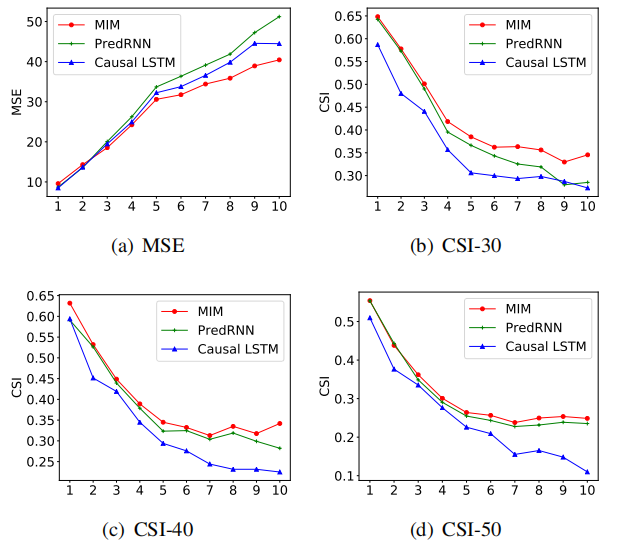

CVPR 2019

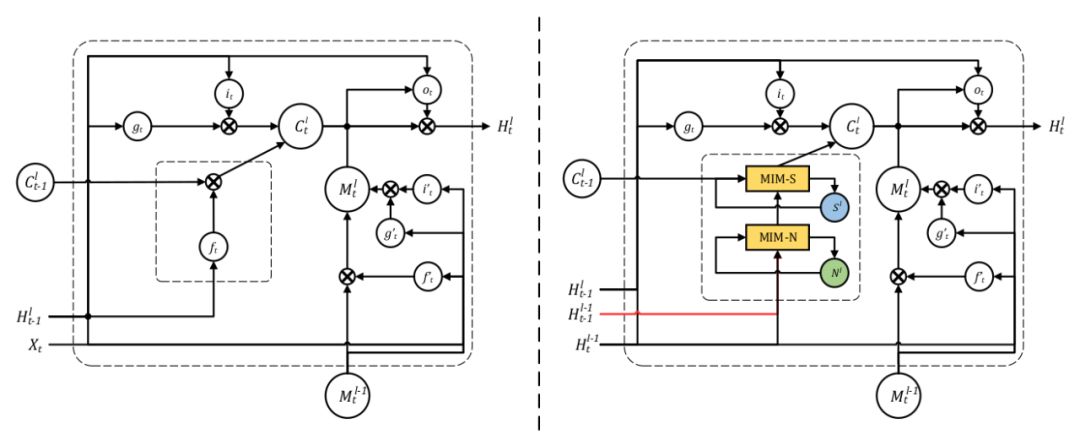

▲ 左边为ST-LSTM (Spatio-Temporal LSTM),右边为加入了MIM模块的LSTM

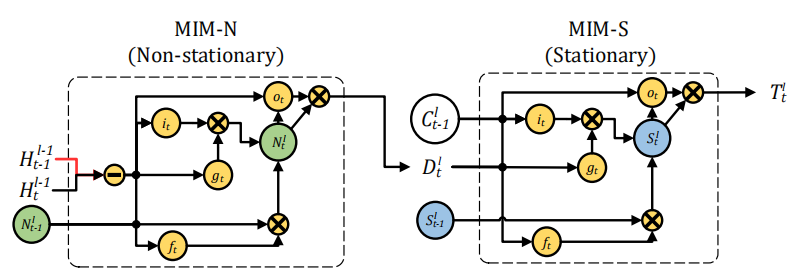

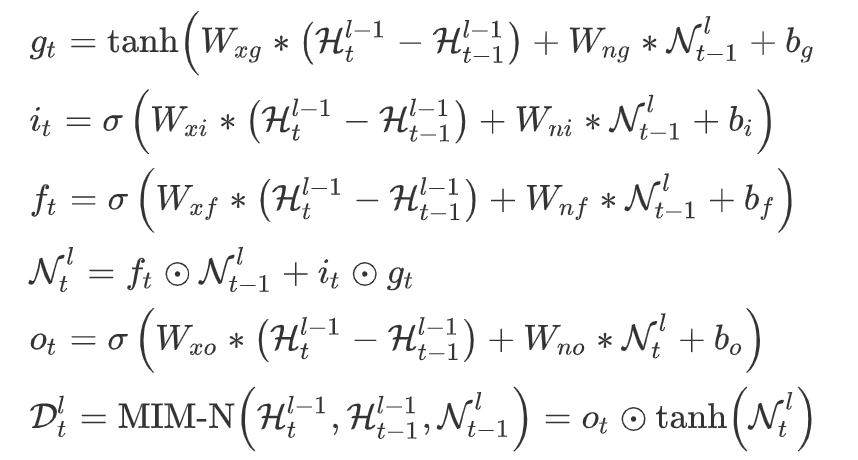

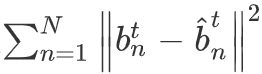

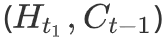

这篇论文的主要工作就是构造了 MIM 模块代替遗忘门,其中这个模块分为两部分:MIM-N(非平稳模块),MIM-S(平稳模块)。

MIM-N 所有的门,

,

,和

都用

和

作为 MIM-S 输入,MIM-S 会根据原记忆和特征差决定变化多少,如果

很小,意味着并不是非平稳变化,即变化得平稳,MIM-S 很大程度会继续沿用

;如果

很大,则会重写记忆并且更关注于非平稳变化。

其数学表达式如下:

1. MIM-N:

2. MIM-S:

总结

点击以下标题查看更多往期内容:

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 获取更多论文推荐