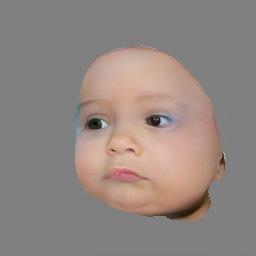

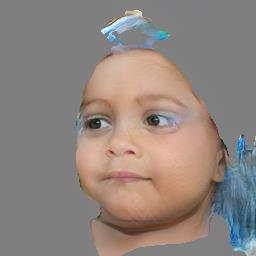

A lifespan face synthesis (LFS) model aims to generate a set of photo-realistic face images of a person's whole life, given only one snapshot as reference. The generated face image given a target age code is expected to be age-sensitive reflected by bio-plausible transformations of shape and texture, while being identity preserving. This is extremely challenging because the shape and texture characteristics of a face undergo separate and highly nonlinear transformations w.r.t. age. Most recent LFS models are based on generative adversarial networks (GANs) whereby age code conditional transformations are applied to a latent face representation. They benefit greatly from the recent advancements of GANs. However, without explicitly disentangling their latent representations into the texture, shape and identity factors, they are fundamentally limited in modeling the nonlinear age-related transformation on texture and shape whilst preserving identity. In this work, a novel LFS model is proposed to disentangle the key face characteristics including shape, texture and identity so that the unique shape and texture age transformations can be modeled effectively. This is achieved by extracting shape, texture and identity features separately from an encoder. Critically, two transformation modules, one conditional convolution based and the other channel attention based, are designed for modeling the nonlinear shape and texture feature transformations respectively. This is to accommodate their rather distinct aging processes and ensure that our synthesized images are both age-sensitive and identity preserving. Extensive experiments show that our LFS model is clearly superior to the state-of-the-art alternatives. Codes and demo are available on our project website: \url{https://senhe.github.io/projects/iccv_2021_lifespan_face}.

翻译:生命周期面部合成( LFS ) 模型旨在生成一套个人整个生命的光度和现实面貌图像, 仅以一个快照作为参考。 给目标年龄代码的生成面面貌图像预计将在身份保护的同时, 被生物可变性的形状和纹理变换所反映为年龄敏感度。 这极具挑战性, 因为面部的形状和纹理特性要分别进行和高度非线性变换 w.r. t. 年龄。 最近的大多数 LFS 模型都基于基因化对立对称网络( GANs), 从而将年龄代码有条件变换应用到潜在的面部表示。 它们从最近GANs 的图像进化进化中大大受益。 然而, 在没有将其潜移到纹理、 形状和 质变变变变模型中, 它们基本上限制了非线变变的图像变变变变模型 。 这通过提取一个稳定的变换模型, 并且基于一个稳定的变换模型, 和另一个的变变换模型, 将显示一个稳定的变换模型 。