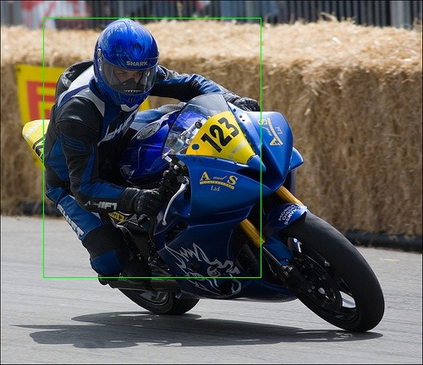

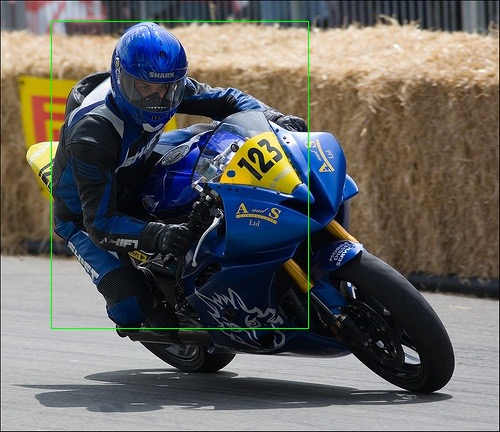

Learning from a few training samples is a desirable ability of an object detector, inspiring the explorations of Few-Shot Object Detection (FSOD). Most existing approaches employ a pretrain-transfer paradigm. The model is first pre-trained on base classes with abundant data and then transferred to novel classes with a few annotated samples. Despite the substantial progress, the FSOD performance is still far behind satisfactory. During pre-training, due to the co-occurrence between base and novel classes, the model is learned to treat the co-occurred novel classes as backgrounds. During transferring, given scarce samples of novel classes, the model suffers from learning discriminative features to distinguish novel instances from backgrounds and base classes. To overcome the obstacles, we propose a novel framework, Mining Implicit Novel Instances (MINI), to mine the implicit novel instances as auxiliary training samples, which widely exist in abundant base data but are not annotated. MINI comprises an offline mining mechanism and an online mining mechanism. The offline mining mechanism leverages a self-supervised discriminative model to collaboratively mine implicit novel instances with a trained FSOD network. Taking the mined novel instances as auxiliary training samples, the online mining mechanism takes a teacher-student framework to simultaneously update the FSOD network and the mined implicit novel instances on the fly. Extensive experiments on PASCAL VOC and MS-COCO datasets show MINI achieves new state-of-the-art performance on any shot and split. The significant performance improvements demonstrate the superiority of our method.

翻译:从一些培训样本中学习是物体探测器的可取能力,它激发了对少数热量物体探测(FSOD)的探索。大多数现有方法都采用先入为主的转移模式。该模式首先在基础班上进行预先培训,并配有丰富的数据,然后转移到具有附加说明的样板的新型班级。尽管取得了很大进展,但FSOD的表现仍然远远落后于令人满意的程度。在培训前,由于基础班和新班之间有共同的采矿机制和在线采矿机制,该模型学会将共同制作的新奇科班作为背景。在转让模型时,由于新班的样本稀少,该模型在区分背景和基础班的新事例时,会受到歧视。为了克服这些障碍,我们提议了一个新的框架,即Mine Indial Indicult Novil Incentes(MINI),将隐含的新事例作为辅助培训样品,广泛存在于丰富的基础数据和新颖的MISA-SA-SL 机制中。离线采矿机制利用了一种自封的歧视性改进模式,与经过训练的隐含地雷新事例,在FSODOD网络上进行了重要的重大试验。在采矿试验中,同时进行新的试验,并用新的试验,在秘密的教师-RODFS-ROD-RODFS-I-I-S-S-S-S-S-S-S-I-S-A-A-S-S-A-A-A-A-A-S-A-A-A-A-A-A-A-S-A-A-S-I-I-I-S-I-I-S-S-S-I-I-I-I-I-I-I-S-S-I-I-S-I-I-I-I-I-S-S-S-S-A-A-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-