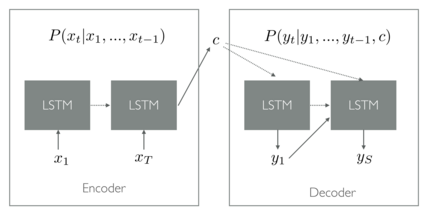

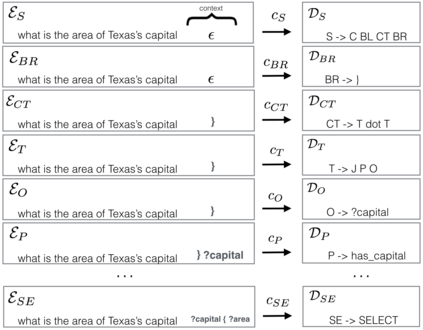

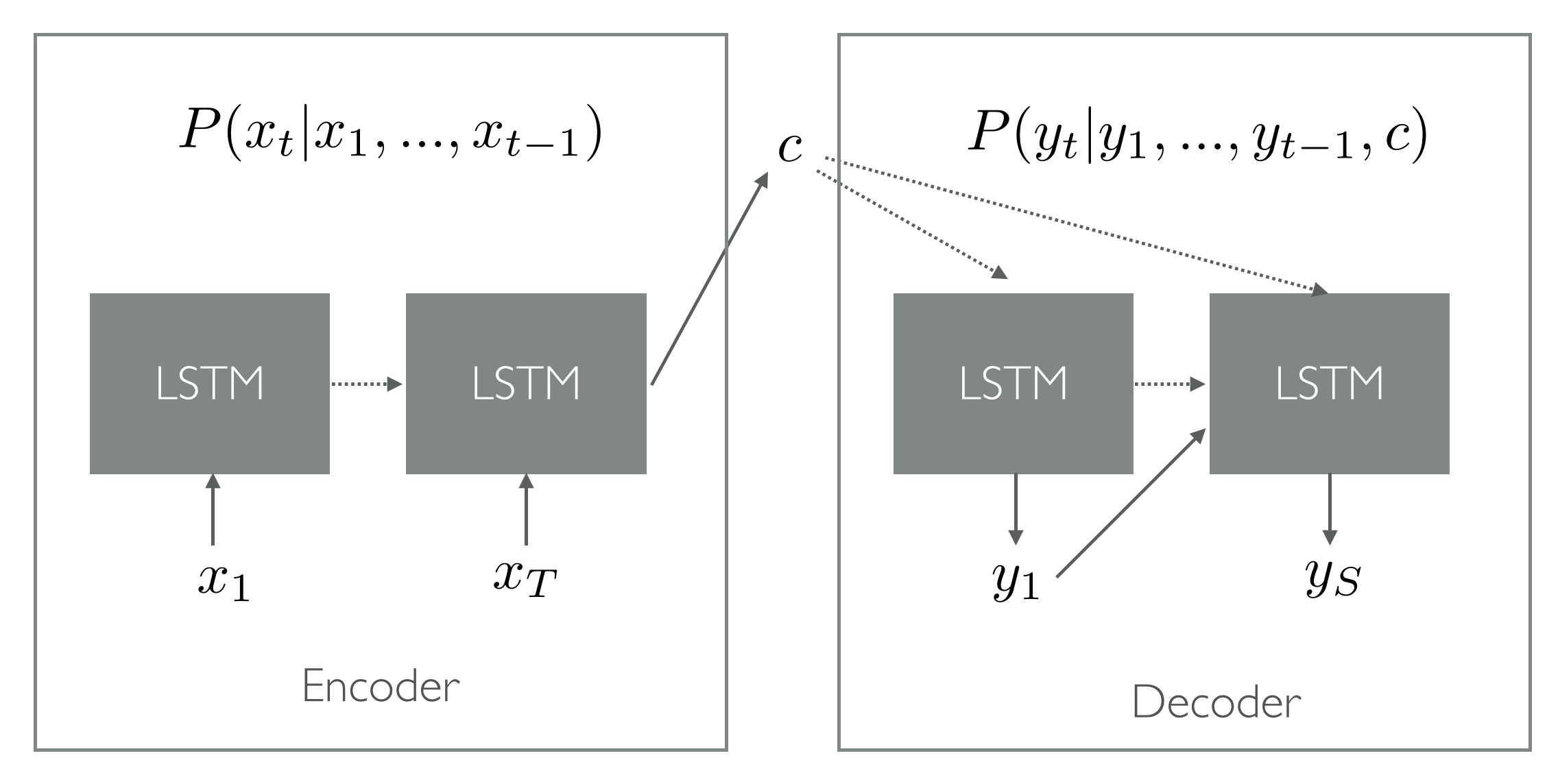

Semantic parsing can be defined as the process of mapping natural language sentences into a machine interpretable, formal representation of its meaning. Semantic parsing using LSTM encoder-decoder neural networks have become promising approach. However, human automated translation of natural language does not provide grammaticality guarantees for the sentences generate such a guarantee is particularly important for practical cases where a data base query can cause critical errors if the sentence is ungrammatical. In this work, we propose an neural architecture called Encoder CFG-Decoder, whose output conforms to a given context-free grammar. Results are show for any implementation of such architecture display its correctness and providing benchmark accuracy levels better than the literature.

翻译:语义分解可被定义为将自然语言句子绘制成机器可解释、正式表达其含义的过程。使用 LSTM 编码器脱coder-decoder神经网络的语义分解已成为有希望的做法,然而,自然语言的人类自动翻译并不能为这些句子提供语法学保障,因此,对于数据库查询如果该句子不具有语法性质而可能造成重大错误的实际案例来说,这种保证尤其重要。在这项工作中,我们提议建立一个称为Encoder CFG-Decoder的神经结构,其输出符合特定不上下文的语法。已经展示了任何实施这种结构的结果,显示其正确性,并提供了比文献更好的基准精确度。