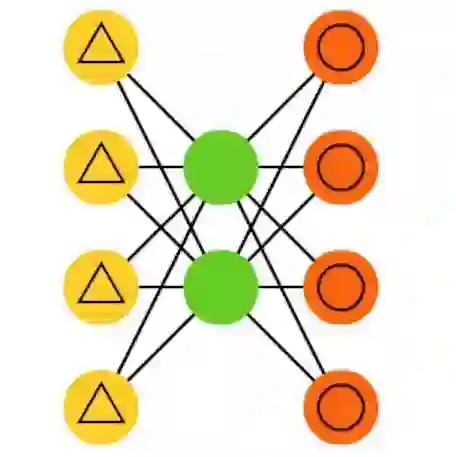

This letter introduces a new denoiser that modifies the structure of denoising autoencoder (DAE), namely noise learning based DAE (nlDAE). The proposed nlDAE learns the noise instead of the original data. Then, the denoising is performed by subtracting the regenerated noise from the noisy input. Hence, nlDAE is more effective than DAE when the noise is simpler to regenerate than the original data. To validate the performance of nlDAE, we provide two case studies: symbol demodulation and precise localization. Numerical results suggest that nlDAE requires smaller latent space dimension and less training dataset compared to DAE.

翻译:此信引入了一个新的解密器, 改变解除自动编码器( DAE)的结构, 即以噪音学习为基础的 DAE (nlDAE) 。 拟议的 NLDAE 学习噪音, 而不是原始数据 。 然后, 解密是通过从噪音输入中减去再生噪音来进行的。 因此, NLDAE 比DAE 更简单再生的NLDAE 更有效。 为了验证 NLDAE 的性能, 我们提供了两个案例研究: 符号递减和精确本地化。 数字结果表明 NLDAE 需要比 DAE 更小的潜层空间和较少的培训数据集 。