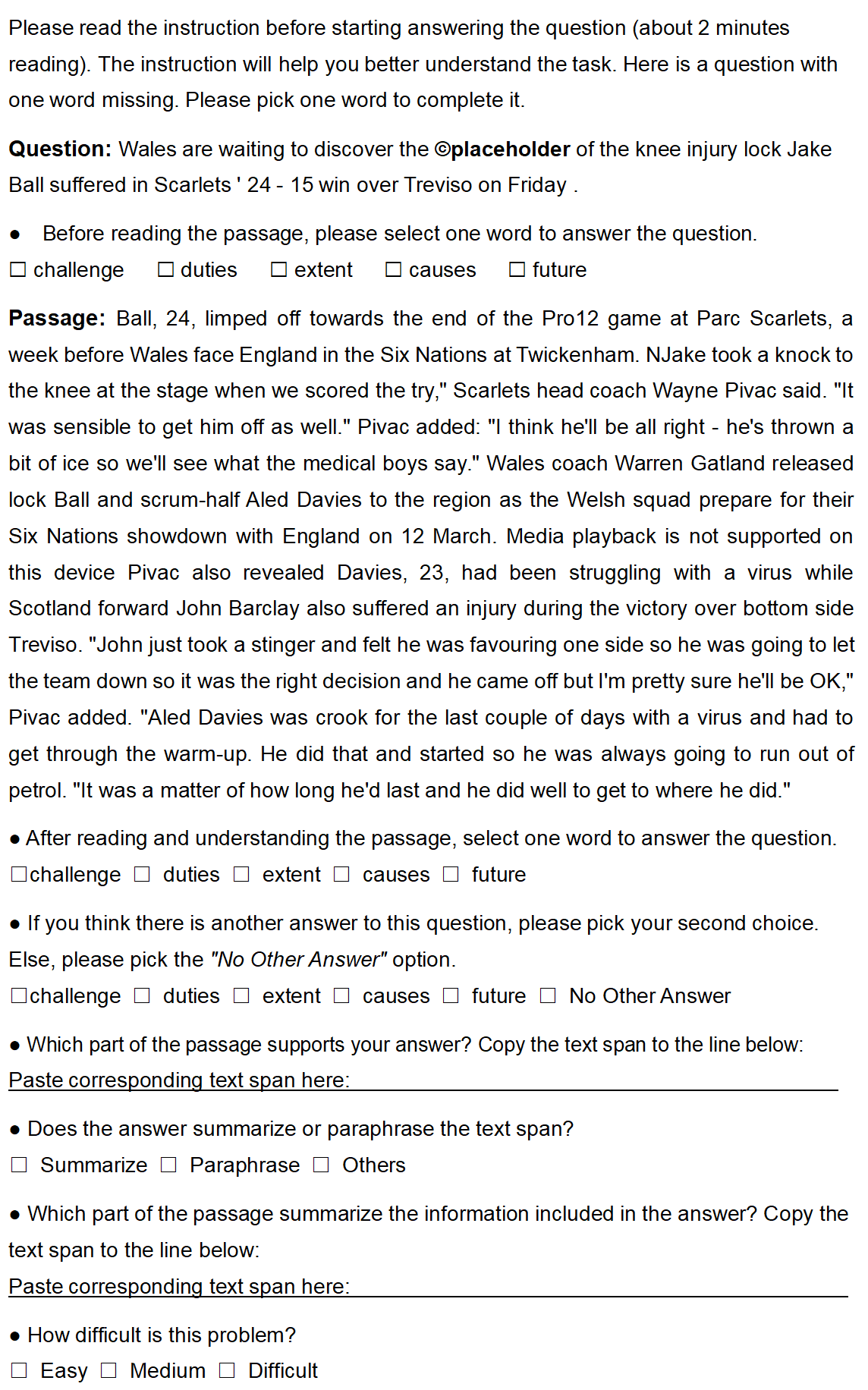

This paper introduces the SemEval-2021 shared task 4: Reading Comprehension of Abstract Meaning (ReCAM). This shared task is designed to help evaluate the ability of machines in representing and understanding abstract concepts. Given a passage and the corresponding question, a participating system is expected to choose the correct answer from five candidates of abstract concepts in a cloze-style machine reading comprehension setup. Based on two typical definitions of abstractness, i.e., the imperceptibility and nonspecificity, our task provides three subtasks to evaluate the participating models. Specifically, Subtask 1 aims to evaluate how well a system can model concepts that cannot be directly perceived in the physical world. Subtask 2 focuses on models' ability in comprehending nonspecific concepts located high in a hypernym hierarchy given the context of a passage. Subtask 3 aims to provide some insights into models' generalizability over the two types of abstractness. During the SemEval-2021 official evaluation period, we received 23 submissions to Subtask 1 and 28 to Subtask 2. The participating teams additionally made 29 submissions to Subtask 3. The leaderboard and competition website can be found at https://competitions.codalab.org/competitions/26153. The data and baseline code are available at https://github.com/boyuanzheng010/SemEval2021-Reading-Comprehension-of-Abstract-Meaning.

翻译:本文介绍了SemEval-2021共同的任务 : 阅读抽象含义(ReCAM) 。 这一共同的任务旨在帮助评估机器在代表并理解抽象概念方面的能力。 鉴于一个段落和相应的问题,一个参与系统预计将从一个凝聚式机器阅读理解结构中的五个抽象概念候选人中选择正确的答案。根据两个典型的抽象性定义,即不可感知性和不具体性,我们的任务为评价参与模式提供了三个子任务。具体地说,子任务1旨在评估一个系统在代表并理解抽象概念方面的能力。鉴于一个段落和相应的问题,一个参与系统将选择五个选择在凝聚式机器阅读理解结构中抽象概念的五个候选人的正确答案。根据两个典型的抽象性定义,即不易感知性和不具体性,我们的任务提供了三个子任务来评价参与模型。具体来说,我们收到了23份提交给Subtask 1 和 28 Subtask 2. 参与小组又向Subtask 提交了29份文件。 Subtask 2 Subtask 2 Subtask 2 Subtask 2) Subtask 2。 Subtask 2 Subtask 2