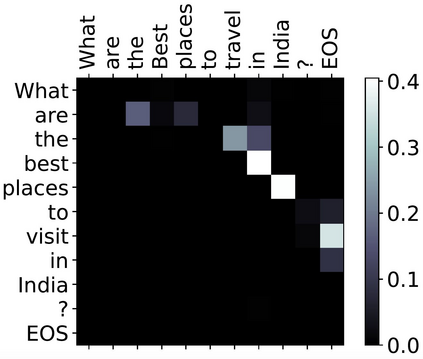

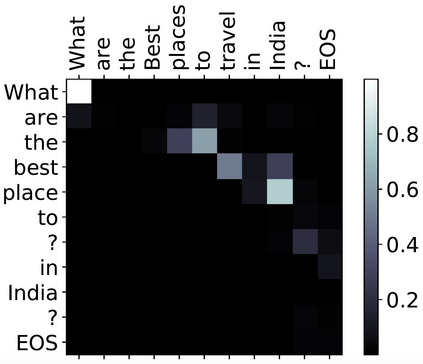

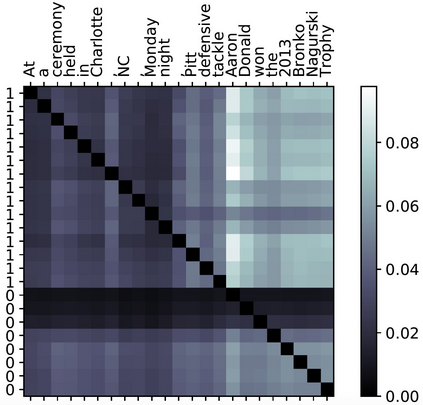

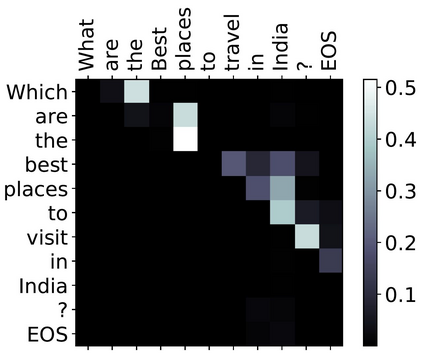

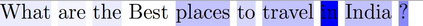

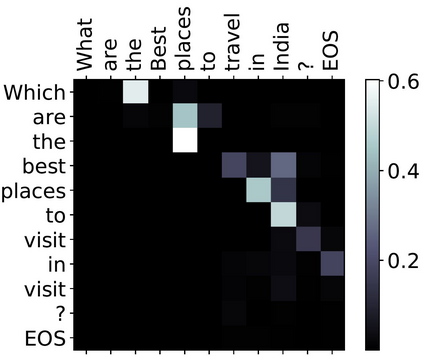

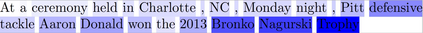

A lack of corpora has so far limited advances in integrating human gaze data as a supervisory signal in neural attention mechanisms for natural language processing(NLP). We propose a novel hybrid text saliency model (TSM) that, for the first time, combines a cognitive model of reading with explicit human gaze supervision in a single machine learning framework. On four different corpora we demonstrate that our hybrid TSM duration predictions are highly correlated with human gaze ground truth. We further propose a novel joint modelling approach to integrate TSM predictions into the attention layer of a network designed for a specific upstream NLP task without the need for any task-specific human gaze data. We demonstrate that our joint model outperforms the state of the art in paraphrase generation on the Quora Question Pairs corpus by more than 10% in BLEU-4 and achieves state-of-the-art performance for sentence compression on the challenging Google Sentence Compression corpus. As such, our work introduces a practical approach for bridging between data-driven and cognitive models and demonstrates a new way to integrate human gaze-guided neural attention into NLP tasks.

翻译:迄今为止,在将人类凝视数据作为自然语言处理神经关注机制的监督信号(NLP)方面,缺乏一个公司在整合人类凝视数据方面进展有限。我们提议了一个新型混合文本突出模型(TSM),首次将认知阅读模式与明确的人类凝视监督结合到一个单一的机器学习框架中。关于四个不同的公司,我们证明我们混合的TSM持续时间预测与人类凝视地面真理高度相关。我们进一步提出一个新的联合建模方法,将TSM预测纳入一个网络的注意层,这个网络是为特定上游的NLP任务设计的,而不需要任何特定任务的人类凝视数据。我们证明,我们的联合模型超越了Quora 问题Pa Pairs Cap 的代言语中的艺术状态,在BLEU-4中超过了10%以上,并实现了对具有挑战性的Google Pold Conpressional Compression的句压缩工作的最新表现。我们的工作引入了一种在数据驱动和认知模型之间建立联系的实用方法,并展示了一种将人类对视向神经的关注纳入NLP任务的新方式。