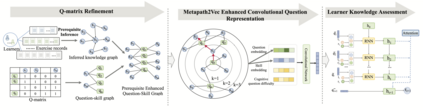

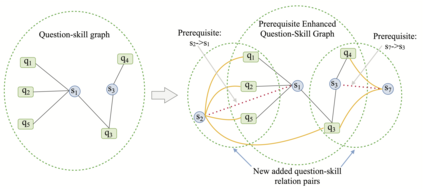

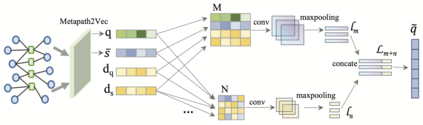

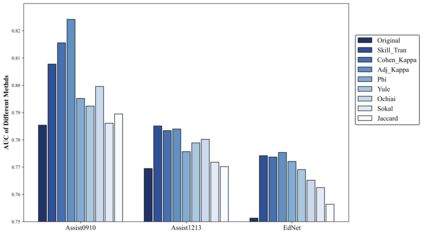

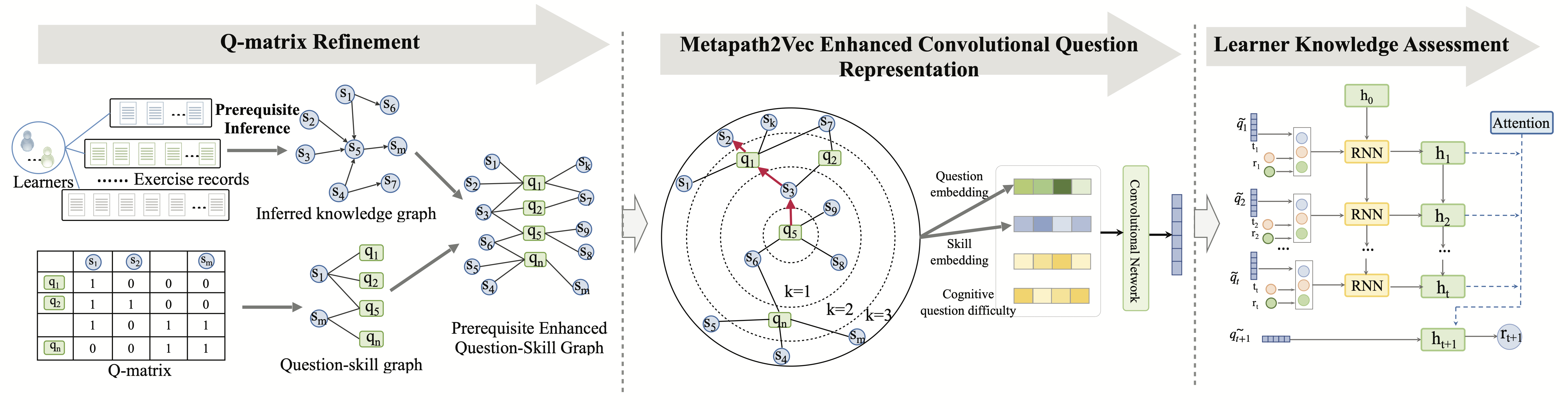

The ever growing abundance of learning traces in the online learning platforms promises unique insights into the learner knowledge assessment (LKA), a fundamental personalized-tutoring technique for enabling various further adaptive tutoring services in these platforms. Precise assessment of learner knowledge requires the fine-grained Q-matrix, which is generally designed by experts to map the items to skills in the domain. Due to the subjective tendency, some misspecifications may degrade the performance of LKA. Some efforts have been made to refine the small-scale Q-matrix, however, it is difficult to extend the scalability and apply these methods to the large-scale online learning context with numerous items and massive skills. Moreover, the existing LKA models employ flexible deep learning models that excel at this task, but the adequacy of LKA is still challenged by the representation capability of the models on the quite sparse item-skill graph and the learners' exercise data. To overcome these issues, in this paper we propose a prerequisite-driven Q-matrix refinement framework for learner knowledge assessment (PQRLKA) in online context. We infer the prerequisites from learners' response data and use it to refine the expert-defined Q-matrix, which enables the interpretability and the scalability to apply it to the large-scale online learning context. Based on the refined Q-matrix, we propose a Metapath2Vec enhanced convolutional representation method to obtain the comprehensive representations of the items with rich information, and feed them to the PQRLKA model to finally assess the learners' knowledge. Experiments conducted on three real-world datasets demonstrate the capability of our model to infer the prerequisites for Q-matrix refinement, and also its superiority for the LKA task.

翻译:在线学习平台日益丰富的学习痕迹将给学习者知识评估(LKA)带来独特的洞察力,这是使这些平台能够进一步提供各种适应性辅导服务的一种基本的个性化智能技术。对学习者知识的精确评估需要精细的Q矩阵,通常由专家设计,用于绘制项目到领域技能的精细Q矩阵。由于主观倾向,某些定型错误可能降低学习者学习LKA的绩效。有些努力改进小规模Q矩阵,但是,很难将这些方法推广到大规模在线学习环境,并应用到具有众多项目和大量技能的大规模在线学习环境。此外,现有的LKA模型采用灵活、深层次的学习模型,而这是由专家设计的,用来绘制非常稀少的项目技能图表和学习者练习数据。为了克服这些问题,我们在本文件中建议为学习者知识评估的精细微的精细Q矩阵改进框架(PQRKA ),我们用从学习者们的精细的精确度数据到最终的精细的精确性数据,我们用其精细的精细的精确性数据基础,我们从学习了精细的精细的精细的数据, Q。