研究人员在机器学习模型方面取得了长足的进步,该模型可以帮助医生更有效地在患者的健康记录中查找信息。

医生经常查询病人的电子健康记录,以获取有助于他们做出治疗决定的信息,但这些记录的繁琐性质阻碍了这一过程。研究表明,即使医生已经接受过使用电子健康记录(EHR)的培训,仅寻找一个问题的答案,平均也需要8分钟以上。

医生必须花更多的时间浏览经常是笨重的EHR界面,他们与病人互动和提供治疗的时间就越少。

研究人员已经开始开发机器学习模型,通过在EHR中自动寻找医生需要的信息来简化这一过程。然而,训练有效的模型需要庞大的相关医疗问题数据集,但由于隐私限制,这些问题往往很难得到。现有的模型很难生成真实的问题--那些人类医生会问的问题--而且往往无法成功找到正确的答案。

为了克服这种数据短缺,麻省理工学院的研究人员与医学专家合作,研究医生在审查EHR时提出的问题。然后,他们建立了一个公开可用的数据集,其中有2000多个由这些医学专家撰写的临床相关问题。

当他们用数据集训练机器学习模型来生成临床问题时,他们发现,与医学专家的真实问题相比,该模型提出的高质量和真实的问题占60%以上。

有了这个数据集,他们计划生成大量的真实医疗问题,然后用这些问题来训练机器学习模型,这将帮助医生更有效地在病人的记录中找到所需的信息。

"两千个问题可能听起来很多,但是当你看到现在正在训练的机器学习模型时,它们有这么多的数据,也许有数十亿个数据点。当你训练机器学习模型在医疗保健环境中工作时,你必须要有真正的创造力,因为数据如此缺乏,"主要作者埃里克-雷曼说,他是计算机科学和人工智能实验室(CSAIL)的研究生。

资深作者是电子工程和计算机科学系(EECS)的教授Peter Szolovits,他是CSAIL临床决策小组的负责人,也是麻省理工学院-IBM Watson人工智能实验室的成员。这篇研究论文是麻省理工学院、MIT-IBM Watson人工智能实验室、IBM研究院以及帮助创建问题并参与研究的医生和医疗专家的合作成果,将在计算语言学协会北美分会的年会上发表。

"现实的数据对于训练模型至关重要,这些数据与任务相关,但却很难找到或创建,"Szolovits说。"这项工作的价值在于仔细收集临床医生对病人病例提出的问题,从中我们能够开发出使用这些数据和一般语言模型来进一步提出合理问题的方法。"

数据缺失

雷曼解释说,研究人员能够找到的少数大型临床问题数据集存在一系列问题。有些是由病人在网络论坛上提出的医疗问题组成,这与医生的问题相差甚远。其他数据集包含从模板中产生的问题,因此它们在结构上大多是相同的,这使得许多问题不切实际。

雷曼说:"收集高质量的数据对于进行机器学习任务来说真的很重要,特别是在医疗保健方面,我们已经证明可以做到这一点"。

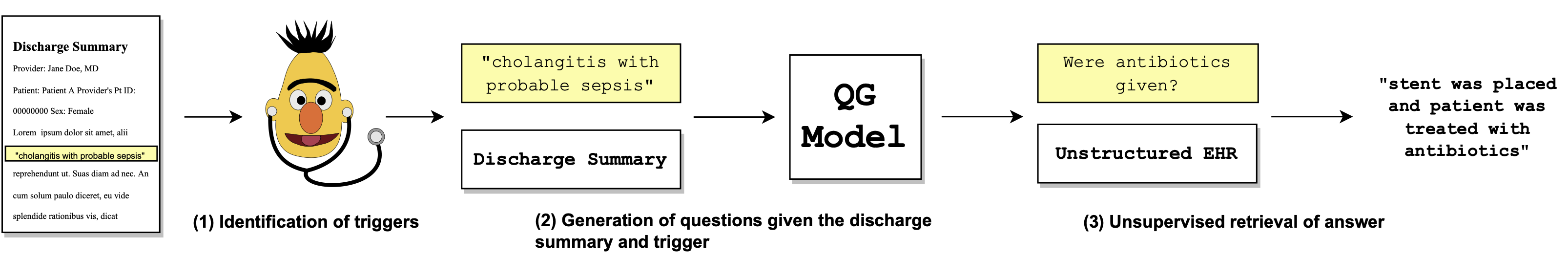

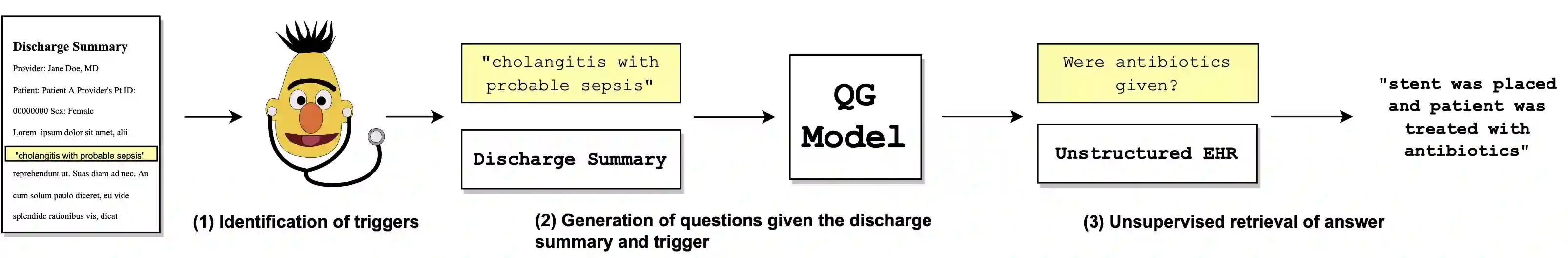

为了建立他们的数据集,麻省理工学院的研究人员与执业医生和接受培训的最后一年的医学生合作。他们给这些医学专家提供了100多份EHR出院摘要,并告诉他们阅读一份摘要并提出他们可能有的任何问题。研究人员没有对问题类型或结构做任何限制,以努力收集自然问题。他们还要求医疗专家确定EHR中导致他们提出每个问题的 "触发文本"。

例如,医疗专家可能会读到EHR中的一个说明,说病人过去的病史对前列腺癌和甲状腺功能减退很重要。触发文本 "前列腺癌 "可能导致专家问一些问题,如 "诊断日期?"或 "做了什么干预措施?"

他们发现,大多数问题都集中在症状、治疗或病人的测试结果上。雷曼说,虽然这些发现并不出乎意料,但量化每个广泛主题的问题数量将帮助他们建立一个有效的数据集,以便在真实的临床环境中使用。

一旦他们汇编了他们的问题数据集和附带的触发文本,他们就用它来训练机器学习模型,以便根据触发文本提出新的问题。

然后,医学专家使用四个指标确定这些问题是否 "好":可理解性(这个问题对人类医生来说有意义吗?)、琐碎性(这个问题从触发文本中是否太容易回答?)

值得关注的原因

研究人员发现,当模型被赋予触发文本时,它能够在63%的时间里产生一个好问题,而人类医生在80%的时间里会提出一个好问题。

他们还训练了模型,以利用他们在这个项目开始时发现的公开可用数据集恢复临床问题的答案。然后他们测试了这些训练有素的模型,看它们是否能找到人类医学专家提出的 "好 "问题的答案。

这些模型只能够恢复医生生成的问题的大约25%的答案。

"这个结果确实令人担忧"。雷曼说:"人们认为表现良好的模型实际上是很糟糕的,因为他们测试的评估问题一开始就不是很好。

该团队现在正将这项工作应用于他们的最初目标:建立一个能够自动回答医生在EHR中提出的问题的模型。下一步,他们将使用他们的数据集来训练一个机器学习模型,该模型可以自动生成数千或数百万个好的临床问题,然后可以用来训练一个新的模型来自动回答问题。

虽然在该模型成为现实之前仍有许多工作要做,但雷曼对该团队用该数据集展示的强大的初步结果感到鼓舞。

这项研究得到了麻省理工学院-IBM Watson人工智能实验室的部分支持。其他合著者包括麻省理工学院医学工程与科学研究所的Leo Anthony Celi;麻省理工学院-IBM Watson人工智能实验室的Preethi Raghavan和Jennifer J. Liang。Liang;布法罗大学的Dana Moukheiber;马萨诸塞大学洛厄尔分校的Vladislav Lialin和Anna Rumshisky;麻省理工学院的Katelyn Legaspi、Nicole Rose I. Alberto、Richard Raymund R. Ragasa、Corinna Victoria M. Puyat、Isabelle Rose I. Alberto以及Pia Gabrielle I。Alfonso;菲律宾大学的Anne Janelle R. Sy和东部大学Ramon Magsaysay纪念医疗中心的Patricia Therese S. Pile;马尼拉雅典耀大学医学和公共卫生学院的Marianne Taliño;以及东北大学的Byron C. Wallace。

论文

现有的源自电子健康记录(EHR)的问题回答(QA)数据集是人为生成的,因此不能捕捉到真实的医生信息需求。我们提出了出院总结临床问题(DiSCQ),这是一个新策划的问题数据集,由2,000多个问题与提示每个问题的文本片段(触发器)搭配而成。这些问题是由医学专家从100多个MIMIC-III出院总结中产生的。我们分析了这个数据集,以确定医学专家所寻求的信息类型的特点。我们还训练了触发器检测和问题生成(QG)的基线模型,与EHR上的无监督答案检索相搭配。我们的基线模型能够在超过62%的情况下生成高质量的问题,这些问题是由人类选择的触发器提示的。我们发布了这个数据集(以及重现基线模型结果的所有代码),以促进对现实的临床质量保证和QG的进一步研究。

源代码

https://github.com/elehman16/discq