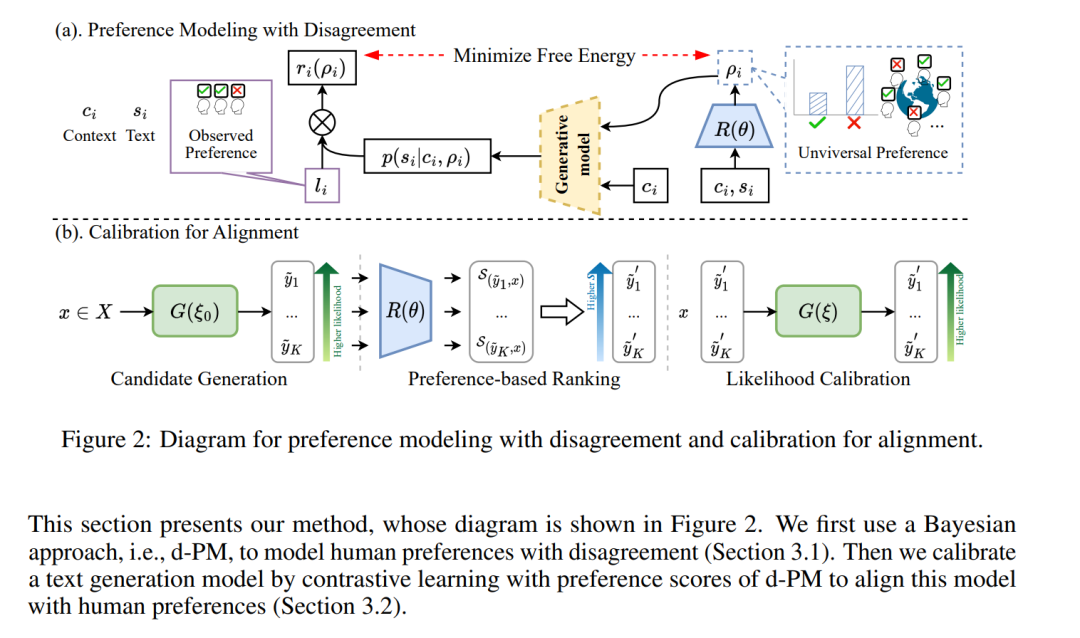

在推进以人为中心的自然语言生成(NLG)系统的征程中,确保NLG模型与人类偏好之间的对齐至关重要。为了达到这种对齐,当前流行的方法利用了一个基于人类反馈训练的奖励模型的强化学习(RL)方法。然而,由于人类偏好的主观性质导致的固有不同意见为训练奖励模型带来了巨大的挑战,导致NLG性能的下降。为了应对这个问题,之前的方法通常依赖于多数投票或平均来整合多个不一致的偏好。尽管这样的方法易于理解和执行,但它们无法捕捉到人们之间的微妙不同意见程度,可能只代表一小部分人,从而缺乏定量揭示人类偏好普遍性的能力。为了应对这一挑战,本文提出了一种新颖的方法,该方法采用贝叶斯框架来考虑人类偏好中不同意见的分布,并将其命名为d-PM。此外,考虑到RL策略在训练效率上的低效和复杂,我们进一步提议使用对比学习策略来训练NLG模型,该模型使用从d-PM模型得到的偏好分数。在两个以人为中心的NLG任务,即情感支持对话和完整性“经验法则”生成上的广泛实验表明,我们的方法在自动和人工评估中都一致超越了先前的SOTA模型。

https://www.zhuanzhi.ai/paper/66668c6091cb215ad2cf17cb2de71dd2

成为VIP会员查看完整内容

相关内容

Deciphering and integrating invariants for neural operator learning with various physical mechanisms

Arxiv

0+阅读 · 2023年11月24日

Arxiv

0+阅读 · 2023年11月22日

Arxiv

224+阅读 · 2023年4月7日