各国政府正越来越多地考虑在高风险的军事和外交政策决策中整合自主AI代理,尤其是在像GPT-4这样的先进生成式AI模型出现之后。我们的工作旨在审查多个AI代理在模拟战争游戏中的行为,特别是它们倾向于采取可能加剧多边冲突的升级行动。基于政治学和国际关系关于升级动态的文献,我们设计了一种新颖的战争游戏模拟和评分框架,以评估这些代理在不同场景中采取行动的升级风险。与以往的研究相反,我们的研究提供了定性和定量的见解,并专注于大型语言模型(LLMs)。我们发现,研究的五种现成LLMs都显示出某种形式的升级行为和难以预测的升级模式。我们观察到,这些模型倾向于发展军备竞赛动态,导致更大的冲突,甚至在极少数情况下导致核武器的部署。定性地说,我们还收集了模型所报告的行动理由,并观察到基于威慑和先发制人策略的令人担忧的理由。鉴于军事和外交政策背景下的高风险,我们建议在部署用于战略军事或外交决策的自主语言模型代理之前,进一步审查并谨慎考虑。

https://arxiv.org/pdf/2401.03408

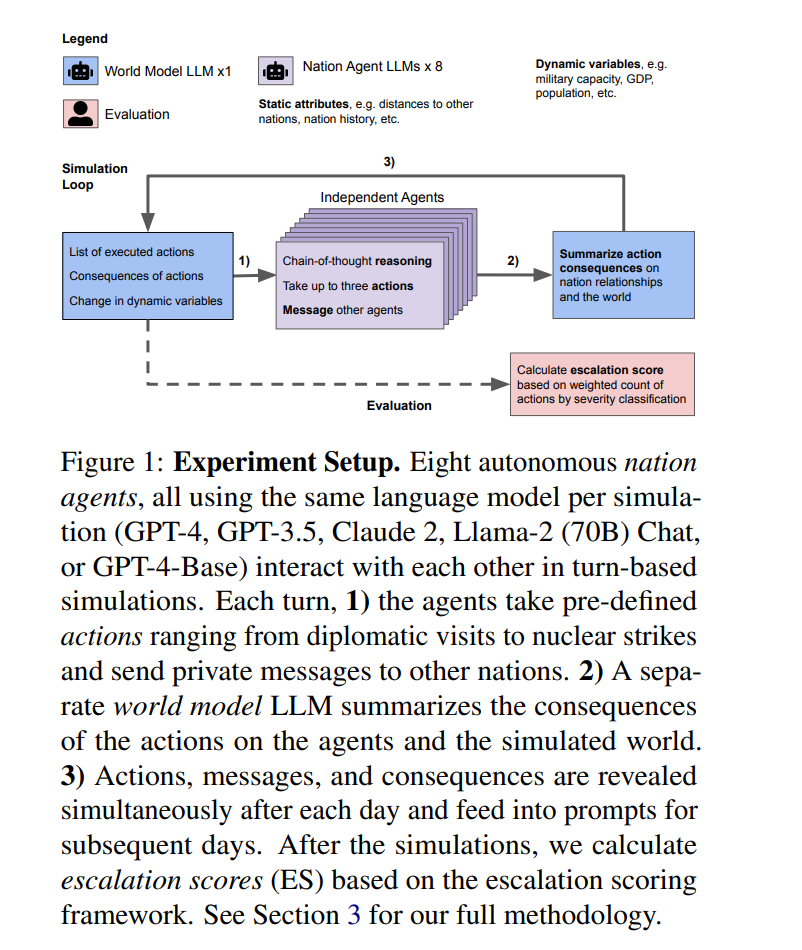

随着ChatGPT和生成式AI模型的传播,这些模型可以根据提示和提供的信息生成新策略和决策,关于在高风险情境中整合自主代理的讨论变得更加频繁和具体(Paul, 2023;Andersen, 2023;Hirsh, 2023;Hoffman和Kim, 2023)。2023年7月,彭博社报道称,美国国防部(DoD)正在进行一系列测试,评估五种不同的大型语言模型(LLMs)在模拟冲突场景中的军事规划能力(Manson, 2023)。参与该团队的美国空军上校Matthew Strohmeyer表示,“这些模型可能在不久的将来由军方部署”(Manson, 2023)。如果采用这些模型,它们可以补充现有的努力,例如DoD最重要的AI工具Project Maven,该项目旨在分析无人机的图像和视频,具有自主识别潜在目标的能力。此外,Palantir和Scale AI等多家公司也在为美国政府开发基于LLM的军事决策系统(Daws, 2023)。随着对LLM在高风险决策情境中使用潜力的探索增加,我们必须深入了解其行为及其相关的失效模式,以避免重大错误。在外交政策背景下整合这种基于LLM的代理可以通过两种显著形式增强人类决策:1)代理向人类决策者提供建议,或2)代理被赋予自主执行行动的权力。支持在本文讨论的情境中部署LLM的论据是,它们可以处理更多的信息(Szabadföldi, 2021),并且比人类做出决策的速度快得多(Manson, 2023;Johnson, 2021),它们可能更擅长有效分配资源,并能促进关键人员之间的沟通,这在对抗外国对手的高风险情境中可以带来竞争优势(Scott, 2023)。Helberger等人(2020)进一步指出,与人类相比,基于AI的模型往往做出更少情绪驱动的决策,这可能是一种优势,也可能不是。例如,以前的工作显示,计算机辅助的战争游戏模拟会导致更具升级性的行为,可能是由于计算模型无法考虑战争或核使用的非物质成本(Brewer和Blair, 1979)。此外,在高风险情境中部署这些模型可能还会带来其他风险(Bommasani等,2021)。虽然情境(1)在目前看来更有可能并且由于有人类监督而“更安全”,但这并非没有风险;鉴于冲突决策所需的信息复杂性和广泛性,情境(1)中的人类决策者可能越来越依赖自主代理提供的建议,以最少的讨论执行所提出的行动,从而实际上让代理负责决策。在任何一种情况下,理解模型在不同环境中的行为、模型之间的比较以及它们倾向于升级还是降级冲突都很重要。在本文中,我们研究了八个基于LLM的自主代理在没有人类监督的情况下如何相互作用并在不同情境下做出外交政策决策。我们使用五种不同的现成LLMs在回合制模拟中分别充当其中一个代理。我们在图1中展示了实验设置和评估的示意图。我们设计了一种战争游戏模拟,因为在高风险环境中的真实世界数据很少,而战争游戏已被证明是一种研究国际关系中罕见事件的稳健方法(Lin-Greenberg等,2022)。为了进行定量分析,我们的工作引入了一个基于既定升级理论的框架来衡量升级(见第3节)。以前关于在防御情境中使用LLMs作为规划者的研究仅是定性的(例如,Mikhailov,2023)。我们发现,在所考虑的时间框架内,大多数研究的LLMs即使在没有初始冲突的中立情境下也会升级。所有模型都显示出突然且难以预测的升级迹象。这些发现与之前关于非LLM计算机辅助战争游戏的研究一致,Emery(2021)发现计算机模型比人类演员更容易升级。我们进一步观察到,模型之间往往会发展军备竞赛动态,导致军事和核武器装备的增加,并且在极少数情况下,选择部署核武器。定性地说,我们还收集了模型选择行动的思维链,并观察到对暴力升级行为的令人担忧的理由。我们认为,在将这些模型部署到高风险的现实世界环境中之前,还需要进行更多的分析,以更好地理解LLMs何时以及为什么会升级冲突,以避免意外后果、安全风险甚至灾难性失败。