题目: Hyperbolic Attention Network

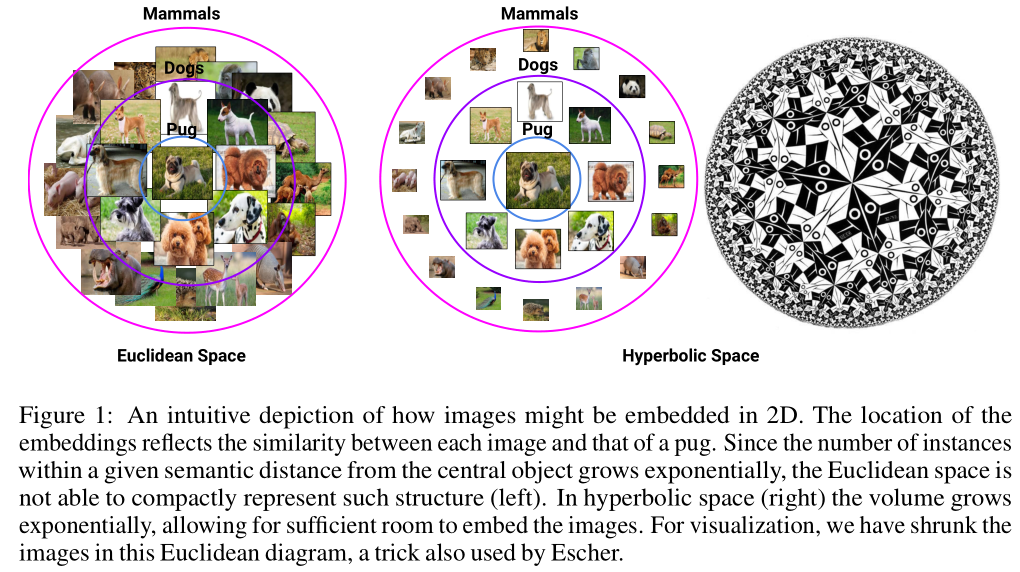

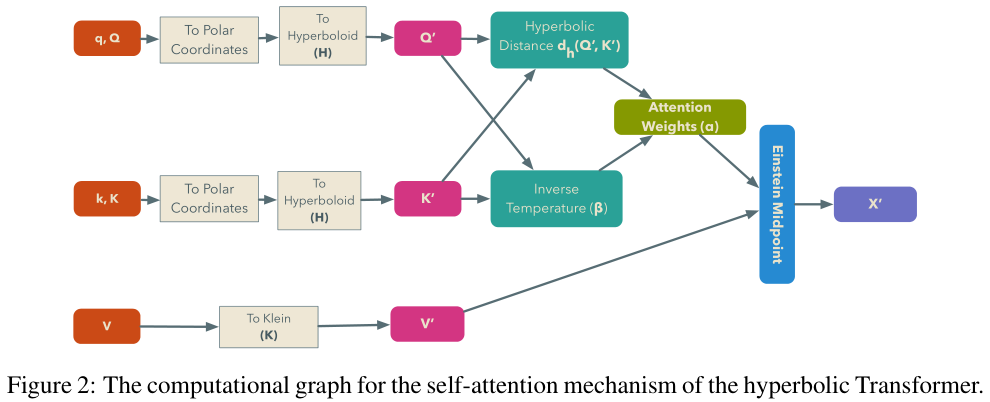

摘要: 最近的方法已经成功地证明了在双曲空间中学习浅层网络参数的优势。我们将双曲几何引入到用于计算不同神经网络结构的注意力机制的嵌入中,从而扩展了这一工作。通过改变object表示的嵌入几何形状,可以在不增加模型参数的情况下能更有效地利用嵌入空间。更重要的是,由于查询的语义距离以指数的速度增长,双曲几何与欧几里得几何相反—可以编码那些object而没有任何干扰。我们的方法在总体上对WMT' 14(英语到德语)的神经机器翻译、图学习(合成和现实世界图任务)和视觉问答(CLEVR)3个任务得到了提升,同时保持神经表征的简洁。

成为VIP会员查看完整内容

相关内容

Attention机制最早是在视觉图像领域提出来的,但是真正火起来应该算是google mind团队的这篇论文《Recurrent Models of Visual Attention》[14],他们在RNN模型上使用了attention机制来进行图像分类。随后,Bahdanau等人在论文《Neural Machine Translation by Jointly Learning to Align and Translate》 [1]中,使用类似attention的机制在机器翻译任务上将翻译和对齐同时进行,他们的工作算是是第一个提出attention机制应用到NLP领域中。接着类似的基于attention机制的RNN模型扩展开始应用到各种NLP任务中。最近,如何在CNN中使用attention机制也成为了大家的研究热点。下图表示了attention研究进展的大概趋势。

专知会员服务

60+阅读 · 2020年6月28日

专知会员服务

77+阅读 · 2020年6月14日