题目: MEMORY-BASED GRAPH NETWORKS

摘 要:

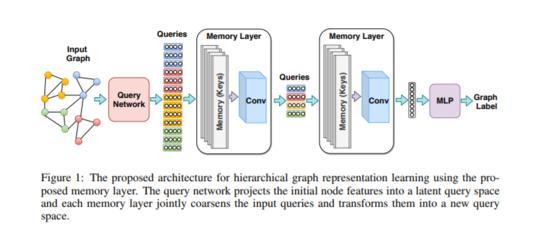

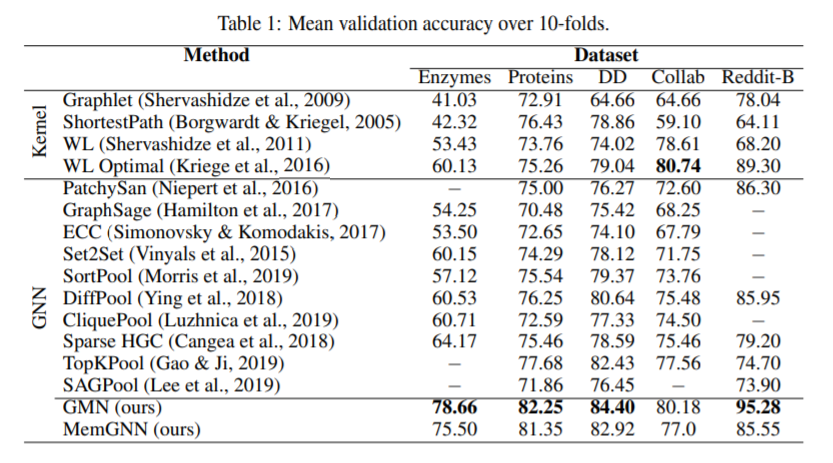

图神经网络是一类对任意拓扑结构的数据进行操作的深度模型。我们为GNNs引入了一个有效的记忆层,它可以联合学习节点表示并对图进行粗化。在此基础上,我们还引入了两个新的网络:基于记忆的GNN (MemGNN)和可以学习层次图表示的图存储网络(GMN)。实验结果表明,所提出的模型在9个图分类和回归基准中有8个达到了最新的结果。我们也证明了这些表示学习可以对应于分子数据中的化学特征。

成为VIP会员查看完整内容

相关内容

专知会员服务

108+阅读 · 2020年3月29日

专知会员服务

136+阅读 · 2020年3月8日

Arxiv

6+阅读 · 2019年8月17日

Arxiv

4+阅读 · 2019年3月7日