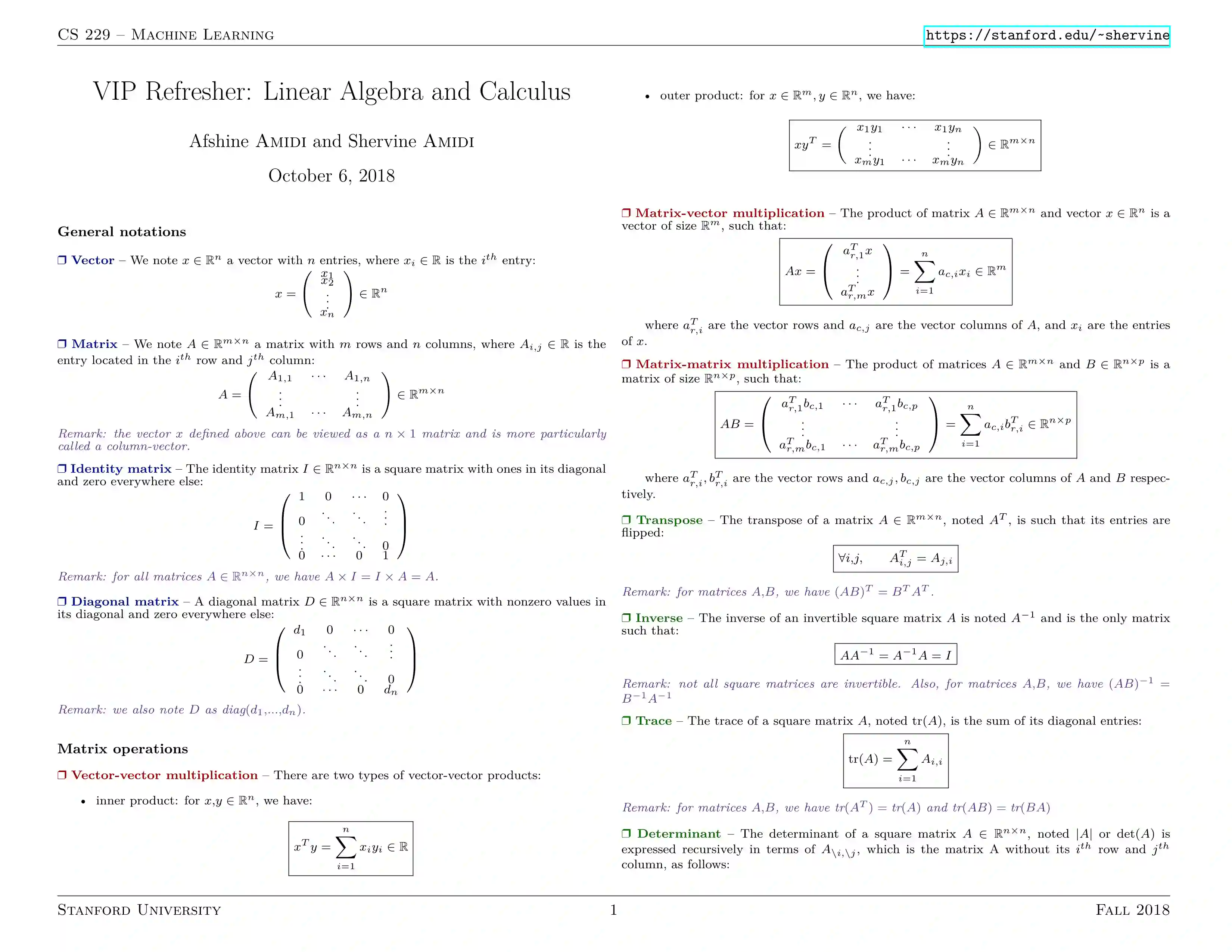

目录: -通用符号

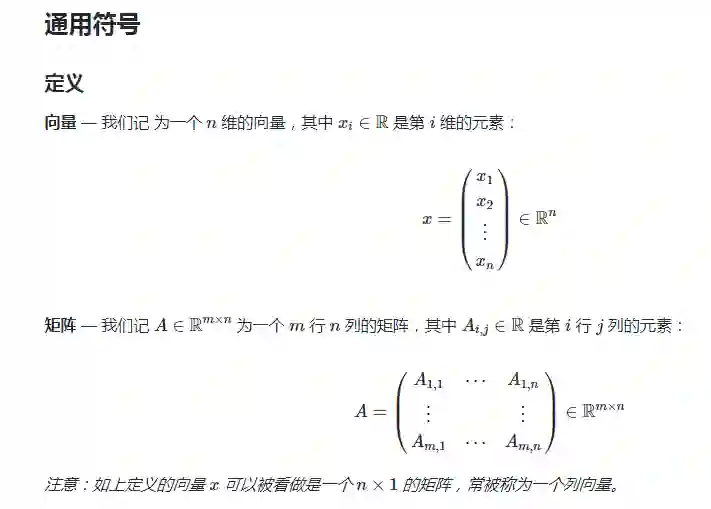

- 定义

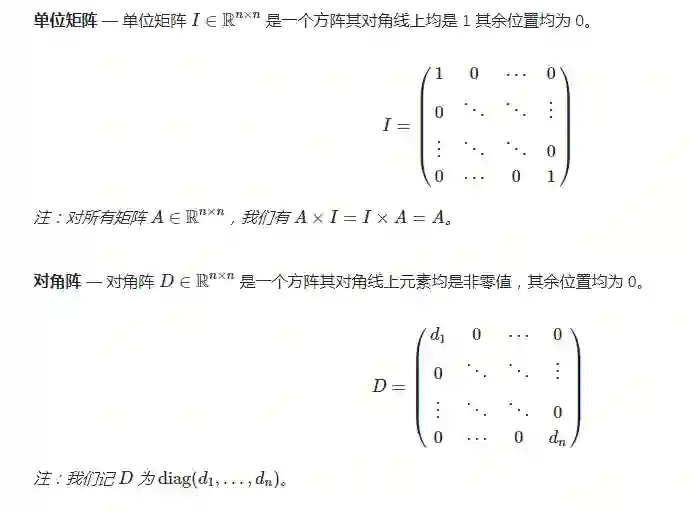

- 主要的矩阵

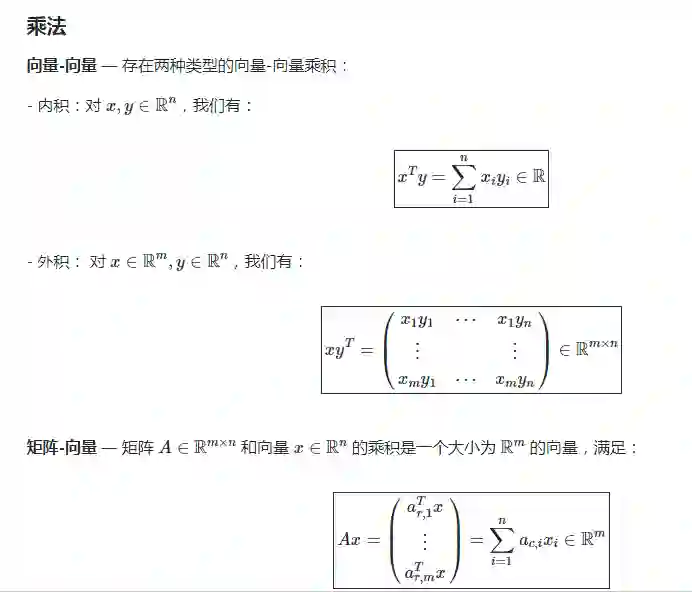

- 矩阵运算

- 乘法 -其他运算

- 矩阵性质

- 范数

- 特征值

- 奇异值分解

- 矩阵微积分

- 梯度

- Hessian

- 运算

成为VIP会员查看完整内容

相关内容

斯坦福大学(StanfordUniversity)位于加利福尼亚州,临近旧金山,占地35平方公里,是美国面积第二大的大学。它被公认为世界上最杰出的大学之一,相比美国东部的常春藤盟校,特别是哈佛大学、耶鲁大学,斯坦福大学虽然历史较短,但无论是学术水准还是其他方面都能与常春藤名校相抗衡。斯坦福大学企业管理研究所和法学院在美国是数一数二的,美国最高法院的9个大法官,有6个是从斯坦福大学的法学院毕业的。

专知会员服务

27+阅读 · 2019年12月19日

Arxiv

6+阅读 · 2018年7月16日