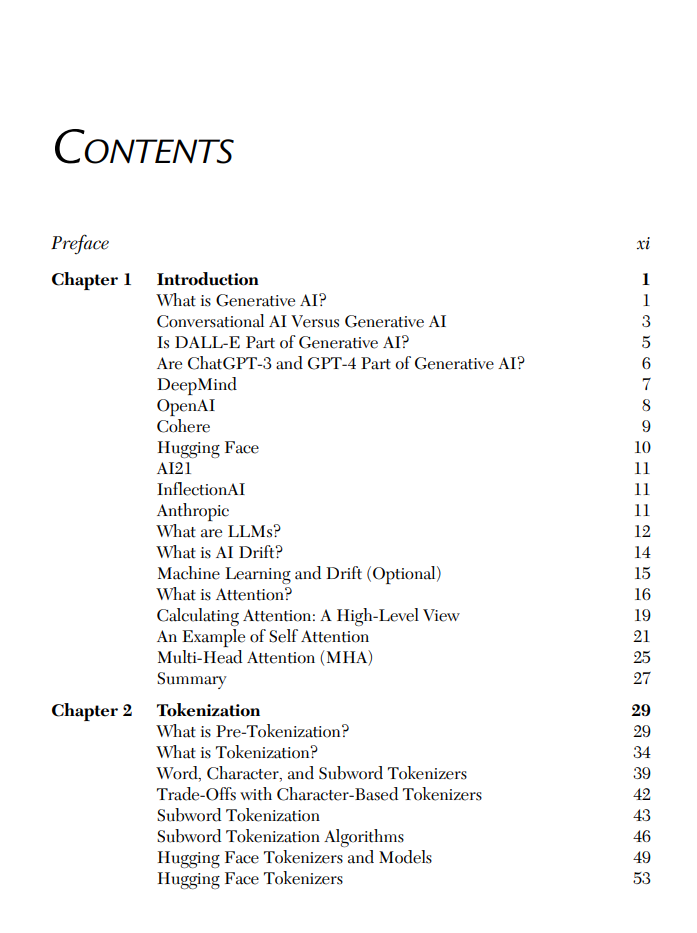

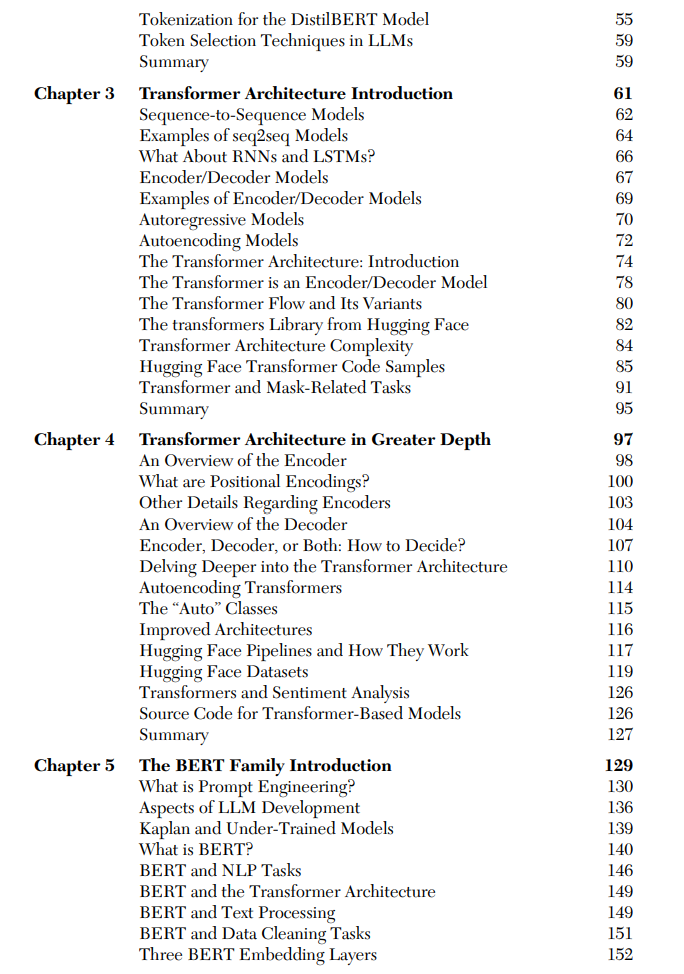

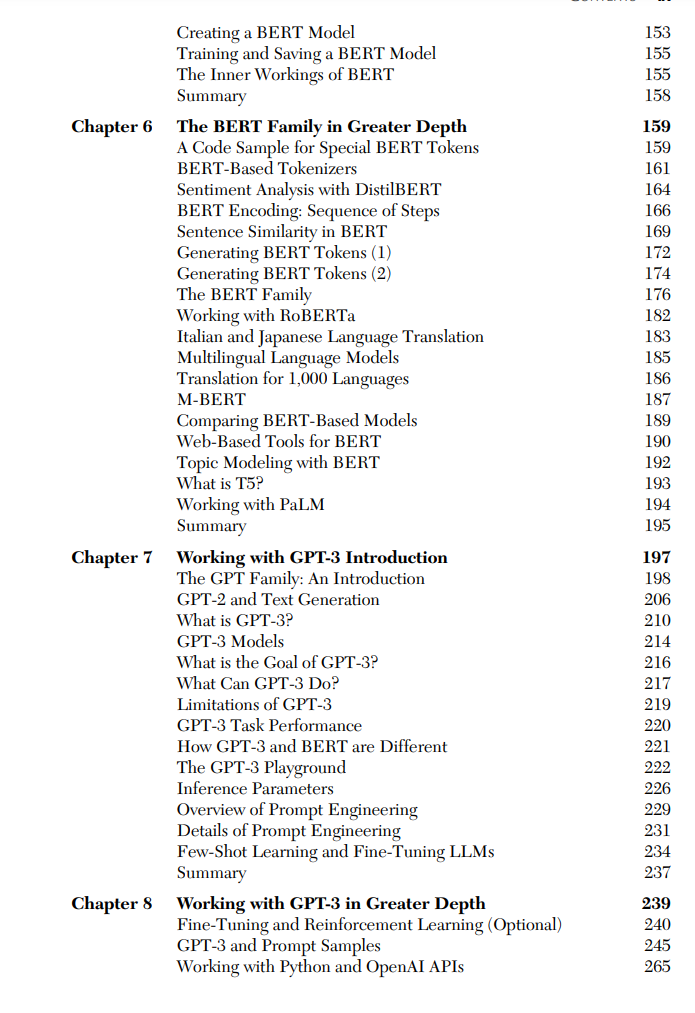

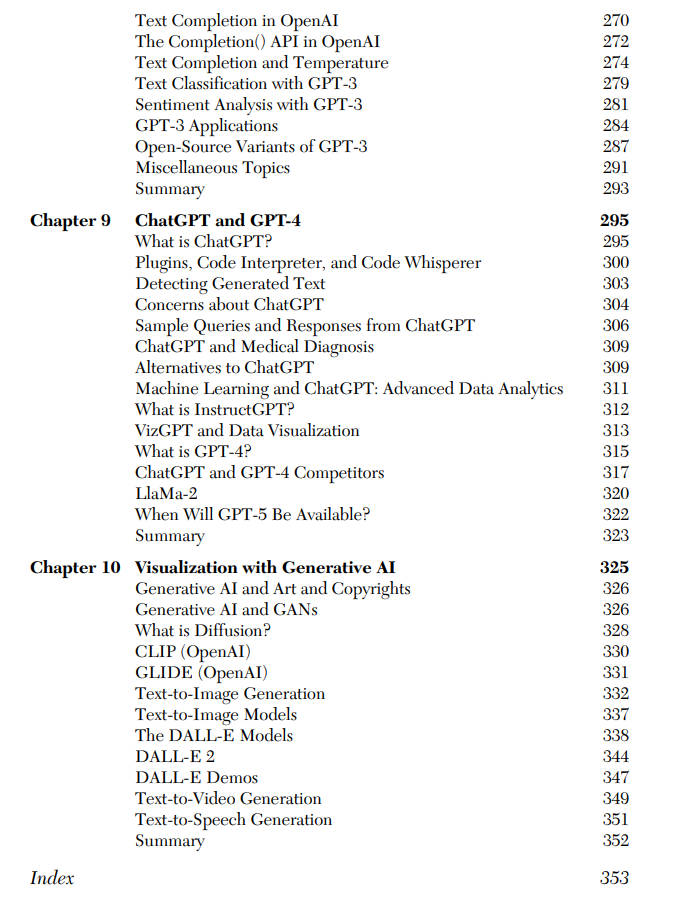

本书全面介绍了一系列主题,涵盖了Transformer(Transformer)架构、BERT模型以及GPT系列(包括GPT-3和GPT-4)的详细信息。全书共十章,从基础概念如注意力机制开始,接着是分词技术,探索Transformer和BERT架构的细微差别,并在GPT系列的最新进展等高级主题上达到高潮,包括ChatGPT。关键章节提供了对深度学习中注意力进化和重要性的洞见,Transformer架构的复杂性,BERT家族的两部分探索,以及关于如何使用GPT-3的实操指导。结尾章节呈现了ChatGPT、GPT-4以及使用生成性AI的可视化概述。除了主要主题外,本书还涵盖了DeepMind、OpenAI、Cohere、Hugging Face等有影响力的AI组织。读者将全面了解当前自然语言处理模型的景观、它们的底层架构和实际应用。附带的配套文件包括众多代码样本和书中的图表。

功能特色:

- 提供一系列全面的主题,详细介绍了Transformer架构、BERT模型和GPT系列(包括GPT-3和GPT-4)。

- 配套文件包括众多代码样本和书中的图表。

成为VIP会员查看完整内容

相关内容

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构

Arxiv

84+阅读 · 2023年4月4日

Arxiv

148+阅读 · 2023年3月29日

Arxiv

84+阅读 · 2023年3月21日