过去十年里,深度神经网络通过使用小批量随机梯度下降(mini-batch stochastic gradient descent)训练方案在大型数据集上展现了显著的成功。在此基础上,研究者开始大量探索神经网络在其他学习场景中的应用。一个受到广泛关注的框架是元学习(meta-learning)。通常被描述为“学会学习”,元学习是一种以数据为驱动,优化学习算法的方法。其他感兴趣的分支包括持续学习(continual learning)和在线学习(online learning),这两者都涉及使用流数据逐步更新模型。虽然这些框架最初是独立开发的,但最近的工作开始探讨它们的结合,提出新颖的问题设置和学习算法。然而,由于复杂性的提高和缺乏统一术语,即使是经验丰富的研究人员也可能难以辨识这些学习框架之间的差异。为了促进清晰的理解,本文提供了一份全面的综述,使用一致的术语和正式描述来组织各种问题设置。通过概述这些学习范式,我们的工作旨在促进这一研究领域的进一步发展。

近年来,深度神经网络的成功主要基于离线学习框架,该框架涉及使用从大型数据集中以独立同分布(i.i.d.)方式采样的小批量进行随机梯度下降(SGD)。另一方面,人类展示出了令人印象深刻的递增学习能力,即使是从高度非静态数据流中也能学习,并且不像深度神经网络那样需要大量的训练数据。此外,人类可以随着知识和经验的积累不断提升其学习能力。因此,已有大量努力致力于使深度神经网络适应这些类人学习场景。在线学习[1]和持续学习[2],[3]是应对这些挑战的研究领域的例子。这两者都通过从数据流中学习来逐步更新模型,但它们在目标和假设上有细微差别。最显著的是,在线学习假设一个静态流,而持续学习旨在减轻从非静态流学习时的灾难性遗忘。

另一个重要的研究领域是元学习[4]。与传统机器学习不同,后者通过训练集优化模型,元学习专注于以数据驱动的方式优化学习算法,使其产生比手工制作的学习算法更好的模型。因此,它通常被描述为“学会学习”。标准学习只涉及一个学习阶段,而元学习包括多个学习阶段,这些阶段被分为元训练集和元测试集。通过利用元训练集中的多个阶段提取的元知识,元学习旨在改进元测试集中每个阶段的学习。元学习也与多个其他领域密切相关,如小样本学习[5],[6],[7]和迁移学习[8],[9]。

虽然这些学习框架已经进行了广泛的单独研究,但最近在它们的协同结合方面出现了浓厚的兴趣,导致了新问题设置和方法的出现。例如,在元持续学习的情况下,传统元学习的每个阶段被替换为一个持续学习阶段。这种设置可以被称为“学会持续学习”。另一个例子是在线元学习,其中学习阶段不是一次性提供的,而是作为一系列阶段呈现,可以总结为“顺序学会学习”。

尽管这些框架每个都具有独特的特点和重要性,但由于几个原因它们可能容易混淆。首先,结合多个框架不可避免地增加了问题表述的复杂性。其次,即使问题设置的基本结构相同,个别论文经常引入一些变体,使它们更难以分类。最后,缺乏统一的术语和表述加剧了混淆。

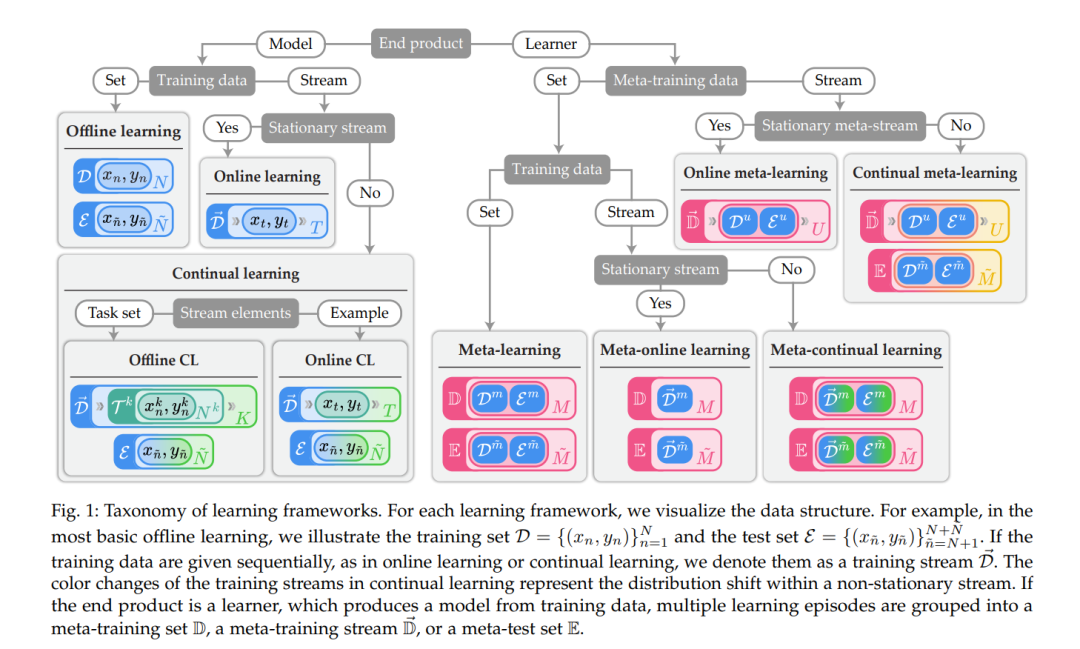

在这种背景下,我们的主要目标是提供一个全面概述,涉及在线学习、持续学习和元学习之间的交叉点。我们建立了统一的符号来组织现有学习框架到一个明确定义的分类中。使用我们的符号,我们首先定义了四个基本学习框架,即离线学习、在线学习、持续学习和元学习。然后,我们将它们的组合分类为五个主要分支:元在线学习、元持续学习、在线元学习、持续元学习和持续双层学习。对于这些组合学习框架中的每一个,我们提供了一个正式定义,并综述了相关论文。

虽然我们确实解释了基本学习框架的概念,但这项工作主要关注它们的组合,目前尚缺乏全面的综述。虽然不是严格必要的,但参考现有的综述可以促进对话题的更深入理解。我们建议参考在线学习的综述[1],持续学习的[2],[3],以及元学习的[4]。总而言之,我们的贡献可以概括如下。首先,我们为在线、持续和元学习的组合定义了清晰的学习框架分类。其次,我们提供了每个类别的全面综述,识别了各种研究分支。第三,我们探讨了剩余的挑战,并提出了在这个有前景的领域未来工作的潜在途径。

本文的其余部分安排如下。在§2中,我们介绍了学习框架的定义和分类。我们用正式算法和数据结构的图形说明补充了描述。在§3-§6中,我们提供了每个学习框架的全面综述和讨论。在§7中,我们讨论了剩余的挑战,并提出了潜在的研究方向。最后,在§8中,我们以一般讨论和未来的评论结束。

本节定义了相关学习框架的问题表述。我们根据它们的问题设置,将学习框架分类为八个主要分支:离线学习、在线学习、持续学习(CL)、元学习、元在线学习(MOL)、元持续学习(MCL)、在线元学习(OML)和持续元学习(CML)。解决这些问题的方法将分别在§3-6中描述。图1展示了每个学习框架的关键特征和数据结构,表1总结了我们在本文中使用的统一符号。