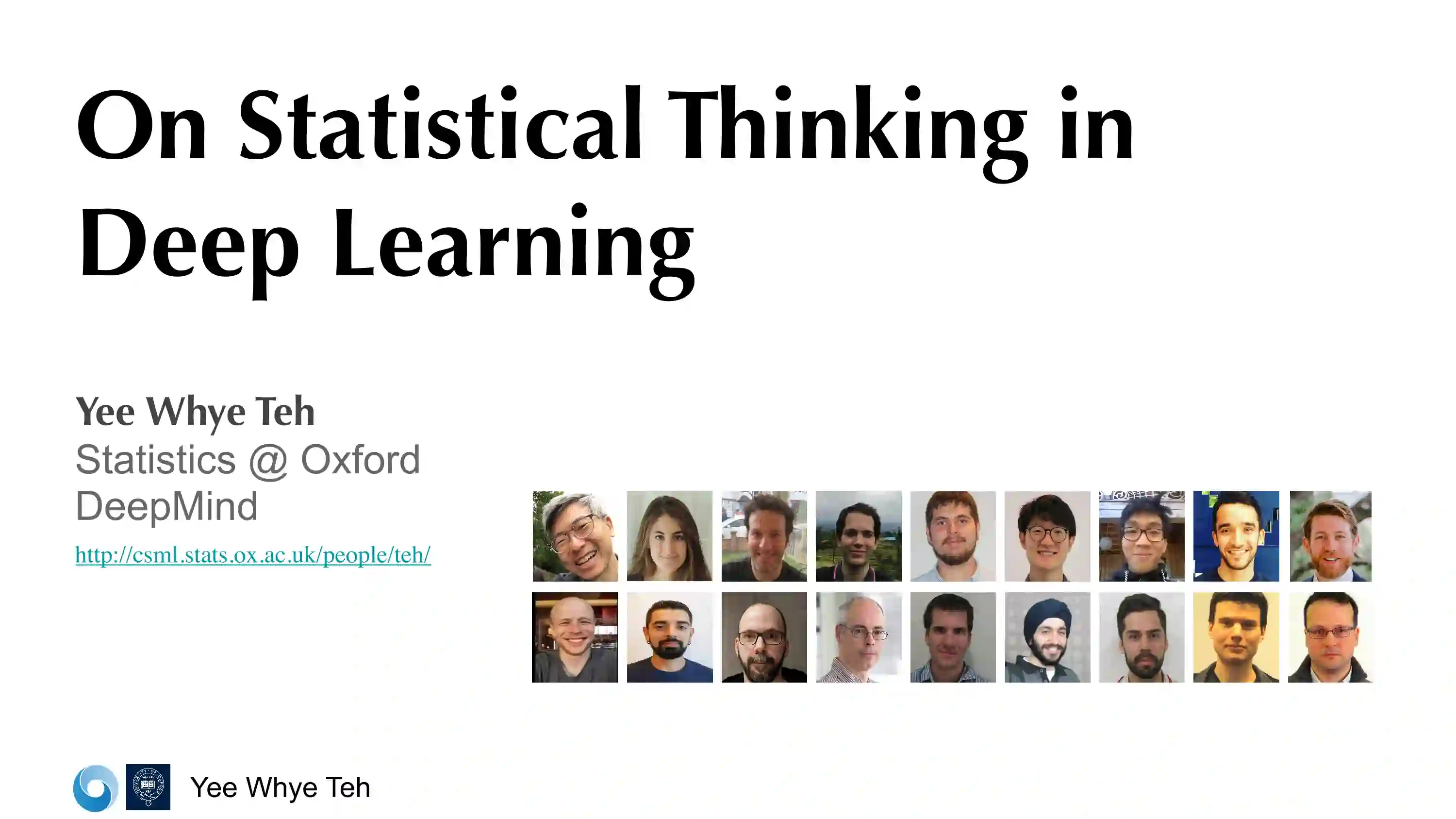

报告主题: On Statistical Thinking in Deep Learning

报告简介:

在过去的二十年形成了一系列成功的机器学习方法,影响了许多这个领域研究人员的思维,而深度学习的兴起彻底改变了这个领域。在这次演讲中,将探讨深度学习中的统计思维,统计思维如何帮助我们理解深度学习方法或者引导我们开发出有趣的新方法,或者深度学习技术如何帮助我们开发先进的统计方法。

嘉宾介绍:

Yee Whye Teh是牛津大学统计学教授,他于2003年获得多伦多大学计算机博士学位,师从Geroffery Hinton。获得多伦多大学的博士学位,郑怀宇在美国加州大学伯克利分校和新加坡国立大学从事博士后工作,研究方向是机器学习和计算统计学,特别是图形模型、贝叶斯非参数和表征学习。他还多次担任NIPS、ICML和AISTATS的领域主席(area chair)。

成为VIP会员查看完整内容