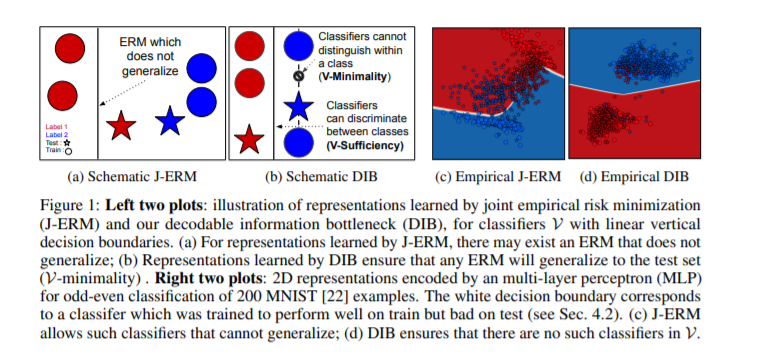

我们解决了监督学习的特征化和寻找最优表示的问题。传统上,这个问题通过使用信息瓶颈来解决,即压缩输入,同时保留关于目标的信息,这种方式与解码器无关。然而,在机器学习中,我们的目标不是压缩而是泛化,这与我们感兴趣的预测族或译码器(例如线性分类器)密切相关。我们提出了可解码信息瓶颈(DIB),它从预期预测族的角度考虑信息的保留和压缩。因此,DIB产生了预期测试性能方面的最优表示,并且可以在保证的情况下进行估计。实验表明,该框架可以在下游分类器上施加一个小的泛化间隙,并预测神经网络的泛化能力。

https://www.zhuanzhi.ai/paper/89c6cd33631078ee766b8b8dc409a503

成为VIP会员查看完整内容