今天专知小编给大家带来的是「微软混合现实与人工智能实验室」最新在CVPR 2022上录用的“FLAG: Flow-based Avatar Generation from Sparse Observations”一文。本篇由Sadegh Aliakbarian,Pashmina Cameron,Federica Bogo,Andrew Fitzgibbon,Thomas J. Cashman等微软科学家联合发表。 论文链接 https://microsoft.github.io/flag/files/paper.pdf

【摘要】

为了在混合现实应用程序中代表人们进行协作和交流,我们需要生成逼真且可信的头像姿势。然而,可以从头戴式设备 (HMD) 应用于此任务的信号流通常仅限于头部姿势和手部姿势估计。虽然这些信号很有价值,但它们是人体的完整代表,因此很难生成可信的全身化身。我们通过从稀疏观察中开发基于流的 3D 人体生成模型来应对这一挑战,其中我们不仅学习 3D 人体姿势的条件分布,还学习从观察到潜在空间的概率映射,我们可以从中生成一个合理的姿势以及关节的不确定性估计。我们表明,我们的方法不仅是一个强大的预测模型,而且还可以在不同的优化设置中充当有效的先验姿势,其中良好的初始潜在代码起主要作用。

【引 言】

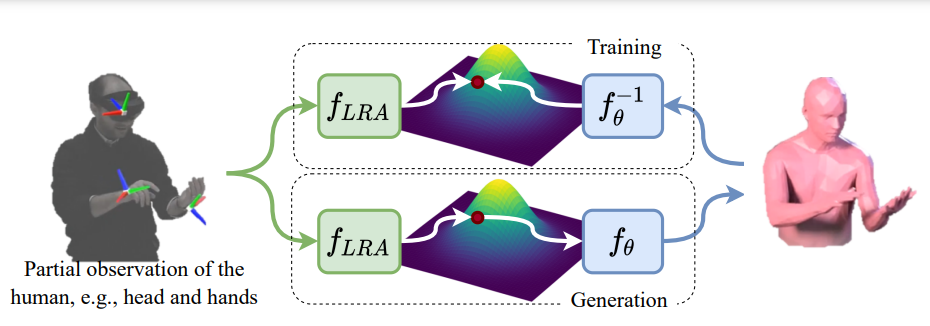

混合现实技术通过远程协作、虚拟聚会、游戏和教育等应用,提供了与人互动的新方式。人是所有这些应用程序的核心,因此生成逼真的、高保真的人的表现是用户体验的关键。虽然外部传感器和摄像头是有效的,但仅使用头戴设备(HMDs)来生成逼真和可信的人类表现仍然是一个具有挑战性的问题。提供的相关数据如Microsoft HoloLens和Oculus Quest等HMDs都局限于头部的位置和方向以及手的位置和方向,可以通过自我中心的手部跟踪,也可以通过运动控制器的信号来获得。对于整个人体的姿势和运动来说,这是一个非常不完整的信号。 尽管之前的工作已经提出了人体姿态先验,用于从部分和模糊的观察(如图像)生成3D人体姿态,2D关节/关键点和标记点,这些观察比HMD在实践中提供的数据来源更丰富。尽管这个问题很重要,但很少有人尝试通过极其稀疏的观察来生成完整的身体姿势,即头和手的位置和方向。Dittadi et al.开发了一种变分自动编码器(VAE)来压缩头和手的输入到潜在空间,允许从潜在空间采样生成一个全身姿势。 针对稀疏输入,提出了一种基于条件归一化流的新方法。具体来说,我们通过一个基于流的模型来学习在给定头和手数据的情况下,整个身体姿态的条件分布,该模型实现了三维姿态分布和基础分布之间的可逆映射。然后,我们的模型的可逆性允许我们进一步学习,在相同的基数分布中,从条件到高似然区域的概率映射,如图1所示。我们将这种方法命名为基于流的角色生成模型(FLAG)。该设计的优点是:首先,使用基于流的生成模型可以实现精确的位姿似然计算,而不是基于vae的位姿先验中的近似似然计算。其次,我们的生成模型的可逆性允许我们计算甲骨文的潜在代码。在训练期间,oracle的潜在代码作为我们映射函数的基本事实。这使我们能够学习从观察到的头和手到潜在空间的代表性映射,使我们的方法成为一个强大的预测模型。最后,当在位姿空间或潜在空间中进行优化时,使用我们的模型作为位姿先验提供了潜在空间中的优越初始化,使优化非常高效。

【结 论】

我们提出了FLAG,一种从稀疏的HMD信号中生成可信的全身人体姿势的新方法。FLAG是基于稀疏观测的基于条件流的三维人体生成模型;我们不仅学会了三维人体的条件分布,还学会了从观察到潜在空间的概率映射,从中我们可以产生不确定性估计的貌似合理的姿势。我们证明了我们的方法既是一个强大的预测模型,而且由于我们的潜变量抽样机制,在不同的优化设置下是一个有效的姿态先验。实验评估和消融研究表明,我们的方法在具有挑战性的AMASS数据集上的性能优于目前最先进的方法,需要更少的优化迭代,并导致非常低的误差。