机器学习论文推荐|Evolving Normalization-Activation Layers

本文第一作者及通讯作者为本科毕业于清华大学,博士毕业于卡耐基梅隆大学,现工作于 Google Brain 的刘寒骁。值得一提的是,刘寒骁也是 DARTS: Differentiable Architecture Search 的第一作者,这篇论文对于神经网络结构搜索(NAS)的搜索成本研究有了突破性的进展,也让 NAS 领域中的 gradient-based 方法变得更加流行。

今天为您推荐的论文为 Google Brain 和 DeepMind 团队于 4 月 28 号挂在 arXiv 上的论文 Evolving Normalization-Activation Layers ,作者为 Hanxiao Liu, Andrew Brock,Karen Simonyan,Quoc V. Le .

Evolving Normalization-Activation Layers 的中心思想也是借助于搜索的方法来探寻最优的 Normalization-Activation Layers。Normalization Layers 和 Activation Layers 是深度神经网络的关键组件。近些年来有很多重要的研究工作致力于对两者的分别独立的设计,比如单一的设计 Normalization Layers (Batch Norm,Group Norm, Instance Norm,Layer Norm 等等)或者单一的设计Activation Layers (ReLU,Sigmoid, Tanh,Swish 等等),都取得了相应的进展。然而,不同于传统地将这两者分别设计,此研究是第一个将两者合为一个整体的计算图来自动设计(automatically co-design)的工作。

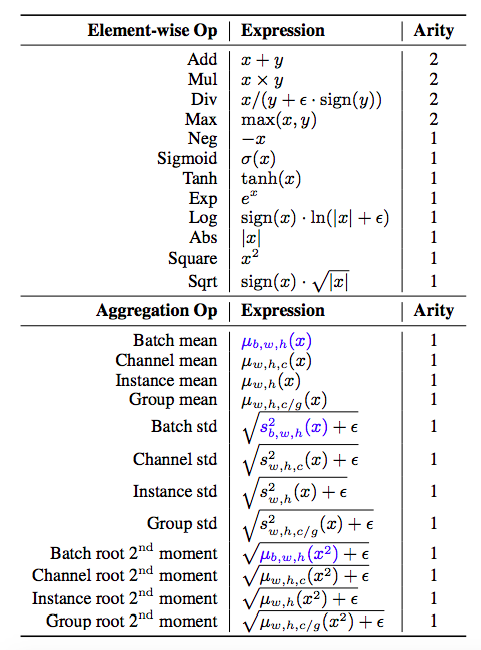

如下图所示,此研究从一些最底层的基元(primitives)结构出发,通过这些基于的不同组合构成了很多不同的 Normalization-Activation Layers。再通过演变的搜索方法来不断的淘汰表现不良的组合,并保留表现良好的组合。最后,演化算法搜索出了全新的 normalization-activation layers,并将之命名为 EvoNorms。

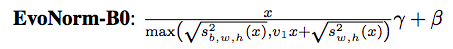

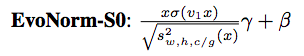

EvoNorms 有两种系列:B 系列(需要 Batch 的统计信息)和 S 系列(需要 Sample 的信息),如图所示给出了 EvoNorm-B0 和 EvoNorm-S0 的表达公式。

EvoNorm-B0 的分母的实际意义是选取 Batch Norm(BN)和 Instance Norm 表现更强的一个,下图是 EvoNorm-B0 对于 MobileNetV2 在 ImageNet 上的表现结果,相对于 BN-ReLU,它可以一致的提高 1~2 个百分点的精度。

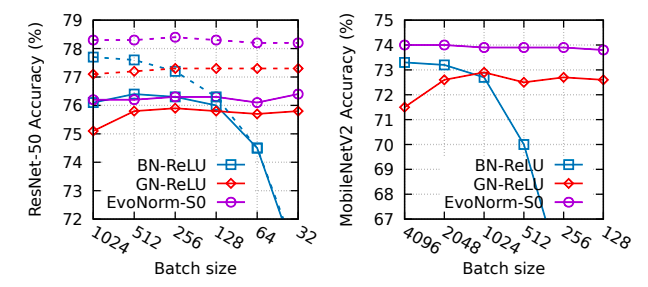

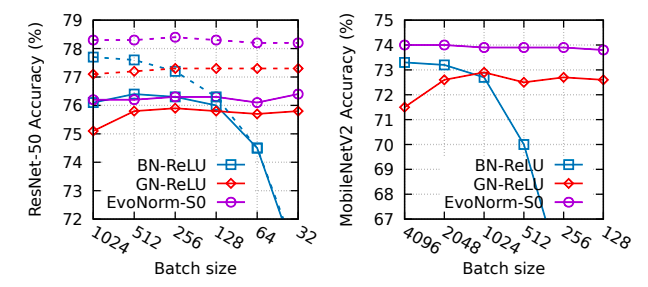

不同于 B0,EvoNorm-S0 是不需要 batch statistics 的。它的分子实际上是 Swish,分母代表的是 Group Norm(GN)信息。如下图所示:

EvoNorm-S0 相对于 BN-ReLU 和 GN-ReLU 精度更高,且精度不受 batch size 的影响。

总的来说,实验结果显示 EvoNorms 不仅能够在多种图像分类模型(包括 ResNets, MobileNets and EfficientNets 等)中取得较好的精度,而且可以很好地转移到实例分割(包括 Mask R-CNN, SpineNet 等)和图像合成(例如 BigGAN)。在这些问题的解决上,EvoNorms 的结构明显优 BatchNorm 和 GroupNorm。

点击阅读原文,查看更多精彩!